L’hype sull’intelligenza artificiale sta danneggiando l’hardware del PC e i giocatori

L’intelligenza artificiale è di gran moda in questo momento e ogni azienda sembra marchiare i propri prodotti con il tag AI per evitare di essere esclusa dal clamore dell’intelligenza artificiale. Ma i produttori di hardware per PC e GPU stanno facendo qualcosa di ancora più preoccupante: ignorare lo spazio dell’hardware per giochi per concentrare tutte le loro energie nel servire il mercato dei data center AI. Se questo diventasse la norma, i giocatori troverebbero difficile entusiasmarsi di nuovo per l’hardware per PC.

L’intelligenza artificiale sta colpendo l’hardware del tuo computer grazie ad AMD Ryzen AI.

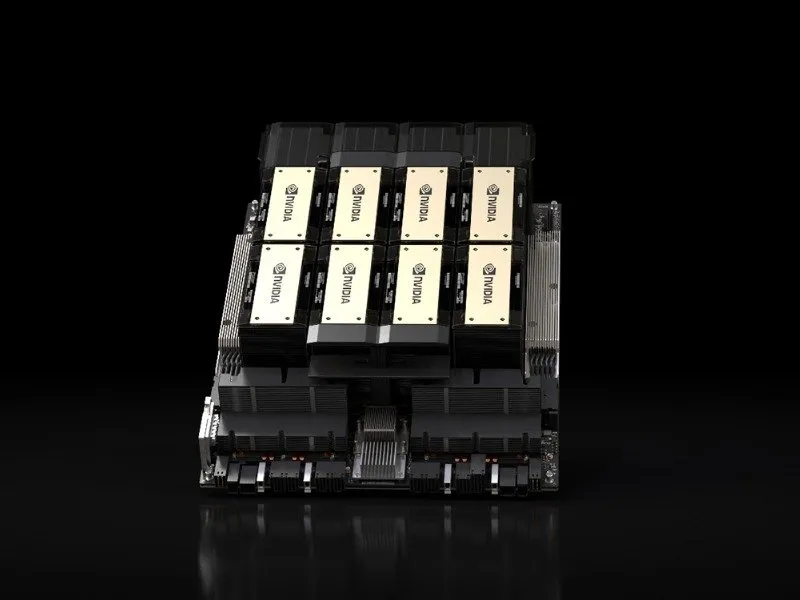

Nvidia punta tutto sulle GPU per data center

Essendo il produttore di GPU dominante nel mondo, ciò che fa Nvidia fa luce anche sul mercato della grafica più ampio. A questo punto probabilmente saprai che Nvidia è diventata un’azienda da 3 trilioni di dollari grazie agli enormi profitti dei suoi data center.

In realtà ha guadagnato oltre 22 miliardi di $ nell’ultimo trimestre dalla vendita di GPU ai data center aziendali, mentre i ricavi del gaming hanno portato solo circa 2,5 miliardi di $. Due anni fa, i ricavi del gaming di Nvidia hanno effettivamente superato i ricavi del data center. Con l’hype dell’IA, quei giorni sono ormai alle nostre spalle.

Secondo il CEO Jensen Huang, Nvidia è ora fermamente concentrata sul lancio di architetture GPU annuali per il mercato dei data center. Mentre l’azienda accelera la produzione per soddisfare la crescente domanda di intelligenza artificiale, posso già vedere le GPU da gioco di nuova generazione apportare solo miglioramenti marginali rispetto ai prodotti della generazione attuale. Quando può allocare i suoi wafer di silicio a GPU aziendali ad alto margine, perché dovrebbe concentrarsi sulle GPU da gioco?

Se le tendenze continuano, potremmo smettere del tutto di acquistare GPU di fascia alta nel prossimo futuro.

Le GPU Nvidia di qualità inferiore sono già una cosa

Non è che io stia inventando storie fantastiche su un futuro desolante. Abbiamo già visto Nvidia lanciare GPU scadenti come risultato della crescente insignificanza del settore gaming nel loro bilancio. L’hype per l’IA è davvero reale.

Prendiamo ad esempio la RTX 4080 12GB. Potreste non ricordare questa GPU perché Nvidia ha dovuto “de-lanciarla” ore dopo aver ricevuto un’enorme reazione negativa dalla comunità. Era stata pubblicizzata come una semplice RTX 4080 con 4 GB di VRAM in meno, ma era molto più vicina a una RTX 4070. Dopo averla de-lanciata, Nvidia l’ha poi riproposta sotto forma di RTX 4070 Ti (che non è ancora del tutto giustificata).

Più di recente, il Team Green ha lanciato la RTX 4060 Ti, una presunta erede della RTX 3060 Ti, ma era appena più veloce e in realtà era indietro rispetto alla 3060 Ti in alcuni giochi. La mediocre VRAM da 8 GB è stata un ulteriore colpo per i giocatori. Con le schede RTX 4000, Nvidia ha già detto addio al segmento economico. Ma con la serie RTX 5000 di prossima generazione, temo che anche il segmento di fascia media verrà eliminato.

Ecco le migliori schede grafiche economiche sul mercato.

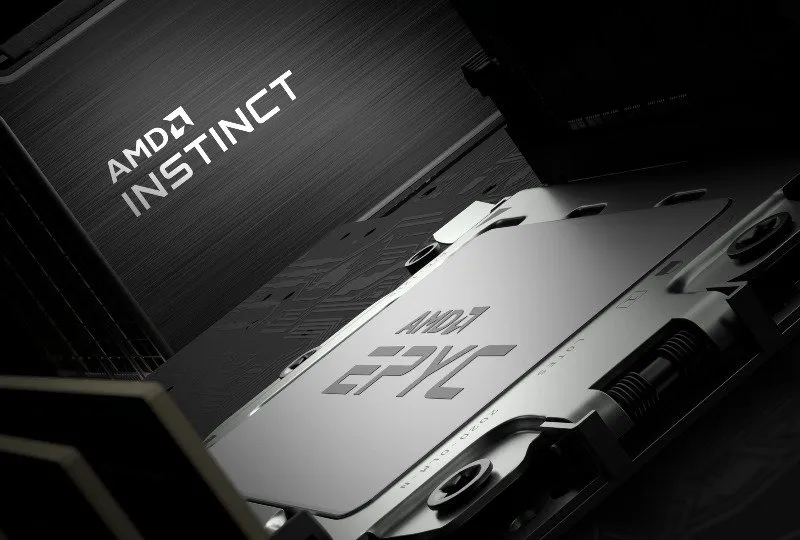

La spinta dell’AI di AMD e la perdita della GPU

Mentre Nvidia è impegnata a diventare il produttore di chip per l’intelligenza artificiale numero uno al mondo, anche AMD sta lavorando duramente per posizionarsi come azienda di riferimento per i processori ad alte prestazioni per i data center dedicati all’intelligenza artificiale.

I processori EPYC di quarta generazione di AMD offrono fino a 128 core di prestazioni “epiche” ai carichi di lavoro dei data center, mentre i suoi acceleratori MI300, alimentati dalle GPU CDNA 3 professionali, aiutano le aziende ad accelerare le proprie capacità di intelligenza artificiale generativa. L’hardware “Ryzen AI” è già presente nei dispositivi degli utenti finali come laptop e desktop.

Considerando la partecipazione del Team Red all’hype dell’IA e le voci secondo cui sta pianificando di non competere affatto nel segmento delle GPU da gioco di fascia alta nel 2024, sembra che AMD sia giunta alla stessa conclusione di Nvidia: andare dove ci sono i soldi. I potenziali ricavi dell’IA eclissano qualsiasi cosa il settore verticale del gioco possa portare, e persino AMD sta cambiando le sue priorità.

Ciò è particolarmente preoccupante per i giocatori, poiché la serie RX 7000 di AMD ha visto alcune delle GPU più potenti di sempre confrontarsi con i costosissimi colossi di Nvidia come la RTX 4090 e la RTX 4080.

La mancanza di competizione è un male per i giocatori

L’uscita di AMD dal settore delle GPU da gioco di fascia alta può significare solo cose negative per i giocatori. La concorrenza è sempre positiva per i consumatori, quindi con AMD apparentemente non in competizione, Nvidia non avrà alcun incentivo a innovare con le sue GPU consumer di prossima generazione. Probabilmente vedremo molti più prodotti come la RTX 4060 Ti. Inoltre, l’azienda sarà libera di far pagare qualsiasi cifra voglia per le sue GPU RTX 5000 di fascia alta.

L’avanzamento dell’intelligenza artificiale è cruciale per l’industria informatica nel suo complesso, ma farlo a spese dell’industria dell’hardware per videogiochi non è accettabile. Se aziende come Nvidia e AMD continuano a spingere l’hype dell’intelligenza artificiale allo stesso ritmo, è possibile che, con il passare del tempo, il mercato dell’hardware per PC diventi l’ombra di se stesso.

Potrebbe esserci ancora speranza per i giocatori

Nel prossimo futuro, in cui Nvidia e AMD si concentreranno sulla promozione dell’agenda pubblicitaria dell’intelligenza artificiale, Intel potrebbe vedere una finestra per acquisire una quota maggiore del mercato dell’hardware per PC. Con i suoi processori Arrow Lake di quindicesima generazione e le schede grafiche Battlemage di seconda generazione, Team Blue potrebbe potenzialmente creare una nuova nicchia per sé: una solida alternativa a Nvidia e AMD. Spero che questo li riporti a dare priorità allo spazio hardware di gioco e inizi a innovare su prodotti migliori per i giocatori.

Credito immagine: Wikimedia Commons .

Lascia un commento