Meilleurs outils gratuits pour exécuter LLM localement sur un PC Windows 11

Vous souhaitez sécuriser vos données et vous assurer qu’elles restent sur votre appareil ? De nombreux services LLM basés sur le cloud imposent des frais d’abonnement continus liés à l’utilisation des API. De plus, les personnes situées dans des endroits éloignés ou celles qui ont un accès Internet irrégulier ne privilégient souvent pas ces solutions cloud. Quelles sont donc les alternatives disponibles ?

Heureusement, l’utilisation d’outils LLM locaux peut contribuer à éliminer ces dépenses, en permettant aux utilisateurs d’exploiter les modèles directement sur leur matériel personnel. Ces outils permettent le traitement des données sans connexion Internet, garantissant que vos informations restent inaccessibles aux serveurs externes. De plus, ils fournissent une interface adaptée spécifiquement à votre flux de travail.

Ce guide présente une liste organisée d’ outils LLM locaux gratuits qui correspondent à vos besoins en matière de confidentialité, d’abordabilité et de performances.

Meilleurs outils LLM gratuits pour PC Windows 11

Vous trouverez ci-dessous quelques outils LLM locaux gratuits exceptionnels qui ont fait l’objet de tests et d’évaluations approfondis.

- Jan

- Studio LM

- GPT4ALL

- ToutLLM

- Être

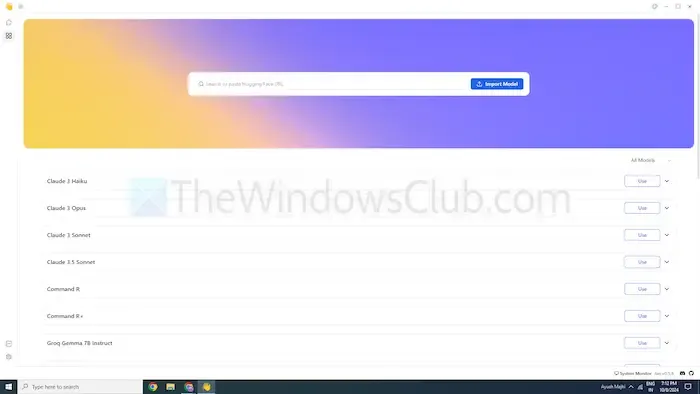

1] Jan

Si vous connaissez ChatGPT, Jan est un outil similaire conçu pour fonctionner hors ligne. Il fonctionne uniquement sur votre appareil, vous permettant de créer, d’analyser et de traiter du texte en privé sur votre réseau local.

Jan propose des modèles haut de gamme comme Mistral, Nvidia ou OpenAI, permettant une utilisation sans envoyer de données à des serveurs externes. Cela en fait un excellent choix pour les utilisateurs qui privilégient la sécurité des données par rapport aux options basées sur le cloud.

Caractéristiques

- Modèles préconfigurés : équipés de modèles d’IA prêts à l’emploi qui ne nécessitent aucune installation supplémentaire.

- Personnalisation : Personnalisez les couleurs du tableau de bord et choisissez un thème uni ou translucide.

- Vérification orthographique : utilisez cette fonction pour corriger les fautes d’orthographe.

Avantages

- Permet les importations de modèles via la source Hugging Face.

- Prend en charge les extensions pour une plus grande personnalisation.

- Utilisation entièrement gratuite.

Inconvénients

- Support communautaire limité, ce qui entraîne moins de tutoriels et de ressources disponibles.

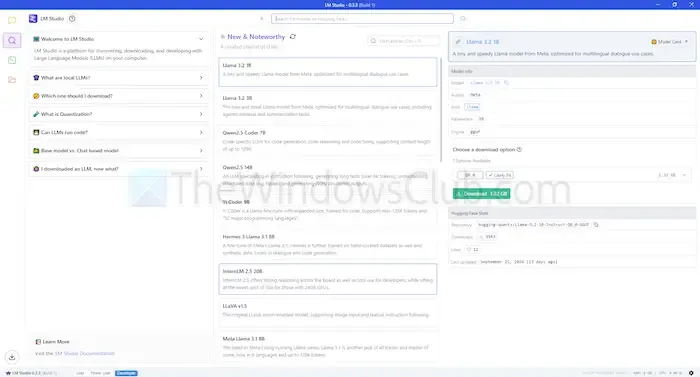

2] LM Studio

LM Studio est un autre outil LLM local qui vous permet d’utiliser des modèles de langage comme ChatGPT directement sur votre machine. Il propose des modèles avancés qui améliorent votre capacité à comprendre et à répondre aux requêtes, en conservant précisément la localisation pour une meilleure confidentialité et un meilleur contrôle.

Cet outil peut résumer des documents, générer du contenu, fournir des réponses et même aider à la programmation, tout en s’exécutant localement. Vous pouvez évaluer la compatibilité de différents modèles avec votre système avant le déploiement, garantissant ainsi une utilisation efficace du temps et des ressources.

Caractéristiques

- Téléchargement de fichiers et intégration RAG : téléchargez différents types de documents tels que PDF, DOCX, TXT et CSV pour des réponses personnalisées.

- Larges options de personnalisation : choisissez parmi plusieurs thèmes de couleurs et niveaux de complexité pour l’interface.

- Riche en ressources : fournit de la documentation et des ressources d’apprentissage aux utilisateurs.

Avantages

- Compatible avec Linux, Mac et Windows.

- Configuration du serveur local disponible pour les développeurs.

- Propose une sélection organisée de modèles de langage.

Inconvénients

- Peut présenter des défis pour les débutants, en particulier lors de la configuration initiale.

3] GPT4ALL

GPT4ALL est un autre outil LLM avancé conçu pour fonctionner sans nécessiter de connexion Internet ou d’intégration API. Cette application est capable de fonctionner sans GPU, bien qu’elle puisse les utiliser s’ils sont disponibles, ce qui la rend accessible à un large éventail d’utilisateurs. Il prend en charge diverses architectures LLM, garantissant la compatibilité avec de nombreux modèles et frameworks open source.

Cet outil utilise llama.cpp pour son backend, améliorant les performances des processeurs et des GPU sans nécessiter de ressources informatiques haut de gamme. GPT4ALL fonctionne de manière transparente avec les processeurs Intel et AMD, ce qui lui permet d’utiliser les GPU pour des vitesses de traitement optimisées.

Caractéristiques

- Intégration de fichiers locaux : les modèles peuvent interroger et interagir avec des documents locaux tels que des fichiers PDF ou des fichiers texte via des documents locaux.

- Efficacité mémoire : de nombreux modèles sont disponibles en versions 4 bits pour réduire les besoins en mémoire et en traitement.

- Vaste référentiel de modèles : GPT4ALL héberge plus de 1 000 modèles open source provenant de référentiels tels que Hugging Face.

Avantages

- Open source et transparent dans ses opérations.

- Propose des solutions spécifiques adaptées aux entreprises pour utiliser l’IA hors ligne.

- Une forte emphase sur la confidentialité des utilisateurs.

Inconvénients

- Prise en charge limitée des processeurs ARM, tels que ceux utilisés dans les Chromebooks.

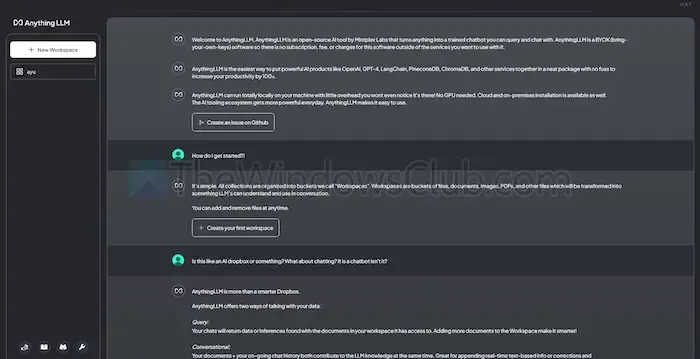

4] N’importe quoiLLM

AnythingLLM est un LLM open source permettant une personnalisation poussée et garantissant une expérience d’IA privée. Il permet aux utilisateurs de mettre en œuvre et d’exécuter des LLM hors ligne sur leurs appareils locaux, qu’ils utilisent Windows, Mac ou Linux, garantissant ainsi une confidentialité totale des données.

Cet outil est particulièrement adapté aux utilisateurs individuels qui recherchent une installation simple avec une configuration minimale requise. Il fonctionne de manière similaire à un système ChatGPT privé que les particuliers ou les entreprises peuvent déployer.

Caractéristiques

- Convivial pour les développeurs : offre une API complète pour les intégrations personnalisées.

- Intégration d’outils : possibilité d’intégrer des outils supplémentaires et de générer des clés API.

- Installation rapide : Conçu pour une expérience d’installation en un clic.

Avantages

- Grande flexibilité dans l’utilisation du LLM.

- Capacités centrées sur les documents.

- Une plateforme avec des agents IA pour automatiser les tâches des utilisateurs.

Inconvénients

- Manque de support pour plusieurs utilisateurs.

- Les fonctionnalités avancées peuvent être difficiles à utiliser.

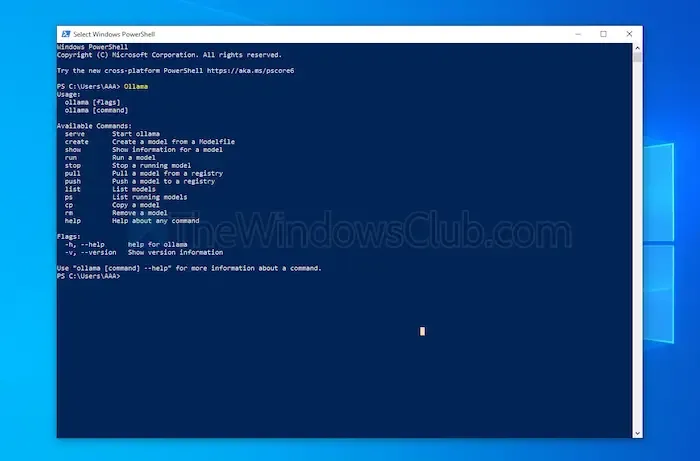

5] Être

Ollama offre aux utilisateurs un contrôle total sur la création de chatbots locaux sans avoir recours à des API. Cet outil bénéficie actuellement d’importantes contributions des développeurs, garantissant des mises à jour et des améliorations fréquentes pour des fonctionnalités améliorées. Contrairement aux autres options évoquées, Ollama fonctionne via une interface de terminal pour les installations et les lancements de modèles.

Chaque modèle que vous installez peut avoir des configurations et des paramètres de poids distincts, ce qui évite tout conflit logiciel sur votre machine. De plus, Ollama dispose d’une API compatible OpenAI, permettant une intégration sans effort avec n’importe quelle application utilisant des modèles OpenAI.

Caractéristiques

- Hébergement de modèles locaux : Ollama vous permet d’exécuter de grands modèles linguistiques hors ligne, tels que Llama et Mistral.

- Personnalisation du modèle : les utilisateurs avancés ont la possibilité d’ajuster les comportements du modèle via un Modefile.

- Intégration avec l’API OpenAI : Ollama inclut une API REST qui s’aligne sur les offres d’OpenAI.

- Gestion des ressources : garantit une utilisation efficace des ressources du processeur et du processeur graphique pour éviter la surcharge du système.

Avantages

- Une collection robuste de modèles divers disponibles.

- Possibilité d’importer des modèles à partir de bibliothèques comme PyTorch.

- S’intègre bien avec un support de bibliothèque étendu.

Inconvénients

- Aucune interface utilisateur graphique fournie.

- Besoins de stockage relativement élevés.

Conclusion

En conclusion, les outils LLM locaux constituent une excellente alternative aux modèles basés sur le cloud, garantissant une confidentialité renforcée et un contrôle total sans aucun coût. Que vous recherchiez une simplicité d’utilisation ou des options de personnalisation étendues, les outils mis en avant répondent à différents niveaux d’expertise et exigences.

Le choix du bon outil dépend de facteurs tels que les capacités de traitement et la compatibilité, vous permettant d’exploiter la puissance de l’IA sans sacrifier la confidentialité ni encourir de frais d’abonnement.

Laisser un commentaire