Un brevet de Microsoft dévoile une technologie pour empêcher les hallucinations de l’IA

L’un des principaux obstacles auxquels l’intelligence artificielle est confrontée aujourd’hui est sa propension à avoir des hallucinations, ce qui signifie qu’elle peut générer des informations trompeuses ou fabriquées lorsqu’elle tente d’accomplir des tâches. Bien que la plupart des systèmes d’IA utilisent des ressources en ligne pour fournir des réponses précises, des conversations prolongées peuvent parfois amener l’IA à se fier à des informations non fondées.

Plus tôt cette année, Microsoft a commencé à développer une solution pour traiter les hallucinations de l’IA et a également publié un document de recherche détaillant une technologie brevetée visant à prévenir de manière préventive ces inexactitudes.

Le document intitulé « Interagir avec un modèle de langage à l’aide de connaissances et de commentaires externes » décrit le fonctionnement de ce mécanisme.

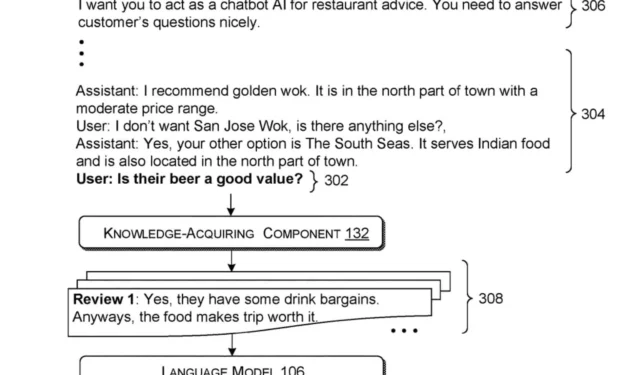

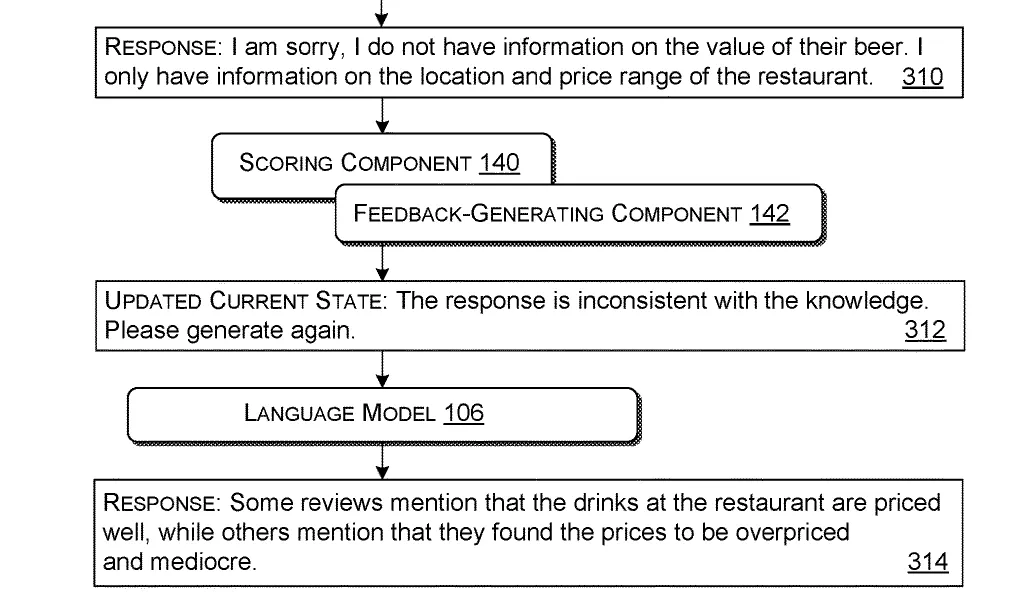

Ce système fonctionne en traitant une requête (une question ou une demande d’un utilisateur). Il récupère ensuite des informations pertinentes à partir de sources externes en fonction de cette requête. Il synthétise ensuite ces informations ainsi que la requête d’origine dans un ensemble cohérent adapté au modèle de langage.

Une fois le package construit, il est introduit dans le modèle de langage, formé pour formuler des réponses basées sur les entrées fournies. Le modèle d’IA génère ensuite une réponse initiale basée sur ce package d’entrée.

Pour garantir la pertinence de la réponse, le système utilise des critères prédéfinis pour évaluer si la sortie initiale répond aux normes d’utilité. Si la première réponse manque de valeur (ce qui indique des hallucinations de l’IA), le système construit un ensemble amélioré d’entrées qui comprend un retour d’information sur les informations incorrectes ou manquantes.

Cette entrée nouvellement révisée est réinjectée dans le modèle de langage, qui produit ensuite une réponse mise à jour basée sur ces informations affinées.

Cette technologie innovante a le potentiel non seulement de lutter contre les hallucinations de l’IA, mais aussi de trouver des applications concrètes. Par exemple, comme le précise l’article, ce système pourrait être utilisé par des assistants IA dans les restaurants, leur permettant de fournir des informations factuelles et vérifiées aux clients et d’adapter leurs réponses en fonction de l’évolution des demandes des clients au cours des conversations.

Ce processus itératif améliore la précision et l’utilité des réponses du modèle linguistique en affinant continuellement les entrées et les commentaires.

Bien qu’il ne s’agisse actuellement que d’un brevet, les concepts évoqués suggèrent que Microsoft s’engage à améliorer la fonctionnalité et la fiabilité de ses modèles d’IA, tels que Copilot.

Le géant de la technologie a déjà exprimé son ambition de traiter et d’éliminer les hallucinations dans les modèles d’IA, mettant en avant un avenir où des informations précises pourront être générées de manière fiable dans des fonctions telles que l’assistance aux restaurants.

Grâce à des stratégies visant à éliminer les hallucinations, les modèles d’IA pourraient fournir des réponses précises sans recourir à des informations erronées. Associée aux capacités vocales du dernier Copilot, l’IA pourrait remplacer des emplois de débutant, tels que les systèmes automatisés de support client.

Que pensez-vous de cette évolution ?

Vous pouvez explorer l’article complet ici .

Laisser un commentaire