Comment utiliser la diffusion stable pour créer des images générées par l’IA

Les chatbots d’intelligence artificielle, comme ChatGPT, sont devenus incroyablement puissants récemment – ils sont partout dans l’actualité ! Mais n’oubliez pas les générateurs d’images AI (comme Stable Diffusion, DALL-E et Midjourney). Ils peuvent faire pratiquement n’importe quelle image lorsqu’ils sont fournis avec seulement quelques mots. Suivez ce didacticiel pour apprendre à le faire gratuitement et sans restriction en exécutant Stable Diffusion sur votre ordinateur.

Qu’est-ce que la diffusion stable ?

Stable Diffusion est un modèle d’apprentissage automatique texte-image gratuit et open source. Fondamentalement, c’est un programme qui vous permet de décrire une image en utilisant du texte, puis crée l’image pour vous. On lui a donné des milliards d’images et des descriptions textuelles d’accompagnement et on lui a appris à les analyser et à les reconstruire.

Stable Diffusion n’est pas le programme que vous utilisez directement – pensez-y plutôt comme l’outil logiciel sous-jacent que d’autres programmes utilisent. Ce tutoriel montre comment installer un programme Stable Diffusion sur votre ordinateur. Notez qu’il existe de nombreux programmes et sites Web qui utilisent Stable Diffusion, mais beaucoup vous factureront de l’argent et ne vous donneront pas autant de contrôle.

Configuration requise

Les lignes directrices approximatives pour ce que vous devriez viser sont les suivantes :

- macOS : Apple Silicon (une puce de la série M)

- Windows ou Linux : GPU NVIDIA ou AMD

- RAM : 16 Go pour de meilleurs résultats

- VRAM GPU : au moins 4 Go

- Stockage : au moins 15 Go

Installer l’interface utilisateur Web AUTOMATIC1111

Nous utilisons le programme AUTOMATIC1111 Web UI , disponible sur tous les principaux systèmes d’exploitation de bureau, pour accéder à Stable Diffusion. Assurez-vous de noter où le répertoire « stable-diffusion-webui » est téléchargé.

Interface utilisateur Web AUTOMATIC1111 sur macOS

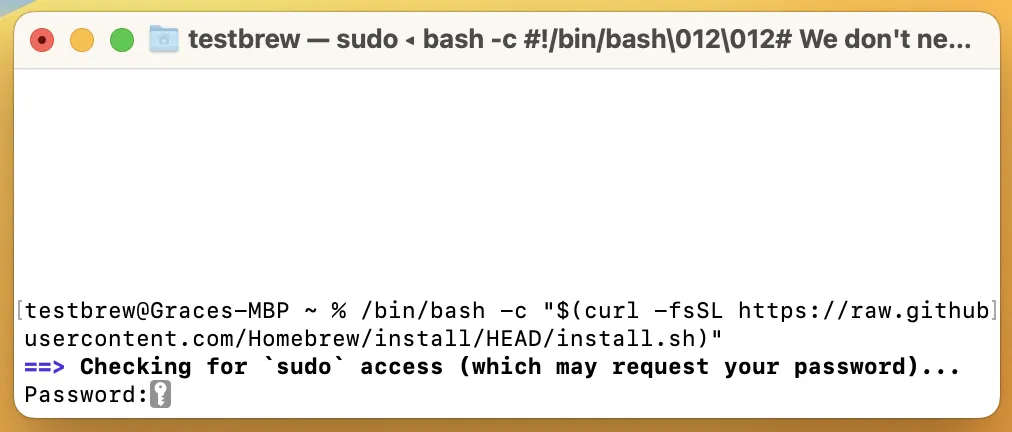

- Dans Terminal, installez Homebrew en saisissant la commande :

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"

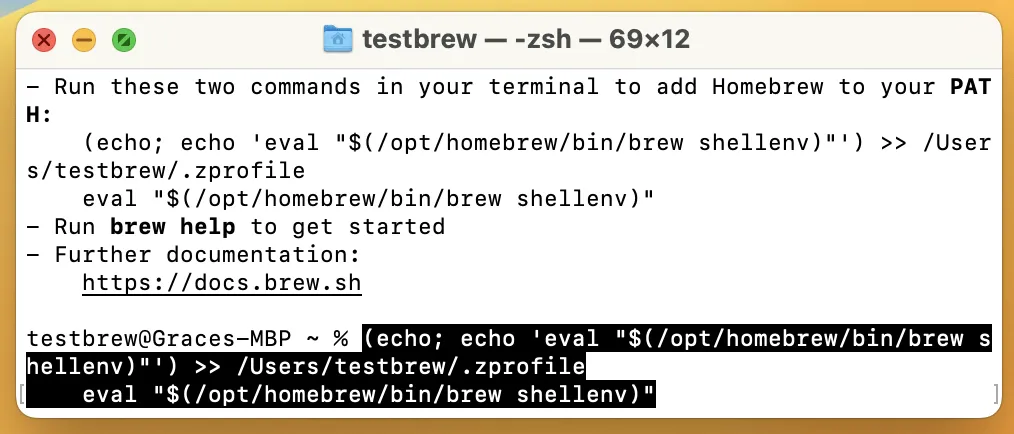

- Copiez les deux commandes pour ajouter Homebrew à votre PATH et entrez-les.

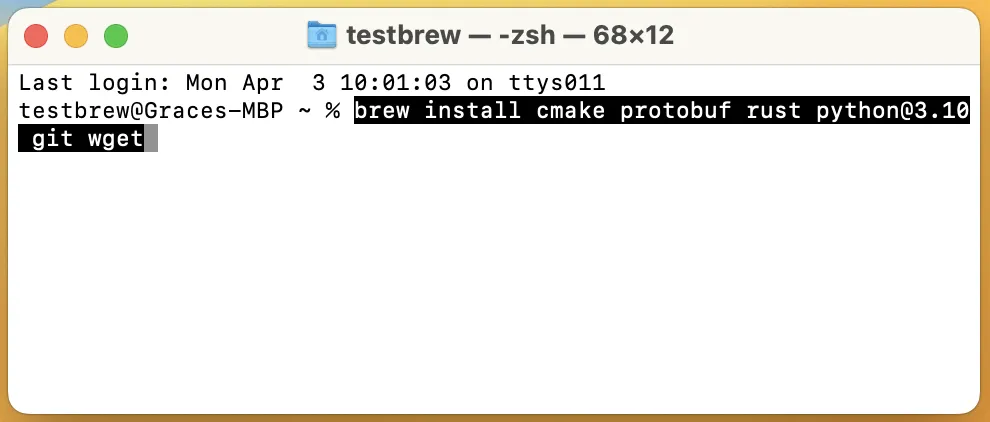

- Quittez et rouvrez Terminal, puis entrez :

brew install cmake protobuf rust python@3.10 git wget

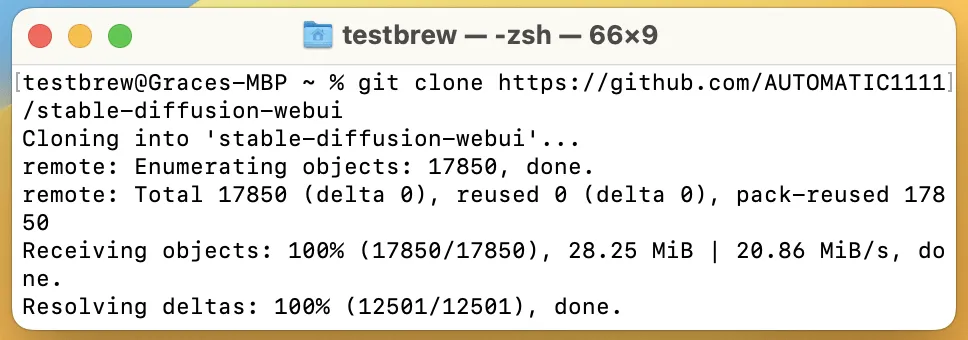

- Entrer:

git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui

Interface utilisateur Web AUTOMATIC1111 sous Windows

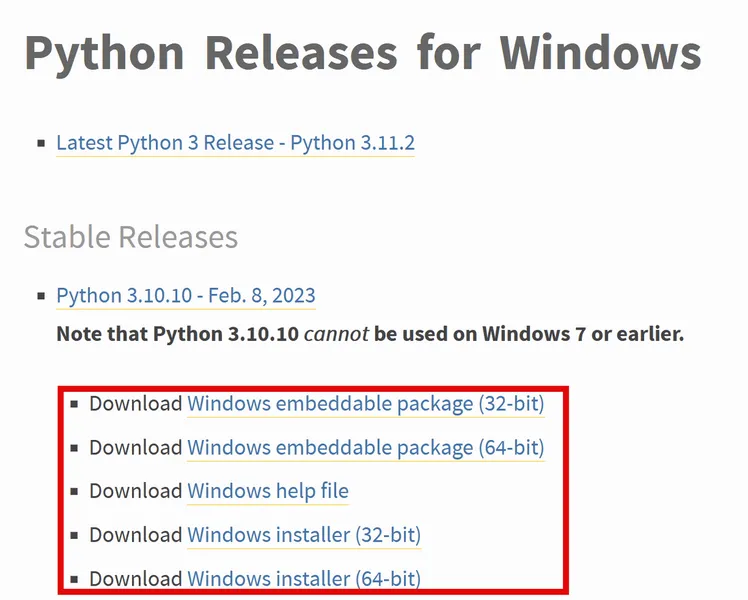

- Téléchargez la dernière version stable de Python 3.10 .

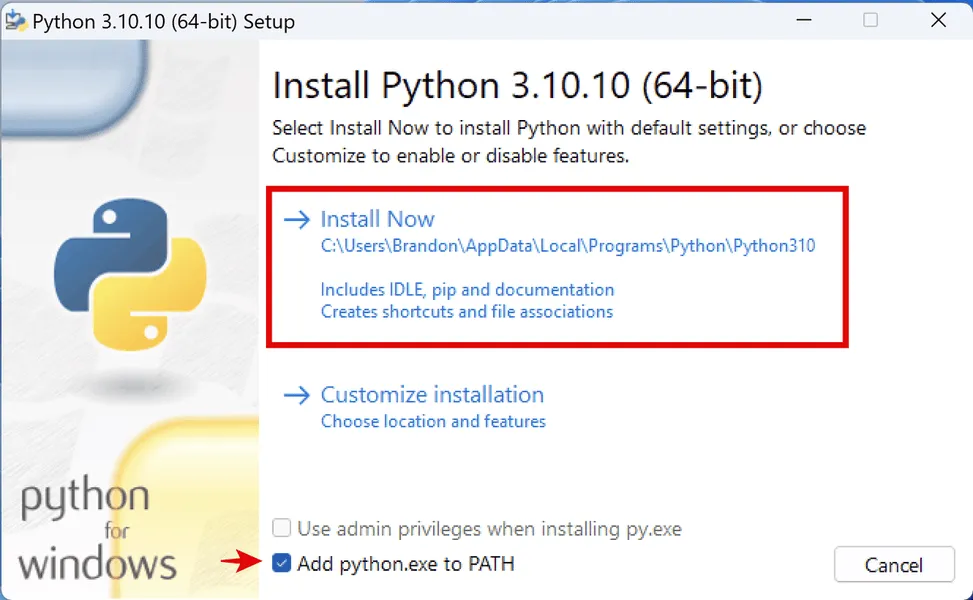

- Exécutez le programme d’installation de Python, cochez « Ajouter python.exe à PATH » et cliquez sur « Installer maintenant ».

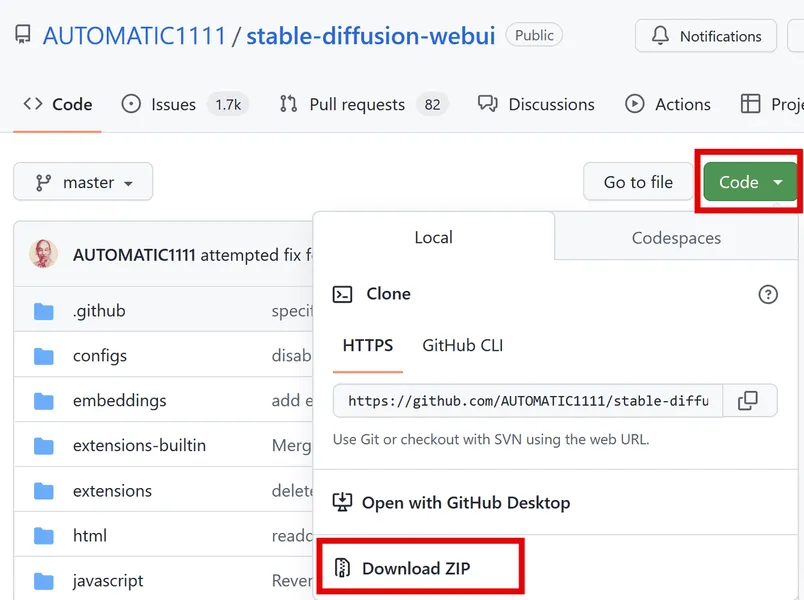

- Accédez au référentiel de l’interface utilisateur Web AUTOMATIC1111 sur GitHub, cliquez sur « Code », puis sur « Télécharger le ZIP » et extrayez-le.

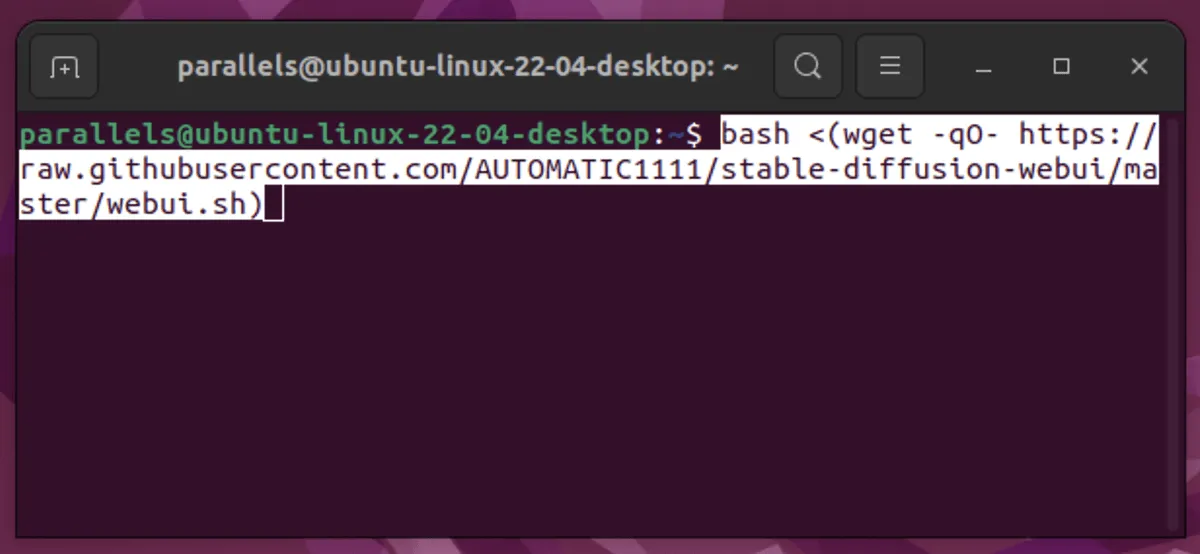

AUTOMATIC1111 Interface utilisateur Web sous Linux

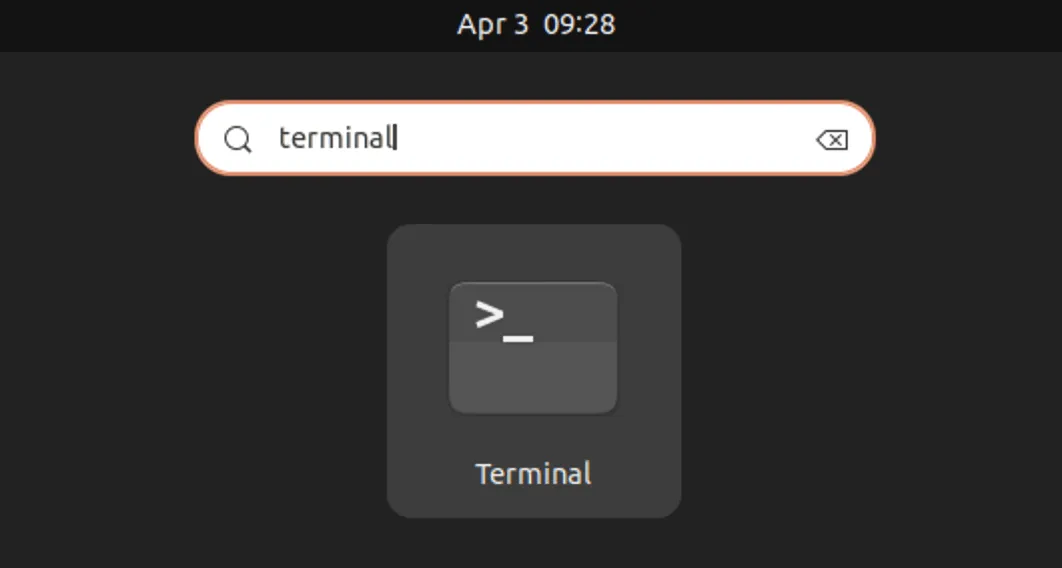

- Ouvrez la borne.

- Saisissez l’une des commandes suivantes, en fonction de votre type de Linux :

Basé sur Debian, y compris Ubuntu :

sudo apt-get updatesudo apt install wget git python3 python3-ven

Basé sur Red Hat :

sudo dnf install wget git python3

Basé sur Arch :

sudo pacman -S wget git python3

- Installez dans « /home/$(whoami)/stable-diffusion-webui/ » en exécutant cette commande :

bash <(wget -qO- https://raw.githubusercontent.com/AUTOMATIC1111/stable-diffusion-webui/master/webui.sh)

Installer un modèle

Vous devrez toujours ajouter au moins un modèle avant de pouvoir commencer à utiliser l’interface utilisateur Web.

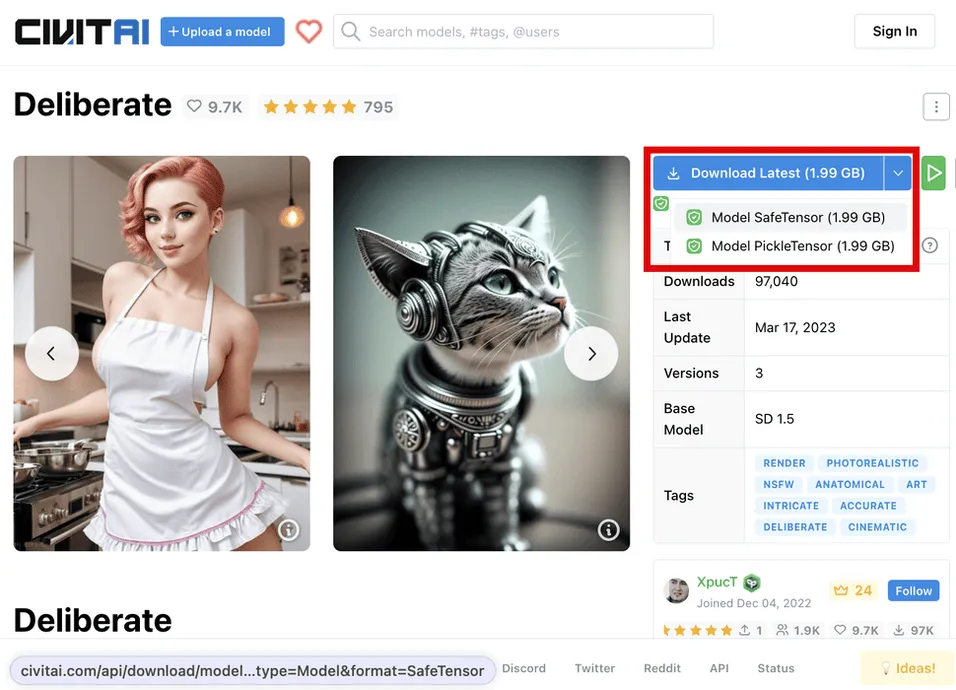

- Allez à CIVITAI .

- Cliquez sur la flèche déroulante sur le bouton de téléchargement et sélectionnez « Modèle SafeTensor ».

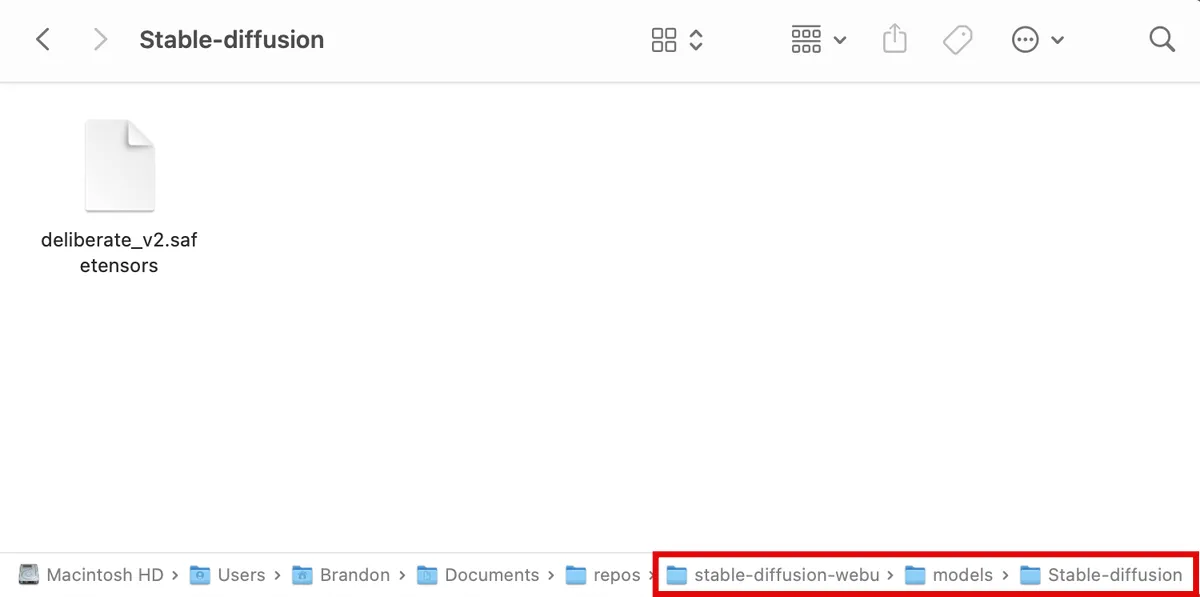

- Bouge le. safetensors téléchargé à l’étape 2 dans votre dossier « stable-diffusion-webui/models/Stable-diffusion ».

Exécuter et configurer l’interface utilisateur Web

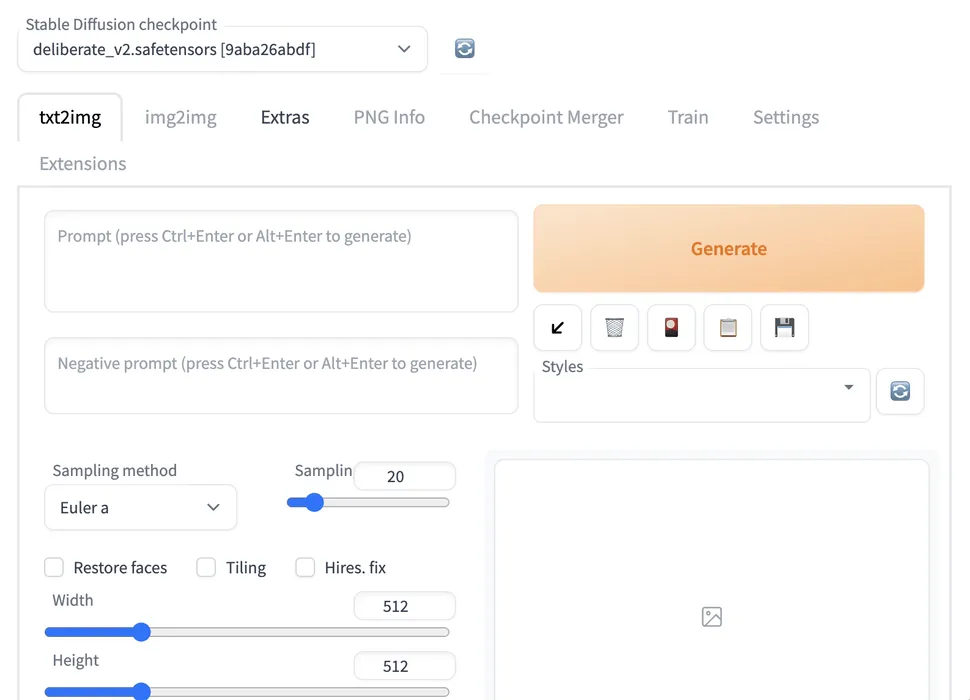

À ce stade, vous êtes prêt à exécuter et à commencer à utiliser le programme Stable Diffusion dans votre navigateur Web.

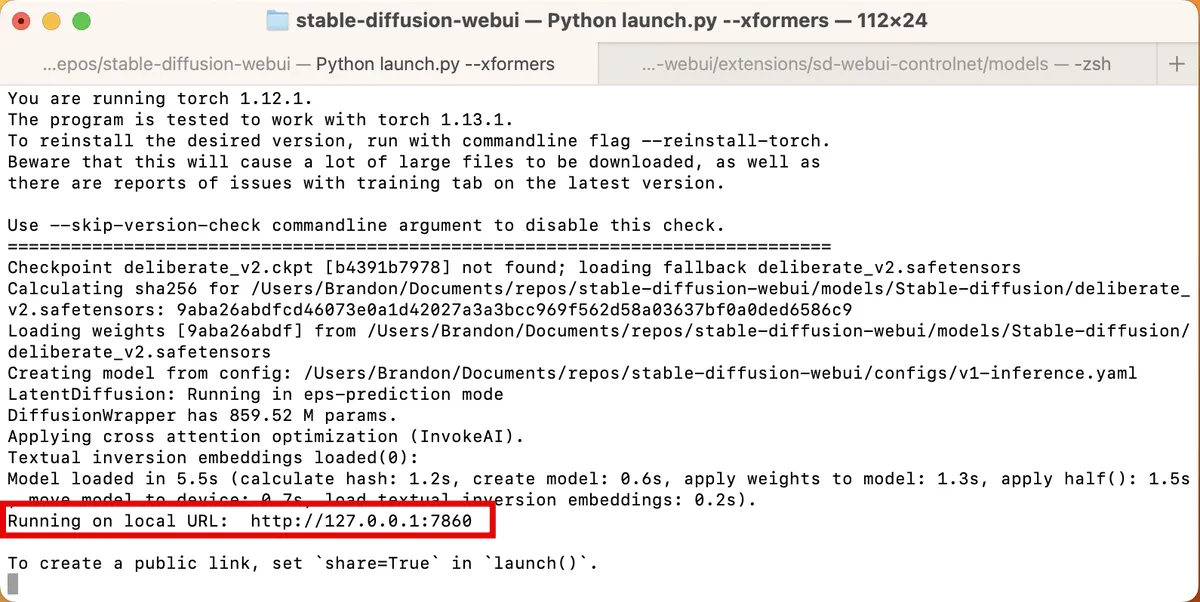

- Dans votre terminal, ouvrez votre répertoire « stable-diffusion-webui » et entrez la commande

./webui.sh --xformerspour Linux/macOS ou./webui-user.batpour Windows. Une fois terminé, sélectionnez et copiez l’URL à côté de « Exécuter sur l’URL locale », qui devrait ressembler à http://127.0.0.1:7860.

- Collez le lien dans la barre d’adresse de votre navigateur et appuyez sur Enter. Le site Web de l’interface utilisateur Web s’affiche.

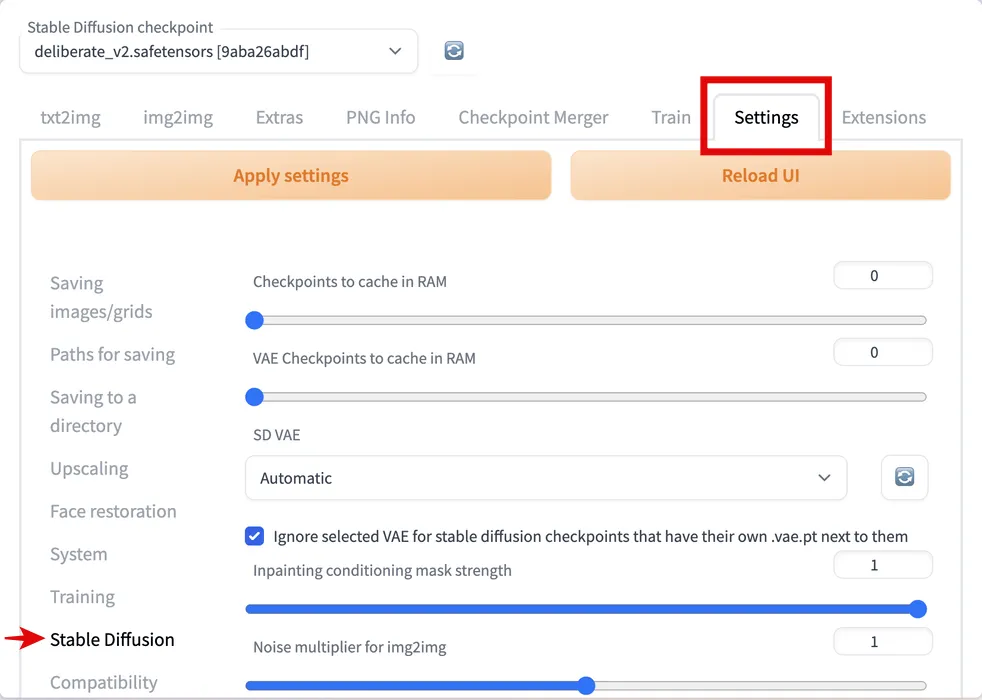

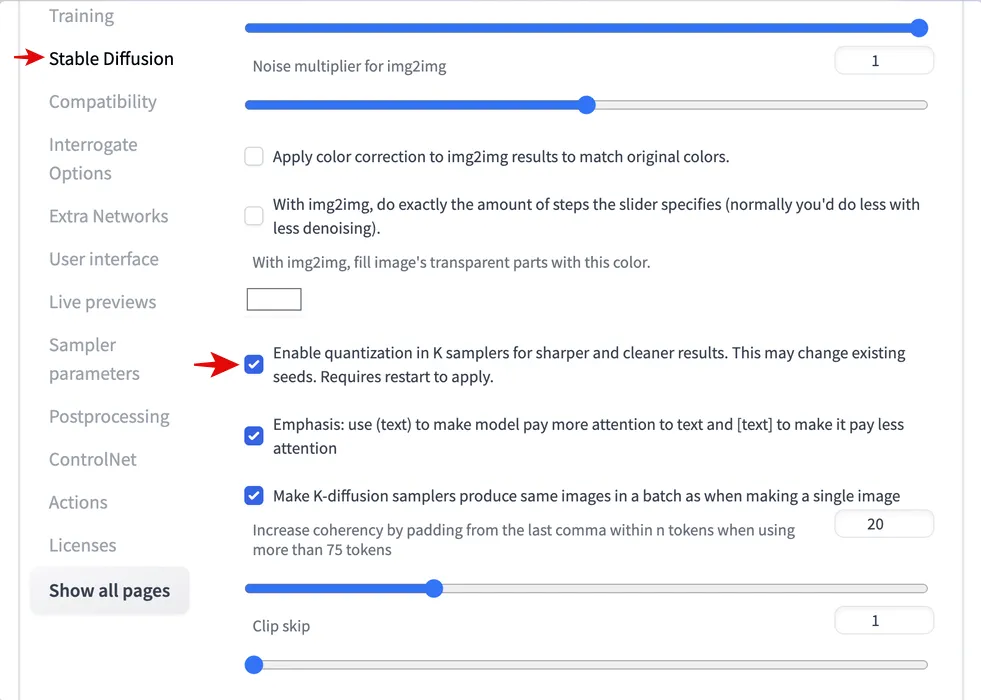

- Modifions quelques paramètres pour de meilleurs résultats. Allez dans « Paramètres -> Diffusion stable ».

- Faites défiler vers le bas et cochez « Activer la quantification dans les échantillonneurs K pour des résultats plus nets et plus propres ».

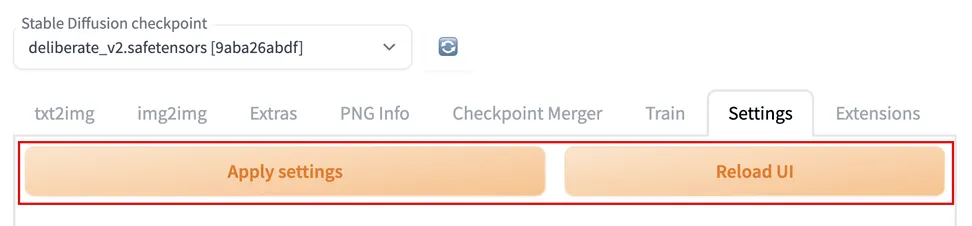

- Faites défiler vers le haut et cliquez sur « Appliquer les paramètres », puis sur « Recharger l’interface utilisateur ».

FYI : Si vous avez besoin de trouver une source d’image, utilisez Google.

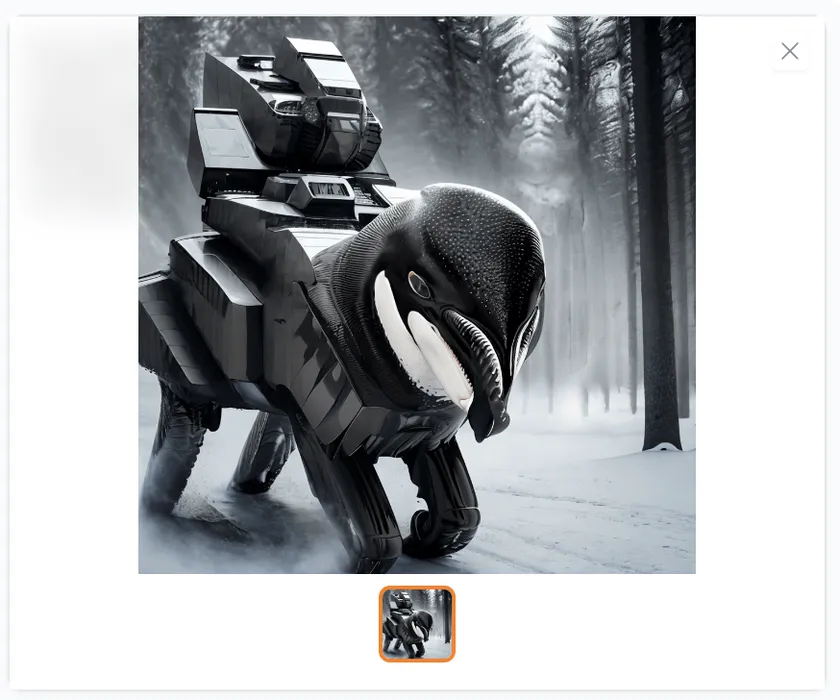

Utilisez txt2txt pour générer des images conceptuelles

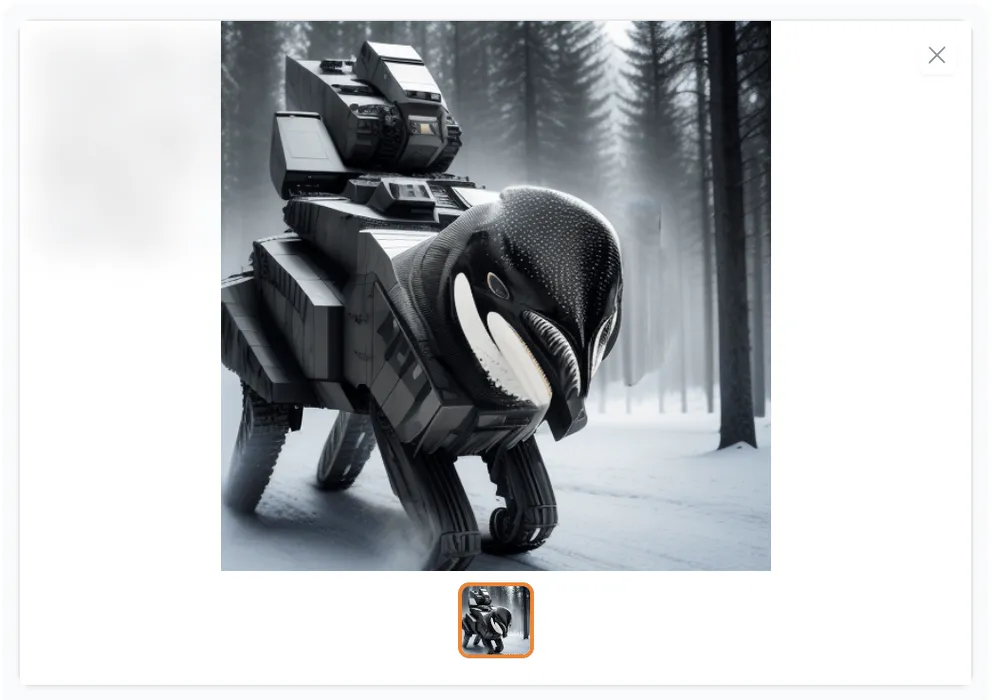

Vient maintenant la partie amusante : créer quelques images initiales et rechercher celle qui ressemble le plus au look que vous souhaitez.

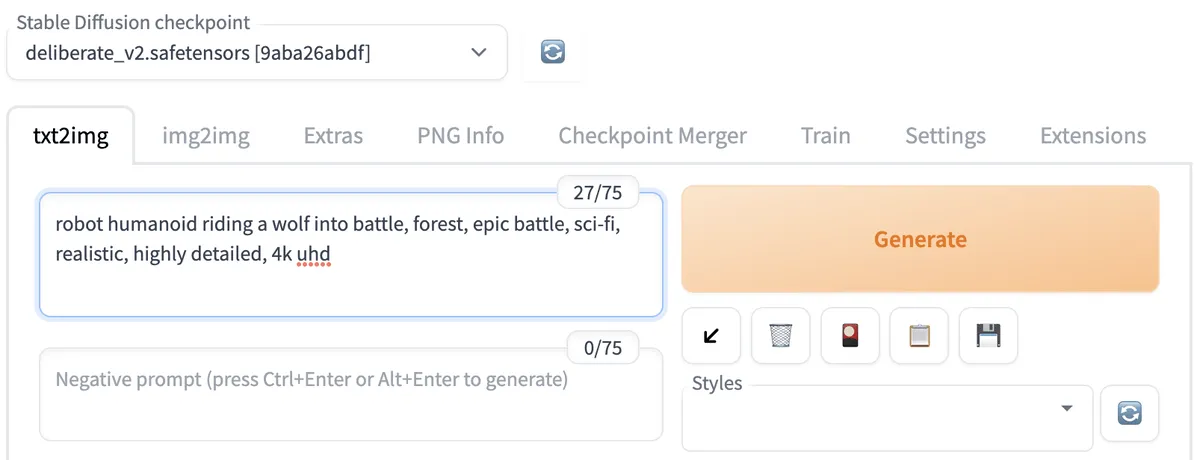

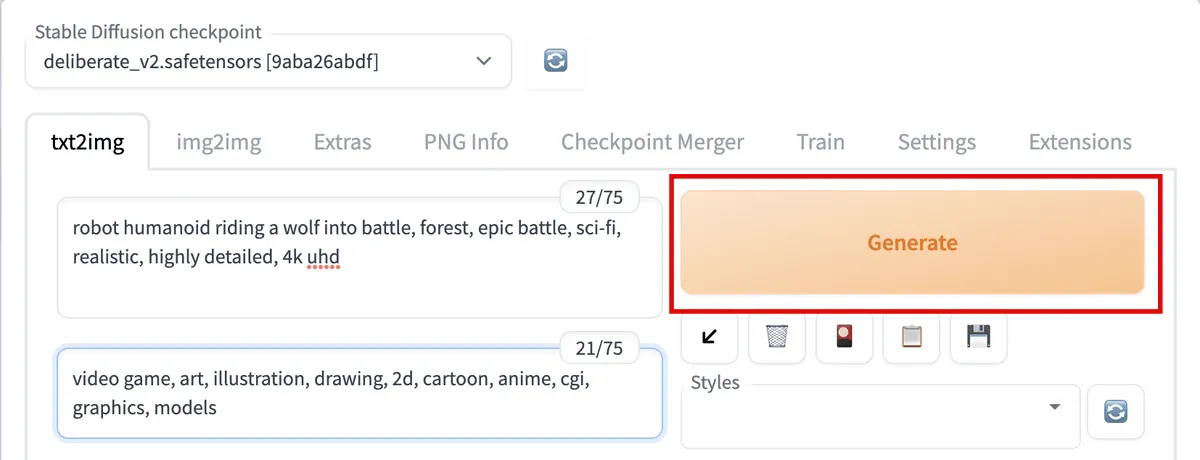

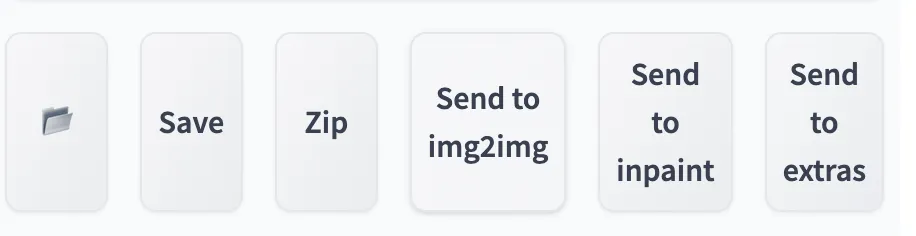

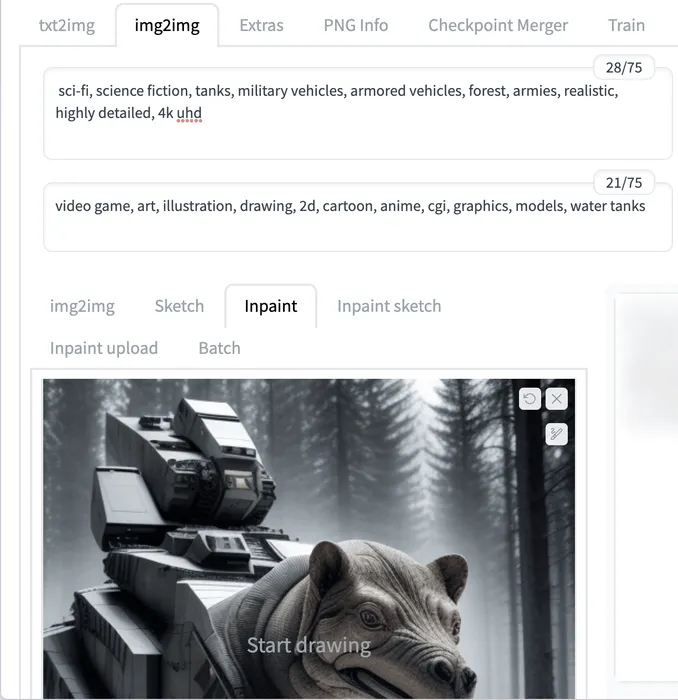

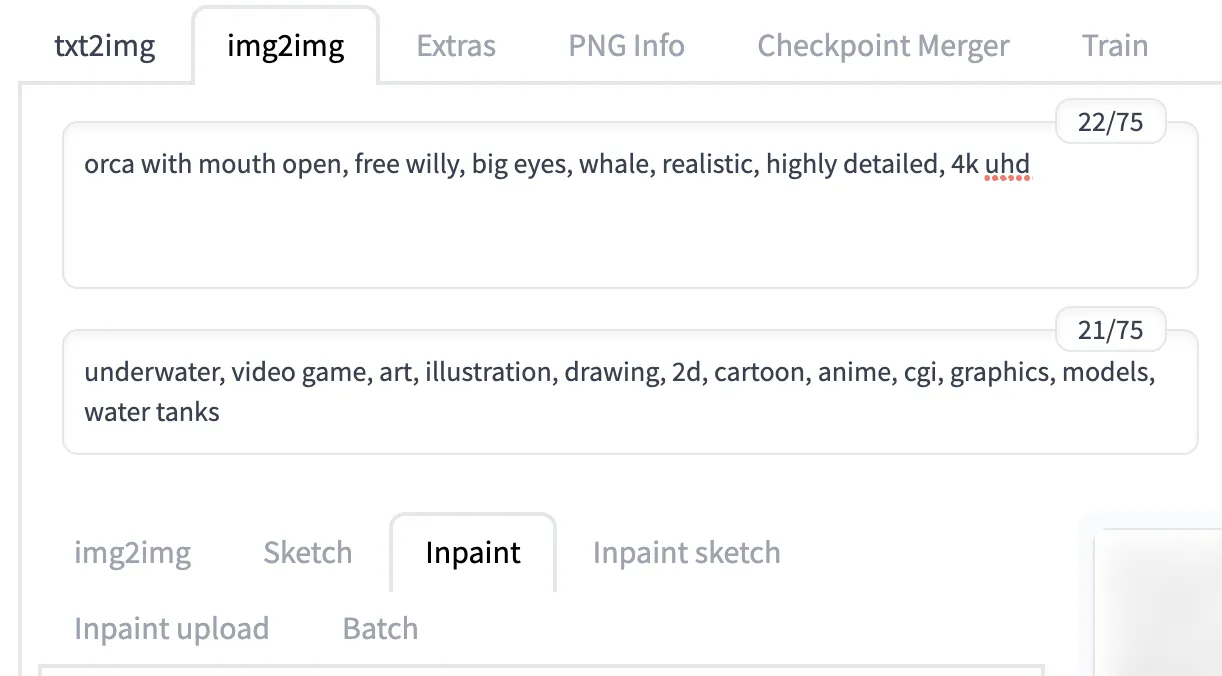

- Allez dans l’onglet « txt2img ».

- Dans la première zone de texte d’invite, saisissez les mots décrivant votre image séparés par des virgules. Il est utile d’inclure des mots décrivant le style de l’image, tels que « réaliste », « détaillé » ou « portrait en gros plan ».

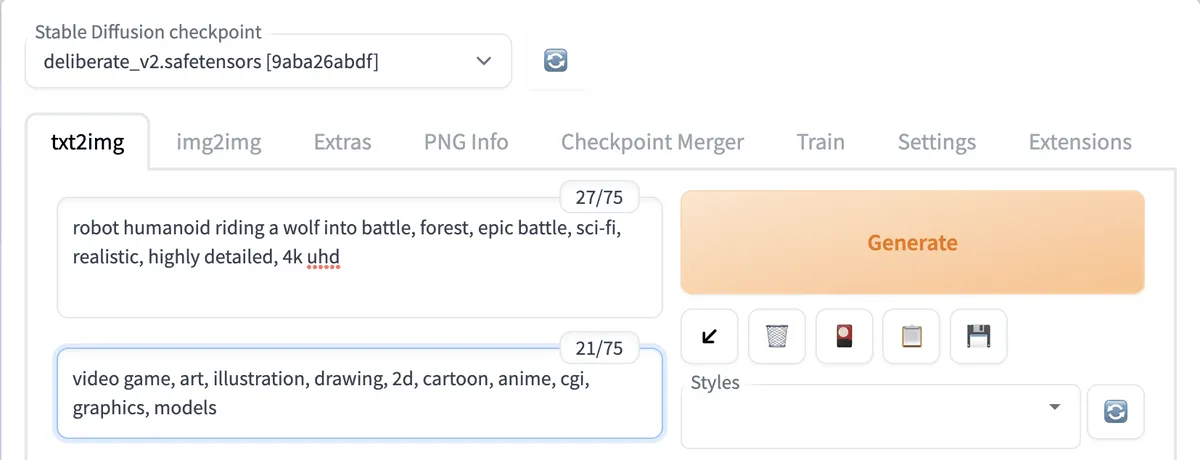

- Dans la zone de texte d’invite négative ci-dessous, saisissez les mots clés auxquels vous ne voulez pas que votre image ressemble. Par exemple, si vous essayez de créer des images réalistes, ajoutez des mots comme « jeu vidéo », « art » et « illustration ».

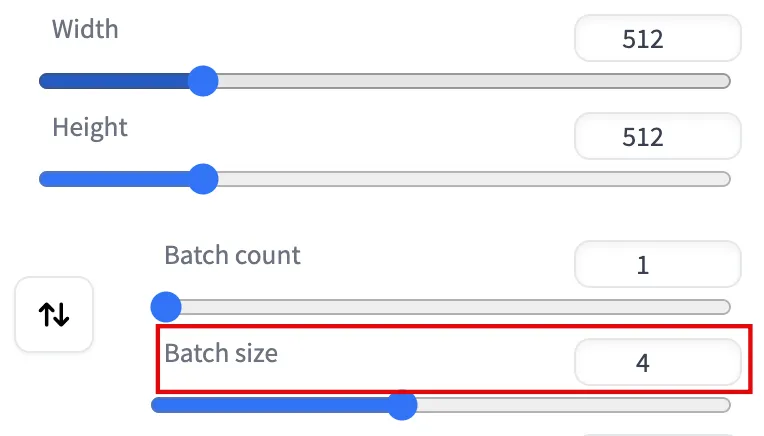

- Faites défiler vers le bas et réglez « Taille du lot » sur « 4 ». Cela permettra à Stable Diffusion de produire quatre images différentes à partir de votre invite.

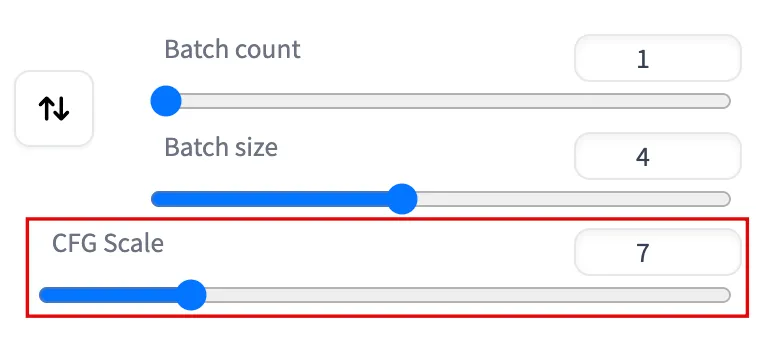

- Augmentez la valeur de «l’échelle CFG» si vous souhaitez que Stable Diffusion suive plus strictement vos mots clés d’invite ou une valeur inférieure si vous souhaitez qu’elle soit plus créative. Une valeur faible (comme la valeur par défaut de 7) produit généralement des images de bonne qualité et créatives.

- Laissez les autres paramètres à leurs valeurs par défaut pour le moment. Cliquez sur le gros bouton « Générer » en haut pour que Stable Diffusion commence à fonctionner.

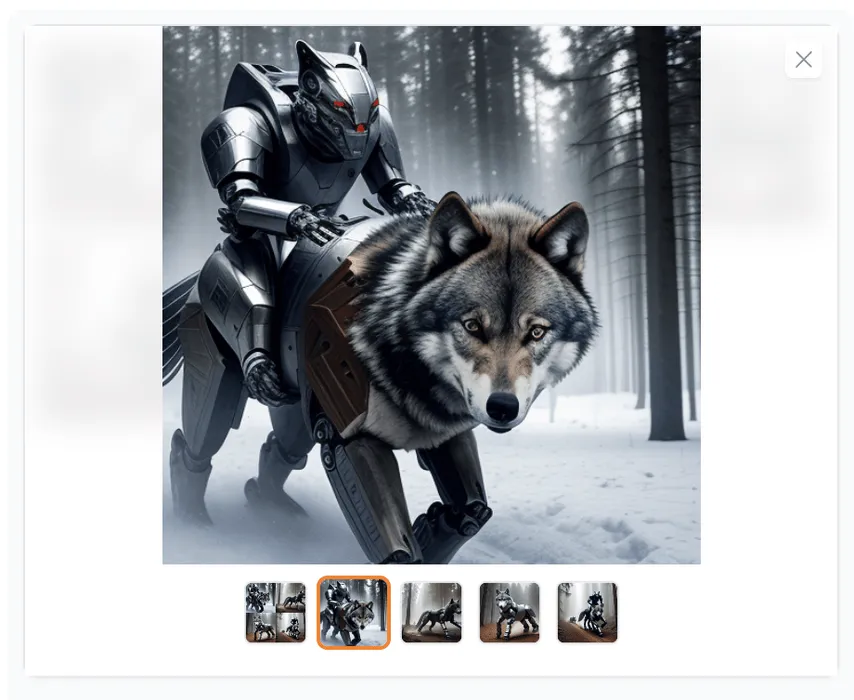

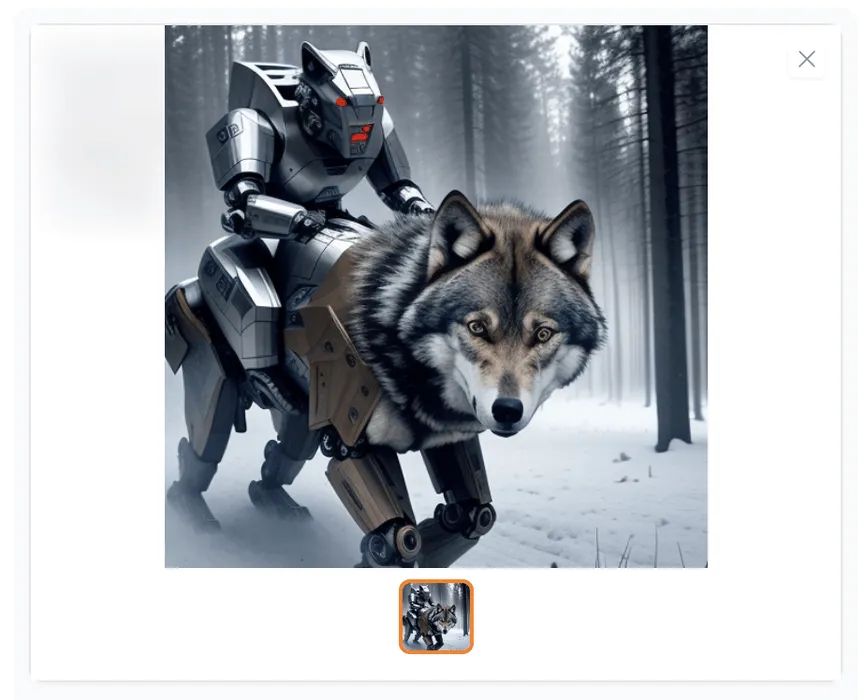

- Sous le bouton « Générer », cliquez sur les vignettes des images pour les prévisualiser et déterminer si vous aimez l’une d’entre elles.

Si vous n’aimez aucune des images, répétez les étapes 1 à 5 avec de légères variations.

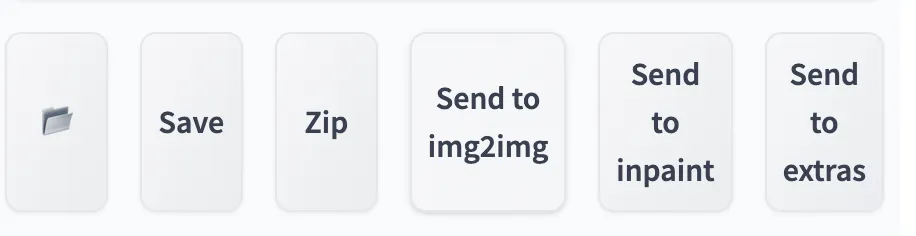

Si vous aimez une image dans l’ensemble mais que vous souhaitez la modifier ou résoudre des problèmes (un visage déformé, des problèmes anatomiques, etc.), cliquez sur « Envoyer à img2img » ou « Envoyer à inpaint ». Cela copiera votre image et vous invitera dans les onglets respectifs où vous pourrez améliorer l’image.

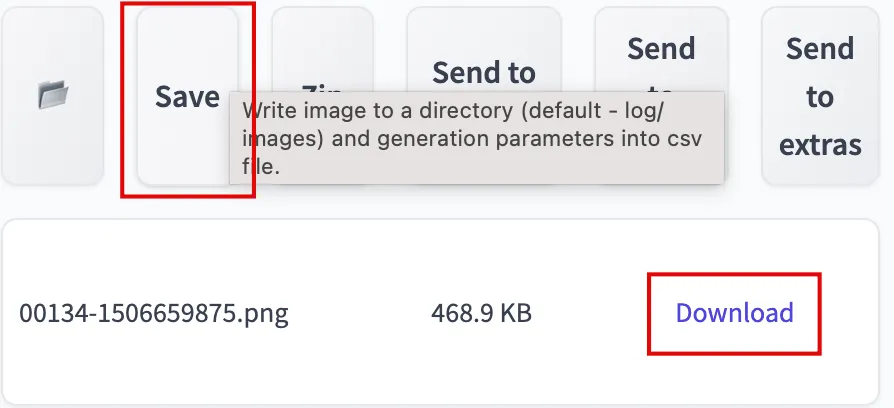

Si une image est exceptionnellement intéressante ou bonne, cliquez sur le bouton « Enregistrer » suivi du bouton « Télécharger ».

Recherche des invites utilisées pour les images passées

Après avoir généré quelques images, il est utile d’obtenir les invites et les paramètres utilisés pour créer une image après coup.

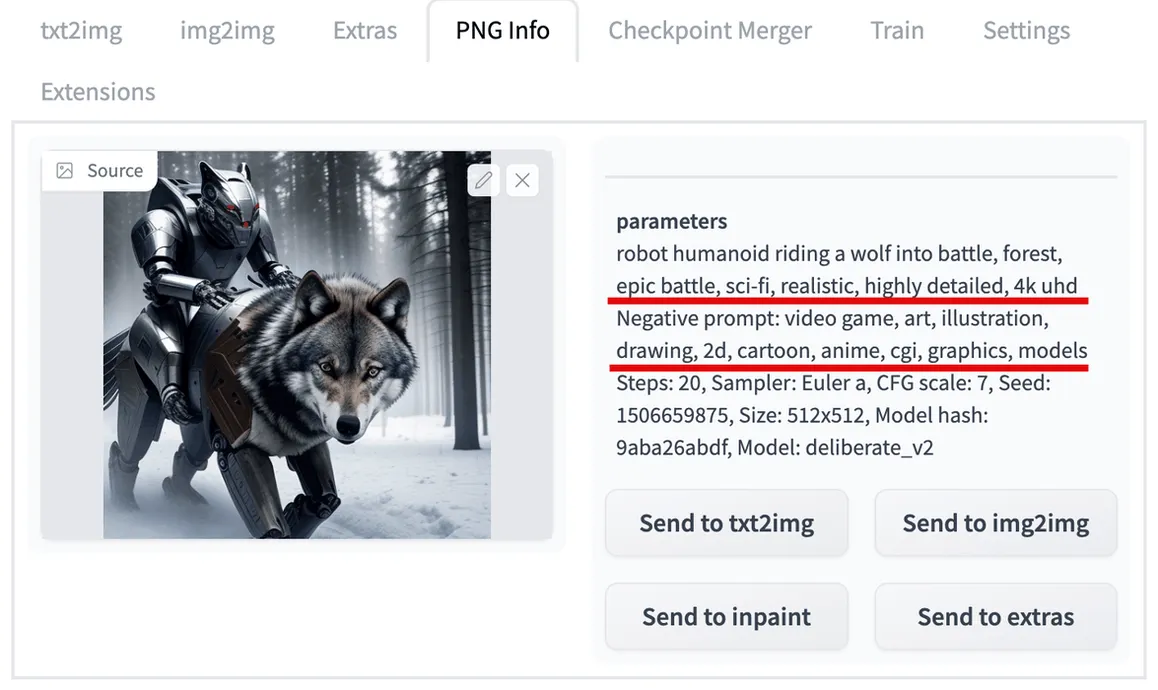

- Cliquez sur l’onglet « Infos PNG ».

- Téléchargez une image dans la boîte. Toutes les invites et autres détails de votre image apparaîtront sur la droite.

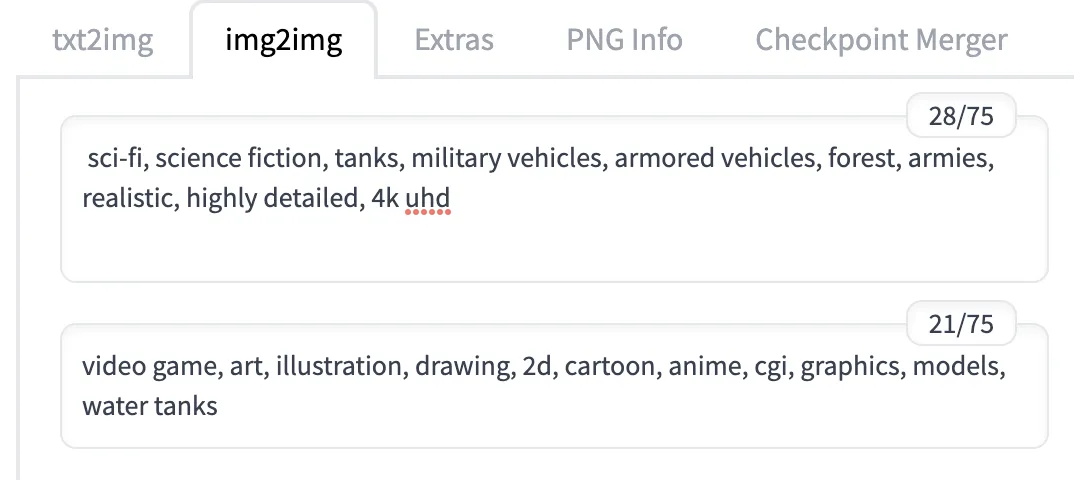

Utilisez img2img pour générer des images similaires

Vous pouvez utiliser la fonction img2img pour générer de nouvelles images imitant l’aspect général de n’importe quelle image de base.

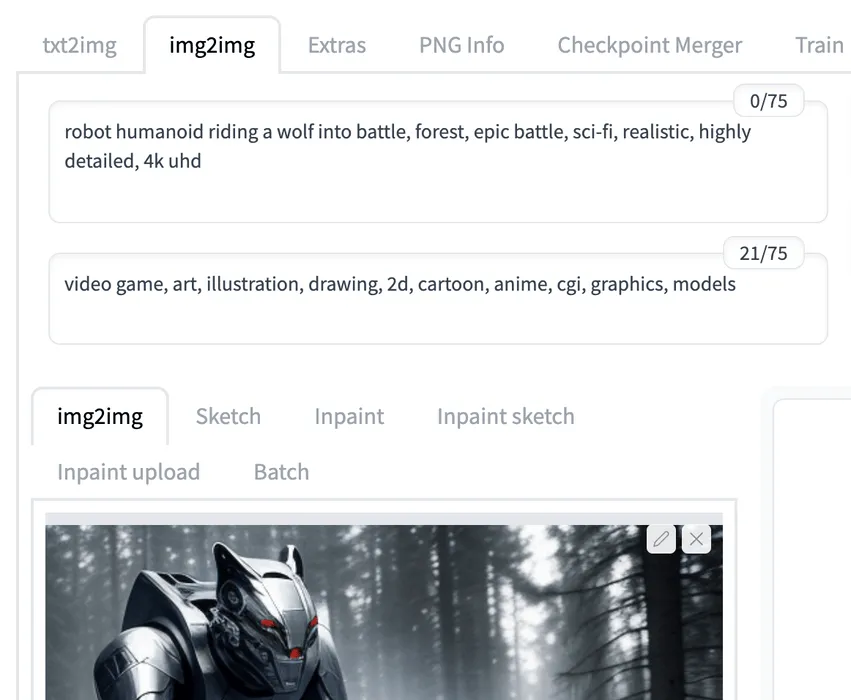

- Dans l’onglet « img2img », assurez-vous que vous utilisez une image générée précédemment avec les mêmes invites.

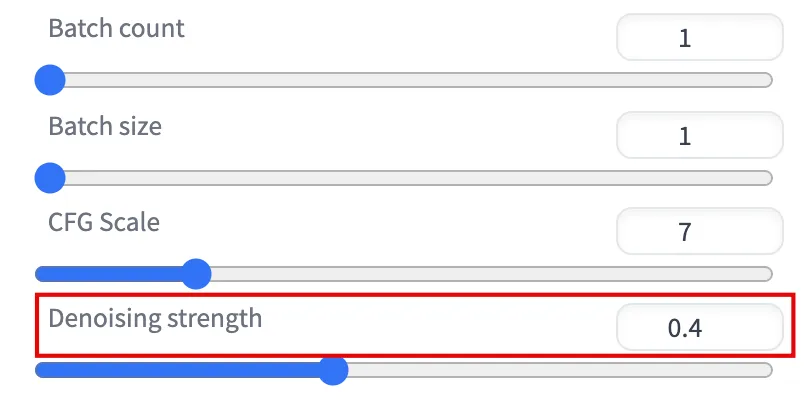

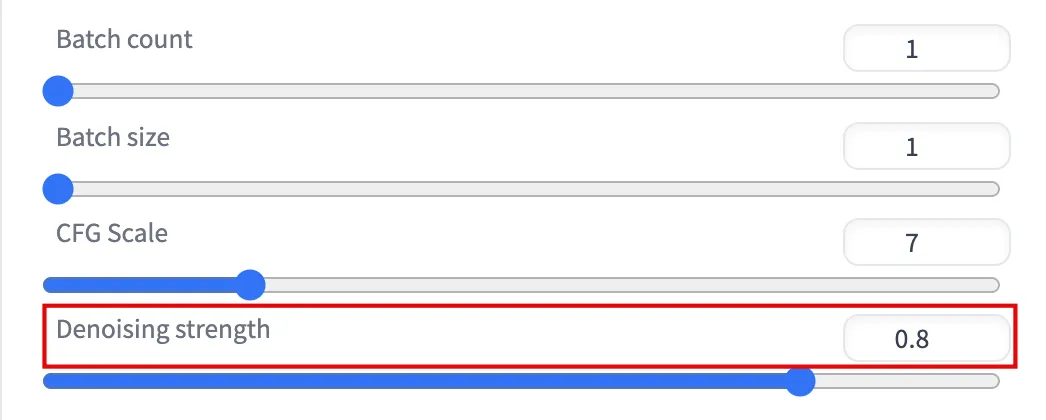

- Réglez la valeur « Denoising Strength » sur une valeur supérieure ou inférieure pour régénérer plus ou moins votre image (0,50 régénère 50 % et 1 régénère 100 %).

- Cliquez sur « Générer » et passez en revue les différences. Si vous n’êtes pas satisfait, répétez les étapes 1 à 3 après avoir modifié les paramètres.

- Vous pouvez également cliquer sur « Envoyer à img2img » pour continuer à apporter des modifications en fonction de la nouvelle image.

- Réécrivez les invites pour ajouter des éléments complètement nouveaux à l’image et ajustez d’autres paramètres comme vous le souhaitez.

- Cliquez sur « Générer » et examinez le résultat.

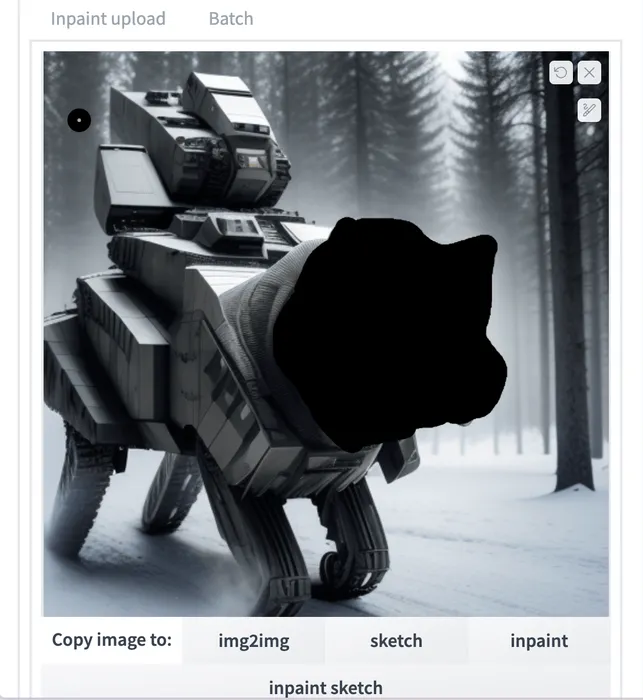

Utiliser inpaint pour modifier une partie d’une image

La fonction inpaint est un outil puissant qui vous permet d’apporter des corrections ponctuelles précises à une image de base en utilisant votre souris pour « peindre » sur les parties d’une image que vous souhaitez régénérer. Les parties que vous n’avez pas peintes ne sont pas modifiées.

- Dans l’onglet « img2img -> onglet Inpaint », assurez-vous que vous utilisez une image générée précédemment.

- Modifiez vos invites si vous souhaitez de nouveaux éléments visuels.

- Utilisez votre souris pour peindre la partie de l’image que vous souhaitez modifier.

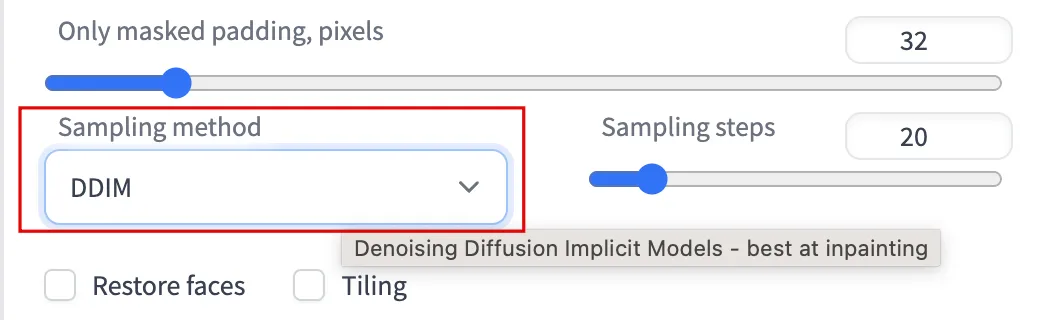

- Changez la « Méthode d’échantillonnage » en DDIM, qui est recommandée pour l’inpainting.

- Définissez la « Force de débruitage », en choisissant une valeur plus élevée si vous apportez des modifications extrêmes.

- Cliquez sur « Générer » et examinez le résultat.

Stable Diffusion ne résoudra probablement pas tout du premier coup, vous pouvez donc cliquer sur « Envoyer à inpaint » et répéter les étapes ci-dessus autant de fois que vous le souhaitez.

Améliorez votre image

Vous avez créé des images relativement petites à 512 x 512 pixels jusqu’à présent, mais si vous augmentez la résolution de votre image, cela augmente également le niveau de détail visuel.

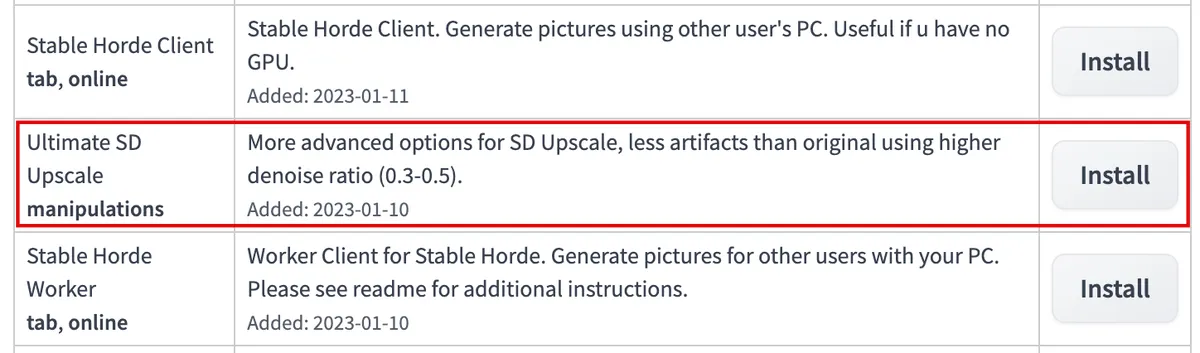

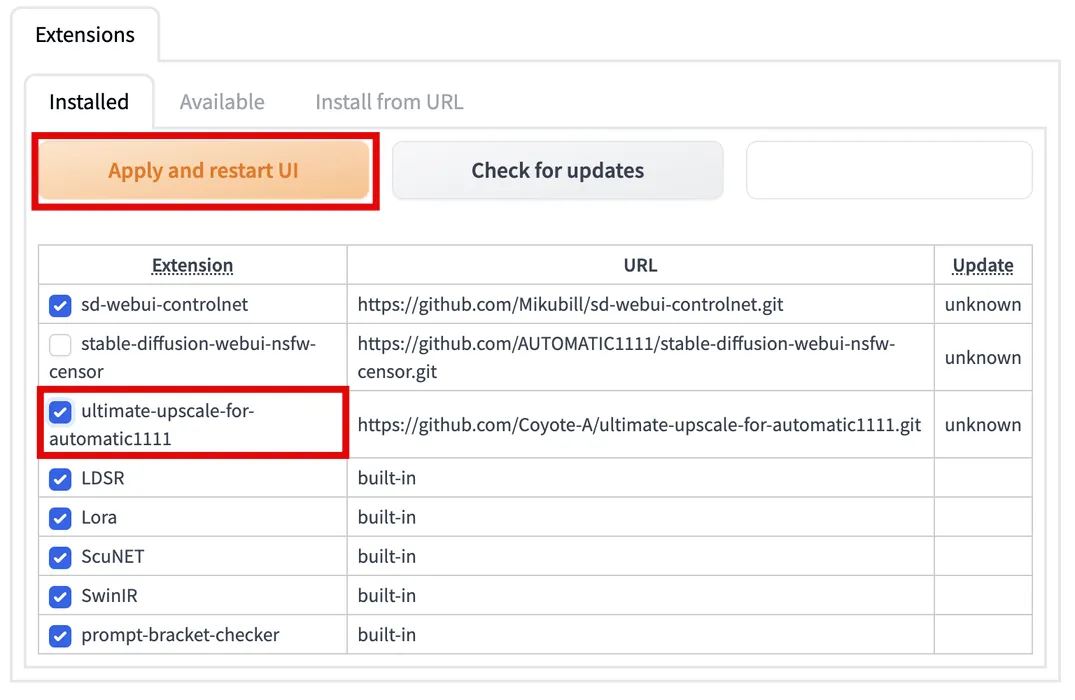

Installez l’extension Ultimate SD Upscale

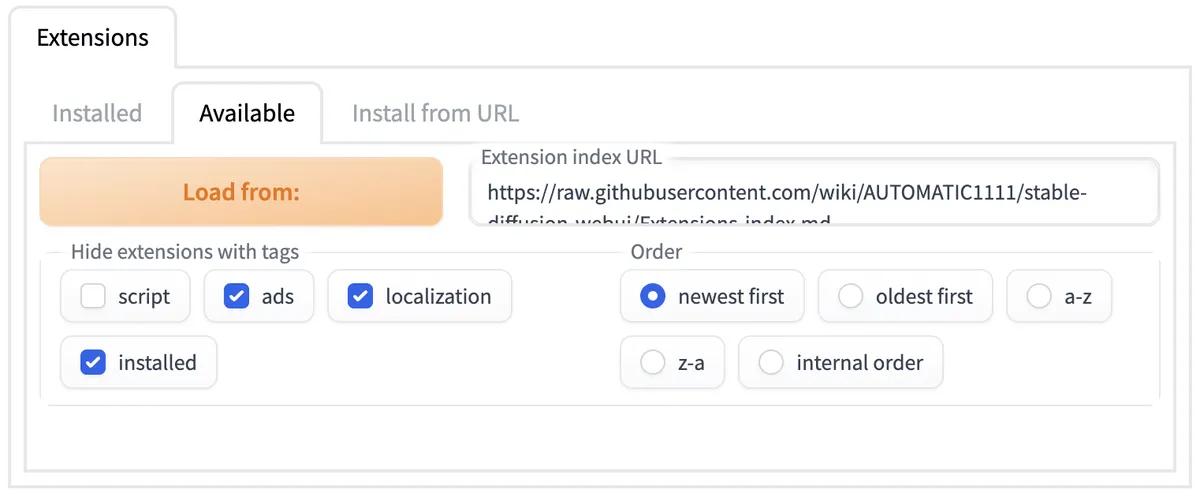

- Cliquez sur « Extensions -> Disponibles -> Charger à partir de ».

- Faites défiler vers le bas pour trouver « Ultimate SD Upscale manipulations » et cliquez sur « Installer ».

- Faites défiler vers le haut et cliquez sur l’onglet « Installé ». Cochez « ultimate-upscale-for-automatic1111 », puis cliquez sur « Appliquer et redémarrer l’interface utilisateur ».

Redimensionner votre image

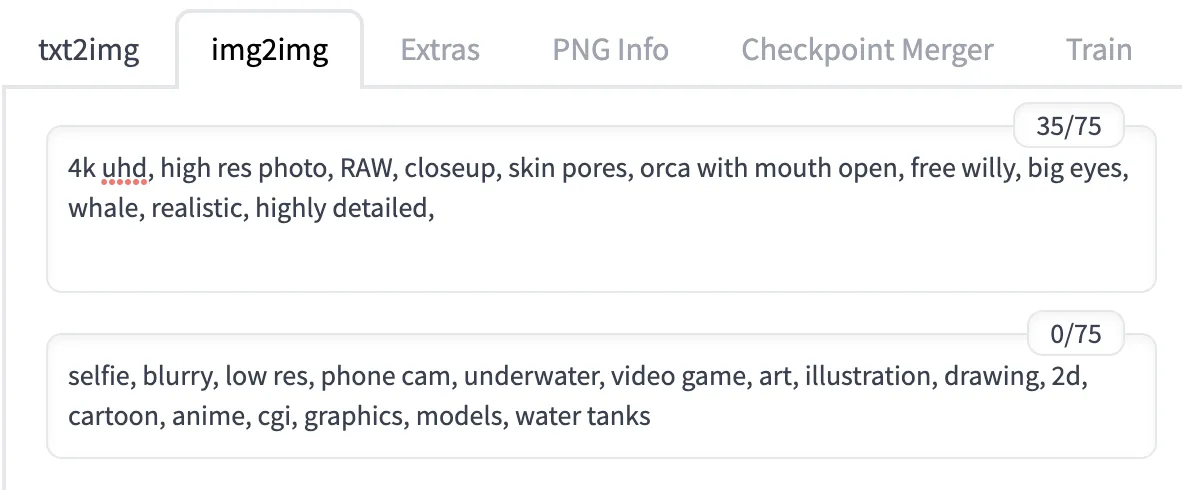

- Dans l’onglet « img2img », assurez-vous que vous utilisez une image générée précédemment avec les mêmes invites. Au début de votre saisie rapide, ajoutez des phrases telles que « 4k », « UHD », « photo haute résolution », « RAW », « gros plan », « pores de la peau » et « yeux détaillés » pour l’affiner davantage. Au début de votre entrée d’invite négative, ajoutez des phrases telles que « selfie », « flou », « basse résolution » et « caméra téléphonique » pour vous éloigner de celles-ci.

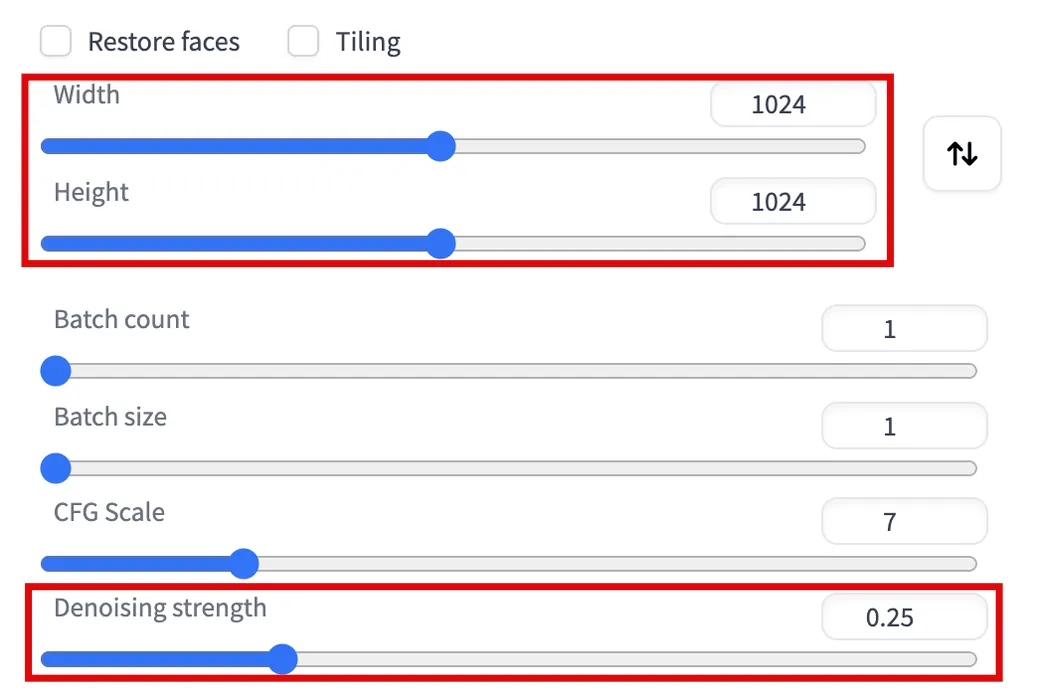

- Réglez votre « Force de débruitage » sur une valeur faible (autour de 0,25) et doublez les valeurs « Largeur » et « Hauteur ».

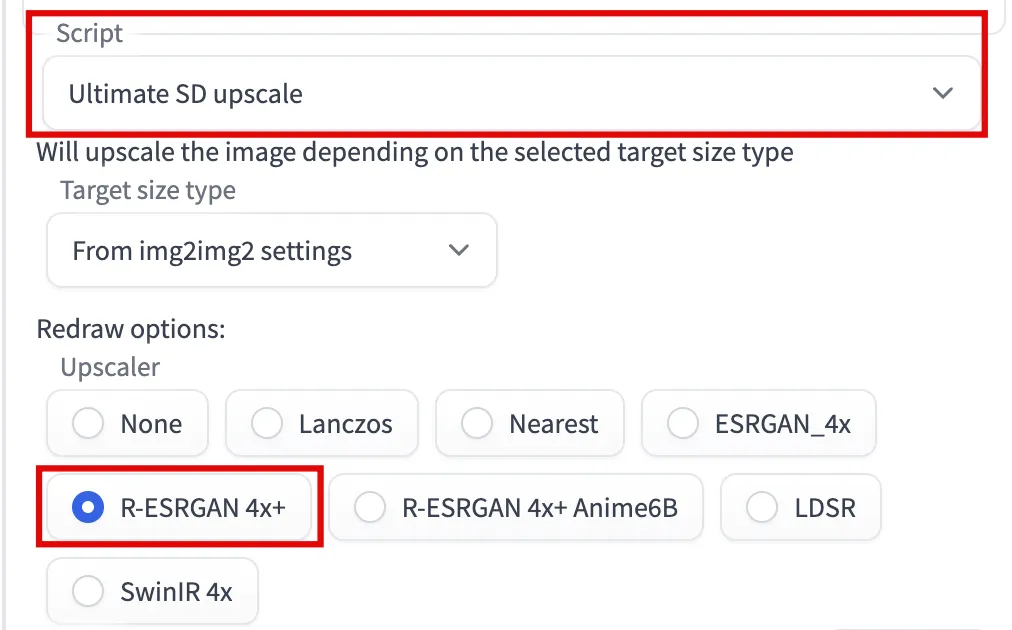

- Dans le menu déroulant « Script », sélectionnez « Ultimate SD upscale », puis sous « Upscaler », cochez l’option « R-ESRGAN 4x+ ».

- Cliquez sur « Générer » et examinez le résultat. Vous devriez remarquer des changements mineurs et des détails plus précis.

Vous pouvez augmenter davantage la résolution en cliquant sur « Envoyer vers img2img » et en répétant les étapes tout en augmentant davantage les valeurs « Largeur » et « Hauteur » et en ajustant la « Force de débruitage ».

Questions fréquemment posées

Quelle est la différence entre Stable Diffusion, DALL-E et Midjourney ?

Tous les trois sont des programmes d’IA qui peuvent créer presque n’importe quelle image à partir d’une invite de texte. La plus grande différence est que seul Stable Diffusion est entièrement gratuit et open source. Vous pouvez l’exécuter sur votre ordinateur sans rien payer, et tout le monde peut apprendre et améliorer le code Stable Diffusion. Le fait que vous deviez l’installer vous-même rend son utilisation plus difficile.

DALL-E et Midjourney sont tous deux des sources fermées. DALL-E est accessible principalement via son site Web et propose un nombre limité de générations d’images par mois avant de vous demander de payer. Midjourney est accessible principalement via des commandes sur son serveur Discord et a différents niveaux d’abonnement.

Qu’est-ce qu’un modèle dans Stable Diffusion ?

Un modèle est un fichier représentant un algorithme d’IA formé sur des images et des mots-clés spécifiques. Différents modèles sont meilleurs pour créer différents types d’images – vous pouvez avoir un modèle bon pour créer des personnes réalistes, un autre qui est bon pour créer des personnages de dessins animés en 2D, et encore un autre qui est meilleur pour créer des peintures de paysage.

Le modèle délibéré que nous avons installé dans ce guide est un modèle populaire qui convient à la plupart des images, mais vous pouvez consulter toutes sortes de modèles sur des sites Web comme Civitai ou Hugging Face . Tant que vous téléchargez un. safetensors, vous pouvez l’importer dans l’interface utilisateur Web AUTOMATIC1111 en suivant les mêmes instructions que dans ce guide.

Quelle est la différence entre SafeTensor et PickleTensor ?

En bref, utilisez toujours SafeTensor pour protéger votre ordinateur contre les menaces de sécurité.

Alors que SafeTensor et PickleTensor sont des formats de fichiers utilisés pour stocker des modèles pour la diffusion stable, PickleTensor est le format le plus ancien et le moins sécurisé. Un modèle PickleTensor peut exécuter du code arbitraire (y compris des logiciels malveillants) sur votre système.

Dois-je utiliser le paramètre de taille de lot ou de nombre de lots ?

Vous pouvez utiliser les deux. Un lot est un groupe d’images générées en parallèle. Le paramètre de taille de lot contrôle le nombre d’images dans un seul lot. Le paramètre de nombre de lots contrôle le nombre de lots exécutés en une seule génération ; chaque lot s’exécute de manière séquentielle.

Si vous avez un nombre de lots de 2 et une taille de lot de 4, vous générerez deux lots et un total de huit images.

Si vous préférez dessiner vous-même, consultez notre liste d’applications de dessin pour Windows.

Crédit image : Pixabay . Toutes les captures d’écran de Brandon Li.

- Tweeter

Laisser un commentaire