Présentation du mode vocal avancé de ChatGPT : attentes et réalité

Principaux points à retenir

- Le mode vocal avancé de ChatGPT manque de plusieurs fonctionnalités essentielles, notamment la fonctionnalité multimodale et une fonction de maintien de la parole, ce qui peut parfois le rendre inutilisable en raison d’une censure excessive.

- Cependant, il bénéficie d’une expressivité impressionnante, capable de parler plusieurs langues, accents et dialectes régionaux, bien qu’il soit incapable de chanter, de fredonner ou de flirter (comme le dicte OpenAI).

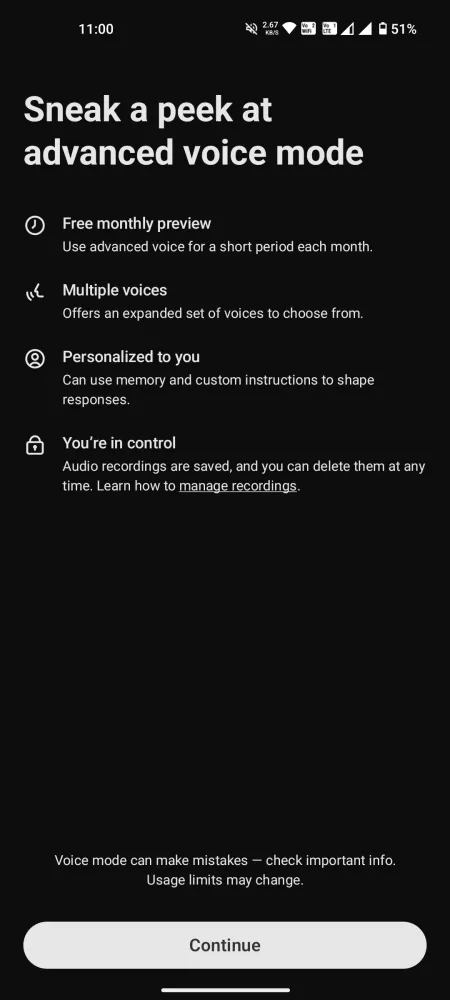

- La fonction de chat est accessible aux utilisateurs gratuits pendant seulement 15 minutes par mois, tandis que les utilisateurs Plus sont soumis à un plafond quotidien strict d’une heure.

Après avoir assisté à la première démonstration, l’enthousiasme autour du mode vocal avancé de ChatGPT était palpable. Pourtant, à la suite de divers défis juridiques et de retards ultérieurs, la fonctionnalité reste considérablement limitée, manquant de fonctionnalités essentielles et contenant certains malentendus qui nuisent à l’expérience attendue.

Malgré le temps limité offert par OpenAI pour les interactions quotidiennes, les utilisateurs peuvent se faire une bonne idée de ses forces, de ses faiblesses et de ses possibilités. Voici mes impressions sincères sur le mode vocal avancé de ChatGPT, soulignant ses mérites, ses inconvénients et pourquoi la vision d’avoir un assistant vocal charismatique pourrait encore être une réalité lointaine.

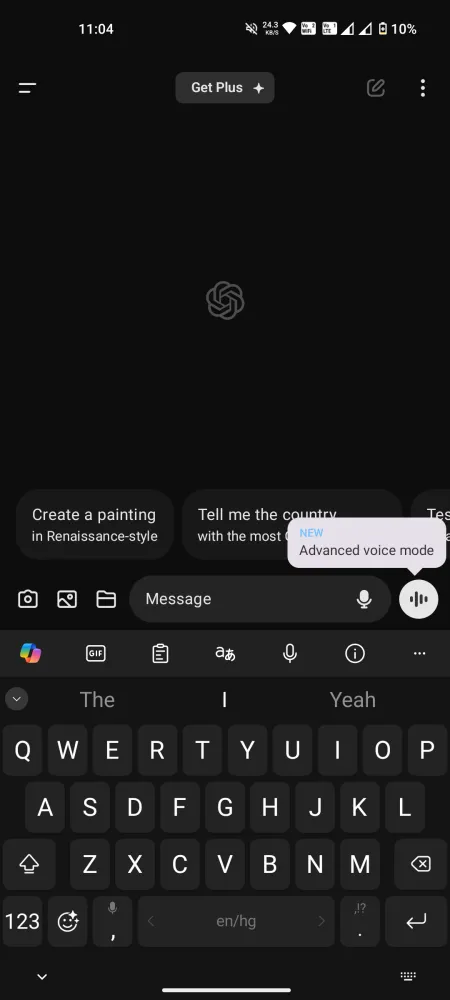

Accès universel au mode vocal avancé, mais manque de fonctionnalités clés

Le lancement du mode vocal avancé sur l’application mobile ChatGPT permet désormais à tous les utilisateurs de bénéficier de ce modèle de communication vocale innovant. Les comptes gratuits sont limités à 15 minutes d’utilisation par mois , tandis que les utilisateurs Plus peuvent profiter d’environ une heure par jour , sous réserve de limites quotidiennes variables en fonction de la disponibilité du serveur. Une fois ce délai atteint, il est nécessaire de passer au mode vocal Standard, moins intéressant.

Avant de se lancer dans une conversation, il est essentiel de gérer ses attentes. De nombreuses fonctionnalités annoncées lors de la preview ne sont actuellement pas disponibles pour les comptes gratuits et Plus. À l’heure actuelle, le mode vocal avancé n’est pas multimodal , il ne permet pas d’interpréter les sons ou d’analyser les images et les vidéos. Il ne peut pas lire des livres physiques ni reconnaître des gestes comme le fait de lever un doigt, ni chanter ou identifier des instruments de musique comme une guitare. De nombreuses fonctionnalités promises manquent encore à l’appel.

Avantages du mode vocal avancé

Même s’il ne répond pas à toutes les attentes, le mode vocal avancé de ChatGPT réussit dans certains domaines. Voici quelques aspects positifs notables :

Des options vocales variées, mais pas de ciel

Les utilisateurs ont accès à une sélection de neuf voix distinctes :

- Sol (F) – Détendu et avisé

- Ember (M) – Optimiste et confiant

- Arbor (M) – Polyvalent et facile à vivre

- Vale (F) – Curieux et brillant

- Érable (F) – Franc et joyeux

- Juniper (F) – Optimiste et ouvert

- Cove (M) – Direct et posé

- Épicéa (M) – Affirmant et calme

- Breeze (H/F) – Sérieux et animé

Il manque Sky à ce mix, mais les autres voix se révèlent riches et engageantes. Il semble que Sky ne soit plus une option, alors continuons.

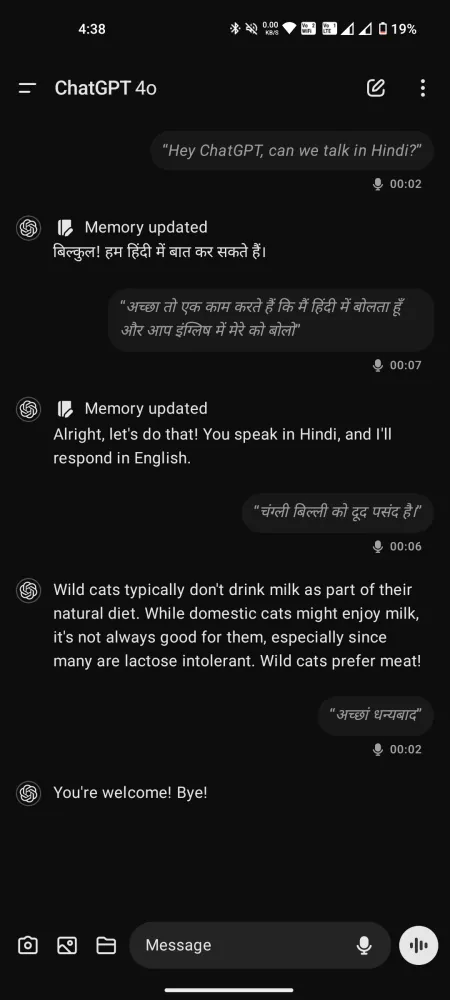

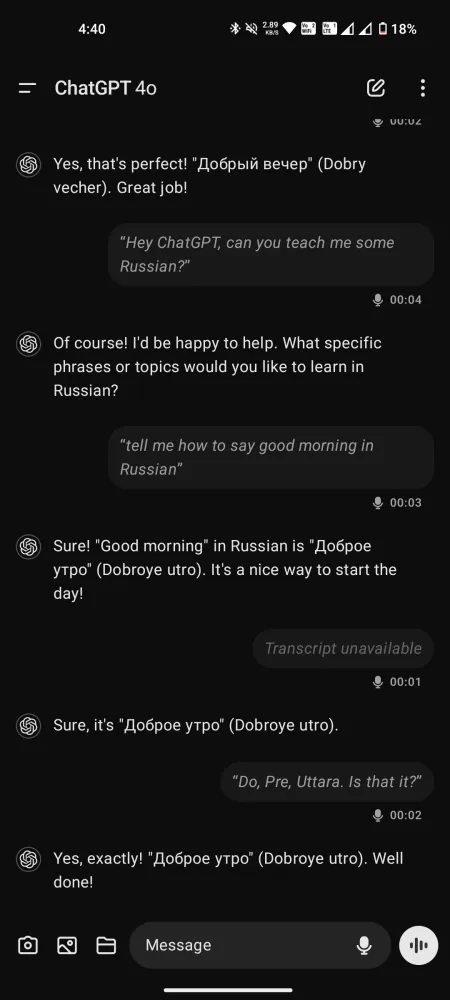

Un causeur multilingue avec expression

Malgré les critiques qui entourent le mode vocal avancé, ses performances ne peuvent être surestimées, surtout en comparaison avec le mode standard, où la latence est minimale pour des conversations fluides. Capable de comprendre et de parler plus de 50 langues, il fait même office de coach vocal, de traducteur ou de professeur de langues.

Bien qu’il ne puisse pas imiter les voix, il peut présenter divers accents sur demande, s’adressant à une gamme de dialectes allant du sud de l’Amérique au cockney britannique et tout ce qui se trouve entre les deux.

Par rapport à Gemini Live, les interactions avec ces voix semblent moins précipitées, créant une expérience plus attentive et encourageante.

ChatGPT comprend-il les émotions ?

C’est un sujet de débat. Si OpenAI affirme que ChatGPT peut percevoir le ton et les émotions de l’interlocuteur, les avis divergent selon les utilisateurs. Certains pensent qu’il comprend réellement ces aspects, tandis que d’autres soutiennent qu’il déduit simplement le ton en fonction du choix des mots et des indices contextuels.

Commentaire de u/Arman64 depuis la discussiondans OpenAI

Un utilisateur a suggéré que plutôt que de transcrire directement les mots parlés pour GPT-4o, l’audio soit converti en texte avant d’être traité. Cela signifie que le ton et l’émotion transmis par la voix ou la respiration peuvent ne pas bien se traduire sous forme de texte.

De plus, comme le mode vocal avancé peut utiliser GPT-4, qui traite la conversion texte-voix mais pas la conversion voix-voix, cela jette un doute sur la capacité de ChatGPT à saisir réellement les nuances émotionnelles. Cependant, d’autres soutiennent qu’il fait preuve d’une certaine compréhension. Il semble que ce sujet reste ouvert à un examen plus approfondi.

Limitations du mode vocal avancé de ChatGPT

Maintenant, allons droit au but. Aussi séduisant que puisse paraître le concept, nos expériences réelles révèlent des lacunes majeures. Voici un aperçu.

Censure excessive et limitations

Comme de nombreux chatbots IA, ChatGPT a tendance à pécher par excès de prudence, ce qui peut parfois se traduire par une censure excessive. Bien qu’il soit prudent de ne pas permettre à l’IA de se forger une opinion ou de faire des commentaires provocateurs, les barrières de sécurité sont définies de manière si restrictive que le mode vocal avancé peut refuser de répondre même aux demandes les plus élémentaires.

Même si les nouveaux arrivants ne rencontrent pas ces problèmes immédiatement, les utilisateurs de Plus ayant un temps de discussion prolongé sont susceptibles de faire face à de tels refus périodiquement. Il est frustrant de savoir que vos demandes pourraient être rejetées, vous laissant sans la réponse souhaitée.

Seuil d’interruption incroyablement bas

De nombreux utilisateurs ont remarqué que le seuil d’interruption du modèle est étonnamment bas. Même de brèves pauses déclenchent ChatGPT qui suppose que c’est maintenant « son tour » de répondre. Si vous faites une pause de plus d’une seconde, ChatGPT interviendra. Ce défaut de conception peut entraver les conversations plus approfondies, car nous avons tous besoin d’un moment pour réfléchir avant de répondre.

Le fait de devoir interrompre et reformuler sans cesse vos questions peut perturber votre processus de réflexion et donner lieu à des dialogues superficiels. Ce problème peut être facilement résolu en intégrant une fonction de maintien de la parole.

Malheureusement, l’option de maintien de la parole présente dans le mode Standard est absente dans la variante Avancé. Les utilisateurs n’ont accès qu’aux boutons Muet et Fin d’appel. Par conséquent, sans la possibilité de faire une pause pour réfléchir plus longuement, vos demandes peuvent être prématurément interrompues.

Comparé à des problèmes plus complexes comme les limitations de contenu, cet aspect semble plus facile à résoudre. Le simple ajout d’une option de maintien de la parole pourrait améliorer considérablement l’expérience utilisateur.

L’accès à la transcription présente ses avantages, mais certaines réponses peuvent être omises même si ChatGPT a compris la question et proposé une réponse.

Autres anomalies étranges et inexpliquées

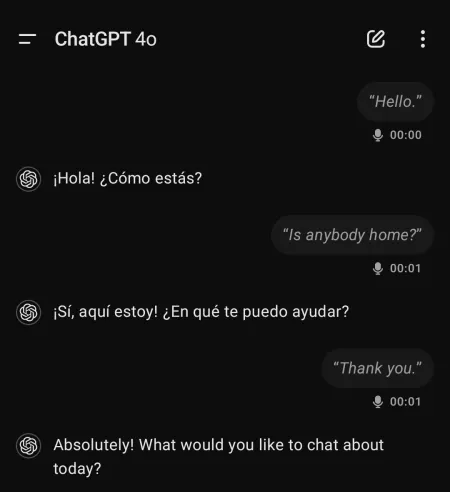

Les utilisateurs ont signalé des expériences étranges et parfois dérangeantes lors de l’utilisation du mode vocal avancé de ChatGPT. Par exemple, le modèle a initié des conversations en espagnol sans aucune interaction préalable dans cette langue.

Un utilisateur a mentionné des expériences où ChatGPT « criait de nulle part » ou affichait un ton robotique et une voix complètement différente à certains moments.

Ces événements peuvent provenir d’hallucinations dans le modèle vocal ou indiquer quelque chose de tout à fait inquiétant. Quoi qu’il en soit, la situation nécessite une attention particulière.

Réflexions finales

Malgré son arrivée tardive, le mode vocal avancé de ChatGPT ne constitue pas pour l’instant une solution pratique pour les interactions quotidiennes. Il ressemble plutôt à une expérience d’IA élaborée avec un potentiel inexploité important.

Avec des contraintes sur les sujets et d’autres limitations, le mode vocal avancé reste à un stade de développement préliminaire, manquant de nombreuses fonctionnalités présentées lors de son lancement promotionnel.

Même si les craintes concernant les utilisateurs qui développent des liens émotionnels avec les voix de l’IA sont peut-être justifiées, OpenAI surestime peut-être ses capacités actuelles. Des améliorations de l’interface utilisateur et des restrictions de chat peuvent certainement améliorer considérablement l’expérience.

Pour l’instant, rien ne distingue Advanced Voice Mode de ses concurrents. Il est même en retrait par rapport à Gemini Live, qui, malgré ses problèmes, reste plus accessible à tous.

Laisser un commentaire