AV-Comparatives : Microsoft Defender améliore considérablement la détection de virus hors ligne sur Windows

La semaine dernière, AV-TEST a publié son rapport d’évaluation anti-malware pour le mois de janvier-février. Le test a révélé que Microsoft Defender s’en sortait plutôt bien en termes de détection de fichiers malveillants (y compris les faux positifs), bien qu’il ait obtenu des résultats assez médiocres dans le département d’impact sur les performances, obtenant le score le plus bas de tous .

AV-Comparatives, qui est une autre grande société de test antivirus, a également publié récemment son test de protection dans le monde réel et son test de protection contre les logiciels malveillants. Nous avons couvert le premier hier. Au cas où vous l’auriez manqué, Microsoft s’en est très bien sorti car il était l’un des plus performants aux côtés de Kaspersky, Bitdefender et Total Defense .

Aujourd’hui, nous examinons le test de protection contre les logiciels malveillants. La différence entre les deux ensembles de tests est que la protection contre les logiciels malveillants traite des logiciels malveillants exécutés sur le système lui-même, tandis que la protection du monde réel concerne les menaces Web.

La procédure de test a été expliquée par AV-Comparatives :

Le test de protection contre les logiciels malveillants évalue la capacité d’un programme de sécurité à protéger un système contre l’infection par des fichiers malveillants avant, pendant ou après l’exécution. La méthodologie utilisée pour chaque produit testé est la suivante.

Avant l’exécution, tous les échantillons de test sont soumis à des analyses à l’accès et à la demande par le programme de sécurité, chacune d’entre elles étant effectuée à la fois hors ligne et en ligne. Tous les échantillons qui n’ont pas été détectés par l’une de ces analyses sont ensuite exécutés sur le système de test, avec un accès Internet/cloud disponible, pour permettre, par exemple, aux fonctionnalités de détection comportementale d’entrer en jeu. Si un produit n’empêche pas ou n’inverse pas toutes les modifications apportées par un échantillon de logiciel malveillant particulier dans un délai donné, ce cas de test est considéré comme un échec. Si l’utilisateur est invité à décider si un échantillon de logiciel malveillant doit être autorisé à s’exécuter, et dans le cas de la pire décision de l’utilisateur, des modifications du système sont observées, le cas de test est classé comme « dépendant de l’utilisateur ».

Comme dans le cas du test de protection dans le monde réel, Microsoft Defender s’est plutôt bien comporté dans les catégories de détection et de protection en ligne. Cependant, son taux de détection hors ligne, qui est de 83 %, est toujours en retard sur plusieurs autres concurrents, même s’il n’est pas le pire car il a battu d’autres comme Trend Micro et Panda. La chose à célébrer cependant est l’amélioration continue dont Defender a fait preuve au fil des mois. L’année dernière, Microsoft n’était qu’à 60,3 % , et il s’est amélioré à 69,8 % six mois plus tard .

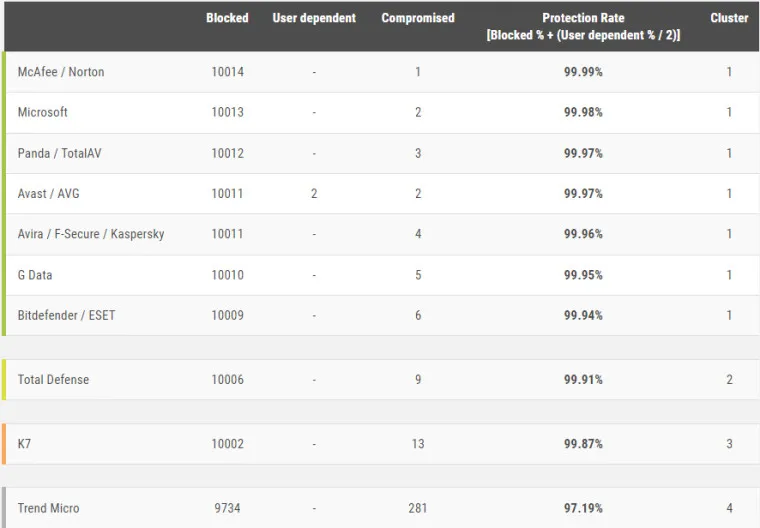

L’image ci-dessous décompose davantage les taux de protection en ligne et montre le nombre de cas compromis. Microsoft a subi deux pertes, seulement derrière McAfee et Norton, qui n’avaient qu’un seul cas compromis. Pendant ce temps, Trend Micro était le pire avec 281, ce qui est relativement épouvantable.

Le tableau ci-dessous résume les résultats des tests en un :

Vous pouvez trouver les données de test complètes sur le site Web d’AV-Comparatives .

Laisser un commentaire