Guide étape par étape pour installer LLaMA 3 sur un PC Windows 11

Llama 3 représente la dernière avancée de Meta en matière de modèles de langage volumineux, idéal pour une large gamme d’applications, notamment pour répondre à des questions, aider aux devoirs universitaires et bien plus encore. En installant Llama 3 sur votre appareil Windows 11, vous pouvez y accéder à tout moment, même sans connexion Internet. Ce guide vous montrera comment configurer Llama 3 sur votre ordinateur Windows 11 .

Installation de Llama 3 sur un ordinateur Windows 11

Le processus d’installation de Llama 3 sur votre appareil Windows 11 à l’aide de Python nécessite un certain niveau de compétence technique. Néanmoins, il existe des méthodes alternatives qui simplifient le déploiement local de Llama 3. Je vais décrire ces techniques.

Pour installer Llama 3, vous devrez exécuter des commandes spécifiques dans l’invite de commande. Notez que cela n’accordera l’accès qu’à la version en ligne de commande ; des étapes supplémentaires sont nécessaires pour utiliser son interface Web. Les deux processus seront abordés ici.

Configuration de Llama 3 sur Windows 11 via CMD

Tout d’abord, vous devez installer Ollama sur votre ordinateur Windows pour déployer Llama 3. Suivez ces étapes :

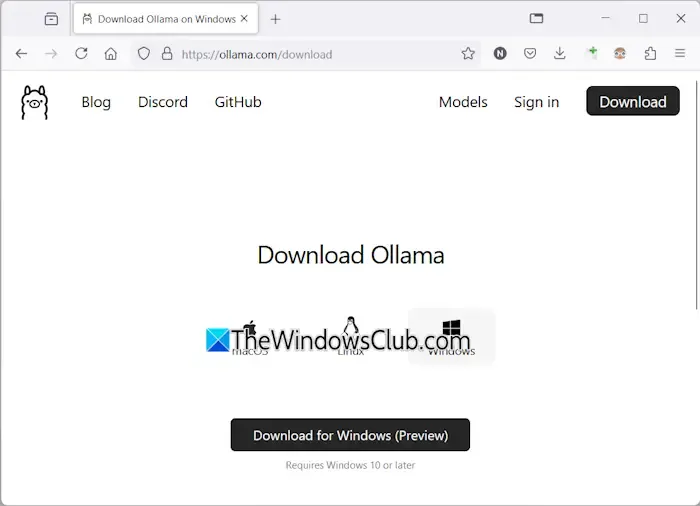

- Accédez au site officiel d’Ollama .

- Sélectionnez l’ option Télécharger , puis choisissez Windows .

- Cliquez sur Télécharger pour Windows pour enregistrer le fichier exécutable sur votre ordinateur.

- Exécutez le fichier exe téléchargé pour installer Ollama sur votre appareil.

Une fois Ollama correctement installé, redémarrez votre ordinateur. Il devrait s’exécuter en arrière-plan, visible dans la barre d’état système. Ensuite, visitez la section Modèles sur le site Web d’Ollama pour voir les modèles disponibles.

Le modèle Llama 3.1 est proposé en trois configurations :

- 8B

- 70B

- 405B

La configuration 405B est la plus exigeante et peut ne pas fonctionner sur une machine bas de gamme. Llama 3.2 propose deux options :

- 1B

- 3B

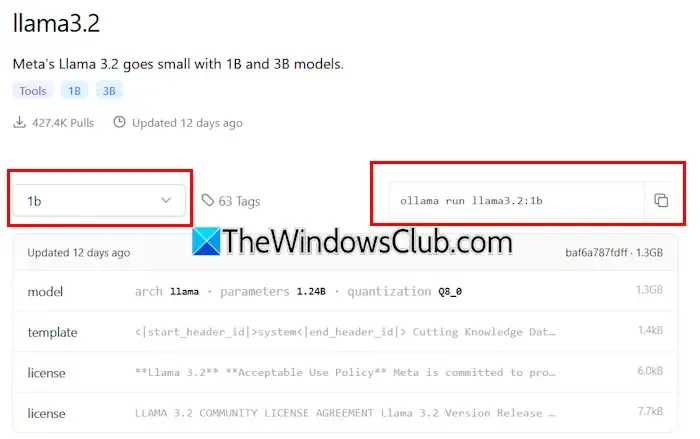

Choisissez une version de Llama pour l’installation. Si vous optez pour Llama 3.2, cliquez dessus. Dans le menu déroulant qui s’affiche, sélectionnez la configuration souhaitée. Ensuite, copiez la commande affichée à côté et collez-la dans l’invite de commande.

Voici les commandes pour le modèle Llama 3.2 :

ollama run llama3.2:3b

Pour installer la configuration Llama 3.2 1B, entrez :

ollama run llama3.2:1b

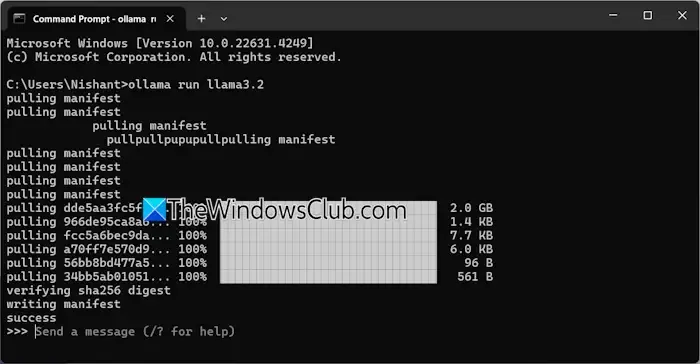

Ouvrez l’invite de commande, saisissez l’une des commandes ci-dessus en fonction de vos besoins et appuyez sur Entrée . Le processus de téléchargement prendra un certain temps, en fonction de votre connexion Internet. Une fois l’opération terminée, un message de réussite apparaîtra dans l’invite de commande.

Vous pouvez ensuite saisir votre entrée pour interagir avec le modèle Llama 3.2. Pour installer le modèle Llama 3.1, utilisez les commandes disponibles sur le site Web d’Ollama.

La prochaine fois que vous ouvrirez l’invite de commande, vous pourrez utiliser la même commande pour exécuter Llama 3.1 ou 3.2.

L’une des limitations de l’installation de Llama 3 via CMD est l’absence d’historique de discussion enregistré. Cependant, le déploiement via un hôte local permet de sauvegarder votre historique de discussion, en plus de fournir une interface utilisateur améliorée. La section suivante explique comment y parvenir.

Déploiement de Llama 3 avec une interface utilisateur Web sur Windows 11

L’utilisation de Llama 3 via un navigateur Web améliore non seulement l’expérience utilisateur, mais préserve également l’historique des conversations, une fonctionnalité absente lors de l’utilisation de CMD. Voici comment exécuter Llama 3 dans votre navigateur Web.

Pour accéder à Llama 3 via un navigateur Web, assurez-vous que Llama 3 via Ollama et Docker sont tous deux installés sur votre système. Si vous n’avez pas installé Llama 3, procédez à l’installation d’Ollama comme indiqué précédemment. Ensuite, téléchargez et installez Docker depuis son site Web officiel .

Après avoir installé Docker, ouvrez-le et terminez le processus d’inscription pour créer un compte, car Docker ne démarrera pas sans lui. Une fois connecté, réduisez Docker dans la barre d’état système ; assurez-vous que Docker et Ollama sont tous deux actifs en arrière-plan pour utiliser Llama 3 via votre navigateur Web.

Ouvrez l’invite de commande, copiez la commande suivante et collez-la :

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

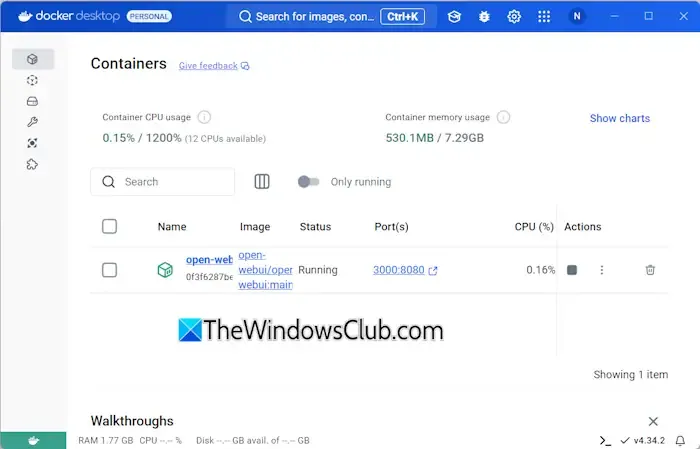

Cette commande prendra un certain temps pour télécharger les fichiers nécessaires, alors soyez patient. Une fois l’opération terminée, ouvrez Docker et accédez à la section Conteneurs sur le côté gauche. Vous devriez voir un conteneur créé automatiquement pour le port 3000:8080.

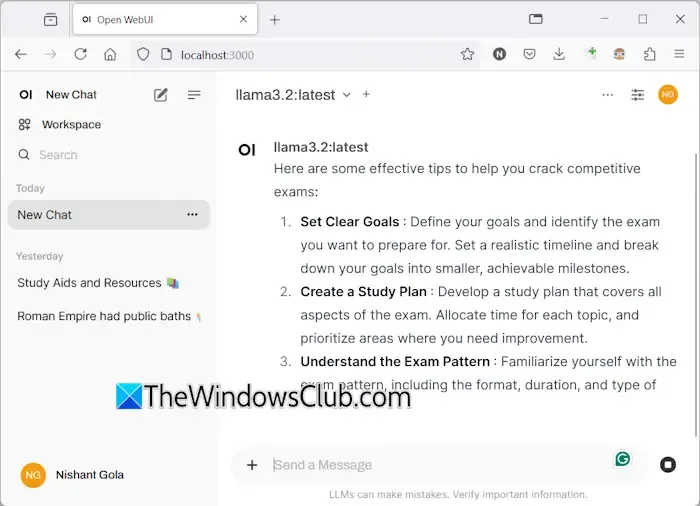

Cliquez sur le port 3000:8080, ce qui ouvrira un nouvel onglet dans votre navigateur Web par défaut. Vous devrez peut-être vous inscrire et vous connecter pour utiliser Llama 3 via le navigateur Web. Si vous vérifiez la barre d’adresse, elle affichera localhost:3000, indiquant que Llama 3 est hébergé localement, ce qui permet une utilisation sans accès à Internet.

Sélectionnez votre modèle de chat Llama préféré dans le menu déroulant. Pour intégrer des modèles de chat Llama 3 supplémentaires, installez-les via Ollama en utilisant les commandes correspondantes ; ils seront alors disponibles dans votre navigateur.

Votre historique de discussion sera enregistré et récupérable sur le côté gauche. Lorsque vous avez terminé, déconnectez-vous de votre session dans le navigateur Web, puis ouvrez Docker et appuyez sur le bouton Arrêter pour l’arrêter avant de fermer Docker.

La prochaine fois que vous souhaitez accéder à Llama 3 dans votre navigateur Web, démarrez Ollama et Docker, attendez quelques minutes, puis cliquez sur le port dans le conteneur Docker pour lancer le serveur localhost. Une fois connecté, vous pouvez commencer à utiliser Llama 3.

J’espère que ces informations vous seront utiles.

Llama 3 peut-il fonctionner sous Windows ?

Votre capacité à exécuter Llama 3 sur votre machine dépend de ses spécifications matérielles. La version la plus légère, le modèle 1B, peut être installée et utilisée via l’invite de commande.

Quelle quantité de RAM est requise pour Llama 3 ?

Pour exécuter le modèle Llama 3.2 1B, votre système doit être équipé d’au moins 16 Go de RAM, ainsi que d’un GPU robuste. Les variantes supérieures de Llama 3 exigeront encore plus de ressources de votre système.

Laisser un commentaire