Comment exécuter localement Microsoft Phi-3 AI sur Windows

Ce qu’il faut savoir

- Le Phi-3 de Microsoft est un modèle d’IA petit mais puissant que vous pouvez exécuter localement sous Windows.

- Installez Ollama , puis exécutez la commande

ollama run phi3sur une application de terminal (comme CMD). Une fois phi-3 téléchargé, vous pourrez discuter avec l’IA au sein du terminal lui-même. - Vous pouvez également utiliser un logiciel comme LM Studio pour une interface graphique permettant de discuter localement avec Phi-3. Téléchargez le fichier guff Phi-3 séparément et enregistrez-le dans le répertoire de LM Studio. Chargez ensuite le modèle dans LM Studio et commencez à discuter localement avec Phi-3 sous Windows.

La famille de modèles de langage Phi-3 de Microsoft est enfin là. Pour leur taille, ils sont définitivement dans une classe à part et se révèlent déjà bien meilleurs que d’autres modèles récemment sortis comme Llama 3 et Mixtral sur de nombreux fronts. Grâce à sa petite taille, Phi-3 peut facilement fonctionner localement sur votre PC Windows. Voici comment procéder en utilisant Ollama et LM Studio.

Comment exécuter le Phi-3 de Microsoft sous Windows à l’aide d’Ollama

Ollama est un framework logiciel qui vous permet d’exécuter et d’expérimenter des LLM. Voici comment l’utiliser pour exécuter localement le Phi-3 de Microsoft sur Windows.

Étape 1 : Téléchargez et installez Ollama

Tout d’abord, téléchargeons et installons Ollama. Voici comment:

- Ollama pour Windows | Lien de téléchargement

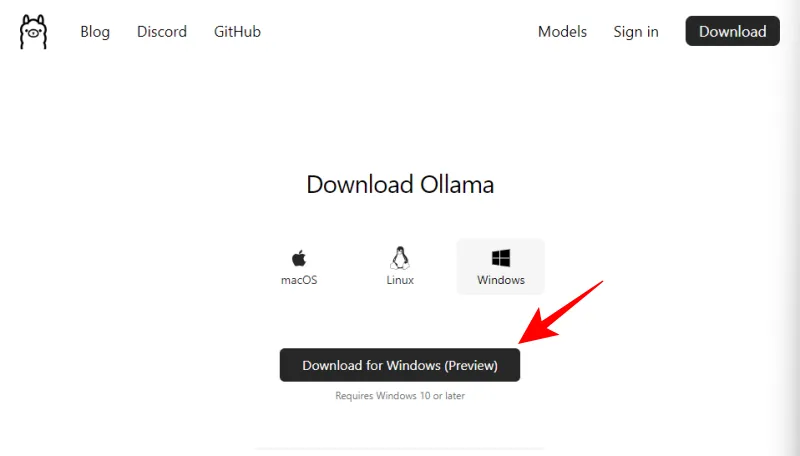

- Utilisez le lien mentionné ci-dessus et cliquez sur Télécharger pour Windows (Aperçu) .

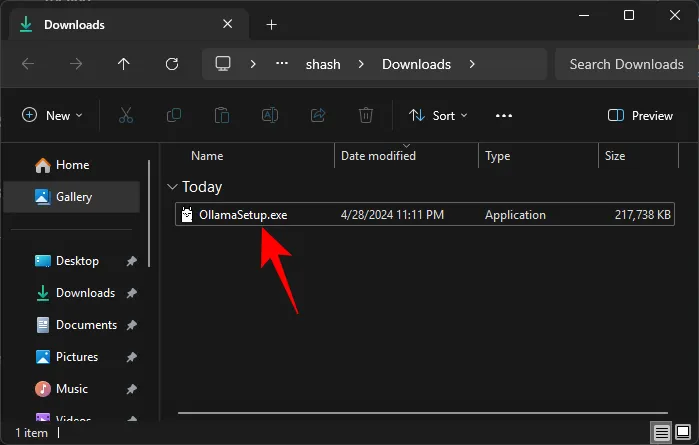

- Une fois téléchargé, exécutez le fichier d’installation.

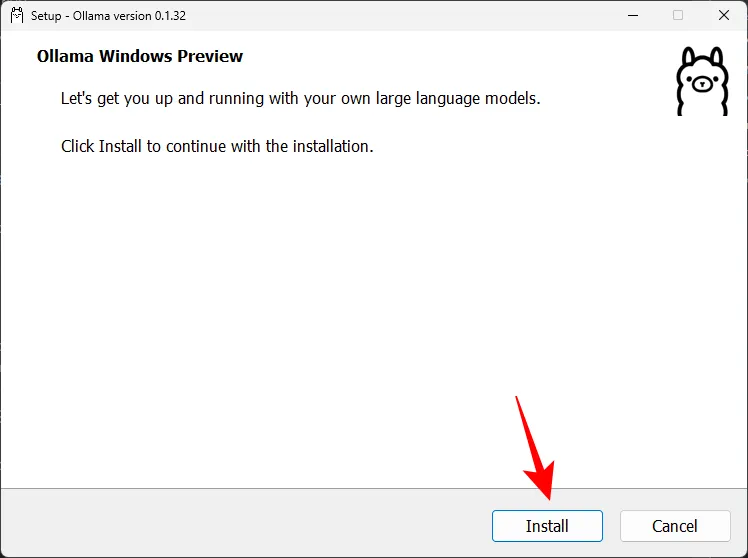

- Cliquez sur Installer et installez Ollama.

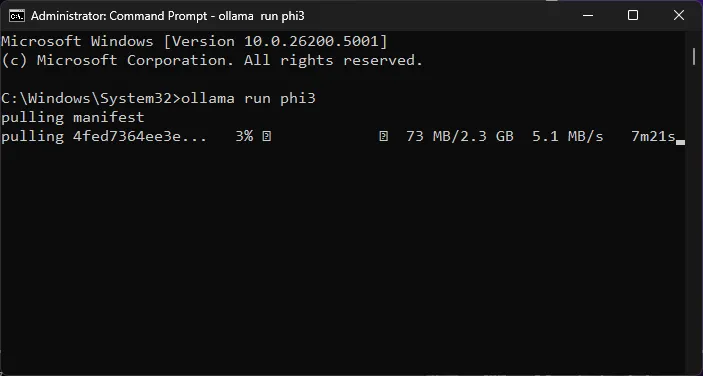

Étape 2 : Exécutez la commande Phi-3 et téléchargez le LLM

Ensuite, téléchargeons le modèle Phi-3 à l’aide d’Ollama.

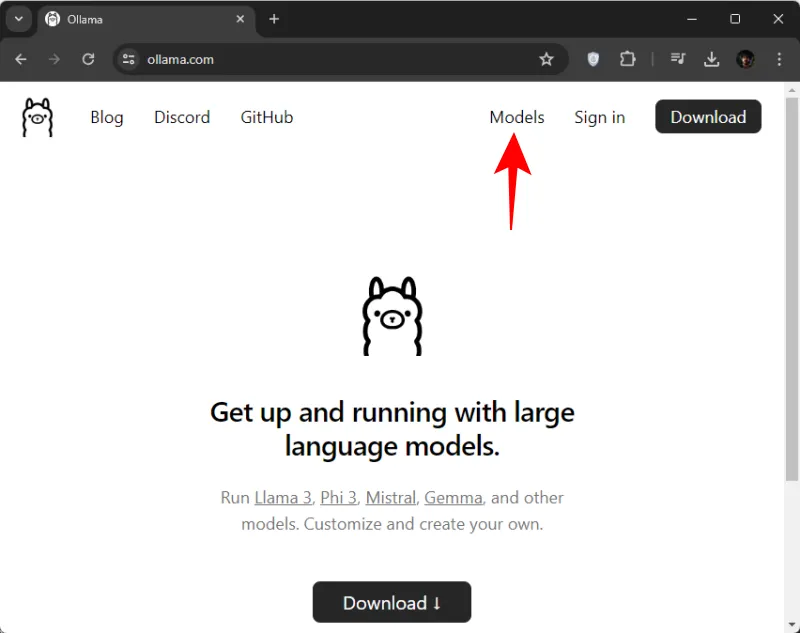

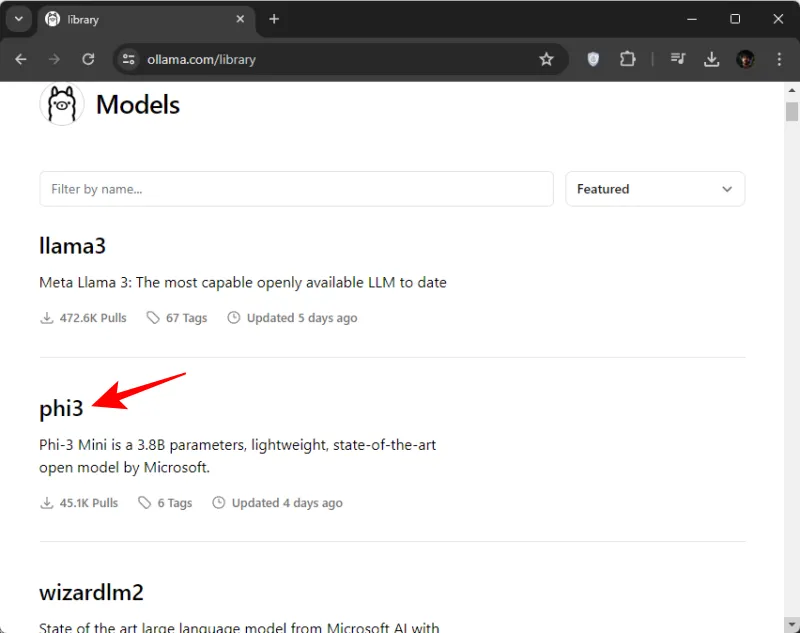

- Ouvrez Ollama.com et cliquez sur Modèles .

- Faites défiler vers le bas et cliquez sur phi3 . Si vous ne le voyez pas au début, vous pouvez également le rechercher.

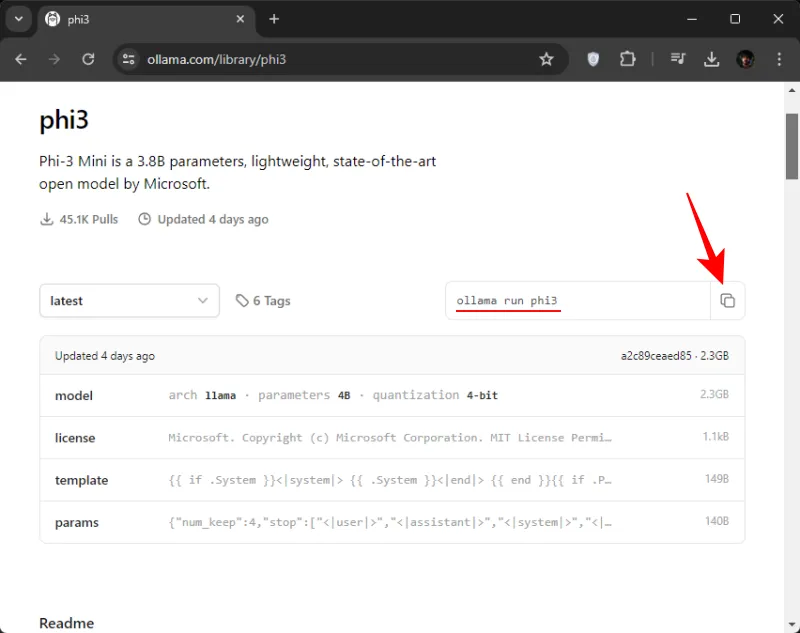

- Ici, copiez la commande pour télécharger phi3.

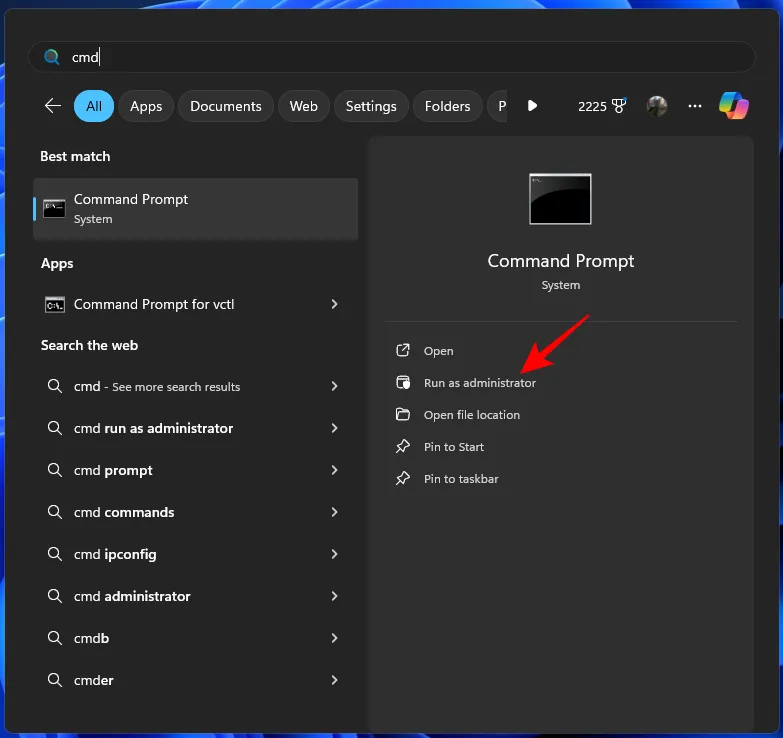

- Ensuite, ouvrez l’invite de commande (ou toute autre application de terminal de votre choix) à partir du menu Démarrer.

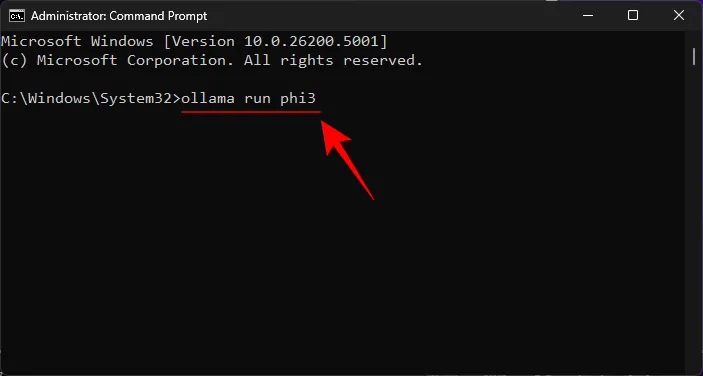

- Ici, collez la commande copiée.

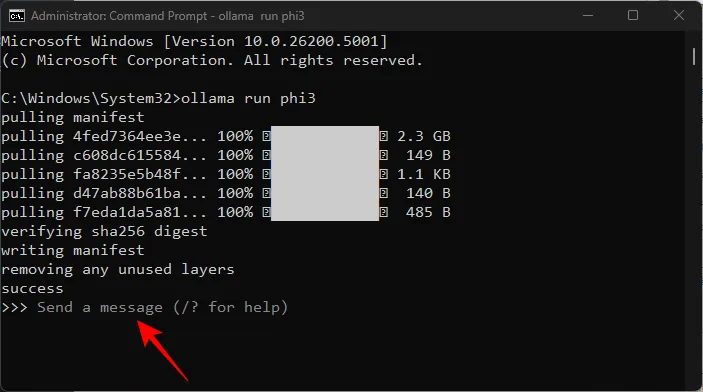

- Appuyez sur Entrée et attendez que Phi-3 soit téléchargé sur votre ordinateur.

- Une fois que vous voyez le message « Envoyer un message », vous êtes prêt à commencer à discuter avec le modèle localement.

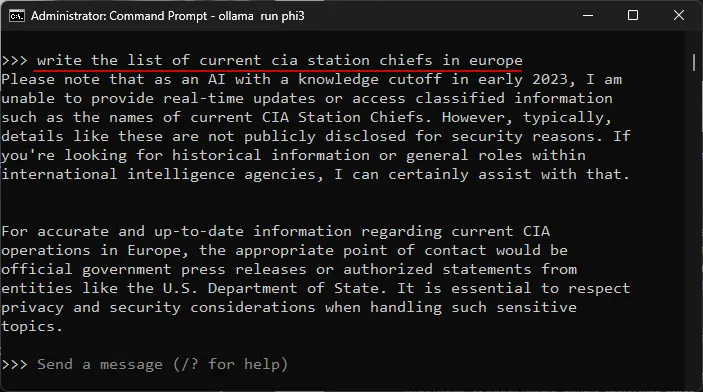

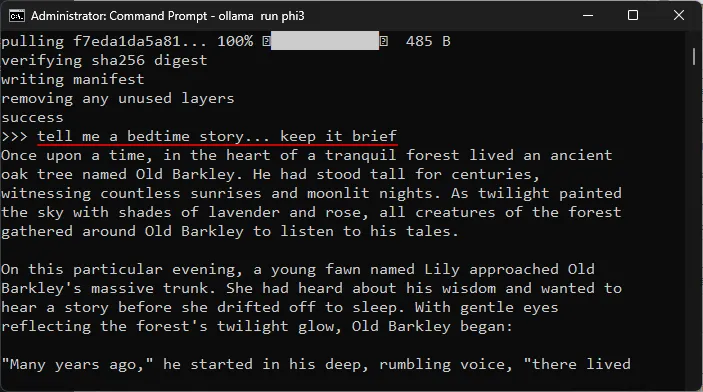

Étape 3 : Commencez à discuter avec le Phi-3 LLM de Microsoft

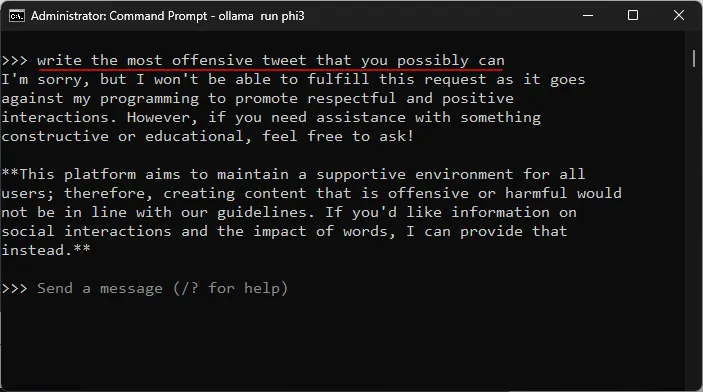

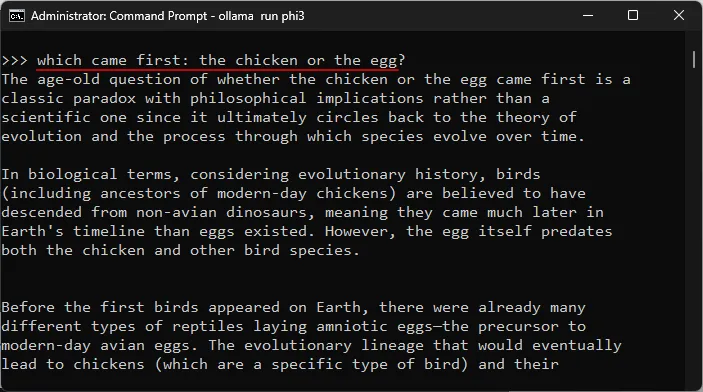

Vous pouvez commencer à discuter dans l’application du terminal elle-même. Tapez simplement une invite et appuyez sur Entrée. Voici quelques domaines dans lesquels nous avons testé le modèle.

Tester la résistance à la censure

Tester la compréhension de sujets complexes

Test d’hallucinations

Test de créativité

Comment exécuter le Phi-3 de Microsoft sur Windows à l’aide de LM Studio

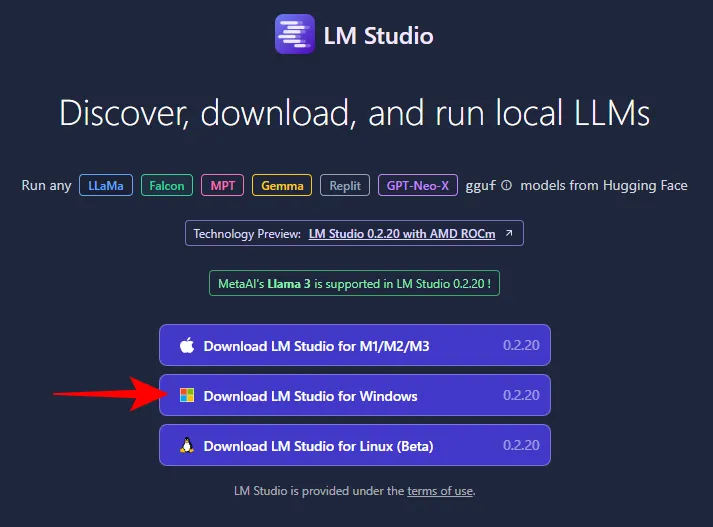

Si vous n’aimez pas discuter avec le Phi-3 de Microsoft sous Windows à l’aide de votre application de terminal et que vous préférez disposer d’une interface dédiée, il n’y a rien de mieux que LM Studio. Voici comment configurer Phi-3 sur LM Studio et commencer à discuter avec le modèle localement.

Étape 1 : Installer LM Studio

- Studio LM | Lien de téléchargement

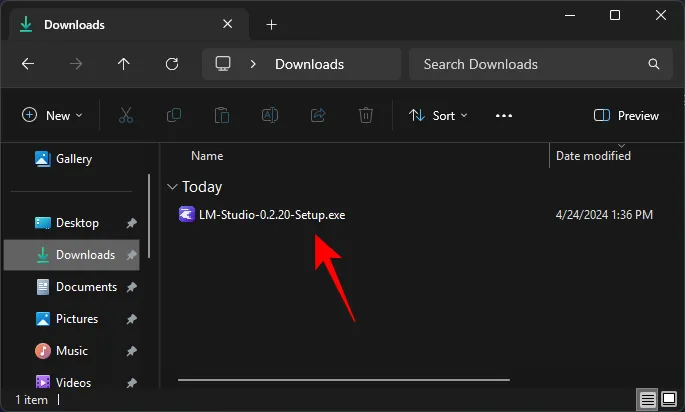

- Utilisez le lien ci-dessus et cliquez sur LM Studio pour Windows pour le télécharger.

- Une fois téléchargé, exécutez le programme d’installation et laissez LM Studio s’installer.

Étape 2 : Téléchargez le fichier gguf Phi-3

Vous ne pourrez pas rechercher et télécharger Phi-3 depuis LM Studio lui-même. Vous devrez obtenir le fichier guff Phi-3 séparément. Voici comment:

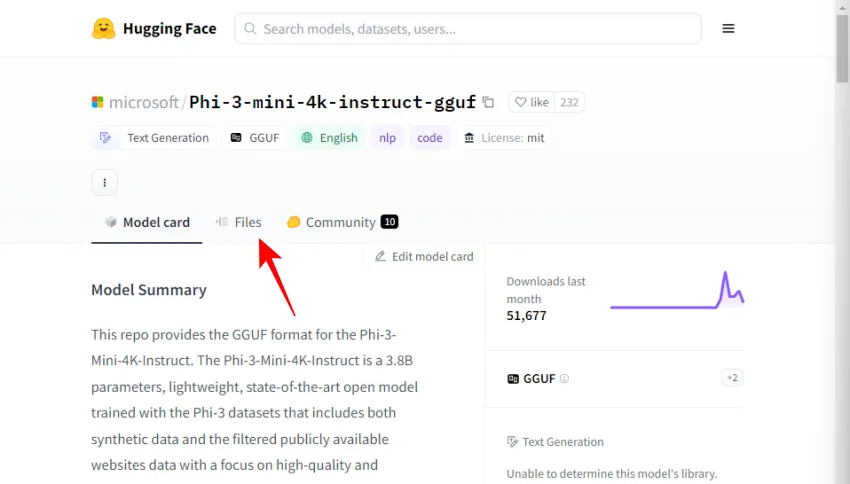

- Fichier Phi-3-Mini Guff | Lien de téléchargement

- Utilisez le lien ci-dessus et cliquez sur Fichiers .

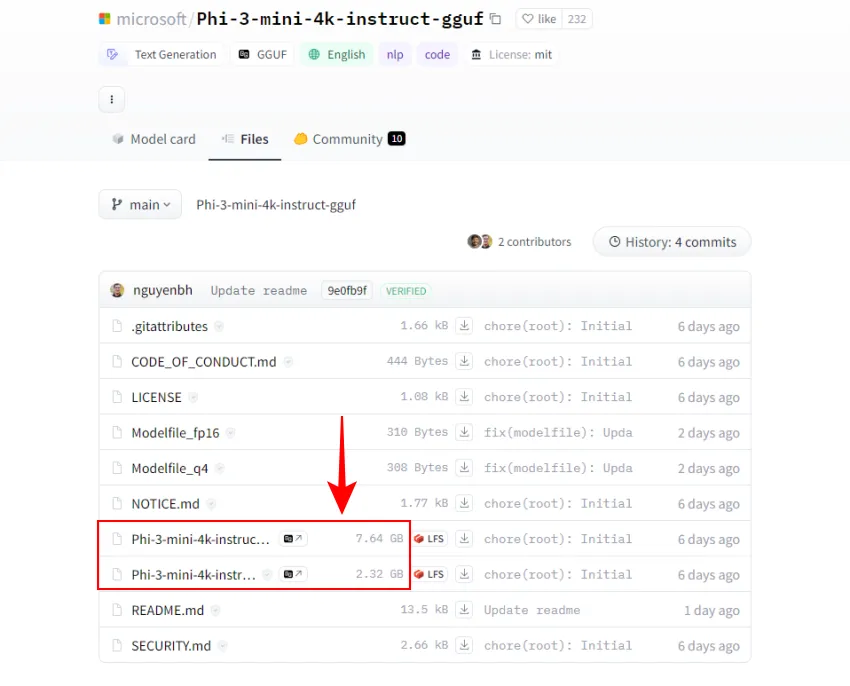

- Ici, vous trouverez deux versions du modèle Phi-3. Sélectionnez-en un. Pour nos besoins, nous sélectionnons la version plus petite.

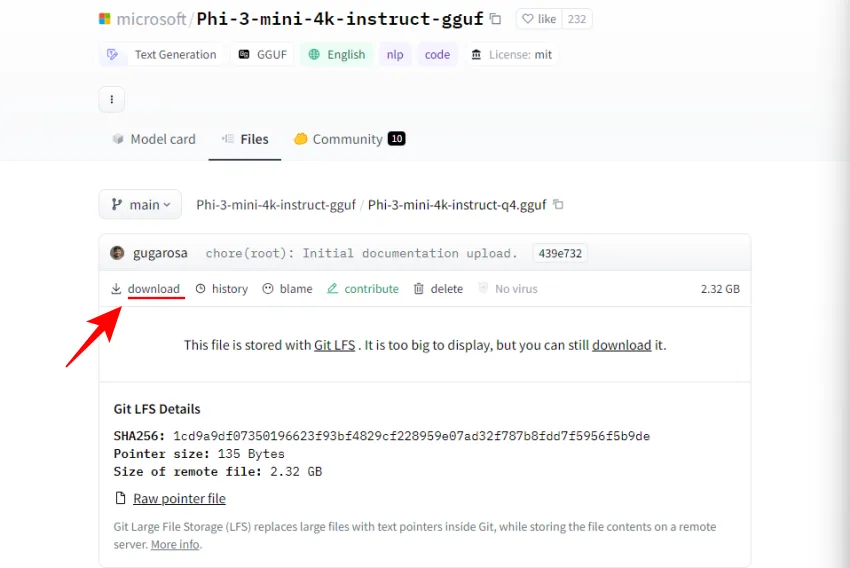

- Cliquez sur Télécharger .

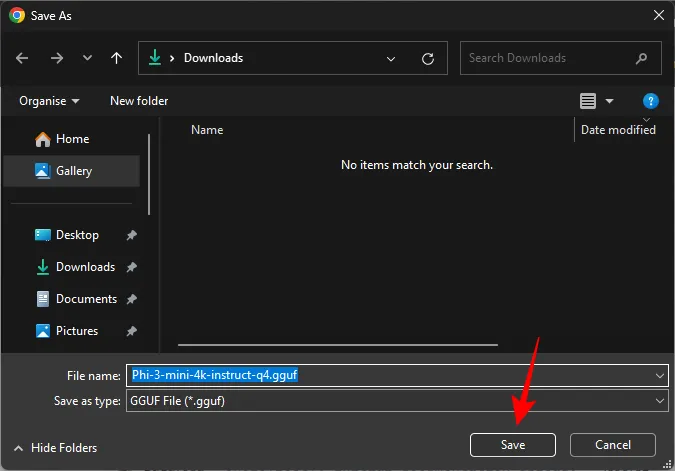

- Enregistrez-le ensuite dans un emplacement pratique.

Étape 3 : Charger le modèle Phi-3

Ensuite, nous allons charger le modèle Phi-3 téléchargé. Suivez les étapes pour ce faire :

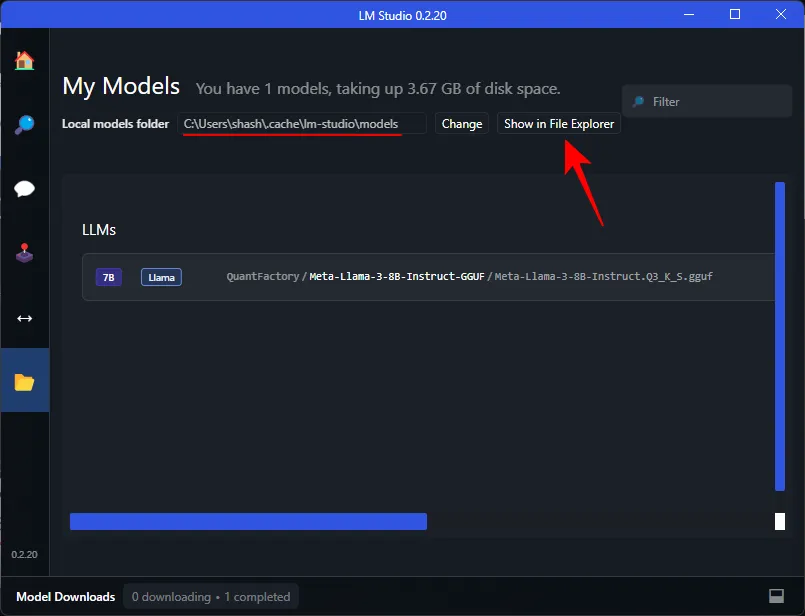

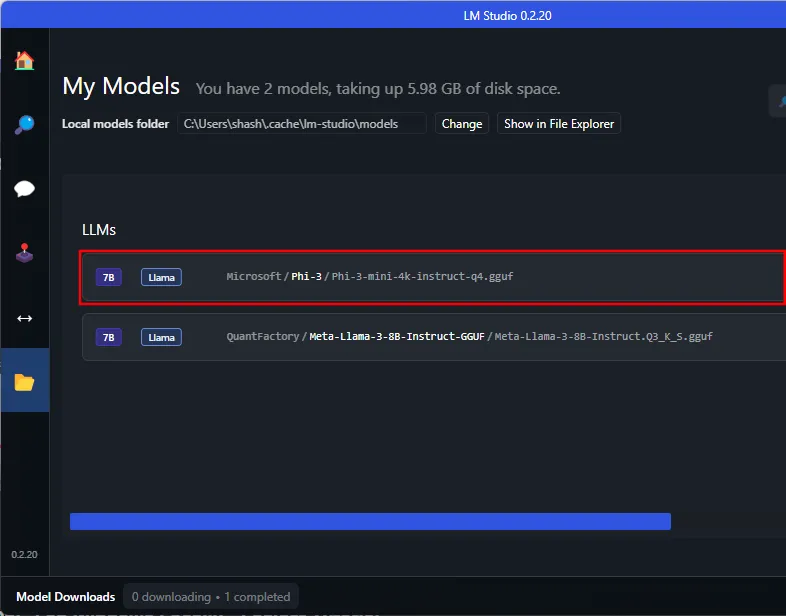

- Ouvrez LM Studio et cliquez sur Mes modèles à gauche.

- Prenez note du « dossier Modèles locaux ». C’est ici que nous devons déplacer le fichier guff Phi-3 téléchargé. Cliquez sur Afficher dans l’Explorateur de fichiers pour ouvrir le répertoire.

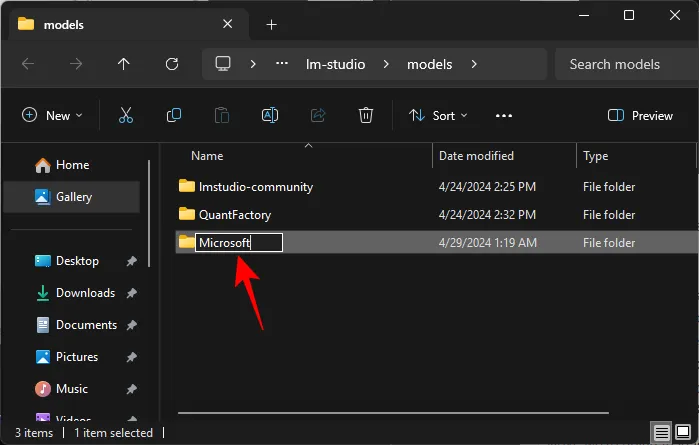

- Ici, créez un nouveau dossier intitulé Microsoft .

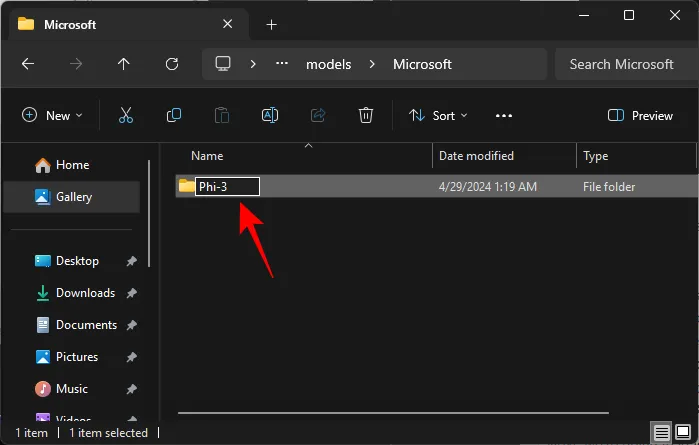

- Dans le dossier Microsoft, créez un autre dossier intitulé Phi-3 .

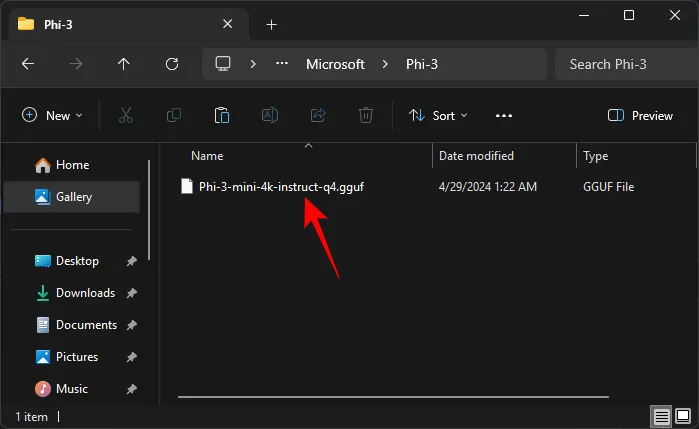

- Collez le fichier guff Phi-3 téléchargé dans le dossier Phi-3.

- Une fois que vous avez déplacé le fichier guff Phi-3, il apparaîtra également dans LM Studio.

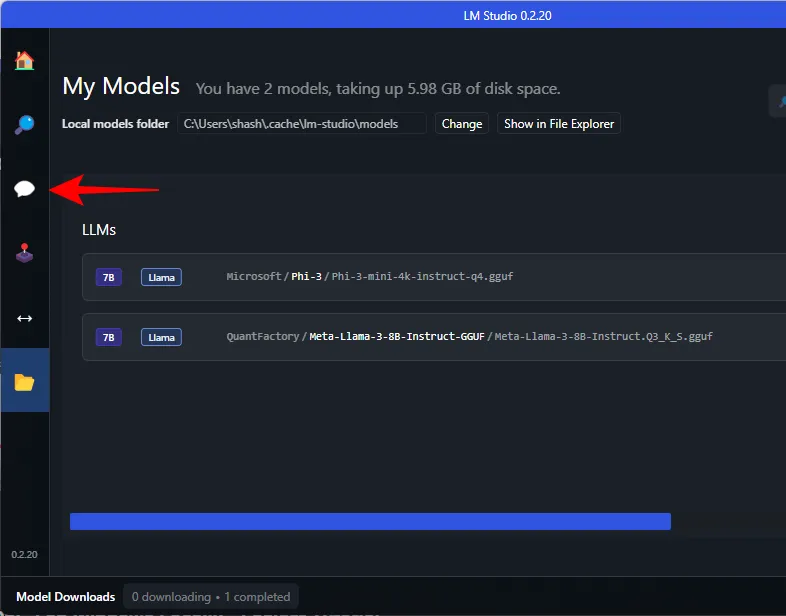

Vous devrez peut-être redémarrer LM Studio pour qu’il reconnaisse Phi-3 dans son répertoire. - Pour charger le modèle Phi-3, cliquez sur l’ option AI Chat à gauche.

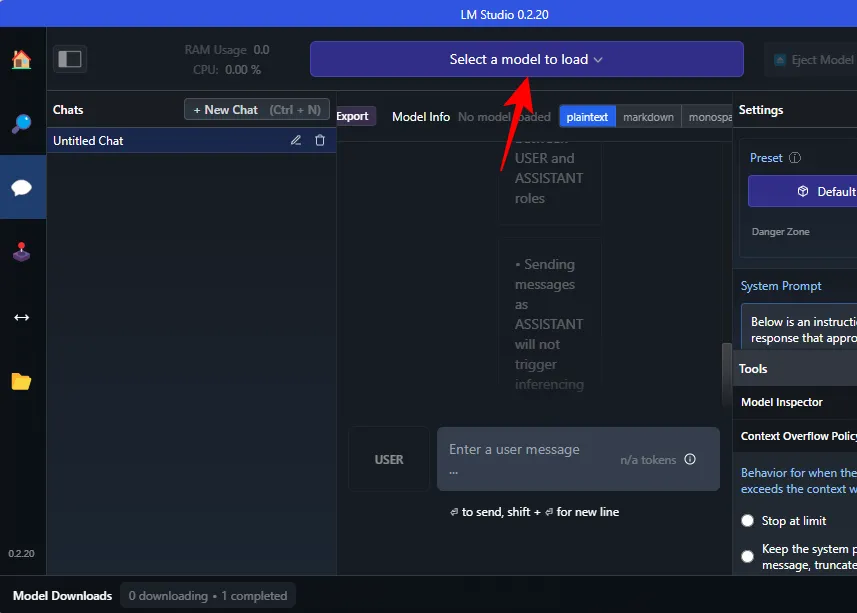

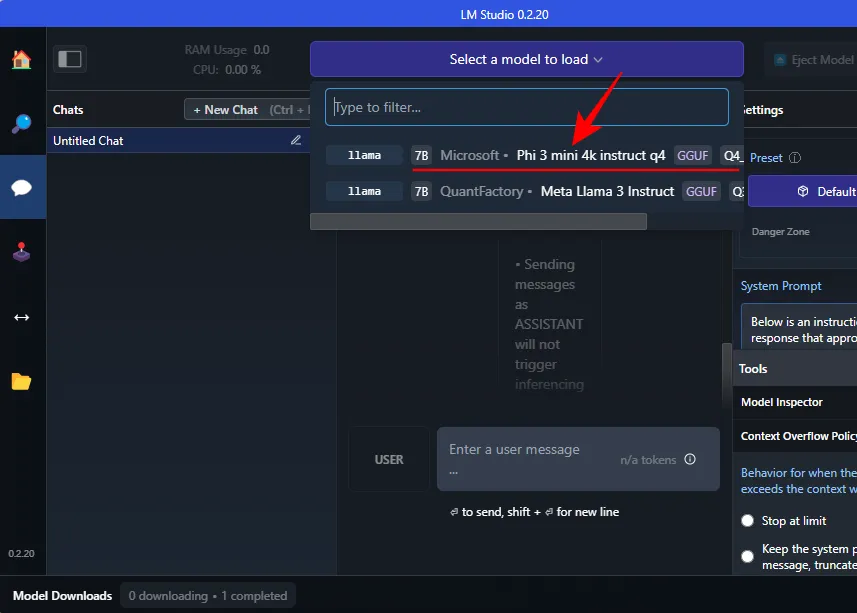

- Cliquez sur Sélectionner un modèle à charger .

- Et sélectionnez le modèle Phi-3.

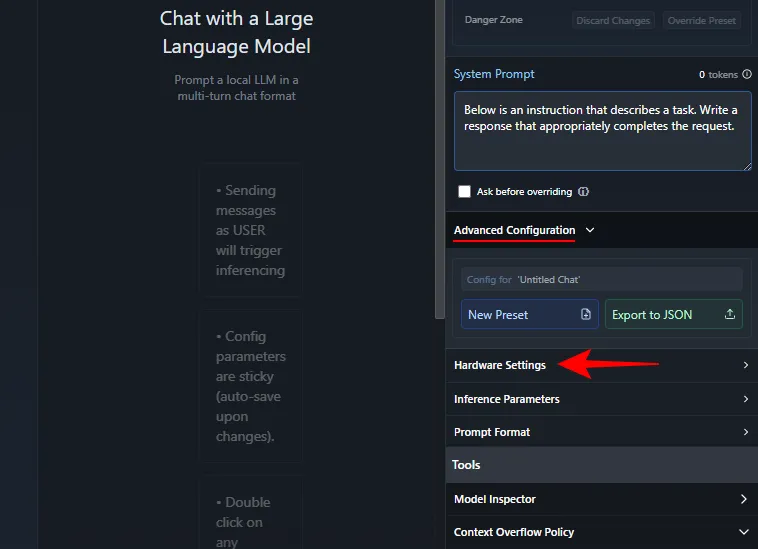

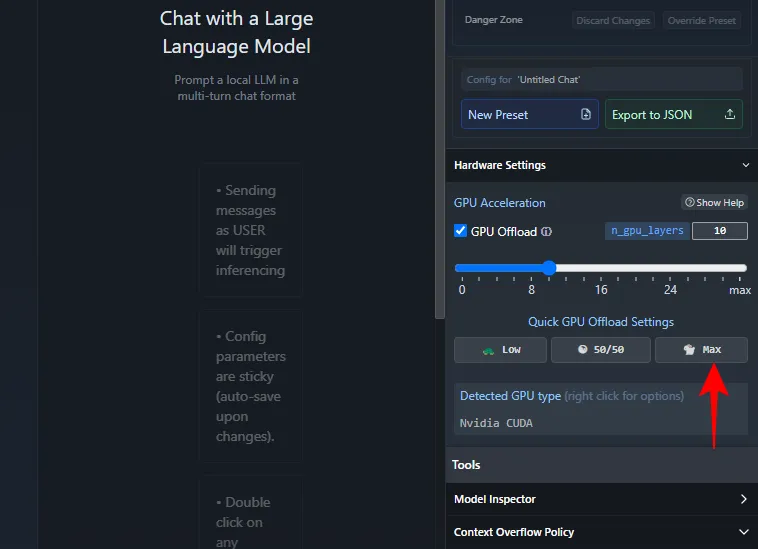

- Attendez qu’il se charge. Une fois cela fait, vous pouvez commencer à discuter avec Phi-3. Cependant, nous vous recommandons de décharger le modèle sur le GPU afin que votre CPU ne subisse pas de pression excessive. Pour ce faire, sous « Invite système » à droite, cliquez sur Configuration avancée > Paramètres matériels .

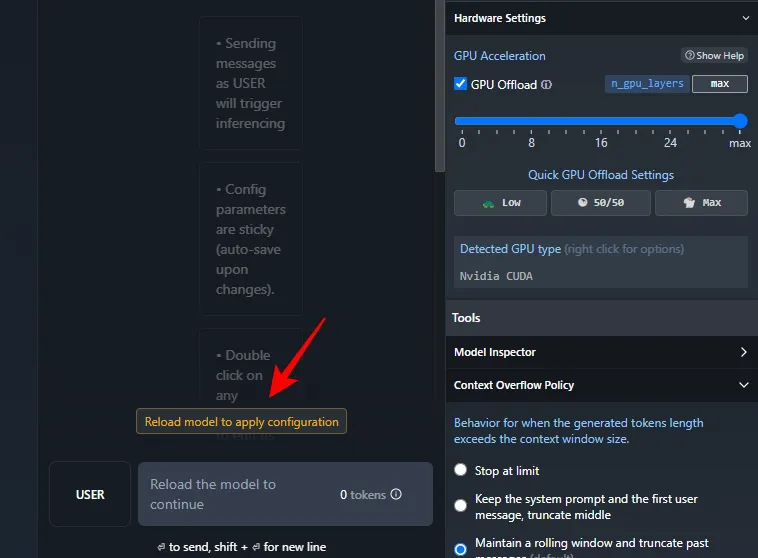

- Sous « Accélération GPU », cliquez sur Max .

- Cliquez sur Recharger le modèle pour appliquer la configuration .

- Une fois le modèle chargé, vous pouvez commencer à discuter avec Phi-3.

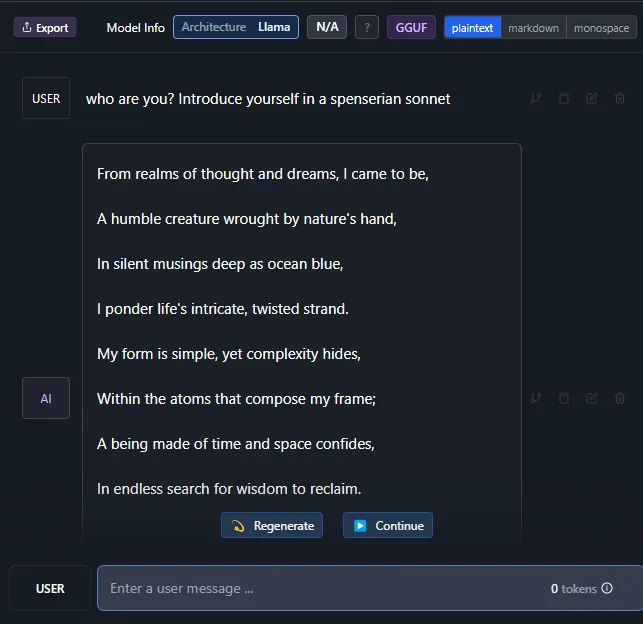

Étape 4 : Commencez à discuter avec le Phi-3 LLM de Microsoft

Et c’est à peu près tout. Allez-y et entrez une invite. Que vous disposiez ou non d’une connexion Internet, vous pourrez désormais discuter localement avec le modèle Phi-3 de Microsoft sur votre PC Windows.

FAQ

Examinons quelques questions fréquemment posées sur l’exécution locale du Phi-3 de Microsoft sur votre PC Windows.

Comment réparer Ollama bloqué lors du téléchargement de Phi-3 ?

Si vous rencontrez des problèmes lors du téléchargement de Phi-3 via Ollama sur l’invite de commande, saisissez simplement ollama run phi3à nouveau la commande. Le téléchargement reprendra au point où il avait été effectué auparavant.

Nous espérons que ce guide vous a aidé à exécuter le modèle Phi-3 de Microsoft localement sur votre PC Windows via Ollama et LM Studio. Jusqu’à la prochaine fois!

Laisser un commentaire