Las mejores alternativas de código abierto a Crawl4AI: comparación de las mejores opciones

Crawl4AI funciona como una herramienta complementaria para el rastreo web y la extracción de datos, especialmente para satisfacer los requisitos de los grandes modelos de lenguaje (LLM) y numerosas aplicaciones basadas en IA. Sin embargo, no es el único contendiente en este espacio. En este artículo, exploraremos las principales alternativas de código abierto a Crawl4AI .

Principales alternativas de código abierto a Crawl4AI

A continuación se muestran algunas alternativas notables de código abierto a Crawl4AI.

- raspado

- Collie

- PyAraña

- X-Crawl

- Arrastre de fuego

1] Scrappy

Scrapy se destaca como un marco de código abierto basado en Python diseñado para el rastreo y el raspado de páginas web. Permite a los usuarios extraer datos de páginas web de manera eficiente. Gracias al uso de Twisted, un marco de trabajo de red asincrónica, Scrapy mejora el rendimiento y la velocidad de procesamiento.

Este marco admite la incorporación de middleware y pipelines, lo que permite un procesamiento de datos personalizado. Scrapy es experto en la gestión de solicitudes, el seguimiento de vínculos y la extracción de información mediante selectores CSS y XPath, integrándose a la perfección en su entorno actual.

Además, Scrapy ofrece una interfaz fácil de usar que simplifica el proceso de seguimiento y extracción de datos de varios sitios web. La plataforma cuenta con el respaldo de una comunidad dinámica y una documentación completa.

Para instalar Scrapy , asegúrate de que estás usando Python 3.8 o superior (CPython es el predeterminado, pero PyPy también es compatible). Si estás usando Anaconda o Miniconda, instala el paquete a través del canal conda-forge con el siguiente comando:

conda install -c conda-forge scrapy

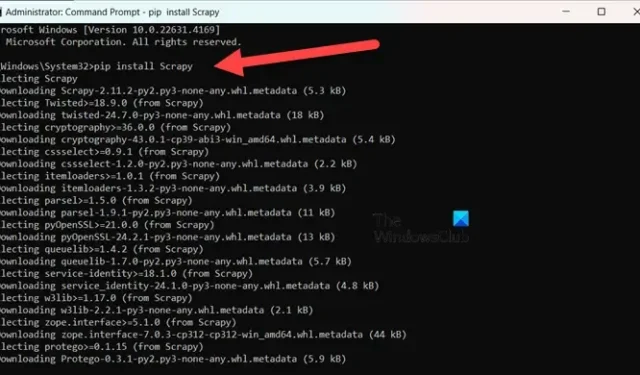

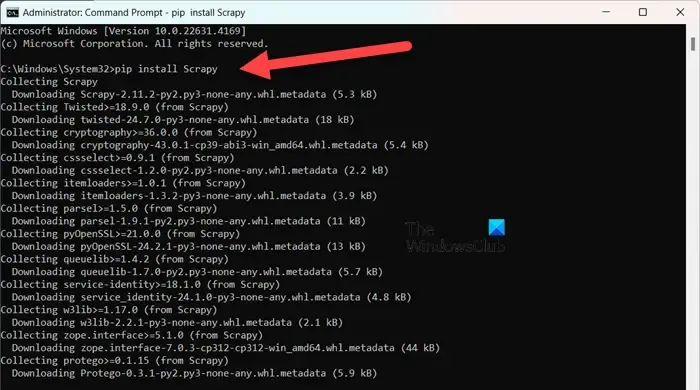

Alternativamente, para aquellos que prefieren PyPI, ejecute el comando en un símbolo del sistema elevado:

pip install Scrapy

Para profundizar en esta herramienta, visita scrapy.org .

2] collie

Colly es una biblioteca de extracción de datos sencilla y desarrollada para Golang. Simplifica el proceso de envío de solicitudes HTTP, análisis de HTML y recuperación de datos de sitios web. Colly incluye funciones que permiten a los desarrolladores navegar por páginas web, filtrar elementos mediante selectores CSS y abordar diversos desafíos de extracción de datos.

La característica más destacada de Colly es su extraordinario rendimiento, capaz de procesar más de 1000 solicitudes por segundo en un solo núcleo; esta tasa aumenta con núcleos adicionales. Logra dicha eficiencia gracias a su almacenamiento en caché integrado y a su compatibilidad con el scraping sincrónico y asincrónico.

Sin embargo, Colly tiene limitaciones, como la falta de representación de JavaScript y una comunidad más pequeña, lo que lleva a menos extensiones y menor documentación.

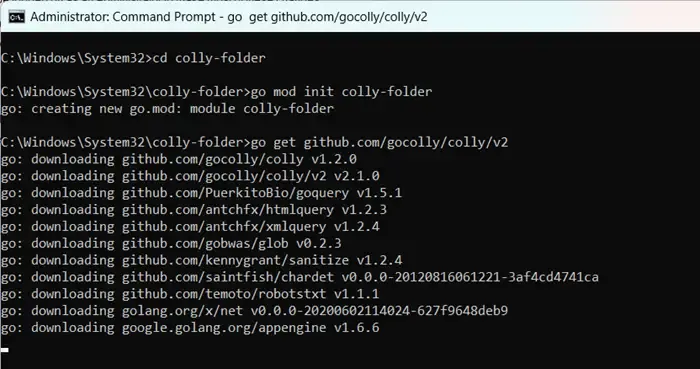

Para comenzar a usar Colly, primero instale Golang visitando go.dev . Después de la instalación, reinicie su computadora, abra el Símbolo del sistema como administrador e ingrese los comandos:

mkdir colly-folder cd colly-folder

go mod init colly-folder

go get github.com/gocolly/colly/v2

Puedes cambiar el nombre de “colly-folder” por el que prefieras. Después de crear el módulo, puedes ejecutar tu web scraper usando go run main.go.

3]PySpider

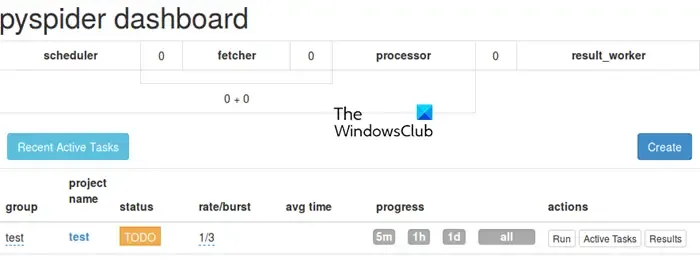

PySpider funciona como un sistema de rastreo web integral que cuenta con una interfaz de usuario intuitiva basada en la web, lo que simplifica la gestión y el monitoreo de sus rastreadores. Está equipado para manejar sitios web ricos en JavaScript a través de su integración con PhantomJS.

A diferencia de Colly, PySpider ofrece amplias capacidades de gestión de tareas, incluidas la programación y priorización de tareas, superando a Crawl4AI en este aspecto. Sin embargo, cabe señalar que puede tener un rendimiento inferior al de Crawl4AI debido a la arquitectura asincrónica de este último.

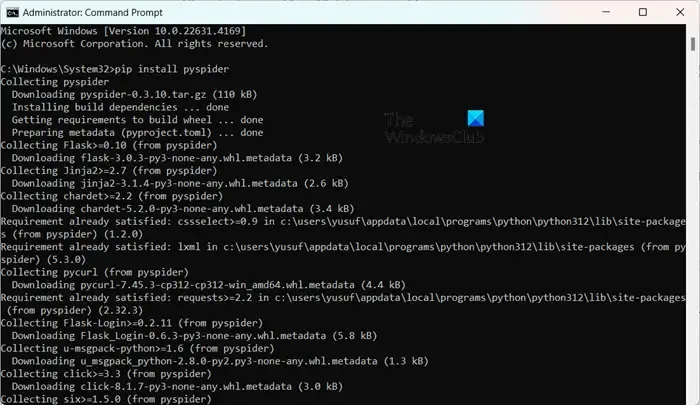

Instalar PySpider no es complicado, especialmente si ya tienes Python instalado. Puedes ejecutarlo pip install pyspideren un símbolo del sistema con privilegios elevados. Para comenzar, solo tienes que usar el comando pyspidery acceder a la interfaz en http://localhost:5000/ en tu navegador web.

4] Travesía transversal

X-Crawl es una biblioteca flexible para Node.js que utiliza tecnologías de IA para mejorar la eficiencia del rastreo web. Esta biblioteca integra capacidades de IA para facilitar el desarrollo de rastreadores y scrapers web efectivos.

X-Crawl se destaca en la gestión de contenido dinámico generado por JavaScript, una necesidad para muchos sitios web modernos. También ofrece numerosas opciones de personalización, diseñadas para ajustar la experiencia de rastreo a sus necesidades.

Es importante tener en cuenta algunas distinciones entre Crawl4AI y X-Crawl, basadas principalmente en su lenguaje de programación preferido: Crawl4AI usa Python, mientras que X-Crawl tiene su base en Node.js.

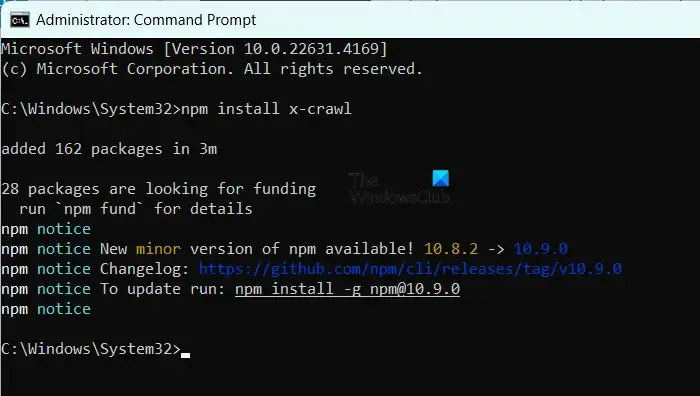

Para instalar X-Crawl, asegúrese de tener Node.js en su máquina, luego simplemente ejecute el comando npm install x-crawl.

5] Fuego gateando

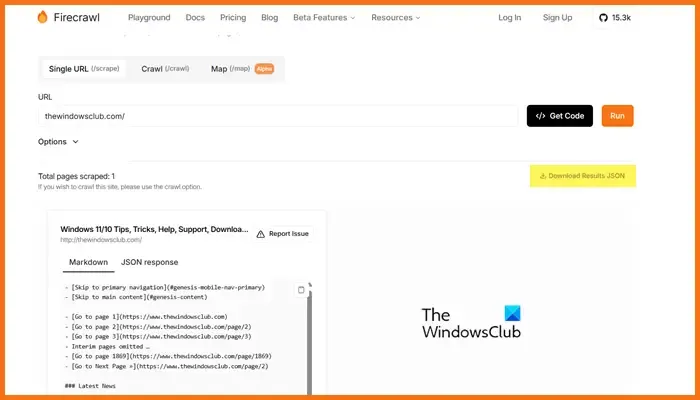

Firecrawl, desarrollado por Mendable.ai, es una sofisticada herramienta de raspado web que transforma los datos web en markdowns u otros formatos perfectamente organizados, optimizados para modelos de lenguaje grandes (LLM) y aplicaciones de IA. Genera resultados listos para el uso de LLM, lo que facilita la integración de este contenido en diversos modelos de lenguaje y soluciones de IA. La herramienta viene con una API fácil de usar para enviar trabajos de rastreo y obtener resultados. Para obtener más detalles sobre Firecrawl, visite firecrawl.dev , ingrese la URL del sitio web que desea escanear y haga clic en Ejecutar.

¿Qué herramienta de código abierto es óptima para el desarrollo web?

Hay una gran cantidad de herramientas de desarrollo web de código abierto disponibles para que las utilices. Para la edición de código, considera Visual Studio Code o Atom. Si necesitas marcos de trabajo frontend, Bootstrap y Vue.js son excelentes opciones, mientras que Django y Express.js son ideales para el desarrollo backend. Además, plataformas como Git, GitHub, Figma, GIMP, Slack y Trello también ofrecen opciones de código abierto que pueden mejorar tu flujo de trabajo de desarrollo web.

¿Son accesibles los modelos GPT de código abierto?

Sí, existen varios modelos GPT de código abierto, entre ellos GPT-Neo de EleutherAI, Cerebras-GPT, BLOOM, GPT-2 de OpenAI y Megatron-Turing NLG de NVIDIA/Microsoft. Estos modelos ofrecen una variedad de soluciones que se adaptan a diferentes requisitos, desde el procesamiento de lenguaje de propósito general hasta modelos diseñados para capacidades multilingües o tareas de alto rendimiento.

Deja una respuesta