Cómo ejecutar LLM localmente en Android

Qué saber

- Instale una aplicación como MLC Chat en su dispositivo Android para experimentar y chatear con LLM localmente.

- Descargue uno de los modelos disponibles y toque el ícono ‘Chat’ para comenzar a chatear con su LLM elegido.

- La aplicación MLC Chat te permite descargar Gemma 2b, RedPajama, Llama3, Phi-2, Mistral y Llama2.

Hay varios LLM que puede ejecutar localmente en su PC. Pero cuando se trata de smartphones, las opciones son ligeramente limitadas. Debe ejecutar un modelo de lenguaje pequeño o tener un dispositivo premium con suficiente potencia de procesamiento para abordar los LLM. De cualquier manera, es posible chatear con modelos de idioma localmente y sin conexión.

Cómo ejecutar LLM localmente en Android

Los modelos de lenguaje grandes son, bueno, grandes y requieren una gran destreza computacional. Pero incluso si su dispositivo Android tiene suficientes recursos para ejecutar SLM (modelos de lenguaje pequeño) así como LLM, aún necesita una aplicación que le permita experimentar con ellos con una interfaz fácil de usar.

Aquí es donde resulta útil una aplicación como MLC Chat. Siga los pasos a continuación para ejecutar LLM localmente en su Android usando la aplicación MLC Chat.

Paso 1: instale la aplicación MLC Chat

- Aplicación de chat MLC | Enlace de descarga

- En primer lugar, haga clic en el enlace de arriba y descargue el APK de la aplicación MLC Chat. Cuando se le solicite, toque Descargar de todos modos .

- Instale la aplicación MLCChat. Una vez hecho esto , ábrelo .

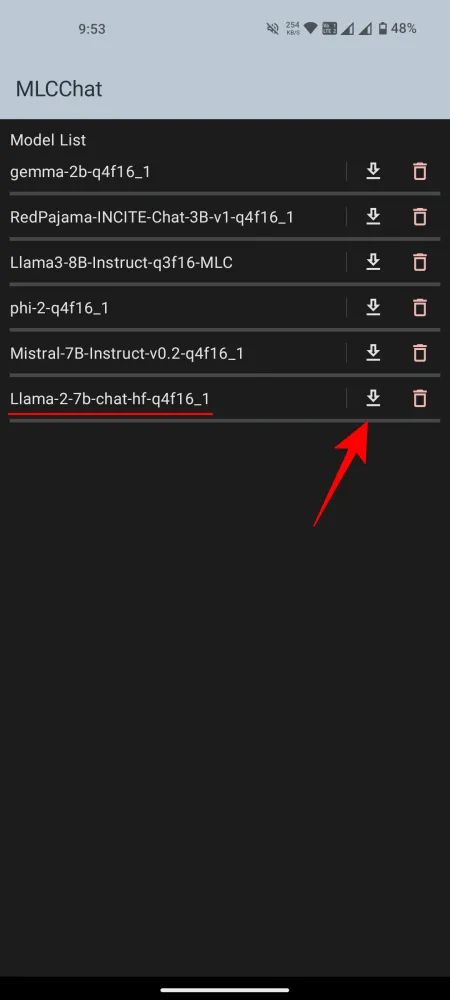

Paso 2: descargue un LLM

En la aplicación MLCChat, tendrás una lista de modelos disponibles que puedes descargar. Toque el enlace de descarga junto al modelo que le guste y espere a que se descargue.

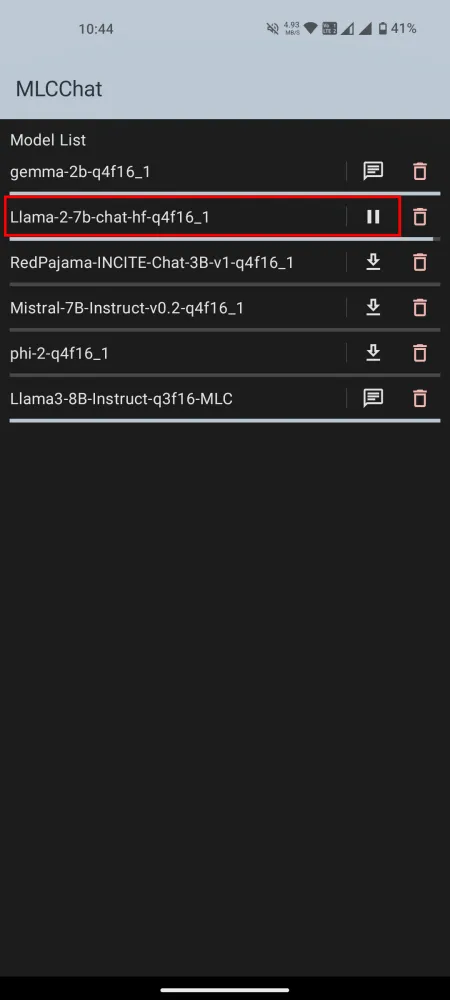

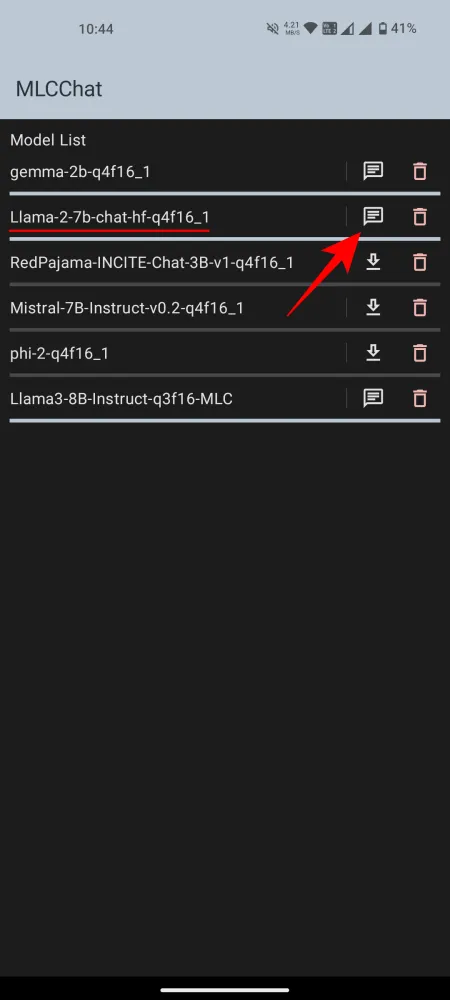

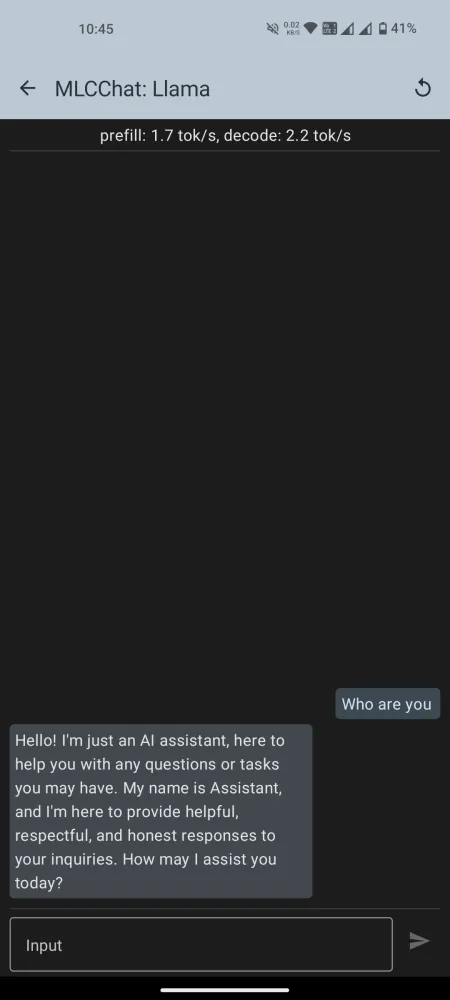

Paso 3: ejecute el LLM instalado

Una vez descargado, toque el ícono de chat al lado para iniciar el chat. Espere a que el modelo se inicialice. Una vez que esté listo, continúe y comience a chatear con la IA.

Tenga en cuenta que de la lista de modelos disponibles en la aplicación MLCChat, habrá algunos, como Llama3, que requerirán mucha potencia de procesamiento. Pero siempre puedes instalar los modelos y probarlos para ver si funcionan lo suficientemente bien. De lo contrario, pruebe con un modelo de lenguaje más pequeño.

En nuestras pruebas (en Nothing Phone 1), Gemma-2b no se pudo cargar, mientras que Llama3 eliminó la interfaz de usuario del sistema. Los que funcionaron bien fueron Llama-2 y Phi-2. La principal diferencia entre los LLM y otros modelos de lenguaje más pequeños es la amplitud de información en la que están entrenados (parámetros). Así que elige tus modelos según tus necesidades y las capacidades de tu dispositivo Android.

Esperamos que haya podido instalar y ejecutar LLM en su dispositivo Android localmente. ¡Hasta la proxima vez!

Deja una respuesta