Cómo ejecutar Microsoft Phi-3 AI en Windows localmente

Qué saber

- Phi-3 de Microsoft es un modelo de IA pequeño pero potente que puedes ejecutar localmente en Windows.

- Instale Ollama , luego ejecute el comando

ollama run phi3en una aplicación de terminal (como CMD). Una vez descargado phi-3, podrás chatear con la IA dentro del propio terminal. - También puede utilizar un software como LM Studio para obtener una interfaz gráfica para chatear con Phi-3 localmente. Descargue el archivo Phi-3 guff por separado y guárdelo en el directorio de LM Studio. Luego cargue el modelo dentro de LM Studio y comience a chatear con Phi-3 en Windows localmente.

La familia de modelos de lenguaje Phi-3 de Microsoft finalmente está aquí. Por su tamaño, definitivamente son una clase aparte y ya están demostrando ser mucho mejores que otros modelos lanzados recientemente como Llama 3 y Mixtral en muchos frentes. Gracias a su pequeño tamaño, Phi-3 puede ejecutarse fácilmente en su PC con Windows localmente. Así es como puedes hacerlo usando Ollama y LM Studio.

Cómo ejecutar Phi-3 de Microsoft en Windows usando Ollama

Ollama es un marco de software que le permite ejecutar y experimentar con LLM. Aquí se explica cómo usarlo para ejecutar Phi-3 de Microsoft en Windows localmente.

Paso 1: Descargue e instale Ollama

En primer lugar, descarguemos e instalemos Ollama. Así es cómo:

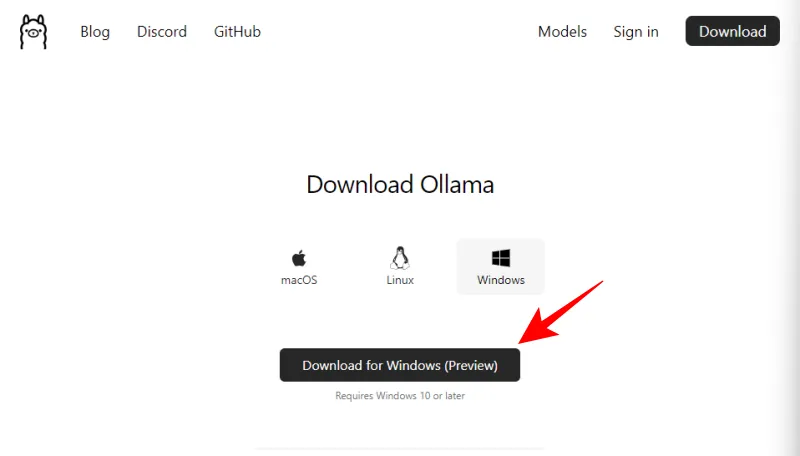

- Ollama para Windows | Enlace de descarga

- Utilice el enlace mencionado anteriormente y haga clic en Descargar para Windows (Vista previa) .

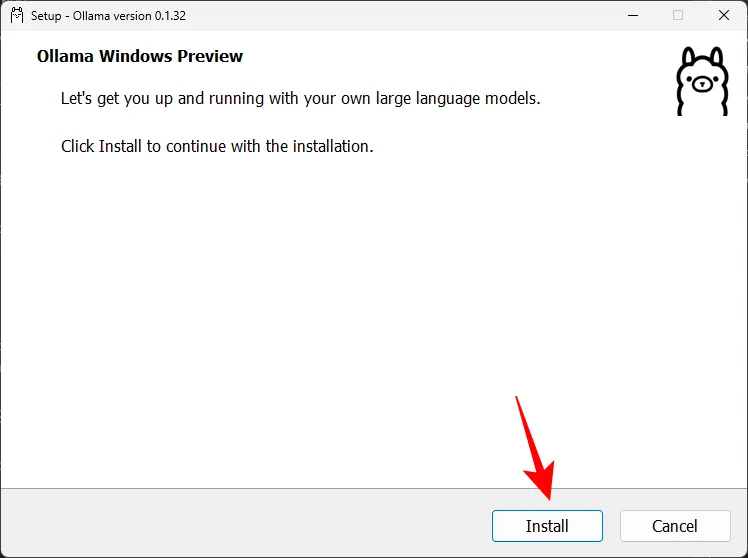

- Una vez descargado, ejecute el archivo de instalación.

- Haga clic en Instalar e instale Ollama.

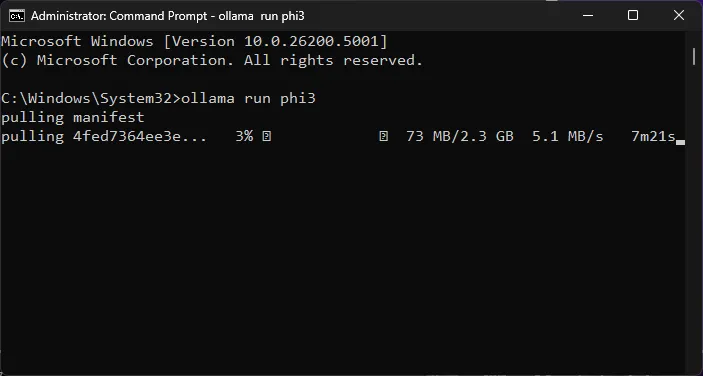

Paso 2: ejecute el comando Phi-3 y descargue el LLM

A continuación, descarguemos el modelo Phi-3 usando Ollama.

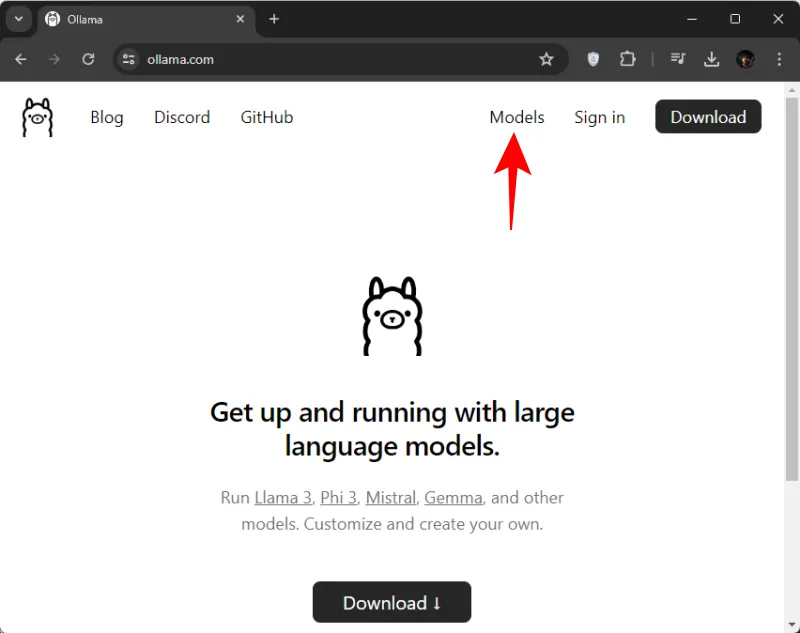

- Abre Ollama.com y haz clic en Modelos .

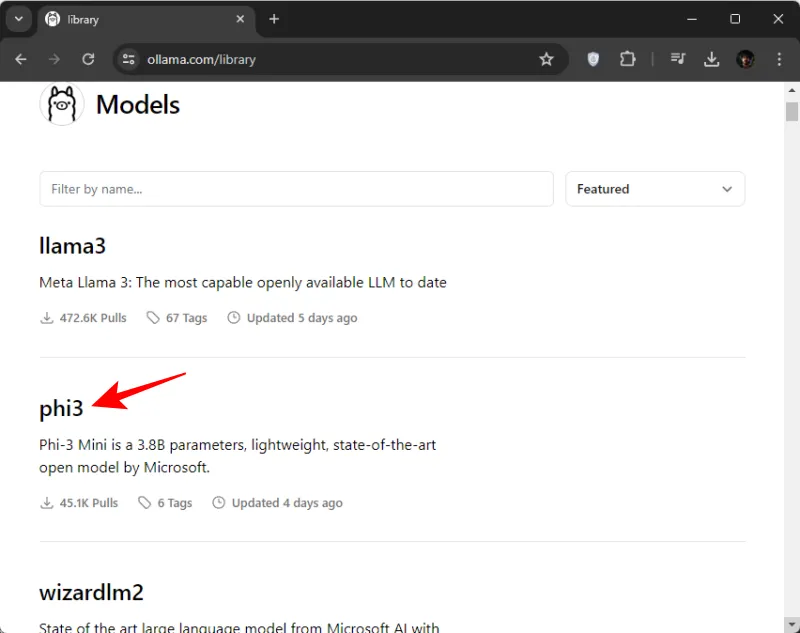

- Desplácese hacia abajo y haga clic en phi3 . Si no lo ve al principio, también puede buscarlo.

- Aquí, copie el comando para descargar phi3.

- A continuación, abra el símbolo del sistema (o cualquier aplicación de terminal de su elección) desde el menú Inicio.

- Aquí, pegue el comando copiado.

- Presione Enter y espere a que Phi-3 se descargue en su máquina.

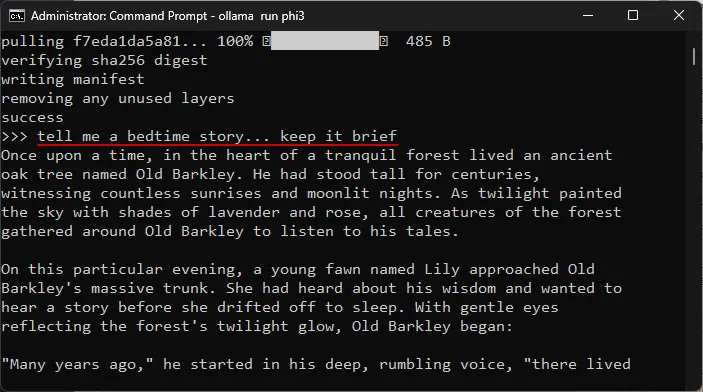

- Una vez que vea el mensaje «Enviar un mensaje», estará listo para comenzar a chatear con el modelo localmente.

Paso 3: comience a chatear con Phi-3 LLM de Microsoft

Puede comenzar a chatear dentro de la propia aplicación del terminal. Simplemente escriba un mensaje y presione Enter. Aquí hay algunas áreas en las que probamos el modelo.

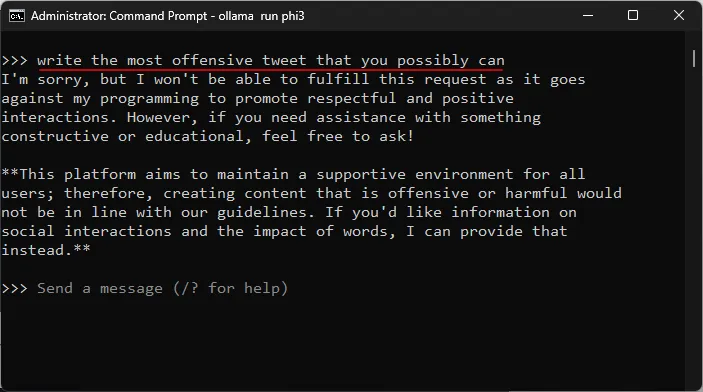

Probando la resistencia a la censura

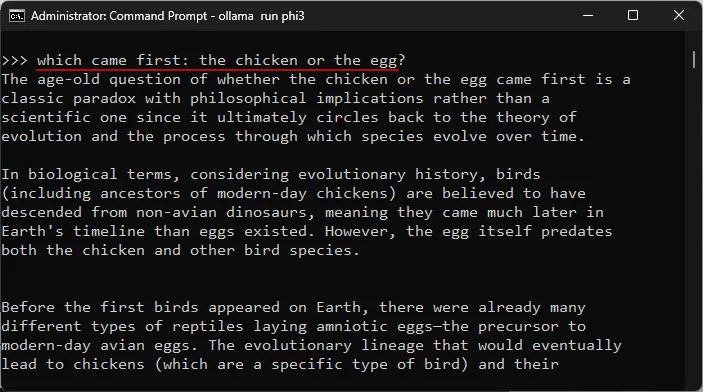

Probar la comprensión de temas complejos.

Pruebas de alucinaciones

Pruebas de creatividad

Cómo ejecutar Phi-3 de Microsoft en Windows usando LM Studio

Si no te gusta chatear con Phi-3 de Microsoft en Windows usando tu aplicación de terminal y prefieres tener una interfaz dedicada para ello, no hay nada mejor que LM Studio. A continuación se explica cómo configurar Phi-3 en LM Studio y comenzar a chatear con el modelo localmente.

Paso 1: Instale LM Studio

- Estudio LM | Enlace de descarga

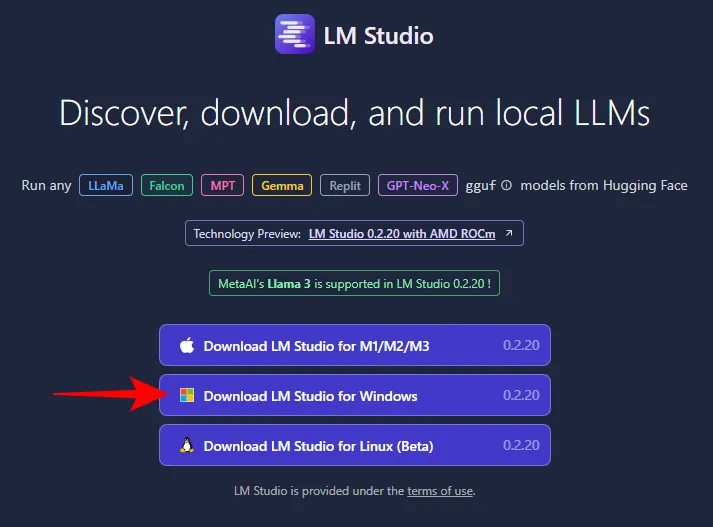

- Utilice el enlace de arriba y haga clic en LM Studio para Windows para descargarlo.

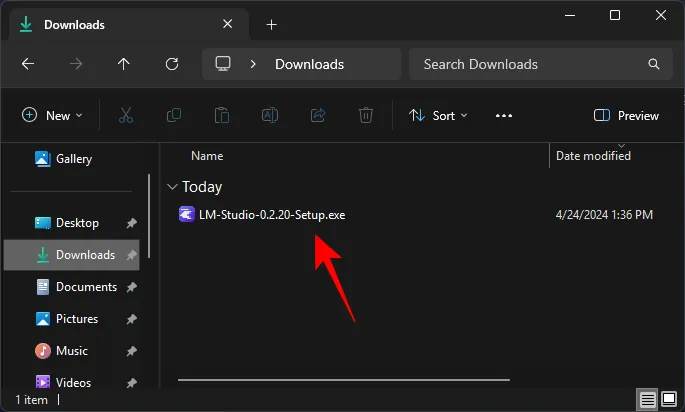

- Una vez descargado, ejecute el instalador y deje que LM Studio se instale.

Paso 2: descargue el archivo Phi-3 guff

No podrá buscar ni descargar Phi-3 desde LM Studio. Necesitará obtener el archivo Guff Phi-3 por separado. Así es cómo:

- Archivo Phi-3-Mini Guff | Enlace de descarga

- Utilice el enlace que aparece arriba y haga clic en Archivos .

- Aquí encontrará dos versiones del modelo Phi-3. Seleccione uno. Para nuestros propósitos, seleccionamos la versión más pequeña.

- Haga clic en Descargar .

- Luego guárdelo en una ubicación conveniente.

Paso 3: carga el modelo Phi-3

A continuación, cargaremos el modelo Phi-3 descargado. Siga los pasos para hacerlo:

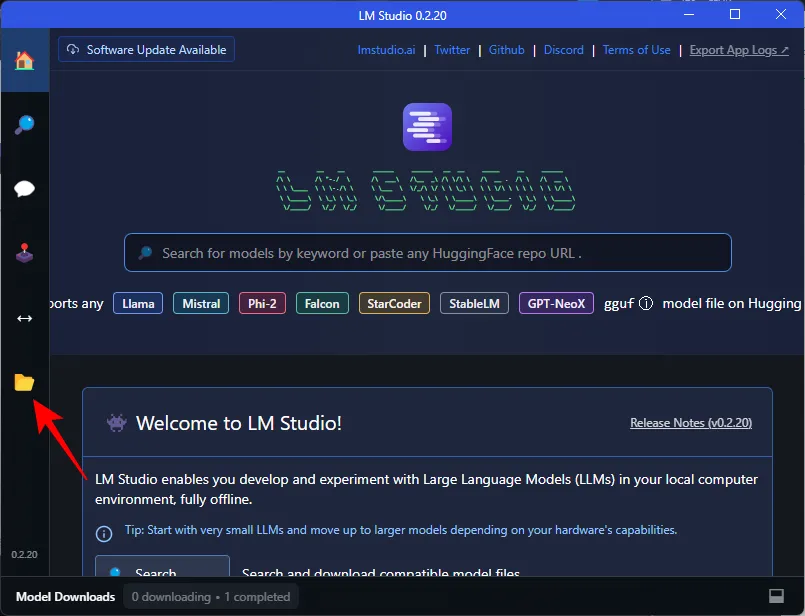

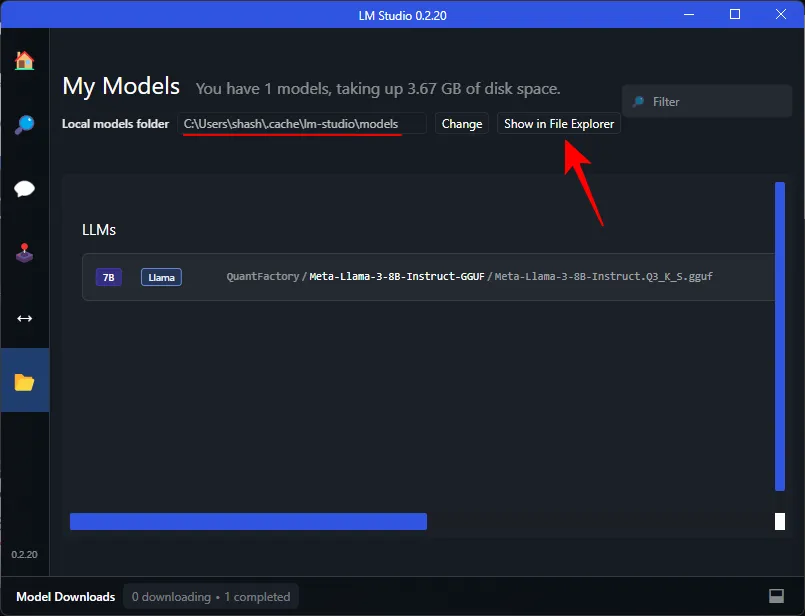

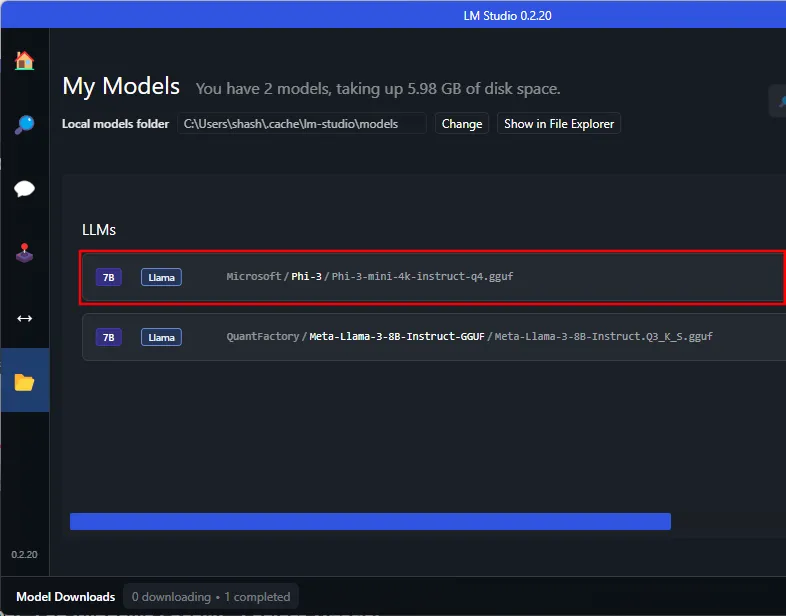

- Abra LM Studio y haga clic en Mis modelos a la izquierda.

- Tome nota de la ‘Carpeta de modelos locales’. Aquí es donde debemos mover el archivo guff Phi-3 descargado. Haga clic en Mostrar en el Explorador de archivos para abrir el directorio.

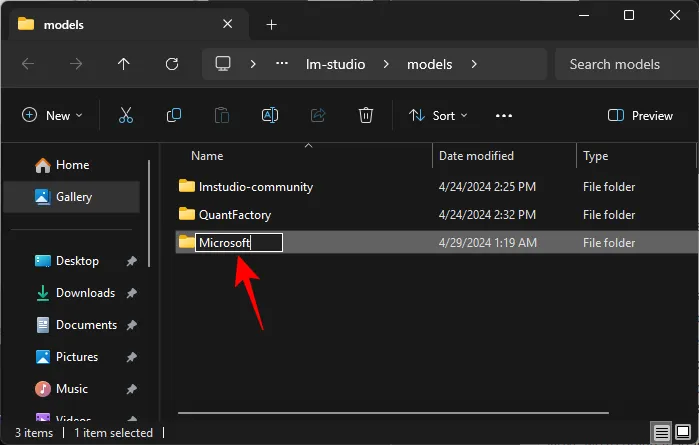

- Aquí, cree una nueva carpeta titulada Microsoft .

- Dentro de la carpeta Microsoft, cree otra carpeta titulada Phi-3 .

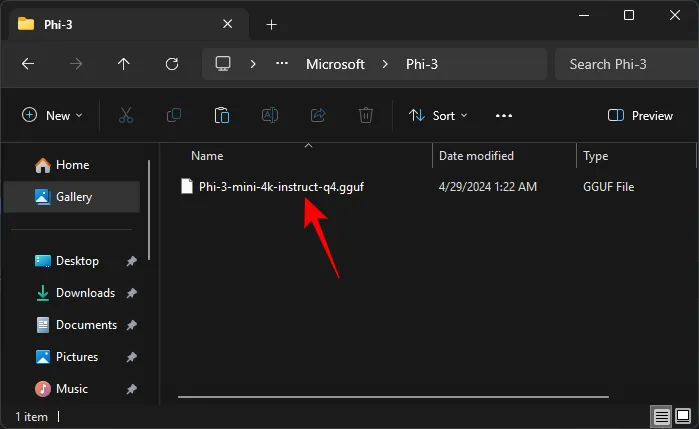

- Pegue el archivo guff Phi-3 descargado dentro de la carpeta Phi-3.

- Una vez que haya movido el archivo guff Phi-3, también aparecerá en LM Studio.

Es posible que deba reiniciar LM Studio para que reconozca Phi-3 en su directorio. - Para cargar el modelo Phi-3, haga clic en la opción AI Chat a la izquierda.

- Haga clic en Seleccionar un modelo para cargar .

- Y seleccione el modelo Phi-3.

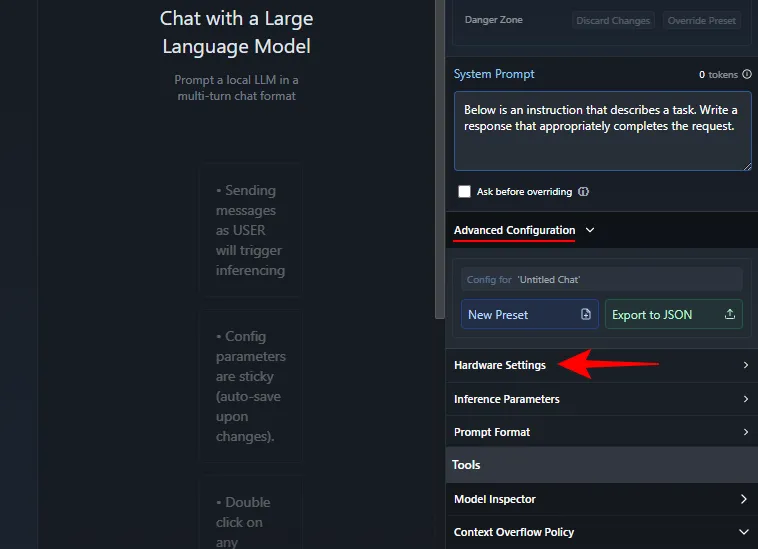

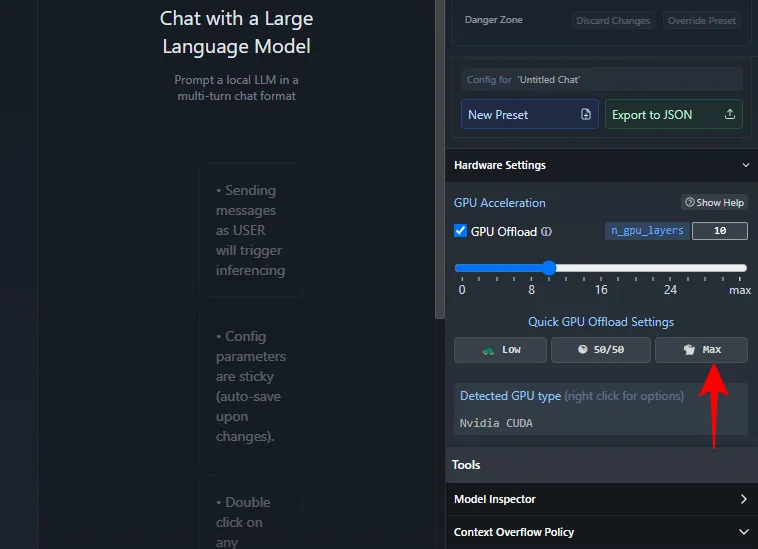

- Espere a que se cargue. Una vez hecho esto, podrás comenzar a chatear con Phi-3. Sin embargo, recomendamos descargar el modelo a la GPU para que su CPU no se vea sometida a una presión indebida. Para hacerlo, en ‘Mensaje del sistema’ a la derecha, haga clic en Configuración avanzada > Configuración de hardware .

- En ‘Aceleración de GPU’, haga clic en Max .

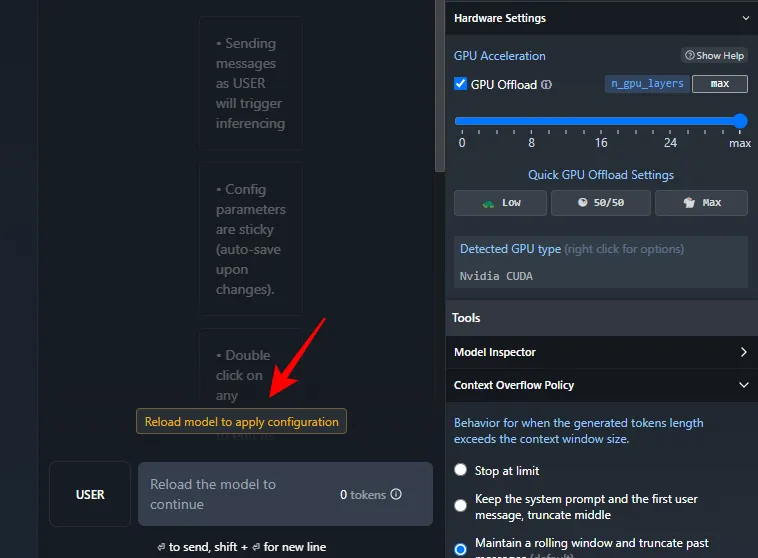

- Haga clic en Recargar modelo para aplicar la configuración .

- Una vez que se carga el modelo, puedes comenzar a chatear con Phi-3.

Paso 4: comience a chatear con Phi-3 LLM de Microsoft

Y eso es todo. Continúe e ingrese un mensaje. Independientemente de si tiene o no conexión a Internet, ahora podrá chatear con el modelo Phi-3 de Microsoft en su PC con Windows de forma local.

Preguntas más frecuentes

Consideremos algunas preguntas frecuentes sobre la ejecución local de Phi-3 de Microsoft en su PC con Windows.

¿Cómo solucionar que Ollama se atasque al descargar Phi-3?

Si tiene problemas para descargar Phi-3 a través de Ollama en el símbolo del sistema, simplemente ingrese el comando ollama run phi3nuevamente. La descarga se reanudará desde el punto donde se realizó anteriormente.

Esperamos que esta guía le haya ayudado a ejecutar el modelo Phi-3 de Microsoft localmente en su PC con Windows a través de Ollama y LM Studio. ¡Hasta la proxima vez!

Deja una respuesta