Microsoft anuncia el modelo de lenguaje-visión Turing Bletchley v3 para búsquedas de imágenes en Bing

Microsoft ha anunciado oficialmente la tercera versión de su modelo básico de visión y lenguaje multilingüe Turing Bletchley. Ahora se está implementando en varios productos de Microsoft, incluido Bing , para mejorar las búsquedas de imágenes.

Microsoft lanzó la primera versión del modelo Turing Bletchley en noviembre de 2021. En una publicación de hoy en el blog oficial de Bing , Microsoft dijo que comenzó a probar la tercera versión del modelo en el otoño de 2022 antes de agregarlo a Bing y otros productos. .

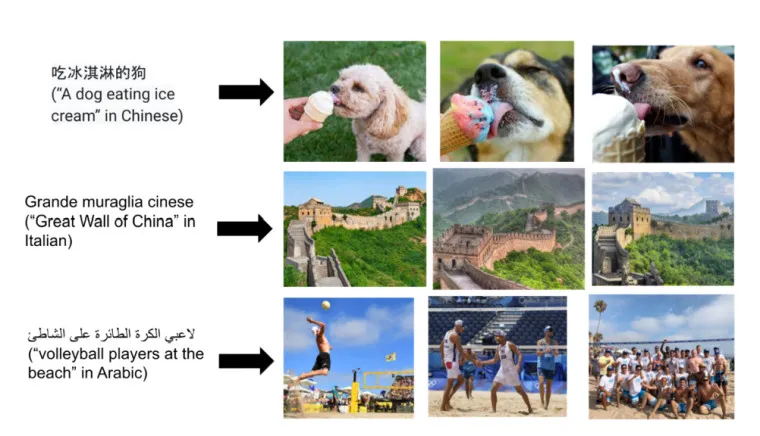

El modelo utiliza entradas de texto e imágenes para encontrar lo que una persona busca en el motor de búsqueda Bing de Microsoft. El objetivo es que el modelo se acerque lo más posible para que un texto que describa, por ejemplo, “un perro comiendo helado” se acerque lo más posible a las imágenes de un perro comiendo helado en un resultado de búsqueda.

Parte de la forma en que Turing Bletchley v3 hace estas conexiones es extensa en relación con el modelo. Microsoft afirma:

Dada una imagen y un título que describe la imagen, algunas palabras del título están enmascaradas. Luego se entrena una red neuronal para predecir las palabras ocultas condicionadas tanto en la imagen como en el texto. La tarea también se puede invertir para enmascarar píxeles en lugar de palabras. Este tipo de entrenamiento enmascarado junto con un gran modelo basado en transformadores conduce a un modelo pre-entrenado sólido que se puede ajustar en un conjunto diverso de tareas posteriores.

Además de servir para búsquedas de imágenes en Bing. El nuevo modelo Turing Bletchley v3 se utiliza para moderar contenidos en su servicio de juegos Xbox. Ayuda a ese equipo a identificar, por ejemplo, imágenes y videos que los jugadores de Xbox cargan en sus perfiles y que se considerarían inapropiados y violarían el estándar comunitario de la compañía en la plataforma Xbox.

Deja una respuesta