Top Open Source-Alternativen zu Crawl4AI: Die besten Optionen im Vergleich

Crawl4AI dient als ergänzendes Tool für Web-Crawling und Datenextraktion und erfüllt insbesondere die Anforderungen großer Sprachmodelle (LLMs) und zahlreicher KI-basierter Anwendungen. Dennoch ist es nicht der einzige Konkurrent in diesem Bereich. In diesem Artikel werden wir die besten Open-Source-Alternativen zu Crawl4AI untersuchen .

Führende Open-Source-Alternativen zu Crawl4AI

Nachfolgend finden Sie einige bemerkenswerte Open-Source-Alternativen zu Crawl4AI.

- Scrapy

- Collie

- PySpider

- X-Crawl

- Feuerkrabbler

1] Scrappy

Scrapy ist ein Python-basiertes Open-Source-Framework, das für Web Scraping und Crawling entwickelt wurde. Es ermöglicht Benutzern, effizient Daten aus Webseiten zu extrahieren. Dank der Verwendung von Twisted, einem asynchronen Netzwerkframework, verbessert Scrapy die Leistung und Verarbeitungsgeschwindigkeit.

Dieses Framework unterstützt das Hinzufügen von Middleware und Pipelines und ermöglicht so eine benutzerdefinierte Datenverarbeitung. Scrapy ist in der Lage, Anfragen zu verwalten, Links zu verfolgen und Informationen mithilfe von CSS-Selektoren und XPath zu extrahieren und fügt sich nahtlos in Ihre aktuelle Umgebung ein.

Darüber hinaus bietet Scrapy eine benutzerfreundliche Oberfläche, die das Verfolgen und Extrahieren von Daten von verschiedenen Websites vereinfacht. Die Plattform wird von einer lebendigen Community und umfassender Dokumentation unterstützt.

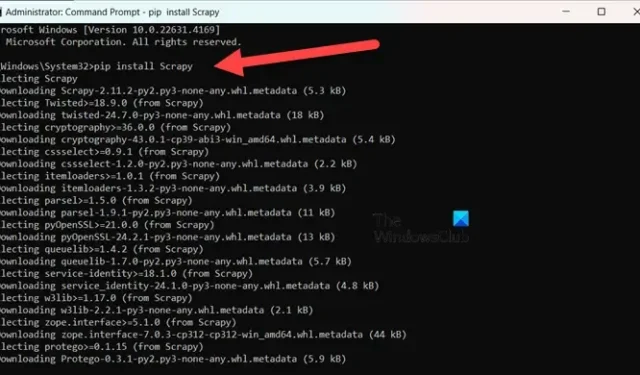

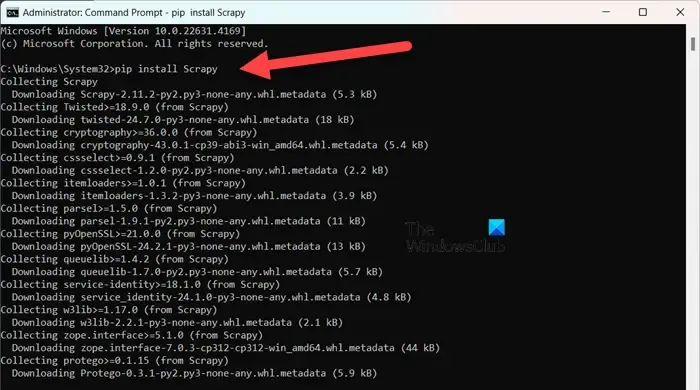

Um Scrapy zu installieren , stellen Sie sicher, dass Sie Python 3.8 oder höher verwenden (CPython ist die Standardeinstellung, aber PyPy wird auch unterstützt). Wenn Sie Anaconda oder Miniconda verwenden, installieren Sie das Paket über den Conda-Forge-Kanal mit dem folgenden Befehl:

conda install -c conda-forge scrapy

Wenn Sie PyPI bevorzugen, können Sie den Befehl alternativ in einer Eingabeaufforderung mit erhöhten Rechten ausführen:

pip install Scrapy

Um tiefer in dieses Tool einzutauchen, besuchen Sie scrapy.org .

2] Collie

Colly ist eine unkomplizierte Scraping-Bibliothek, die für Golang entwickelt wurde. Sie vereinfacht das Senden von HTTP-Anfragen, das Parsen von HTML und das Abrufen von Daten von Websites. Colly bietet Funktionen, mit denen Entwickler durch Webseiten navigieren, Elemente mithilfe von CSS-Selektoren filtern und verschiedene Herausforderungen bei der Datenextraktion bewältigen können.

Das herausragende Merkmal von Colly ist seine bemerkenswerte Leistung. Es kann über 1000 Anfragen pro Sekunde auf einem einzigen Kern verarbeiten; diese Rate erhöht sich mit zusätzlichen Kernen. Diese Effizienz wird durch das integrierte Caching und die Unterstützung für synchrones und asynchrones Scraping erreicht.

Colly weist jedoch Einschränkungen auf, beispielsweise das Fehlen einer JavaScript-Wiedergabe und eine kleinere Community, was zu weniger Erweiterungen und schlechterer Dokumentation führt.

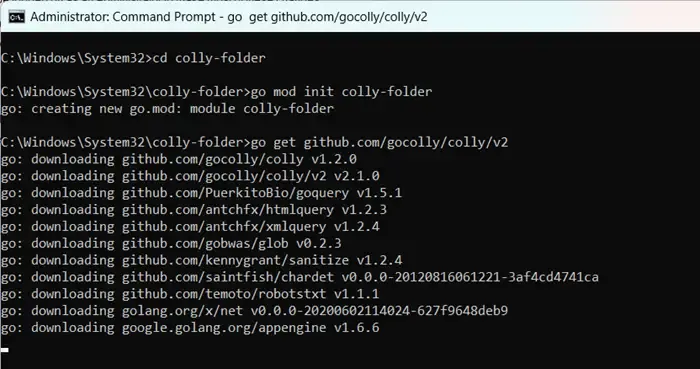

Um mit Colly zu beginnen, installieren Sie zunächst Golang, indem Sie go.dev aufrufen . Starten Sie nach der Installation Ihren Computer neu, öffnen Sie die Eingabeaufforderung als Administrator und geben Sie die folgenden Befehle ein:

mkdir colly-folder cd colly-folder

go mod init colly-folder

go get github.com/gocolly/colly/v2

Sie können „colly-folder“ beliebig umbenennen. Nachdem Sie das Modul erstellt haben, können Sie Ihren Web Scraper mit ausführen go run main.go.

3]PySpider

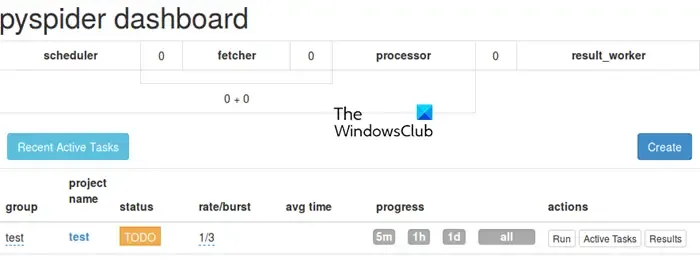

PySpider ist ein umfassendes Web-Crawling-System mit einer intuitiven webbasierten Benutzeroberfläche, die die Verwaltung und Überwachung Ihrer Crawler vereinfacht. Durch die Integration mit PhantomJS ist es für die Verarbeitung von Websites mit viel JavaScript geeignet.

Im Gegensatz zu Colly bietet PySpider umfangreiche Funktionen zur Aufgabenverwaltung, einschließlich der Planung und Priorisierung von Aufgaben, und übertrifft in dieser Hinsicht Crawl4AI. Es ist jedoch anzumerken, dass die Leistung im Vergleich zu Crawl4AI aufgrund der asynchronen Architektur von letzterem möglicherweise nachlässt.

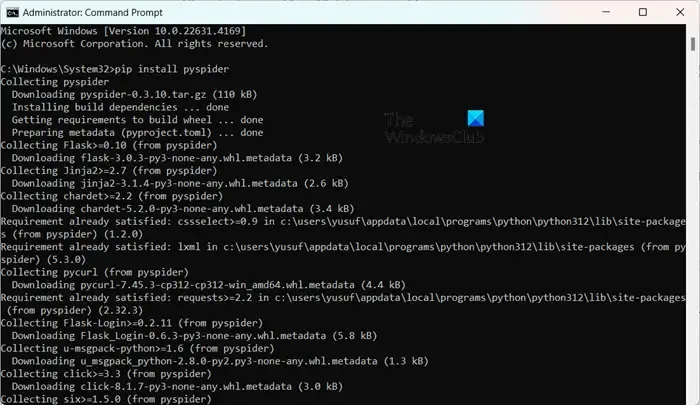

Die Installation von PySpider ist unkompliziert, insbesondere wenn Sie Python bereits installiert haben. Sie können es einfach pip install pyspiderin einer Eingabeaufforderung mit erhöhten Rechten ausführen. Verwenden Sie zum Starten einfach den Befehl pyspiderund rufen Sie die Schnittstelle unter http://localhost:5000/ in Ihrem Webbrowser auf.

4]X-Crawl

X-Crawl ist eine flexible Bibliothek für Node.js, die KI-Technologien nutzt, um die Effizienz des Web-Crawlings zu verbessern. Diese Bibliothek integriert KI-Funktionen, um die Entwicklung effektiver Web-Crawler und Scraper zu erleichtern.

X-Crawl eignet sich hervorragend für die Verwaltung dynamischer Inhalte, die von JavaScript generiert werden, was für viele moderne Websites eine Notwendigkeit ist. Es bietet außerdem zahlreiche Anpassungsoptionen, mit denen Sie das Crawling-Erlebnis genau auf Ihre Bedürfnisse abstimmen können.

Es ist wichtig, einige Unterschiede zwischen Crawl4AI und X-Crawl zu beachten, die hauptsächlich auf Ihrer bevorzugten Programmiersprache basieren – Crawl4AI verwendet Python, während X-Crawl auf Node.js basiert.

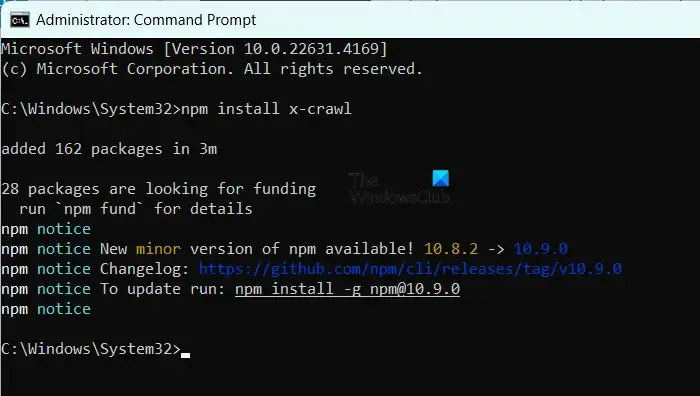

Um X-Crawl zu installieren, stellen Sie sicher, dass Sie Node.js auf Ihrem Computer haben, und führen Sie dann einfach den Befehl aus npm install x-crawl.

5] Feuerkriechen

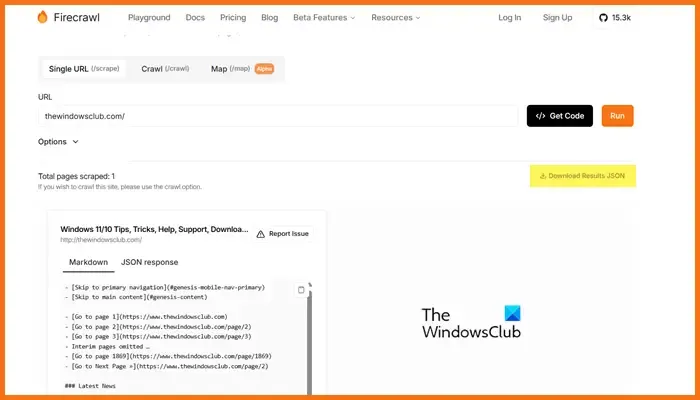

Firecrawl, entwickelt von Mendable.ai, ist ein ausgeklügeltes Web Scraping-Tool, das Webdaten in übersichtlich organisierte Markdowns oder andere Formate umwandelt, die für große Sprachmodelle (LLMs) und KI-Anwendungen optimiert sind. Es generiert Ausgaben, die für die Verwendung mit LLMs bereit sind, und erleichtert die Integration dieser Inhalte in verschiedene Sprachmodelle und KI-Lösungen. Das Tool verfügt über eine benutzerfreundliche API, mit der Sie Crawling-Jobs übermitteln und Ergebnisse erhalten können. Weitere Informationen zu Firecrawl finden Sie unter firecrawl.dev . Geben Sie die URL der Website ein, die Sie scannen möchten, und klicken Sie auf „Ausführen“.

Welches Open-Source-Tool ist für die Webentwicklung optimal?

Ihnen steht eine Vielzahl von Open-Source-Tools für die Webentwicklung zur Verfügung. Für die Codebearbeitung eignen sich Visual Studio Code oder Atom. Wenn Sie Frontend-Frameworks benötigen, sind Bootstrap und Vue.js eine ausgezeichnete Wahl, während Django und Express.js sich gut für die Backend-Entwicklung eignen. Darüber hinaus bieten Plattformen wie Git, GitHub, Figma, GIMP, Slack und Trello ebenfalls Open-Source-Optionen, die Ihren Webentwicklungs-Workflow verbessern können.

Sind Open-Source-GPT-Modelle zugänglich?

Ja, es gibt verschiedene Open-Source-GPT-Modelle, darunter GPT-Neo von EleutherAI, Cerebras-GPT, BLOOM, GPT-2 von OpenAI und Megatron-Turing NLG von NVIDIA/Microsoft. Diese Modelle bieten eine Reihe von Lösungen für unterschiedliche Anforderungen, von der allgemeinen Sprachverarbeitung bis hin zu Modellen, die für mehrsprachige Funktionen oder Hochleistungsaufgaben entwickelt wurden.

Schreibe einen Kommentar