Die besten kostenlosen Tools zum lokalen Ausführen von LLM auf einem Windows 11-PC

Möchten Sie Ihre Daten schützen und sicherstellen, dass sie auf Ihrem Gerät bleiben? Viele cloudbasierte LLM-Dienste erheben laufende Abonnementgebühren für die API-Nutzung. Darüber hinaus sind Personen an abgelegenen Standorten oder mit inkonsistentem Internetzugang oft nicht für diese Cloud-Lösungen geeignet. Welche Alternativen gibt es also?

Glücklicherweise können diese Kosten durch die Verwendung lokaler LLM-Tools vermieden werden, da Benutzer Modelle direkt auf ihrer persönlichen Hardware ausführen können. Diese Tools ermöglichen die Datenverarbeitung ohne Internetverbindung und stellen sicher, dass Ihre Informationen für externe Server unzugänglich bleiben. Darüber hinaus bieten sie eine speziell auf Ihren Arbeitsablauf zugeschnittene Schnittstelle.

Dieser Leitfaden enthält eine kuratierte Liste kostenloser lokaler LLM-Tools , die Ihren Anforderungen an Datenschutz, Erschwinglichkeit und Leistung entsprechen.

Die besten kostenlosen LLM-Tools für Windows 11-PCs

Nachfolgend finden Sie einige außergewöhnliche kostenlose lokale LLM-Tools, die gründlichen Tests und Bewertungen unterzogen wurden.

- Jan

- LM Studio

- GPT4ALL

- AllesLLM

- Zu sein

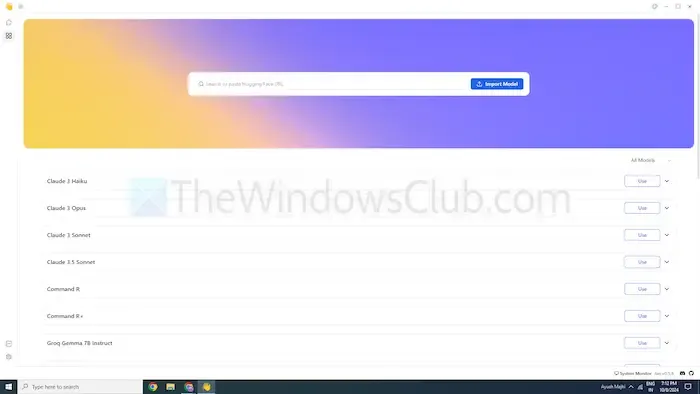

1] Januar

Wenn Sie mit ChatGPT vertraut sind, ist Jan ein ähnliches Tool, das für den Offline-Betrieb konzipiert ist. Es läuft ausschließlich auf Ihrem Gerät und ermöglicht Ihnen das private Erstellen, Analysieren und Verarbeiten von Texten in Ihrem lokalen Netzwerk.

Jan bietet erstklassige Modelle wie Mistral, Nvidia oder OpenAI und ermöglicht die Nutzung, ohne Daten an externe Server zu senden. Dies macht es zu einer ausgezeichneten Wahl für Benutzer, denen Datensicherheit wichtiger ist als Cloud-basierte Optionen.

Merkmale

- Vorkonfigurierte Modelle: Ausgestattet mit gebrauchsfertigen KI-Modellen, die keine zusätzliche Installation erfordern.

- Anpassung: Personalisieren Sie die Farben des Dashboards und wählen Sie entweder ein einfarbiges oder ein durchscheinendes Design.

- Rechtschreibprüfung: Nutzen Sie diese Funktion, um Rechtschreibfehler zu korrigieren.

Pro

- Ermöglicht Modellimporte über die Hugging Face-Quelle.

- Unterstützt Erweiterungen für mehr Anpassungsmöglichkeiten.

- Die Nutzung ist völlig kostenlos.

Nachteile

- Eingeschränkter Community-Support, daher weniger verfügbare Tutorials und Ressourcen.

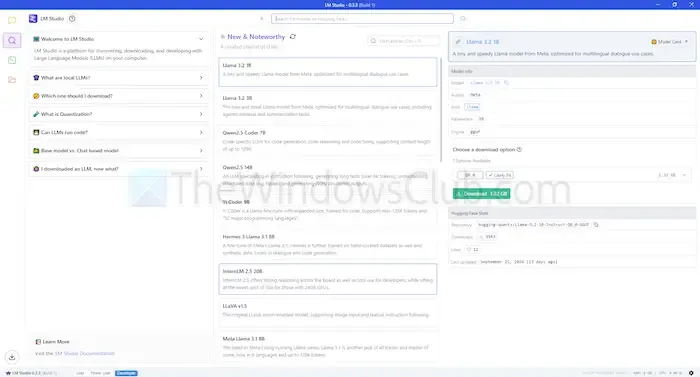

2] LM Studio

LM Studio ist ein weiteres lokales LLM-Tool, mit dem Sie Sprachmodelle wie ChatGPT direkt auf Ihrem Computer nutzen können. Es bietet erweiterte Modelle, die Ihre Fähigkeit verbessern, Anfragen zu verstehen und zu beantworten, wobei die Lokalisierung präzise beibehalten wird, um mehr Privatsphäre und Kontrolle zu gewährleisten.

Dieses Tool kann Dokumente zusammenfassen, Inhalte generieren, Antworten liefern und sogar beim Programmieren helfen – und das alles lokal. Sie können die Kompatibilität verschiedener Modelle mit Ihrem System vor der Bereitstellung prüfen und so eine effiziente Nutzung von Zeit und Ressourcen sicherstellen.

Merkmale

- Datei-Upload und RAG-Integration: Laden Sie verschiedene Dokumenttypen wie PDF, DOCX, TXT und CSV für maßgeschneiderte Antworten hoch.

- Umfangreiche Anpassungsoptionen: Wählen Sie aus mehreren Farbthemen und Komplexitätsstufen für die Benutzeroberfläche.

- Ressourcenreich: Bietet Dokumentation und Lernressourcen für Benutzer.

Pro

- Kompatibel mit Linux, Mac und Windows.

- Lokale Serverkonfiguration für Entwickler verfügbar.

- Bietet eine kuratierte Auswahl an Sprachmodellen.

Nachteile

- Kann für Anfänger eine Herausforderung darstellen, insbesondere während der Ersteinrichtung.

3] GPT4ALL

GPT4ALL ist ein weiteres fortschrittliches LLM-Tool, das ohne Internetverbindung oder API-Integration funktioniert. Diese Anwendung kann ohne GPUs ausgeführt werden, kann diese aber nutzen, wenn sie verfügbar sind, wodurch sie für eine breite Palette von Benutzern zugänglich ist. Es unterstützt verschiedene LLM-Architekturen und gewährleistet die Kompatibilität mit vielen Open-Source-Modellen und Frameworks.

Dieses Tool verwendet llama.cpp für sein Backend und verbessert die Leistung sowohl von CPUs als auch von GPUs, ohne dass High-End-Rechenressourcen erforderlich sind. GPT4ALL funktioniert nahtlos mit Intel- und AMD-Prozessoren und kann GPUs für optimierte Verarbeitungsgeschwindigkeiten nutzen.

Merkmale

- Lokale Dateiintegration: Modelle können über „Local Docs“ lokale Dokumente wie PDFs oder Textdateien abfragen und mit ihnen interagieren.

- Speichereffizient: Viele Modelle sind in 4-Bit-Versionen verfügbar, um den Speicher- und Verarbeitungsbedarf zu reduzieren.

- Riesiges Modell-Repository: GPT4ALL hostet über 1000 Open-Source-Modelle aus Repositories wie Hugging Face.

Pro

- Open Source und transparent im Betrieb.

- Bietet maßgeschneiderte Lösungen für Unternehmen, um KI offline zu nutzen.

- Starker Schwerpunkt auf die Privatsphäre der Benutzer.

Nachteile

- Eingeschränkte Unterstützung für ARM-Prozessoren, wie sie beispielsweise in Chromebooks verwendet werden.

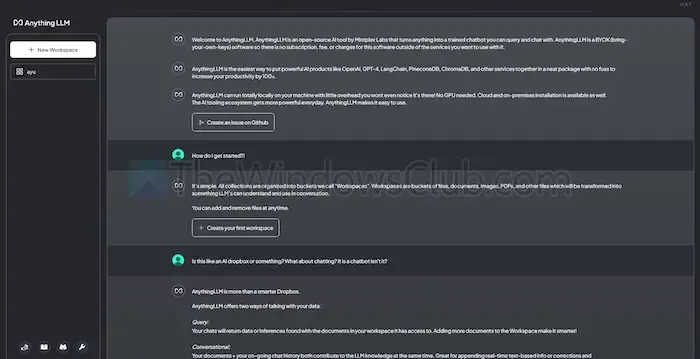

4] AllesLLM

AnythingLLM ist ein Open-Source-LLM, das umfangreiche Anpassungsmöglichkeiten bietet und ein privates KI-Erlebnis gewährleistet. Es ermöglicht Benutzern, LLMs offline auf ihren lokalen Geräten zu implementieren und auszuführen – unabhängig davon, ob sie Windows, Mac oder Linux verwenden – und gewährleistet so absolute Datenvertraulichkeit.

Dieses Tool eignet sich besonders für Einzelnutzer, die eine unkomplizierte Installation mit minimalem Einrichtungsaufwand wünschen. Es funktioniert ähnlich wie ein privates ChatGPT-System, das Einzelpersonen oder Unternehmen einsetzen können.

Merkmale

- Entwicklerfreundlich: Bietet eine umfassende API für benutzerdefinierte Integrationen.

- Tool-Integration: Möglichkeit, zusätzliche Tools einzubinden und API-Schlüssel zu generieren.

- Schnelle Installation: Entwickelt für eine Installation mit nur einem Klick.

Pro

- Hohe Flexibilität bei der LLM-Nutzung.

- Dokumentzentrierte Funktionen.

- Eine Plattform mit KI-Agenten zur Automatisierung von Benutzeraufgaben.

Nachteile

- Fehlende Unterstützung für mehrere Benutzer.

- Die Navigation in erweiterten Funktionen kann eine Herausforderung sein.

Greifen Sie hier auf AnythingLLM zu

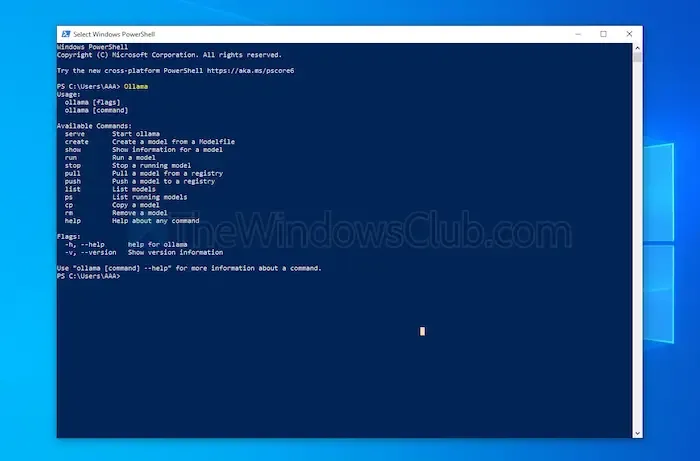

5] Sein

Ollama bietet Benutzern die vollständige Kontrolle über die Erstellung lokaler Chatbots ohne Abhängigkeit von APIs. Dieses Tool profitiert derzeit von erheblichen Beiträgen von Entwicklern, wodurch häufige Updates und Verbesserungen für eine verbesserte Funktionalität sichergestellt werden. Im Gegensatz zu den anderen besprochenen Optionen funktioniert Ollama über eine Terminalschnittstelle für Modellinstallationen und -starts.

Jedes von Ihnen installierte Modell kann unterschiedliche Konfigurationen und Gewichtseinstellungen haben, wodurch Softwarekonflikte auf Ihrem Computer vermieden werden. Darüber hinaus verfügt Ollama über eine OpenAI-kompatible API, die eine mühelose Integration mit jeder Anwendung ermöglicht, die OpenAI-Modelle verwendet.

Merkmale

- Lokales Modell-Hosting: Ollama ermöglicht Ihnen, große Sprachmodelle wie Llama und Mistral offline auszuführen.

- Modellanpassung: Fortgeschrittene Benutzer haben die Möglichkeit, das Modellverhalten über eine Modusdatei anzupassen.

- Integration mit OpenAI-API: Ollama enthält eine REST-API, die auf die Angebote von OpenAI abgestimmt ist.

- Ressourcenverwaltung: Gewährleistet eine effiziente Nutzung der CPU- und GPU-Ressourcen, um eine Systemüberlastung zu vermeiden.

Pro

- Eine robuste Sammlung unterschiedlicher Modelle verfügbar.

- Möglichkeit zum Importieren von Modellen aus Bibliotheken wie PyTorch.

- Lässt sich gut mit umfassender Bibliotheksunterstützung integrieren.

Nachteile

- Keine grafische Benutzeroberfläche bereitgestellt.

- Relativ hoher Speicherbedarf.

Abschluss

Zusammenfassend lässt sich sagen, dass lokale LLM-Tools eine hervorragende Alternative zu Cloud-basierten Modellen darstellen, da sie mehr Privatsphäre und volle Kontrolle gewährleisten, ohne dass Kosten entstehen. Ob Sie einfache Benutzerfreundlichkeit oder umfangreiche Anpassungsoptionen suchen, die vorgestellten Tools sind auf verschiedene Erfahrungsstufen und Anforderungen zugeschnitten.

Die Auswahl des richtigen Tools hängt von Faktoren wie Verarbeitungskapazität und Kompatibilität ab. So können Sie die Leistungsfähigkeit von KI nutzen, ohne Ihre Privatsphäre zu gefährden oder Abonnementgebühren zu zahlen.

Schreibe einen Kommentar