Das GPT-4o-Modell von OpenAI ist alles, was wir uns von Sprachassistenten gewünscht haben

Was Sie wissen sollten

- Das Frühjahrsupdate von OpenAI stellte GPT-4o vor, das neue Flaggschiffmodell des Unternehmens.

- OpenAI hat außerdem einen verbesserten Sprachmodus vorgeführt, der der bisher emotionalste und lebensechteste Assistent ist.

- GPT-4o und seine API werden allen Benutzern zur Verfügung stehen, während der Sprachmodus vorerst nur für Plus-Abonnenten eingeführt wird.

- ChatGPT wird in Kürze auch seine Desktop-App für Mac veröffentlichen; eine Windows-App wird irgendwann in diesem Jahr verfügbar sein.

OpenAI hat die Messlatte wieder einmal höher gelegt. Obwohl die Neuigkeiten beim Spring Update-Event keine Ausflüge in das Gebiet der Suchmaschinen beinhalteten, hat OpenAI mit seinem neuen Modell GPT-4o die Herzen und Köpfe vieler erobert. Es ist schnell, flott und mit einem verbesserten Sprachmodus ist es dem KI-Assistenten aus Spike Jonzes Film „Her“ aus dem Jahr 2013 erschreckend ähnlich.

Aber was noch wichtiger ist: Es ist ein großer Fortschritt in Bezug auf Sprachassistenten auf Smartphones, die ChatGPT für sich beanspruchen möchte und für die es nun auch ideal geeignet ist. Hier finden Sie alles, was Sie über GPT, die Upgrades des Sprachmodus bei ChatGPT und deren Bedeutung für die Branche wissen sollten.

Das GPT-4o-Modell macht ChatGPT flotter und emotionaler als jeden KI-Chatbot oder -Assistenten

https://www.youtube.com/watch?v=vgYi3Wr7v_g

GPT-4o („o“ für Omni) ist das neue Flaggschiffmodell des Unternehmens und zugleich das erste Modell, das Text, Bild und Audio kombiniert. Es verfügt über Intelligenz auf GPT-4-Niveau, ist aber schneller und effizienter. In der vorherigen Version des Sprachmodus, die mit einer Mischung aus drei Modellen mit unterschiedlichem Intelligenzgrad arbeitete, ging ein Großteil der Hauptintelligenz auf GPT-4-Niveau verloren. Darin unterscheidet sich GPT-4o.

GPT-4o ist das erste Modell, das durchgängig in den drei Modalitäten Text, Bild und Audio trainiert wurde und ausschließlich den Sprachmodus unterstützt. Und das merkt man. In einer der Demos haben die Leute bei OpenAI ChatGPT auf zwei Telefonen dazu gebracht, miteinander zu sprechen und Lieder zu singen.

https://www.youtube.com/watch?v=MirzFk_DSiI

Die Antworten von ChatGPT sind schnell genug, um in Echtzeit zu erfolgen. Es kann auch Dinge tun wie Tonfall beobachten, emotionale Zustände anhand von Stimmen und Videos erkennen, Ratschläge geben, beim Codieren helfen und live übersetzen, während es das Ganze wie ein vertrauliches menschliches Gespräch erscheinen lässt.

Während der Veranstaltung dramatisierte ChatGPT Gutenachtgeschichten, wechselte im Handumdrehen die Stimmen und beendete die Veranstaltung mit einem Lied.

https://www.youtube.com/watch?v=D9byh4MAsUQ

Dies sind nur einige der vielen Dinge, die ChatGPT mit dem GPT-4-Omni-Modell tun kann, das bereits bahnbrechende Neuerungen mit sich bringt. Als erste seiner Art könnten zukünftige Omni-Modelle die Art und Weise, wie wir mit ChatGPT chatten, und unsere Beziehung zu ihm völlig verändern.

GPT-4o ist für alle kostenlos!

GPT-4o ist auch nicht nur Plus-Mitgliedern vorbehalten. Die Tatsache, dass OpenAI kostenlose Benutzer automatisch mit GPT-4o aktualisiert, legt die Messlatte für andere Chatbots auf ganzer Linie höher. Dies ist besonders praktisch für Benutzer, die Google Assistant (oder heutzutage Gemini) ersetzen möchten, wofür ChatGPT perfekt geeignet ist.

Es gibt bereits Möglichkeiten und Mittel für Android-Benutzer, ChatGPT als digitalen Assistenten zu verwenden. Einige Hersteller, wie Nothing, ermöglichen es Ihnen auch, ChatGPT zur Schnelleinstellungskachel hinzuzufügen, um schneller auf den Sprachmodus zugreifen zu können. Aber ein offizieller ChatGPT-Assistent könnte durchaus der Ersatz sein, den sich Benutzer wünschen.

Mit der Veröffentlichung einer offiziellen ChatGPT-Desktop-App könnte ChatGPT Ihr einziger Assistent auf allen Geräten sein. Die ChatGPT-Windows-App wird später in diesem Jahr erscheinen, während in den nächsten Wochen eine App für Mac herausgebracht wird.

GPT-4o ist ein kleineres, effizienteres Modell

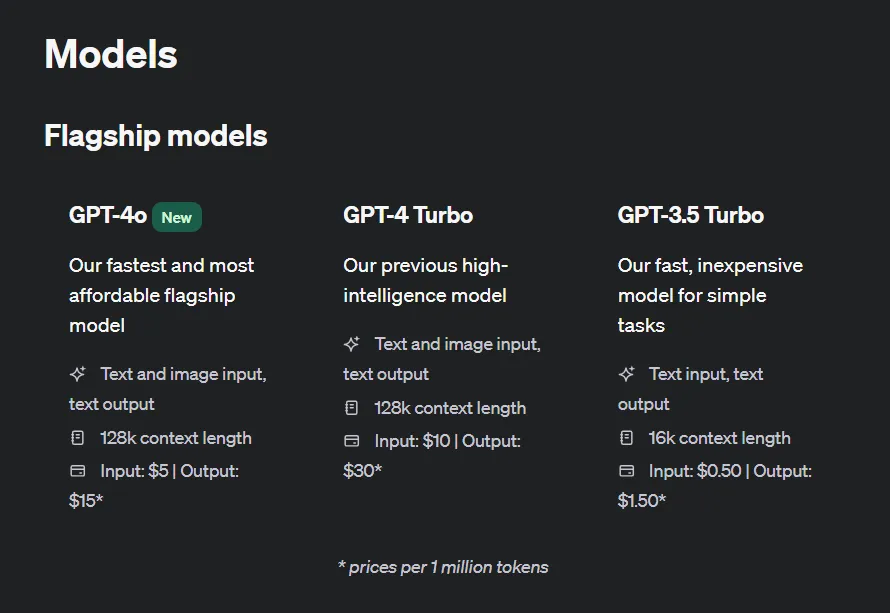

GPT-4o ist das bisher schnellste und günstigste Modell und entthront GPT-4 Turbo in vielerlei Hinsicht. Mit der Intelligenz auf GPT-Turbo-Niveau soll GPT-4o doppelt so schnell sein, obwohl Tests in der Praxis dies noch nicht bestätigen müssen. Es gibt aber auch verschiedene andere Upgrades. Vergleichen Sie die wichtigsten Funktionen unten:

OpenAI stellt GPT-4o außerdem in den APIs „Chat Completions“, „Assistants“ und „Batch“ zur Verfügung. Entwickler werden sich sofort darauf stürzen, wenn das Feature herauskommt, insbesondere, da die API-Token nur die Hälfte des Preises von GPT-4 Turbo kosten.

Die Geschwindigkeit des neuen Modells von ChatGPT ist besonders hilfreich bei Live-Übersetzungen, wie OpenAI vorführte, wobei die Sprachfunktion als Vermittler zwischen Menschen fungiert, die verschiedene Sprachen sprechen.

https://www.youtube.com/watch?v=c2DFg53Zhvw

Der neue Sprach- und Videomodus fühlt sich an wie KI aus den Filmen

Dank des Omni-Modells verfügt ChatGPT über einen viel breiteren emotionalen Quotienten, da es emotionale Zustände erkennen kann, indem es einfach Ihrer Stimme zuhört oder Ihre Mimik betrachtet. Aber abgesehen von Augen und Ohren ist es die Stimme, die dieses magische menschliche Element hinzufügt und die Illusion erzeugt, dass ein Geist in der Maschine steckt, was die Fantasie von Menschen auf der ganzen Welt beflügelt zu haben scheint.

Sam Altman nannte es treffend „KI aus den Filmen“. Angesichts des unbeschwerten, leicht koketten Tons der Demo wird es nicht überraschend sein, dass die Leute ChatGPT eher als ihren Assistenten annehmen als die herkömmlichen Standardassistenten, die, offen gesagt, mittlerweile veraltet erscheinen. Aber bevor Sie sich mit ChatGPT anfreunden oder mit Ihrem digitalen Begleiter intim werden, sollten Sie vielleicht die Botschaft des Films beherzigen, auf die Altman anspielt, und die Fallstricke vermeiden, digitale Begleitung mit echter zu verwechseln.

Wird Apple mit OpenAI zusammenarbeiten und Siri ersetzen?

Nur wenige Tage vor der Veranstaltung stand Apple Berichten zufolge kurz vor einem Deal mit OpenAI, um neue KI-Funktionen auf zukünftigen iPhones zu ermöglichen. Jetzt, da GPT-4o mit einem besseren, eindrucksvolleren Sprachmodus herausgekommen ist, könnten wir die Fähigkeiten von ChatGPT auf eine Reihe von iOS-Funktionen übertragen sehen, darunter Siri. Es ist vielleicht weit hergeholt, sich vorzustellen, dass Apple Siri in naher Zukunft aufgibt, wenn überhaupt. Aber es könnte durchaus mit Fähigkeiten aufgerüstet werden, die sich nicht allzu sehr von denen von ChatGPT unterscheiden. Weitere Neuigkeiten dazu werden voraussichtlich bekannt gegeben, wenn wir uns der WWDC im Juni nähern. Bleiben Sie also dran.

Wann wird GPT-4o eingeführt?

Da GPT-4o erst kürzlich angekündigt wurde, kann es eine Weile dauern, bis es weltweit für Benutzer verfügbar ist. Was den Spritely Voice Mode betrifft, werden Plus-Abonnenten als Erste darauf zugreifen können. Wenn Sie also die neue Funktion ausprobieren, länger chatten und schnelle Antworten vom KI-Assistenten erhalten möchten, lohnt sich eine Plus-Mitgliedschaft immer noch.

Mit einer besseren, schnelleren Architektur und einem breiteren Spektrum an emotionalen Funktionen hat ChatGPT die besten Voraussetzungen, Ihr bevorzugter Sprachassistent oder vielleicht sogar ein Freund zu werden.

Was denken Sie? Sind Sie gespannt darauf, ChatGPT als Ihren digitalen Assistenten auszuprobieren? Die Möglichkeiten für kreative Gespräche sind endlos, aber auch das Missbrauchspotenzial. Denken Sie also daran, die neuen Funktionen in erster Linie als Werkzeug zu verwenden, auch wenn Sie sie ausprobieren. Bis zum nächsten Mal! Passen Sie auf sich auf.

Schreibe einen Kommentar