Microsoft-Patent stellt Technologie zur Verhinderung von KI-Halluzinationen vor

Eines der größten Hindernisse für künstliche Intelligenz ist ihre Neigung zur Halluzination. Das bedeutet, dass sie bei der Erledigung von Aufgaben irreführende oder erfundene Informationen generieren kann. Obwohl die meisten KI-Systeme Online-Ressourcen nutzen, um genaue Antworten zu liefern, kann es bei längeren Gesprächen vorkommen, dass sich die KI auf unbegründete Informationen verlässt.

Anfang des Jahres begann Microsoft mit der Entwicklung einer Lösung zur Bekämpfung von KI-Halluzinationen und veröffentlichte außerdem ein Forschungspapier, in dem eine patentierte Technologie beschrieben wird, mit der diese Ungenauigkeiten präventiv verhindert werden sollen.

Das Dokument mit dem Titel „Interaktion mit einem Sprachmodell unter Verwendung externen Wissens und Feedbacks“ beschreibt, wie dieser Mechanismus funktionieren würde.

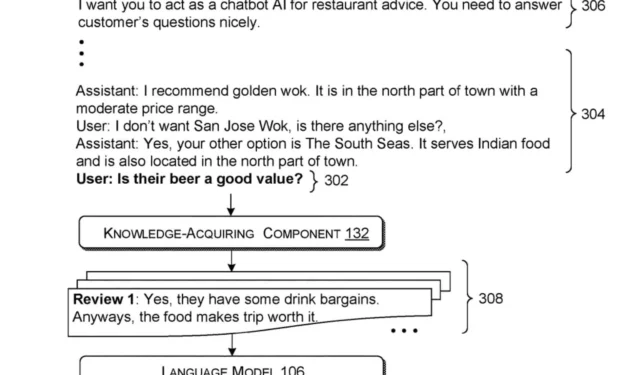

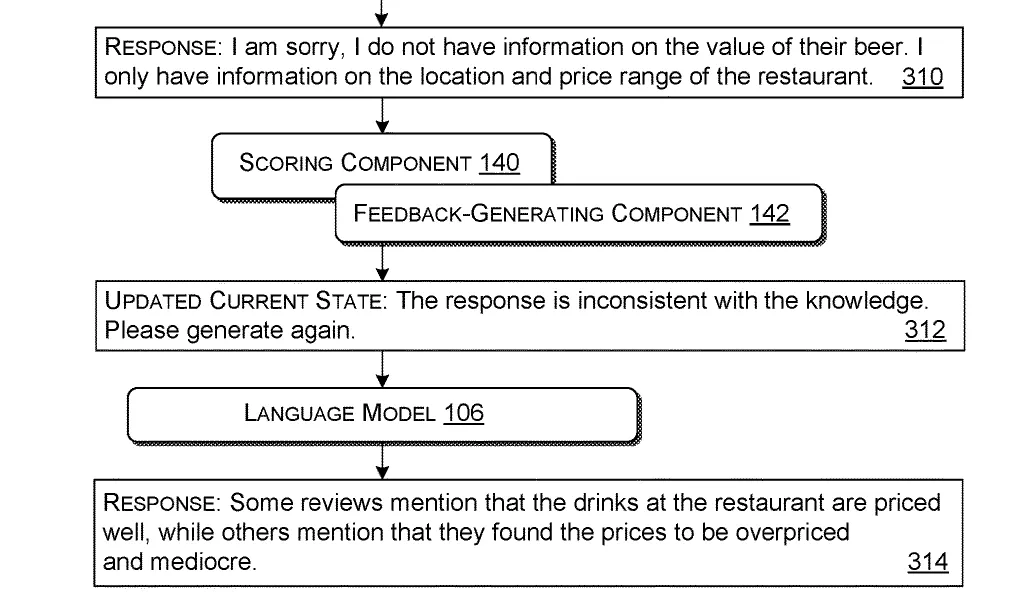

Dieses System funktioniert, indem es eine Abfrage verarbeitet – eine Frage oder Anfrage eines Benutzers. Anschließend ruft es auf Grundlage dieser Abfrage relevante Informationen aus externen Quellen ab. Anschließend fasst es diese Informationen zusammen mit der ursprünglichen Abfrage zu einem zusammenhängenden Paket zusammen, das für die Verwendung durch das Sprachmodell geeignet ist.

Sobald das Paket erstellt ist, wird es dem Sprachmodell vorgestellt und darauf trainiert, Antworten auf der Grundlage der bereitgestellten Eingaben zu formulieren. Das KI-Modell generiert dann eine erste Antwort, die auf diesem Eingabepaket basiert.

Um die Relevanz der Antwort sicherzustellen, verwendet das System vordefinierte Kriterien, um zu beurteilen, ob die erste Ausgabe die Nützlichkeitsstandards erfüllt. Sollte die erste Antwort keinen Wert aufweisen (was auf KI-Halluzinationen hindeutet), erstellt das System ein verbessertes Eingabepaket, das Feedback zu den falschen oder fehlenden Informationen enthält.

Diese neu überarbeitete Eingabe wird wieder in das Sprachmodell eingespeist, das dann auf der Grundlage dieser verfeinerten Informationen eine aktualisierte Antwort erstellt.

Diese innovative Technologie bietet nicht nur Potenzial für die Bekämpfung von KI-Halluzinationen, sondern auch für verschiedene Anwendungen in der realen Welt. Wie in dem Dokument ausführlich beschrieben, könnte dieses System beispielsweise von KI-Assistenten in Restaurants eingesetzt werden, damit diese den Gästen sachliche, verifizierte Informationen liefern und ihre Antworten im Gespräch an die sich entwickelnden Kundenanfragen anpassen können.

Dieser iterative Prozess verbessert die Genauigkeit und Nützlichkeit der Antworten des Sprachmodells, indem die Eingabe und das Feedback kontinuierlich verfeinert werden.

Obwohl es sich derzeit lediglich um ein Patent handelt, deuten die besprochenen Konzepte darauf hin, dass Microsoft daran interessiert ist, die Funktionalität und Zuverlässigkeit seiner KI-Modelle, wie beispielsweise Copilot, zu verbessern.

Der Technologieriese hat bereits seine Ambition zum Ausdruck gebracht, sich mit Halluzinationen in KI-Modellen zu befassen und diese zu eliminieren, und verweist auf eine Zukunft, in der in Funktionen wie der Restaurantassistenz zuverlässig genaue Informationen generiert werden können.

Mit Strategien zur Vermeidung von Halluzinationen könnten KI-Modelle genaue Antworten liefern, ohne auf falsche Informationen zurückzugreifen. In Kombination mit den Sprachfunktionen des neuesten Copiloten könnte KI Einstiegsjobs wie automatisierte Kundensupportsysteme ersetzen.

Was denken Sie über diese Entwicklung?

Sie können das vollständige Dokument hier einsehen .

Schreibe einen Kommentar