Übersicht über den erweiterten Sprachmodus von ChatGPT: Erwartungen vs. Realität

Die wichtigsten Erkenntnisse

- Dem erweiterten Sprachmodus von ChatGPT fehlen mehrere wichtige Funktionen, darunter die multimodale Funktionalität und eine Hold-to-Speak-Funktion, was ihn aufgrund übermäßiger Zensur manchmal unbrauchbar machen kann.

- Allerdings verfügt er über eine beeindruckende Ausdruckskraft und kann mehrere Sprachen, Akzente und regionale Dialekte sprechen, allerdings kann er nicht singen, summen oder flirten (wie von OpenAI vorgegeben).

- Für Gratisnutzer ist die Chat-Funktion nur 15 Minuten im Monat verfügbar, für Plus-Nutzer gilt ein striktes tägliches Limit von 1 Stunde.

Nach der ersten Demonstration war die Begeisterung über den erweiterten Sprachmodus von ChatGPT spürbar. Nach verschiedenen rechtlichen Herausforderungen und den darauf folgenden Verzögerungen ist die Funktion jedoch immer noch erheblich eingeschränkt, es fehlen wichtige Funktionen und es gibt einige Missverständnisse, die das erwartete Erlebnis beeinträchtigen.

Obwohl OpenAI nur begrenzt Zeit für tägliche Interaktionen bietet, können sich Benutzer ein gutes Bild von dessen Stärken, Schwächen und Möglichkeiten machen. Hier sind meine ehrlichen Eindrücke vom erweiterten Sprachmodus von ChatGPT, in denen ich seine Vorzüge und Nachteile hervorhebe und erkläre, warum die Vision eines charismatischen Sprachassistenten noch weit entfernt sein könnte.

Universeller Zugriff auf den erweiterten Sprachmodus, aber es fehlen wichtige Funktionen

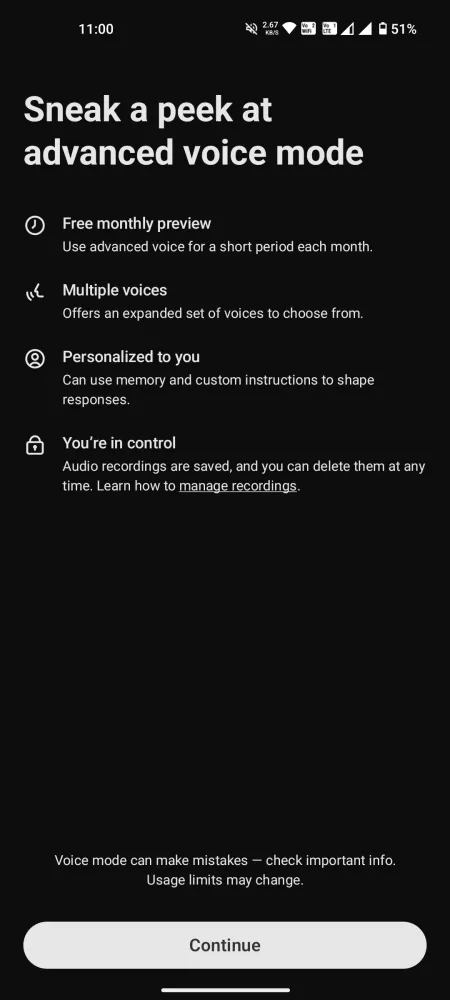

Die Einführung des erweiterten Sprachmodus in der ChatGPT-Mobilanwendung ermöglicht es nun allen Benutzern, dieses innovative Voice-to-Voice-Modell zu nutzen. Kostenlose Konten sind auf 15 Minuten Nutzung pro Monat beschränkt , während Plus-Benutzer täglich etwa eine Stunde nutzen können , wobei je nach Serververfügbarkeit unterschiedliche tägliche Limits gelten. Sobald Sie diese Zeit erreicht haben, ist ein Wechsel zum weniger spannenden Standard-Sprachmodus erforderlich.

Bevor Sie sich in ein Gespräch stürzen, sollten Sie Ihre Erwartungen im Zaum halten. Viele der in der Vorschau beworbenen Funktionen sind derzeit weder für kostenlose noch für Plus-Konten verfügbar. Der erweiterte Sprachmodus ist derzeit nicht multimodal und kann weder Geräusche interpretieren noch Bilder und Videos analysieren. Er kann weder aus physischen Büchern vorlesen noch Gesten erkennen, z. B. ob Sie einen Finger hochhalten, noch kann er singen oder Musikinstrumente wie eine Gitarre erkennen. Zahlreiche versprochene Funktionen fehlen noch immer.

Vorteile des erweiterten Sprachmodus

Auch wenn der erweiterte Sprachmodus von ChatGPT möglicherweise nicht alle Erwartungen erfüllt, ist er in bestimmten Bereichen erfolgreich. Hier sind einige bemerkenswerte positive Aspekte:

Vielfältige Sprachoptionen, aber kein Sky

Den Benutzern steht eine Auswahl von neun verschiedenen Stimmen zur Verfügung:

- Sol (F) – Entspannt und clever

- Ember (M) – Optimistisch und zuversichtlich

- Arbor (M) – Vielseitig und unkompliziert

- Vale (F) – Neugierig und aufgeweckt

- Maple (F) – Offen und fröhlich

- Wacholder (F) – Optimistisch und offen

- Cove (M) – Direkt und gelassen

- Fichte (M) – Bejahend und ruhig

- Breeze (M/W) – Ernst und lebhaft

In diesem Mix fehlt Sky, aber die anderen Stimmen sind klangvoll und einnehmend. Es scheint, dass Sky keine Option mehr ist, also machen wir weiter.

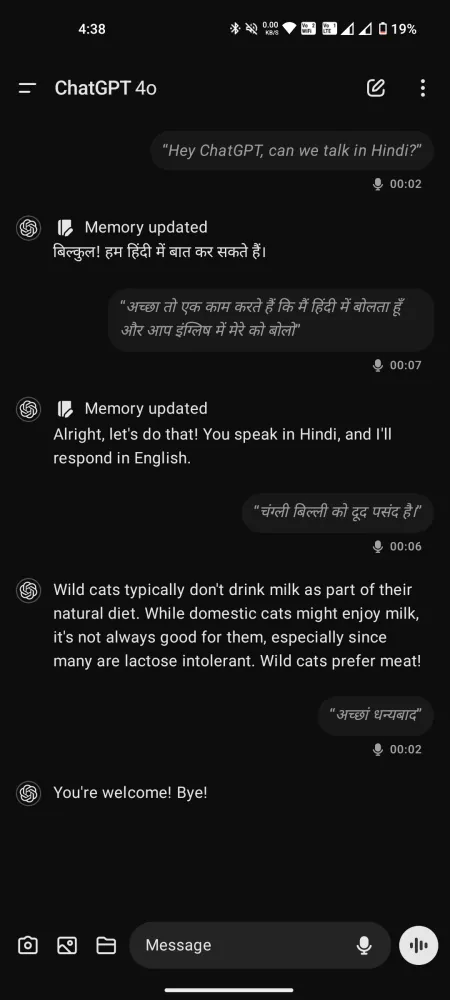

Ein mehrsprachiger Gesprächspartner mit Ausdruck

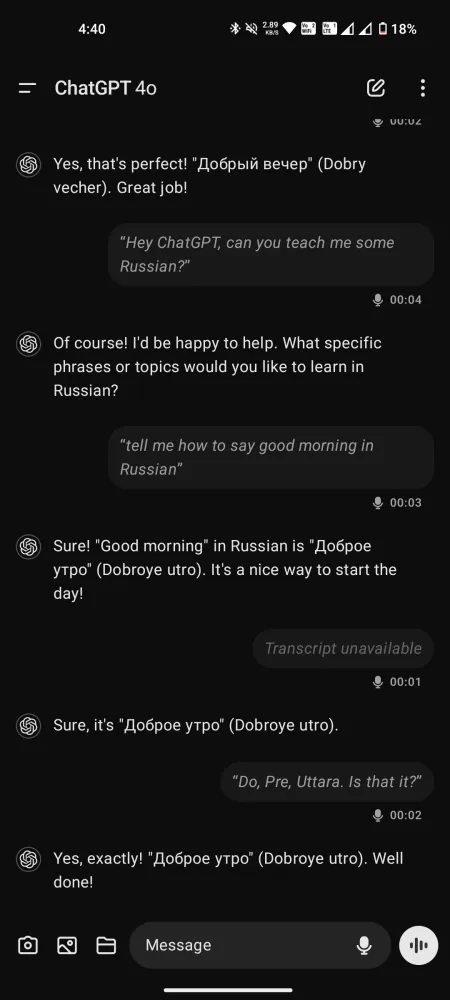

Trotz aller Kritik am erweiterten Sprachmodus kann seine Leistung nicht hoch genug eingeschätzt werden – insbesondere im Vergleich zum Standardmodus, in dem es nur minimale Latenz für flüssige Gespräche gibt. Da es über 50 Sprachen versteht und spricht, eignet es sich sogar gut als Sprachtrainer, Übersetzer oder Sprachlehrer.

Auch wenn die Sprachausgabe keine Stimmen imitiert, kann sie auf Anfrage verschiedene Akzente aufweisen und so eine Reihe von Dialekten abdecken, vom Südstaaten-Dialekt bis zum britischen Cockney-Dialekt und alles dazwischen.

Im Vergleich zu Gemini Live wirken die Interaktionen mit diesen Stimmen weniger hastig, wodurch ein aufmerksameres und unterstützenderes Erlebnis entsteht.

Versteht ChatGPT Emotionen?

Darüber lässt sich streiten. Während OpenAI behauptet, dass ChatGPT den Tonfall und die Emotionen des Sprechers wahrnehmen kann, gehen die Meinungen der Benutzer auseinander. Einige glauben, dass es diese Aspekte wirklich versteht, während andere argumentieren, dass es den Tonfall lediglich anhand der Wortwahl und Kontexthinweisen ableitet.

Ein Benutzer schlug vor, dass gesprochene Wörter nicht direkt für GPT-4o transkribiert werden, sondern dass Audio vor der Verarbeitung in Text umgewandelt wird. Dies bedeutet, dass Tonfall und Emotionen, die durch Stimm- oder Atemmuster vermittelt werden, möglicherweise nicht gut in Textform übertragen werden.

Da der erweiterte Sprachmodus GPT-4 nutzen kann, das Text-zu-Sprache, aber nicht Sprache-zu-Sprache verarbeitet, gibt es zudem Zweifel daran, ob ChatGPT emotionale Nuancen wirklich erfasst. Andere behaupten jedoch, dass es ein gewisses Verständnis zeigt. Es scheint, dass dieses Thema noch für weitere Untersuchungen offen ist.

Einschränkungen des erweiterten Sprachmodus von ChatGPT

Kommen wir nun zur Sache. So ansprechend das Konzept auch klingen mag, unsere tatsächlichen Erfahrungen damit offenbaren erhebliche Mängel. Hier ist eine Aufschlüsselung.

Übermäßige Zensur und Einschränkungen

Wie viele KI-Chatbots neigt ChatGPT dazu, auf Nummer sicher zu gehen, was manchmal zu übermäßiger Zensur führen kann. Obwohl es ratsam ist, der KI nicht zu erlauben, Meinungen zu bilden oder aufrührerische Kommentare abzugeben, sind die Sicherheitsvorkehrungen so restriktiv, dass der erweiterte Sprachmodus möglicherweise sogar die Beantwortung grundlegender Anfragen ablehnt.

Während Neulinge diese Probleme vielleicht nicht sofort haben, werden Plus-Benutzer mit längerer Chatzeit wahrscheinlich regelmäßig mit solchen Ablehnungen konfrontiert. Es ist frustrierend zu wissen, dass Ihre Anfragen abgelehnt werden könnten und Sie ohne die gewünschte Antwort dastehen.

Unglaublich niedrige Unterbrechungsschwelle

Vielen Benutzern ist aufgefallen, dass die Unterbrechungsschwelle des Modells überraschend niedrig ist. Selbst kurze Pausen lassen ChatGPT annehmen, dass es jetzt „an der Reihe“ ist, zu antworten. Wenn Sie länger als eine Sekunde pausieren, wird es einspringen. Dieser Designfehler kann tiefergehende Gespräche behindern, da wir alle einen Moment zum Nachdenken brauchen, bevor wir antworten.

Wenn Sie Ihre Fragen immer wieder unterbrechen und umformulieren müssen, kann das Ihren Denkprozess stören und zu oberflächlichen Dialogen führen. Dies könnte leicht durch die Integration einer Hold-to-Speak-Funktion gelöst werden.

Leider fehlt die im Standardmodus vorhandene Option „Halten zum Sprechen“ in der erweiterten Variante. Benutzer haben nur Zugriff auf die Schaltflächen „Stumm“ und „Anruf beenden“. Ohne die Möglichkeit, zum längeren Nachdenken innezuhalten, werden Ihre Anfragen möglicherweise vorzeitig unterbrochen.

Im Vergleich zu komplexeren Problemen wie Inhaltsbeschränkungen scheint dieser Aspekt leichter zu lösen. Das einfache Hinzufügen einer Hold-to-Speak-Option könnte das Benutzererlebnis erheblich verbessern.

Der Zugriff auf das Transkript hat seine Vorteile, aber einige Antworten können ausgelassen werden, obwohl ChatGPT die Frage verstanden und eine Antwort angeboten hat.

Andere unheimliche und unerklärliche Anomalien

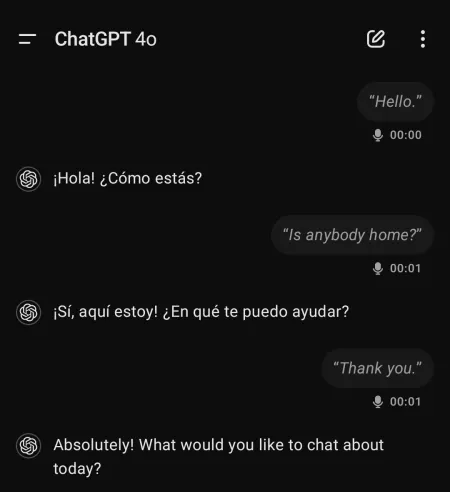

Benutzer haben von seltsamen und manchmal beunruhigenden Erfahrungen bei der Verwendung des erweiterten Sprachmodus von ChatGPT berichtet. Beispielsweise hat das Modell Gespräche auf Spanisch begonnen, ohne dass zuvor Interaktionen in dieser Sprache stattgefunden hätten.

Ein Benutzer erwähnte Erfahrungen, bei denen ChatGPT „aus dem Nichts schrie“ oder zeitweise einen Roboterton und eine völlig andere Stimme anzeigte.

Diese Vorkommnisse können auf Halluzinationen im Stimmmodell zurückzuführen sein oder auf etwas insgesamt Beunruhigendes hinweisen. Unabhängig davon erfordert die Situation Aufmerksamkeit.

Abschließende Gedanken

Trotz seiner verspäteten Einführung dient der ChatGPT Advanced Voice Mode derzeit nicht als praktische Lösung für alltägliche Interaktionen. Vielmehr fühlt er sich wie ein aufwändiges KI-Experiment mit erheblichem ungenutztem Potenzial an.

Aufgrund von Themenbeschränkungen und anderen Einschränkungen befindet sich der erweiterte Sprachmodus noch in der vorläufigen Entwicklungsphase und verfügt nicht über viele der Funktionen, die bei der Werbeeinführung vorgestellt wurden.

Bedenken, dass Benutzer eine emotionale Bindung zu KI-Stimmen entwickeln könnten, mögen zwar berechtigt gewesen sein, aber OpenAI überschätzt möglicherweise die aktuellen Möglichkeiten. Verbesserungen der Benutzeroberfläche und Chat-Einschränkungen können das Erlebnis sicherlich deutlich verbessern.

Im Moment gibt es wenig, was den Advanced Voice Mode von seinen Konkurrenten unterscheidet. Wenn überhaupt, bleibt er hinter Gemini Live zurück, das trotz seiner Probleme für alle zugänglicher bleibt.

Schreibe einen Kommentar