Die besten kostenlosen Methoden zum Erstellen von KI-Bildern mit stabiler Diffusion

Wollten Sie schon immer KI-Bilder erstellen, ohne auf Online-Tools zurückzugreifen? Viele kostenlose Online-Bildgeneratoren beschränken die Anzahl der Ausgaben und erfordern oft schon nach wenigen Versuchen ein Abonnement. Wir stellen Stable Diffusion vor: einen kostenlosen und quelloffenen KI-Bildgenerator, mit dem Sie zu Hause ohne Einschränkungen Bilder erstellen können.

Was ist stabile Diffusion?

Stable Diffusion ist ein kostenloses Open-Source-Framework, das Text auf der Grundlage Ihrer Beschreibungen in visuelle Bilder umwandelt. Obwohl es keine eigenständige Anwendung ist, dient es als Schlüsseltechnologie, die von verschiedenen Anwendungen genutzt wird. Wenn es um generative KI zur Bilderzeugung geht, bleibt Stable Diffusion einer der Top-Anwärter. Dieser Leitfaden beleuchtet drei Ansätze zur Nutzung von Stable Diffusion, von anfängerfreundlich bis komplexer, mit einzigartigen Funktionen innerhalb jeder Methode.

Systemanforderungen

Hier sind die empfohlenen Spezifikationen für ein erfolgreiches Erlebnis:

- macOS: Apple Silicon (Chip der M-Serie)

- Windows oder Linux: NVIDIA- oder AMD-GPU

- RAM: 16 GB für optimale Leistung

- GPU VRAM: mindestens 4 GB (8 GB bevorzugt)

- Speicher: 60–70 GB freier Speicherplatz

1. Verwenden der Automatic1111-WebUI

Der erste Ansatz beinhaltet die Verwendung der AUTOMATIC1111-Web-Benutzeroberfläche für den Zugriff auf Stable Diffusion, die mit allen gängigen Betriebssystemen kompatibel ist.

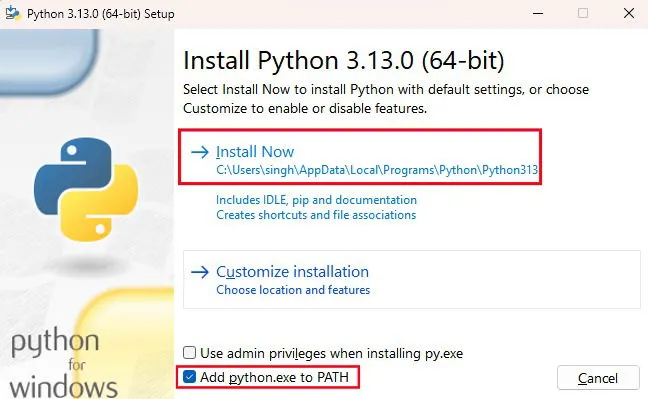

Beginnen Sie mit dem Herunterladen der neuesten stabilen Version von Python . Führen Sie nach dem Herunterladen das Installationsprogramm aus und achten Sie darauf, dass Sie „python.exe zu PATH hinzufügen“ auswählen , bevor Sie auf „Jetzt installieren“ klicken .

Gehen Sie als Nächstes zum AUTOMATIC1111 Web UI-Repository auf GitHub, klicken Sie auf Code und wählen Sie ZIP herunterladen . Sobald der Download abgeschlossen ist, entpacken Sie die Datei und merken Sie sich den Speicherort, an dem die WebUI installiert wurde.

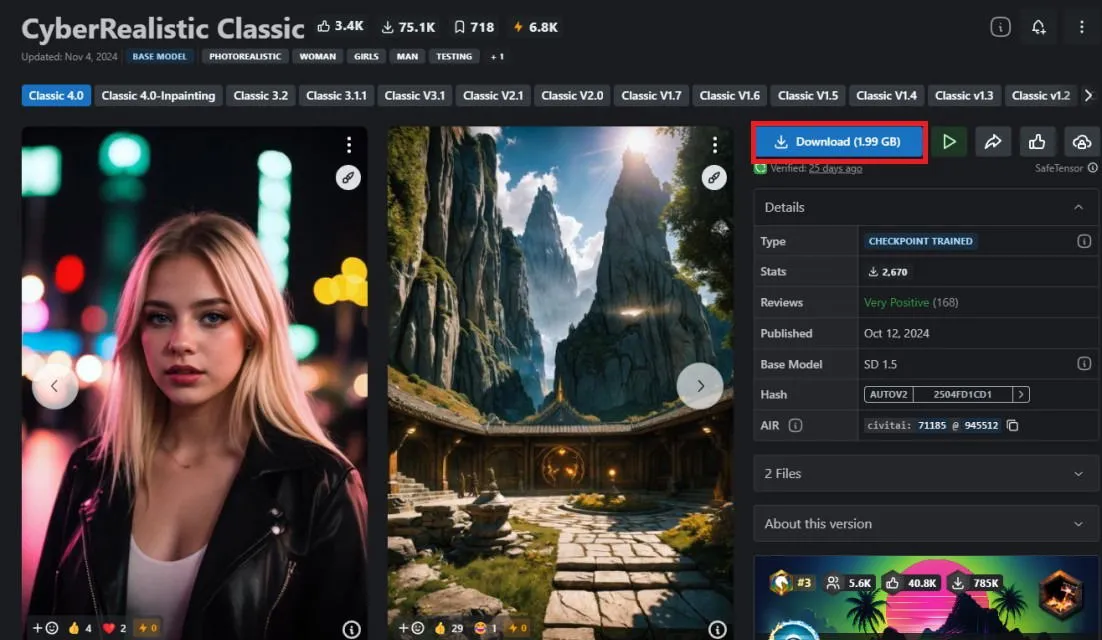

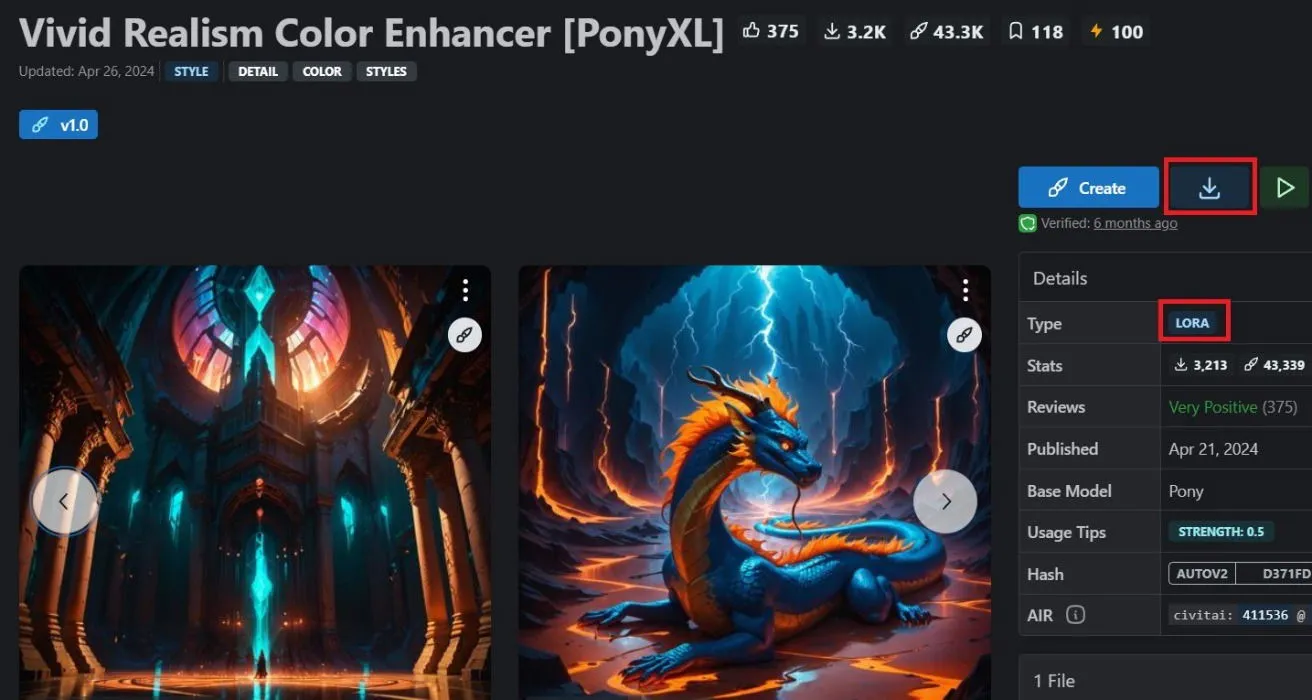

Installieren eines Modells

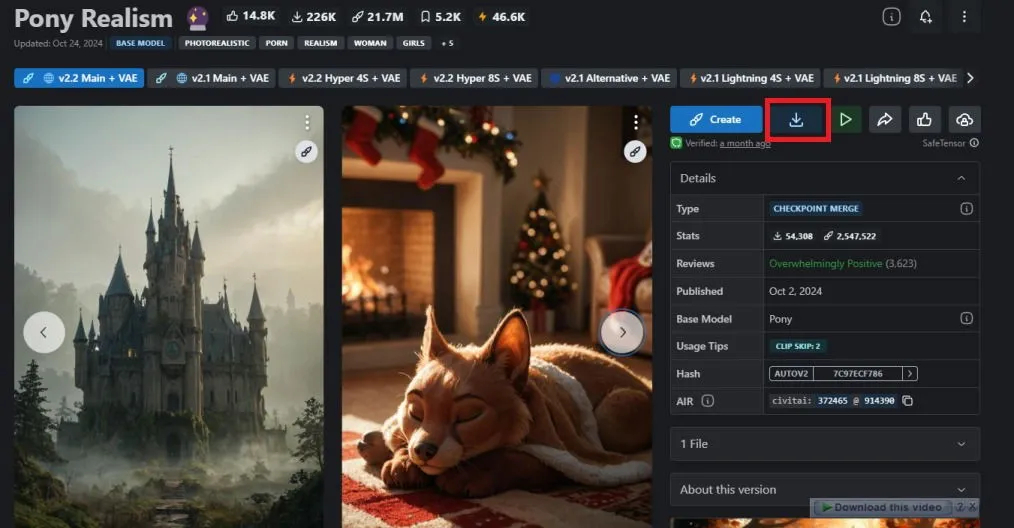

Bevor Sie die Web-Benutzeroberfläche verwenden können, müssen Sie mindestens ein Modell installieren. Diese Modelle sind vorab trainierte Kontrollpunkte, die den künstlerischen Stil für die Bildgenerierung bestimmen. Um ein Modell auszuwählen, besuchen Sie CIVITAI und wählen Sie das Modell aus, das Ihnen gefällt.

Nachdem Sie Ihr bevorzugtes Modell gefunden haben, klicken Sie auf die Download-Schaltfläche. Sobald dies abgeschlossen ist, übertragen Sie die Prüfpunktdatei „.safetensors“ in den richtigen Ordner. Navigieren Sie zum Download-Verzeichnis für Ihre Automatic1111-WebUI und wechseln Sie dann zu webui -> models -> Stable-diffusion . Fügen Sie die heruntergeladene Modelldatei in dieses Verzeichnis ein, und schon kann es losgehen.

Ausführen und Konfigurieren der WebUI

Jetzt können Sie Stable Diffusion direkt in Ihrem Webbrowser ausführen und verwenden.

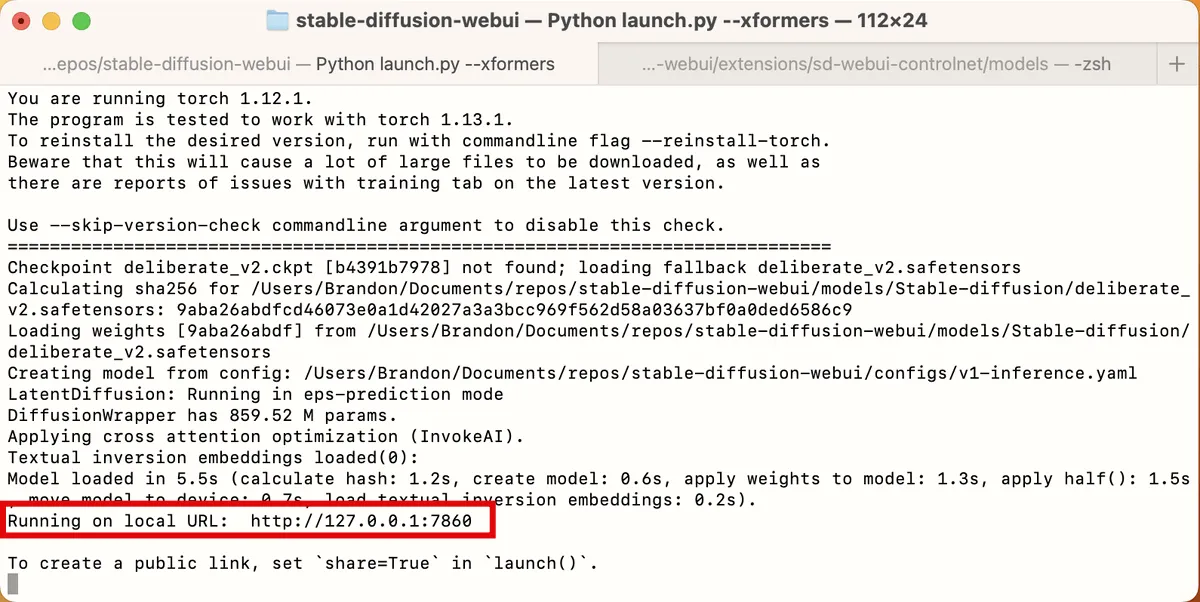

Unter macOS greifen Sie über Terminal auf Ihren Ordner „stable-diffusion-webui“ zu und führen den Befehl aus ./webui.sh --xformers. Windows-Benutzer führen den Befehl aus ./webui-user.bat. Kopieren Sie anschließend die URL neben „Wird unter lokaler URL ausgeführt“, die normalerweise als http://127.0.0.1:7860 angezeigt wird .

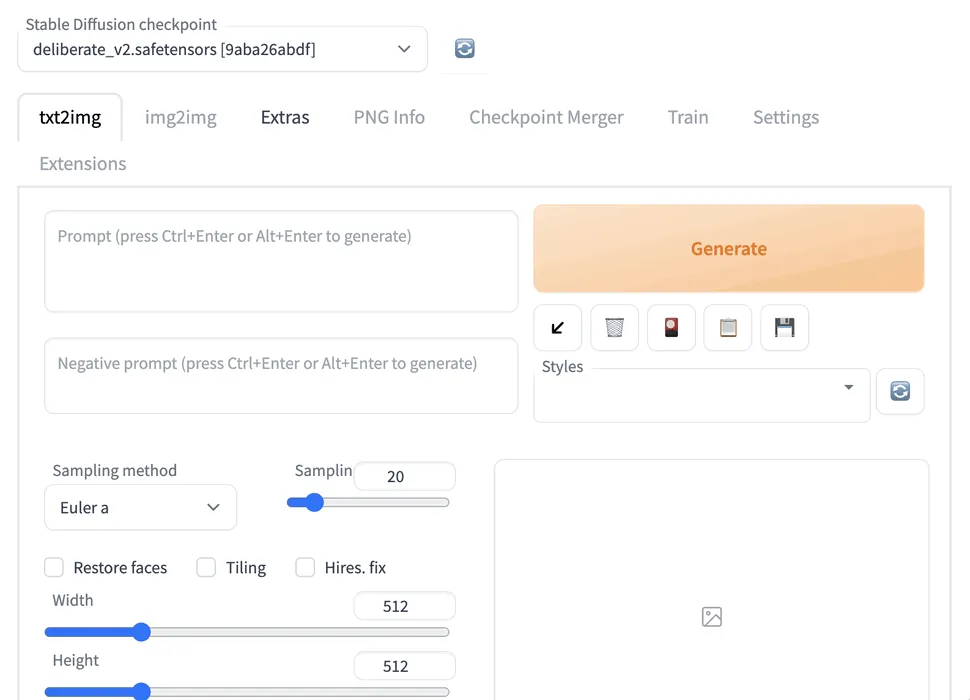

Geben Sie die URL in die Adressleiste Ihres Browsers ein und drücken Sie Enter. Die Web-Benutzeroberfläche wird lokal in Ihrem Standard-Internetbrowser geladen. Obwohl die anfängliche Benutzeroberfläche überwältigend erscheinen kann, müssen Sie zunächst nicht viele Einstellungen anpassen.

Passen Sie zunächst die Parameter „Breite“ und „Höhe“ an und stellen Sie die Stapelgröße auf 4 ein. Dadurch werden für jede Eingabeaufforderung vier unterschiedliche Bilder generiert.

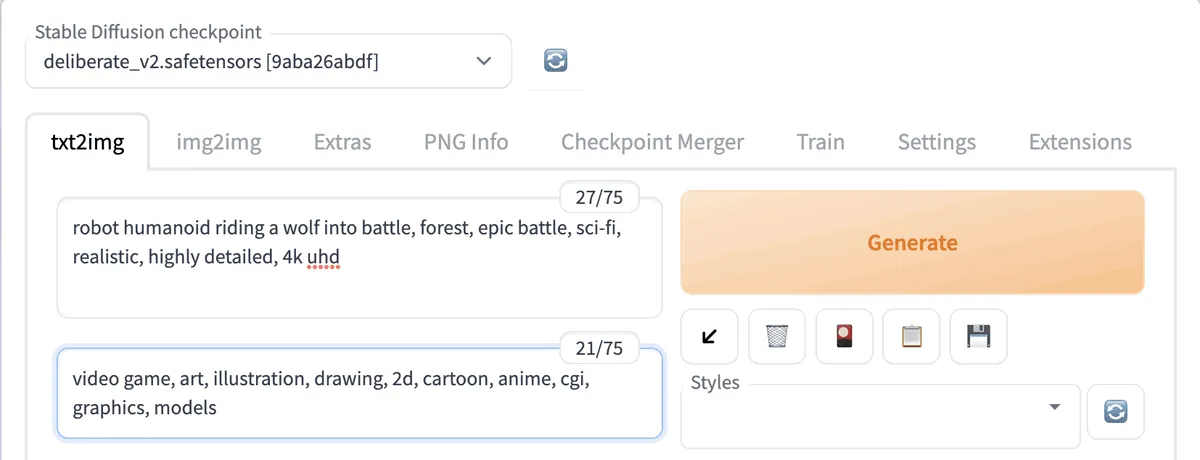

Geben Sie als Nächstes einen beliebigen kreativen Hinweis in die Registerkarte „txt2img“ ein . Geben Sie genau an, welche Details Sie im Bild haben möchten, und trennen Sie die einzelnen Beschreibungen durch Kommas. Beschreiben Sie außerdem den künstlerischen Stil mit Begriffen wie „realistisch“, „detailliert“ oder „Porträt im Nahbereich“.

Geben Sie in das Feld für negative Eingabeaufforderungen alle Elemente ein, die Sie aus Ihrem Bild ausschließen möchten. Erwägen Sie eine Änderung der Einstellung „CFG-Skala“. Ein höherer Wert bewirkt, dass sich der Generator genauer an Ihre Eingabeaufforderungen hält, während ein niedrigerer Wert kreativere Ergebnisse ermöglicht.

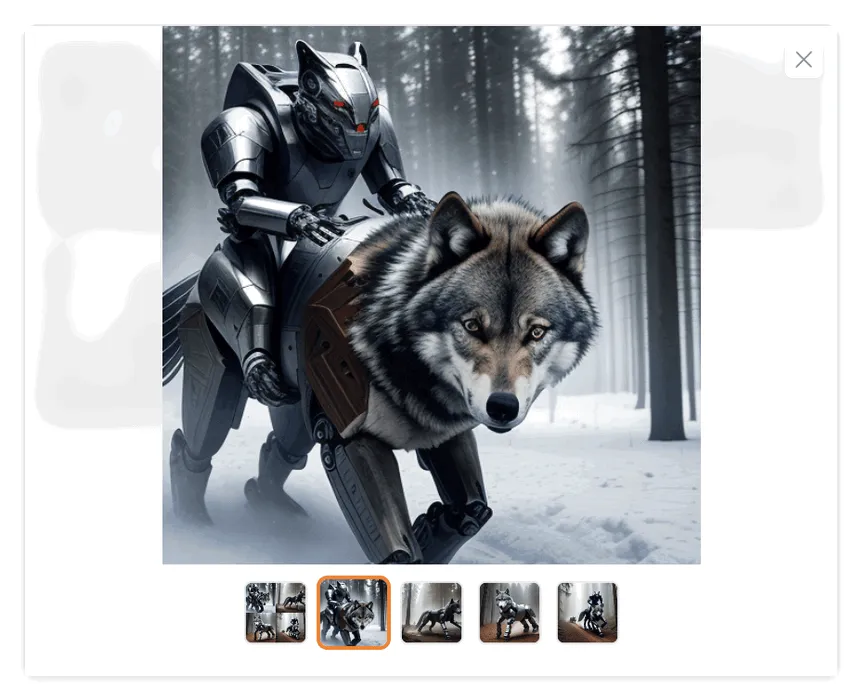

Lassen Sie die restlichen Einstellungen unverändert und klicken Sie oben auf „Generieren“ , um den Bildgenerierungsprozess zu starten. Anschließend können Sie auf die Miniaturbilder klicken, um sie anzuzeigen und zu entscheiden, ob sie Ihren Erwartungen entsprechen. Wenn dies nicht der Fall ist, können Sie die CFG-Skala und Ihre Eingabeaufforderungen anpassen. Während dieser Phase wird Ihre GPU stark beansprucht.

Wenn Sie ein Bild finden, das Ihnen gefällt, das Sie aber verbessern oder Probleme (wie verzerrte Details) beheben möchten, klicken Sie auf An img2img senden oder An inpaint senden . Mit dieser Option werden Ihr Bild und die Eingabeaufforderungen zur weiteren Verbesserung auf die entsprechenden Registerkarten übertragen.

2. Fooocus erkunden: Der einfachste KI-Bildgenerator

Fooocus ist eines der einfachsten und effektivsten KI-Bildgenerierungstools auf dem Markt. Seine intuitive Benutzeroberfläche macht es für Anfänger zugänglich, die mit der KI-Bildgenerierung experimentieren möchten, bevor sie sich in komplexere Methoden vertiefen.

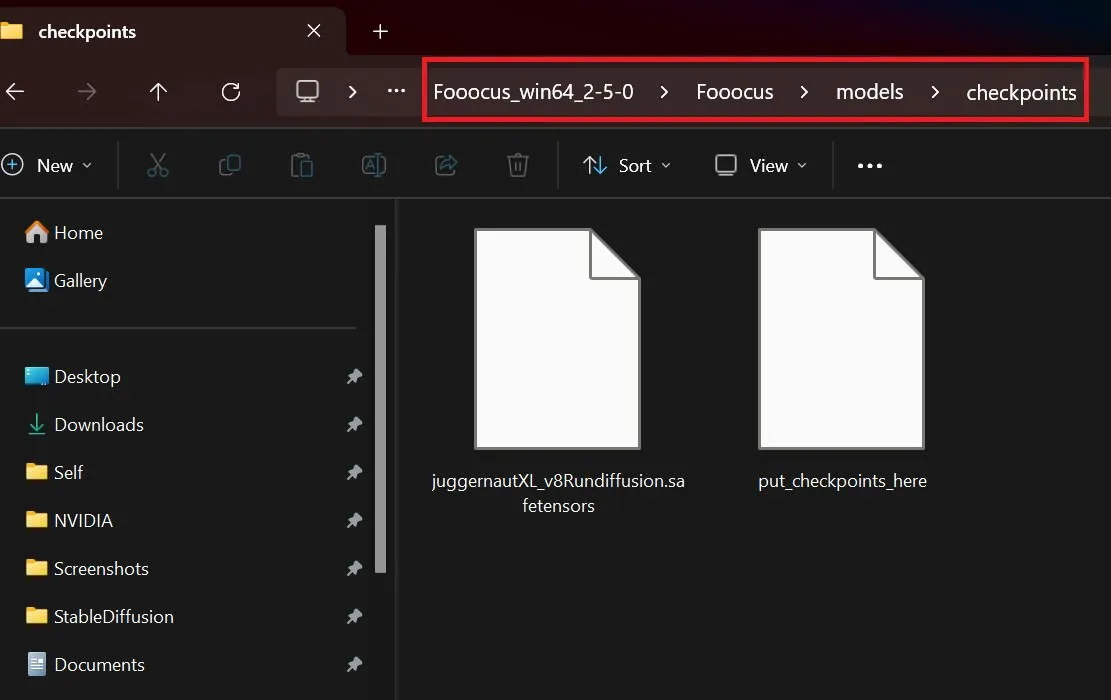

Laden Sie die komprimierte Fooocus-Datei herunter und extrahieren Sie sie, sobald der Download abgeschlossen ist. Gehen Sie anschließend zu CIVITAI, um einen gewünschten Prüfpunkt auszuwählen. Navigieren Sie nach dem Herunterladen des Prüfpunkts zu Ihrem Fooocus-Ordner. Klicken Sie auf Fooocus -> Modelle -> Prüfpunkte und platzieren Sie die heruntergeladene Prüfpunktdatei dort.

Sie können auch LoRAs von Civitai herunterladen. Dabei handelt es sich um kleinere Dateien, die große Sprachmodelle um neue Konzepte oder Stile erweitern. Im Gegensatz zu Checkpoints, die mehrere Gigabyte groß sein können, fügen LoRAs den endgültigen Bildern unter Verwendung eines vorhandenen Checkpoints unverwechselbare Elemente hinzu.

Wenn Sie ein LoRA verwenden möchten, um den visuellen Stil Ihrer KI-Bilder zu verbessern, kehren Sie zum Ordner „Models“ in Ihrem Fooocus-Verzeichnis zurück und fügen Sie die LoRA-Datei in den Ordner „Loras“ ein .

Laufender Fooocus

Jetzt können Sie mit der Bildgenerierung in Fooocus beginnen. Navigieren Sie zu dem Ordner, in den Sie die Software extrahiert haben, und doppelklicken Sie auf run.bat . Die Eingabeaufforderung wird angezeigt und lädt automatisch die Fooocus-Oberfläche in Ihren Webbrowser.

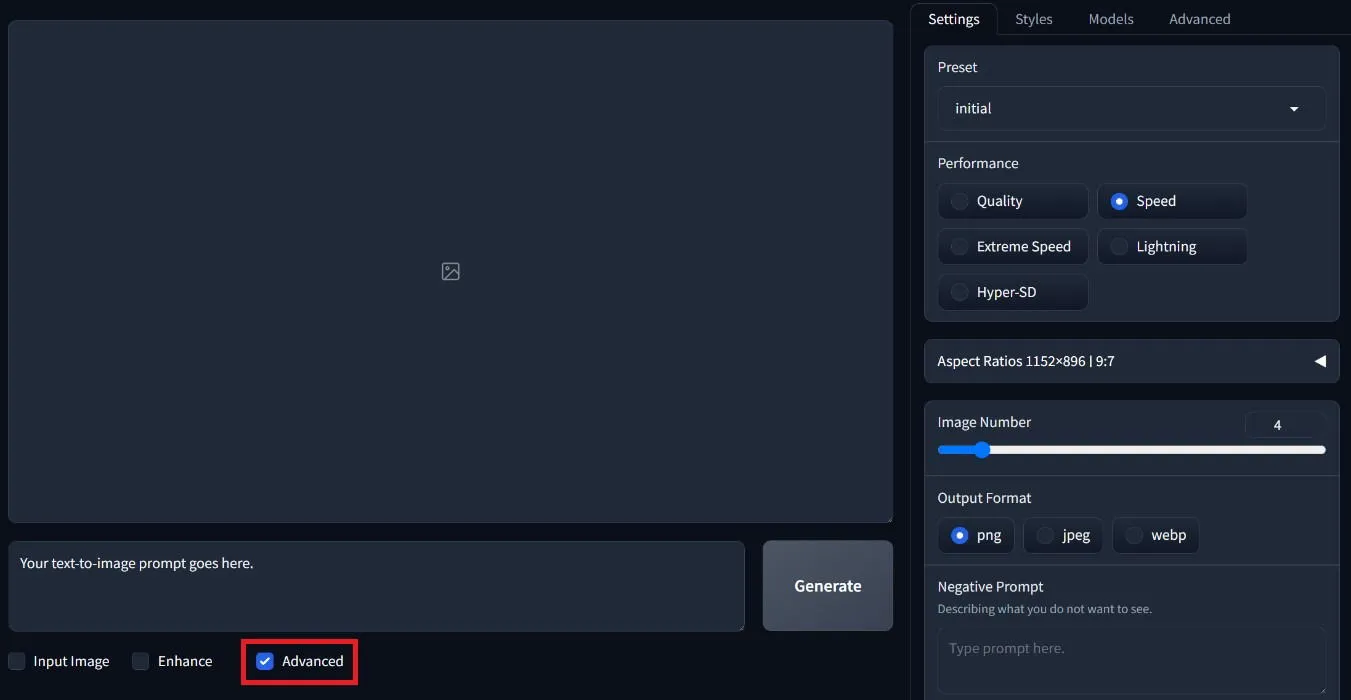

Aktivieren Sie auf dem Startbildschirm unten die Option „Erweitert“ , um weitere Einstellungen anzuzeigen. Hier können Sie das gewünschte Seitenverhältnis, die Anzahl der Bilder, die Fooocus pro Eingabeaufforderung generieren soll, und das Bilddateiformat auswählen.

Stellen Sie die Leistungsoption zunächst auf Geschwindigkeit ein , da dies die Geschwindigkeit der Bildgenerierung erheblich erhöht. Geben Sie unten negative Eingabeaufforderungen für unerwünschte Elemente ein.

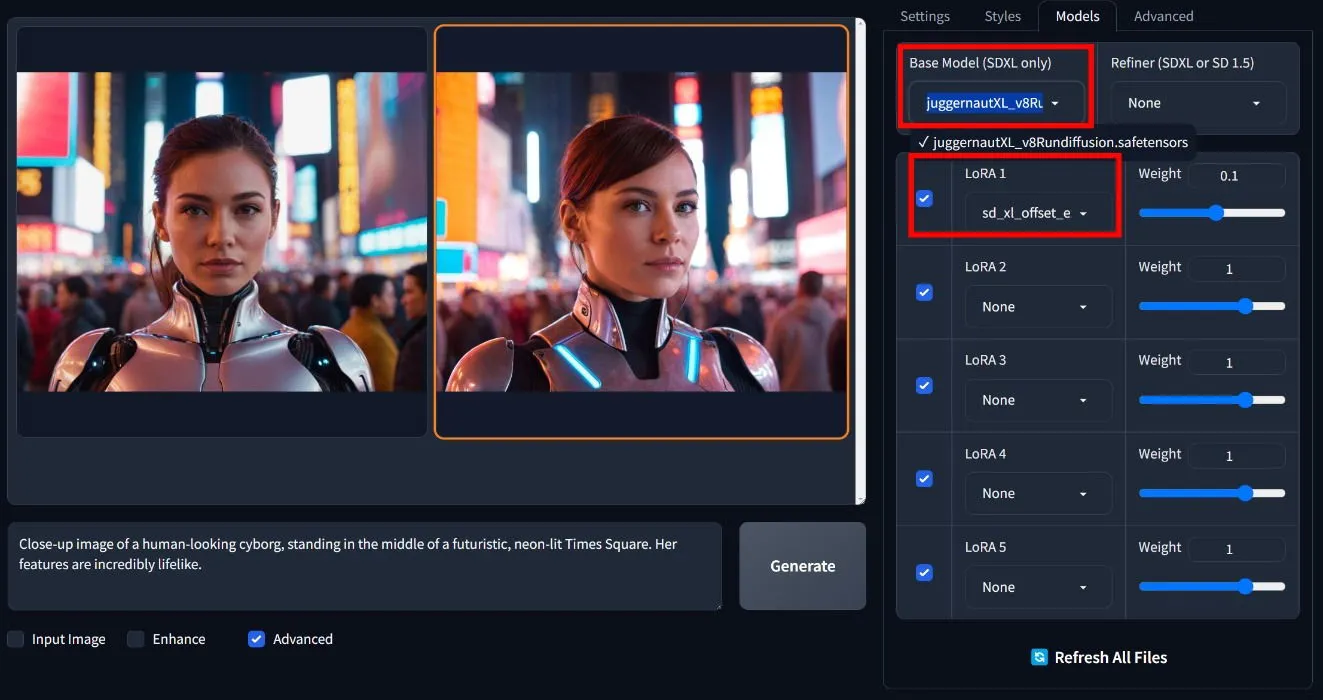

Bewegen Sie den Mauszeiger über jeden Stil, um eine Vorschau anzuzeigen. Navigieren Sie dann zur Registerkarte „Modelle“, wo Sie das Basismodell auswählen können, das Sie in Ihrem Fooocus-Ordner abgelegt haben. Wählen Sie direkt darunter ein LoRA aus, falls Sie eines installiert haben.

Klicken Sie einfach auf die Schaltfläche „Generieren“ und sehen Sie zu, wie Fooocus Ihre gewünschten Bilder erstellt. Es ist zwar nicht der leistungsstärkste Bildgenerator auf dem Markt, aber Fooocus erweist sich mit Sicherheit als die einfachste Methode, da Sie Stile, Prüfpunkte und LoRAs ganz einfach anpassen können, um Ihre idealen Bilder zu erstellen.

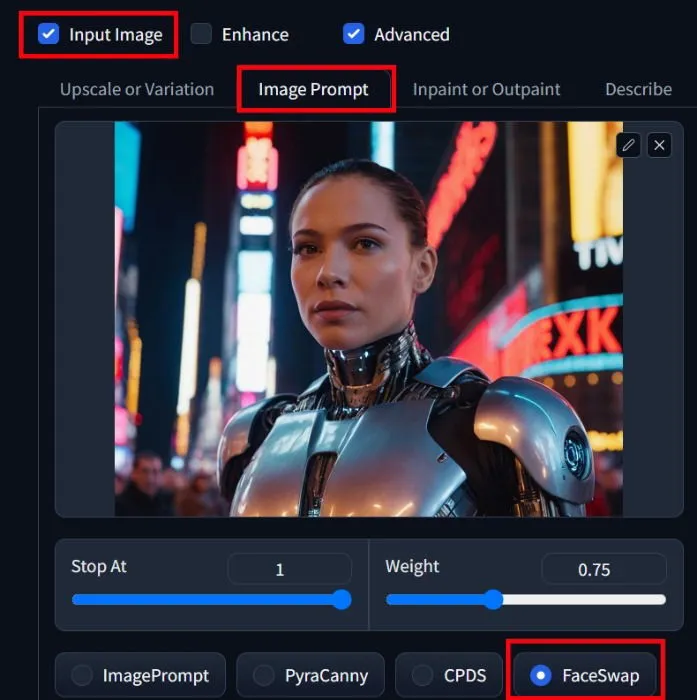

Nutzung von AI Face Swap in Fooocus

Fooocus bietet sogar eine FaceSwap-Funktion, mit der Sie Gesichter in einem Bild durch andere ersetzen können. Aktivieren Sie zunächst die Option „Bild eingeben“ unten und wählen Sie dann „Bildeingabeaufforderung“ . Laden Sie hier das Bild hoch, mit dem Sie das Gesicht austauschen möchten. Scrollen Sie nach unten, klicken Sie erneut auf „Erweitert“ und wählen Sie aus den Optionen „FaceSwap“ aus .

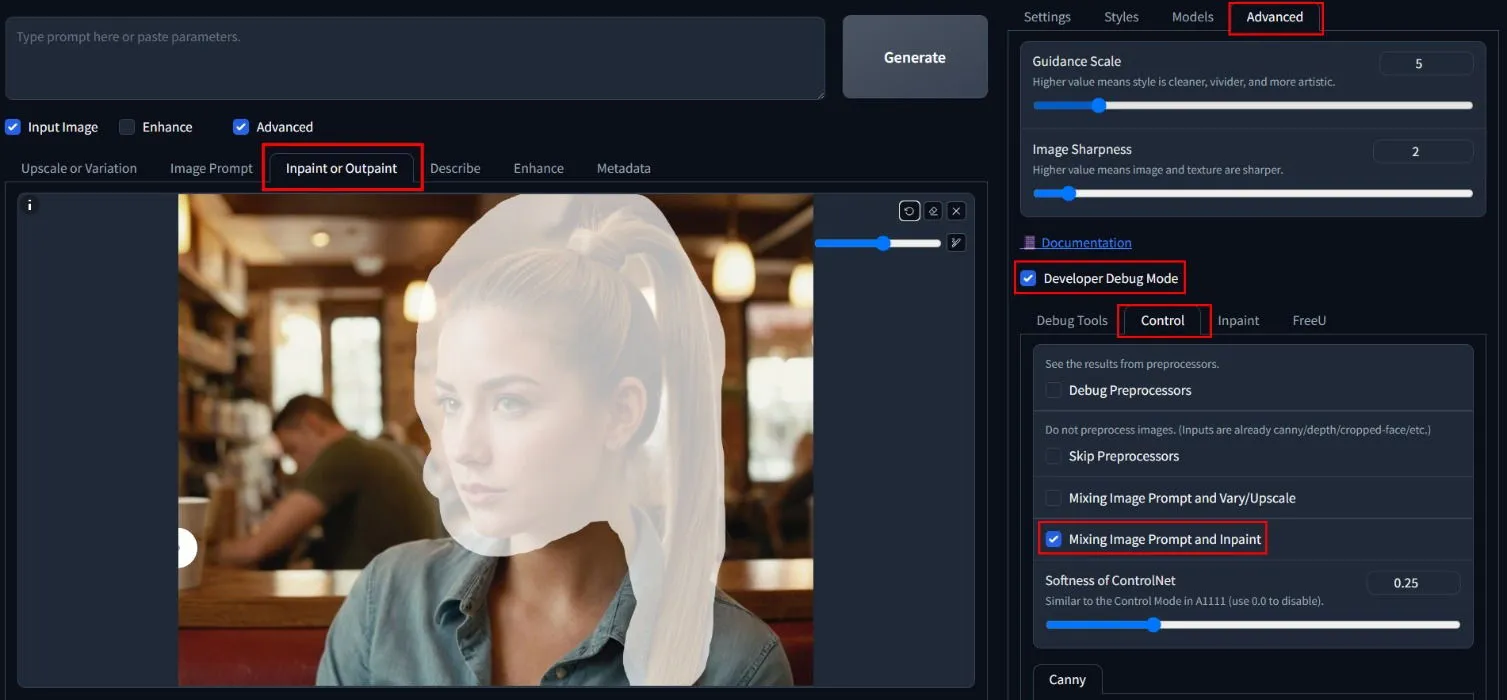

Klicken Sie neben dem Abschnitt „Bildeingabeaufforderung“ auf die Registerkarte „Inpaint“ oder „Outpaint“ und laden Sie das Bild für den Gesichtstausch hoch. Skizzieren Sie Gesicht und Haare und wechseln Sie dann zur Registerkarte „Erweitert“ in der oberen rechten Ecke. Aktivieren Sie den Entwickler-Debugmodus , klicken Sie auf „Steuerung“ und aktivieren Sie das Kontrollkästchen „Bildeingabeaufforderung und Inpaint mischen“ .

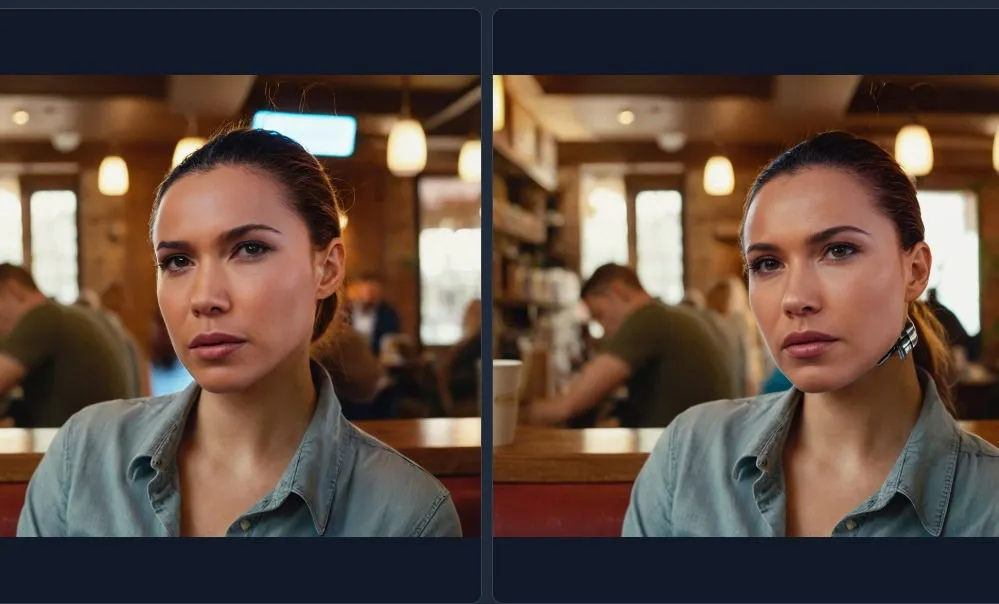

Wenn Sie fertig sind, löschen Sie das Eingabefeld und klicken Sie auf „Generieren“ . Dadurch wird der Gesichtstausch mit Ihrem ausgewählten Bild ausgeführt, was zu unterschiedlichen Ergebnissen führt.

Nachdem Sie Ihre Bilder erstellt haben, möchten Sie sie möglicherweise mit einigen erstklassigen KI-Bildskalierungstools verbessern, um ihre Auflösung zu erhöhen.

3. Generieren von KI-Bildern mit ComfyUI

ComfyUI ist eine weitere beliebte Methode, um Stable Diffusion für die Erstellung von KI-Bildern zu nutzen. Der Workflow ist zwar ansprechender, aber auch komplexer. Laden Sie zunächst ComfyUI von GitHub herunter und extrahieren Sie es .

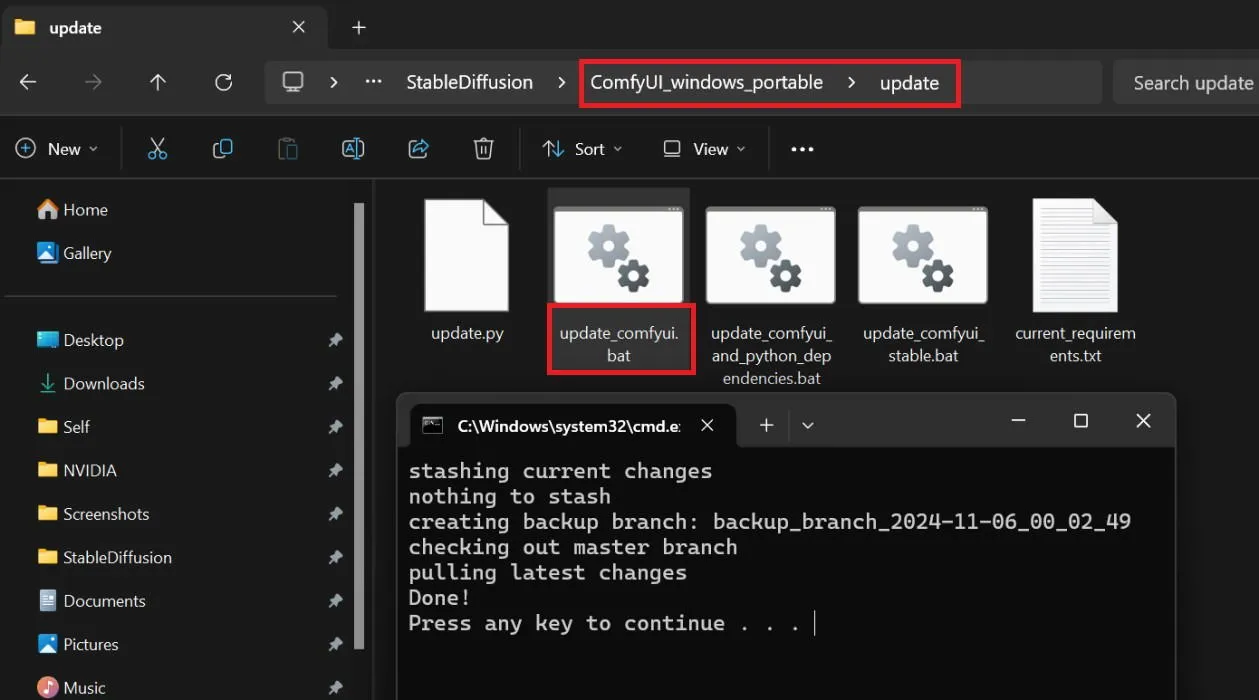

Sie sind an dieser Stelle wahrscheinlich mit Checkpoints und LoRAs vertraut. Laden Sie, wie bereits erwähnt, eine Checkpoint-Datei (und bei Bedarf eine LoRA-Datei) herunter und platzieren Sie sie in den richtigen Ordnern im Verzeichnis „Modelle“ von ComfyUI. Öffnen Sie in Ihrem ComfyUI-Verzeichnis den Ordner „Update“ und führen Sie „update_comfyui.bat“ aus, um das Setup vorzubereiten.

Jetzt ist es an der Zeit, den ComfyUI AI-Bildgenerator auszuführen. Navigieren Sie zurück zu Ihrem ComfyUI-Verzeichnis, wo Sie zwei Batchdateien sehen sollten. Wenn Sie eine Nvidia-GPU haben, doppelklicken Sie auf run_nvidia_gpu.bat ; andernfalls führen Sie run_cpu.bat aus .

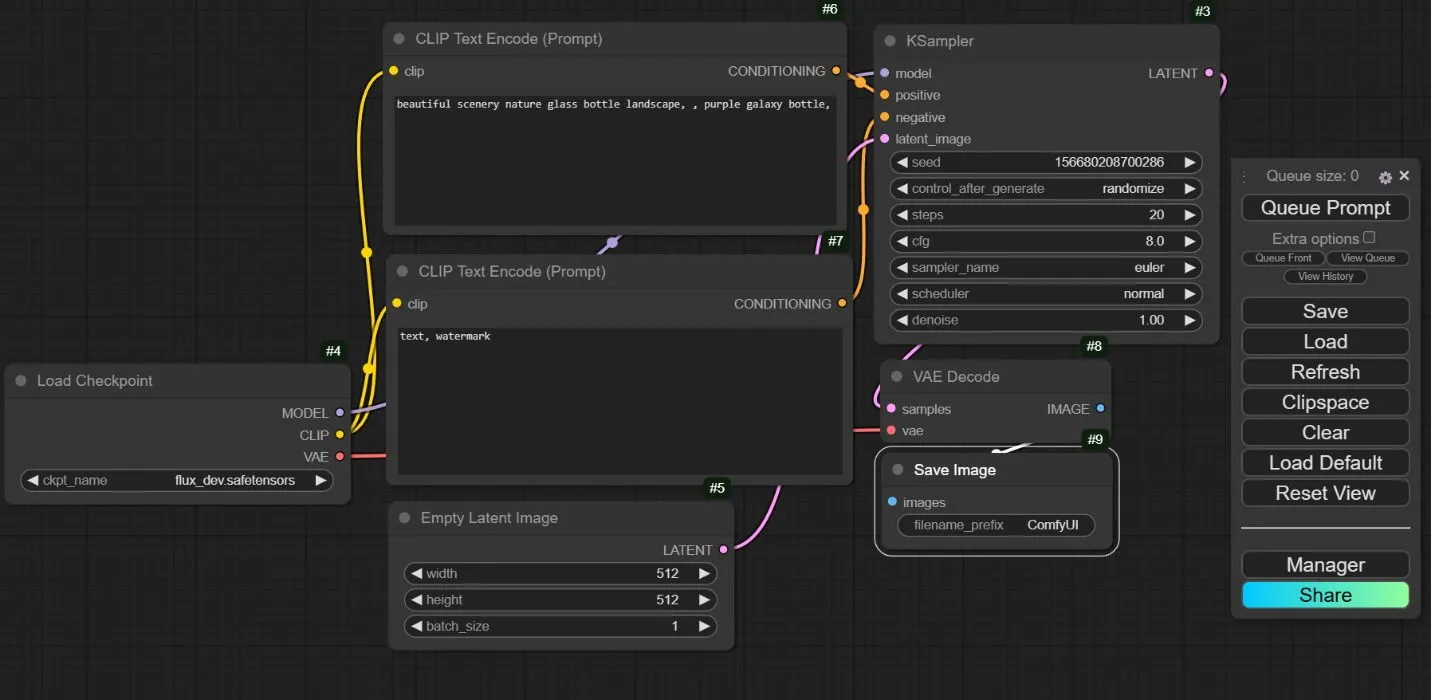

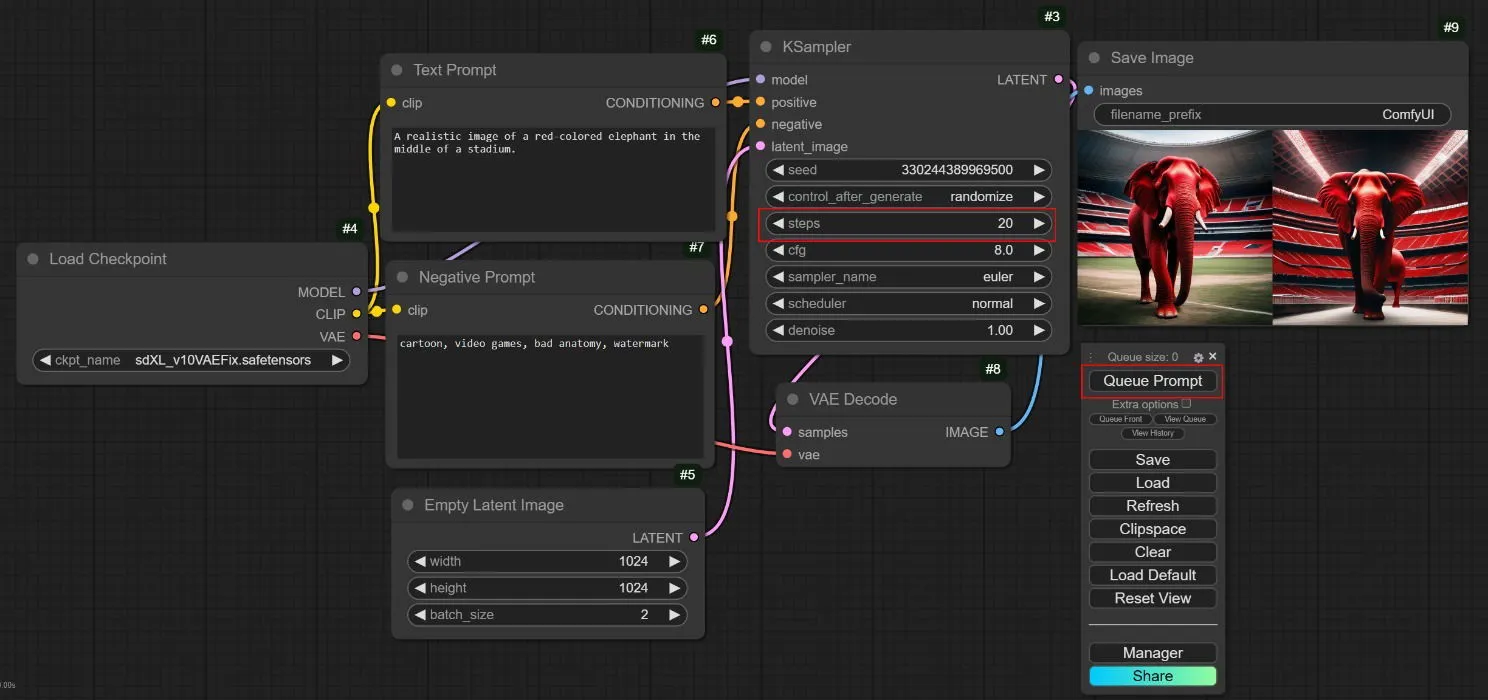

Sobald ComfyUI in Ihrem Browser gestartet ist, sehen Sie den Standard-Workflow, der mehrere miteinander verbundene Knoten umfasst. Obwohl es zunächst komplex aussehen mag, stellen diese Knoten verschiedene Schritte im KI-Bildgenerierungsprozess dar.

Die mehreren Knoten ermöglichen Ihnen die Erstellung eines maßgeschneiderten Workflows, der verschiedene Knoten, Modelle, LoRAs und Refiner integriert und den Benutzern umfassende Kontrolle über die endgültige Ausgabe gewährt. Diese Komplexität kann jedoch dazu führen, dass ComfyUI schwer zu navigieren und zu beherrschen ist.

Ausführen von ComfyUI

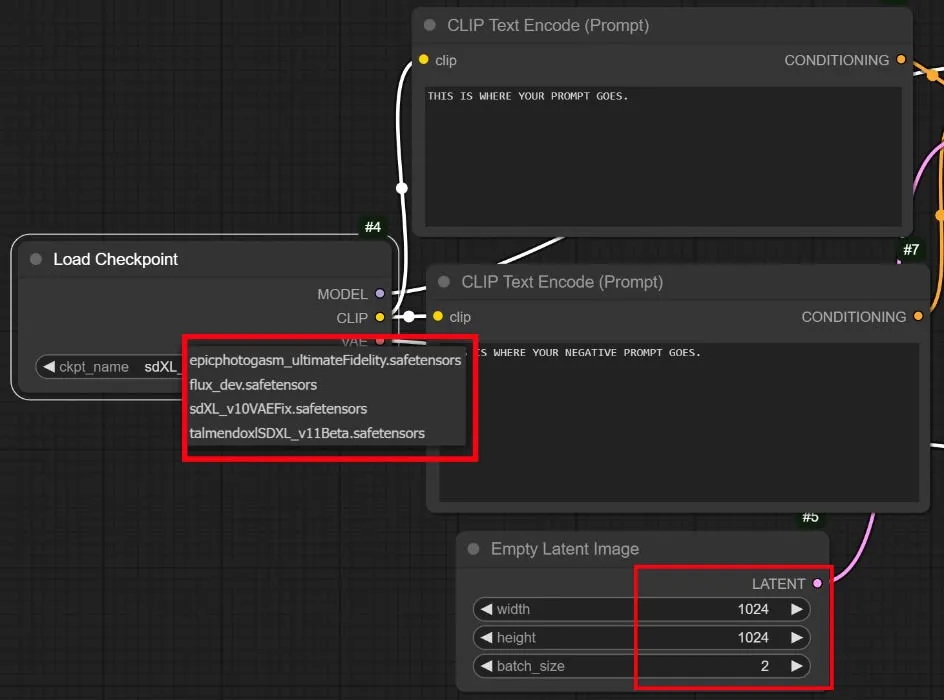

Wählen Sie zunächst einen Prüfpunkt im Knoten „ Prüfpunkt laden“ aus . Fahren Sie mit dem Knoten „CLIP-Textcodierung (Eingabeaufforderung)“ fort , in den Sie Ihre Texteingabeaufforderung für das Bild eingeben. Darunter befindet sich ein entsprechender Knoten für negative Eingabeaufforderungen für unerwünschte Deskriptoren. Im Knoten „Leeres latentes Bild“ können Sie die Breite, Höhe und Anzahl der Bilder anpassen, die Sie generieren möchten.

Sobald Sie mit Ihren Eingabeaufforderungen fertig sind, passen Sie die Bildabmessungen, die Stapelgröße und die wichtigsten Schritte für die Verarbeitung an. Etwa 20 bis 30 Schritte ergeben normalerweise ein Bild in guter Qualität. Klicken Sie abschließend auf die Schaltfläche „Eingabeaufforderung in Warteschlange stellen“ und überlassen Sie ComfyUI die Arbeit.

Verwenden von LoRAs in ComfyUI

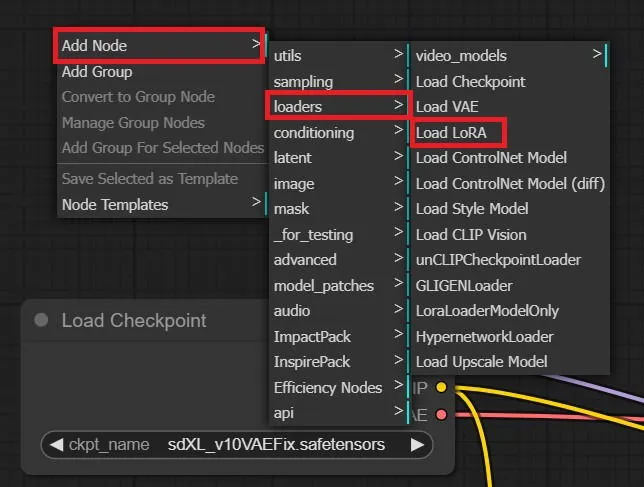

Um bestimmte LoRAs in ComfyUI einzubinden, klicken Sie einfach mit der rechten Maustaste neben den Checkpoint-Knoten und wählen Sie „Knoten hinzufügen“ -> „Loader“ -> „LoRA laden“ . Wählen Sie ein beliebiges LoRA aus Ihrem Ordner im Verzeichnis aus.

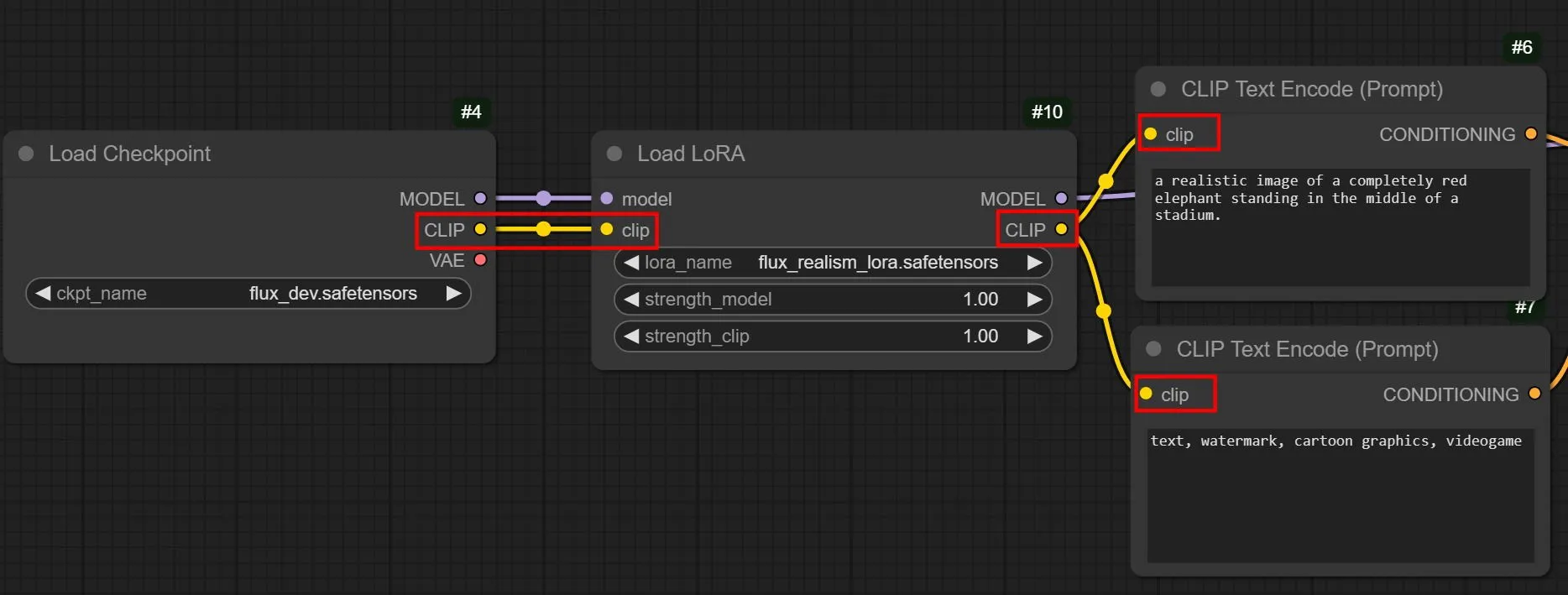

Beachten Sie jedoch, dass Sie die Verbindungen jedes Mal neu anordnen müssen, wenn ein neuer LoRA-Knoten hinzugefügt wird. Ziehen Sie die Linie vom Checkpoint-Knoten mit der Bezeichnung „ Modell“ zum Modell-Einstiegspunkt des LoRA-Knotens auf der linken Seite statt zum KSampler. Verbinden Sie dann den Ausgangspunkt des LoRA-Knotens wieder mit dem Modell-Eingang des KSampler.

Stellen Sie sicher, dass beide Clip- Zeilen vom Checkpoint-Knoten zu jedem Prompt-Knoten geleitet werden. Verbinden Sie auf ähnliche Weise die linken Einstiegspunkte des LoRA-Clips mit positiven und negativen Eingabeaufforderungen.

Wenn Sie den Standard-Workflow verstehen und nach und nach benutzerdefinierte Knoten hinzufügen, können Sie ComfyUI kompetent für Ihre Anforderungen zur KI-Bildgenerierung nutzen.

Häufig gestellte Fragen

Wie unterscheiden sich stabile Diffusion, DALL-E und Midjourney?

Alle drei KI-Systeme können Bilder aus Texteingabeaufforderungen erstellen, aber nur Stable Diffusion ist völlig kostenlos und Open Source. Sie können es kostenlos auf Ihrem Computer installieren und ausführen, während DALL-E und Midjourney proprietäre Software sind.

Was genau ist ein Modell bei stabiler Diffusion?

Ein Modell dient als Datei, die einen KI-Algorithmus verkörpert, der mit bestimmten Bildern und Schlüsselwörtern trainiert wurde. Verschiedene Modelle sind hervorragend für die Generierung unterschiedlicher Arten von Bildern geeignet. Einige sind beispielsweise für realistische menschliche Darstellungen optimiert, während andere besser für 2D-Illustrationen oder verschiedene künstlerische Stile geeignet sind.

Bildnachweis: Titelbild von Stable Diffusion. Alle Screenshots bereitgestellt von Brandon Li und Samarveer Singh.

Schreibe einen Kommentar