Schritt-für-Schritt-Anleitung zur Installation von LLaMA 3 auf einem Windows 11-PC

Llama 3 stellt Metas neueste Weiterentwicklung im Bereich großer Sprachmodelle dar und eignet sich ideal für eine breite Palette von Anwendungen, darunter das Beantworten von Fragen, die Unterstützung bei akademischen Aufgaben und vieles mehr. Wenn Sie Llama 3 auf Ihrem Windows 11-Gerät einrichten, können Sie jederzeit darauf zugreifen, auch ohne Internetverbindung. Diese Anleitung zeigt, wie Sie Llama 3 auf Ihrem Windows 11-Computer einrichten .

Installieren von Llama 3 auf einem Windows 11-Computer

Der Prozess der Installation von Llama 3 auf Ihrem Windows 11-Gerät mit Python erfordert ein gewisses Maß an technischen Kenntnissen. Es gibt jedoch alternative Methoden, die die lokale Bereitstellung von Llama 3 vereinfachen. Ich werde diese Techniken skizzieren.

Um Llama 3 zu installieren, müssen Sie bestimmte Befehle in der Eingabeaufforderung ausführen. Beachten Sie, dass Sie dadurch nur auf die Befehlszeilenversion zugreifen können. Für die Verwendung der Weboberfläche sind zusätzliche Schritte erforderlich. Beide Prozesse werden hier behandelt.

Einrichten von Llama 3 unter Windows 11 über CMD

Zuerst müssen Sie Ollama auf Ihrem Windows-Computer installieren, um Llama 3 bereitzustellen. Folgen Sie diesen Schritten:

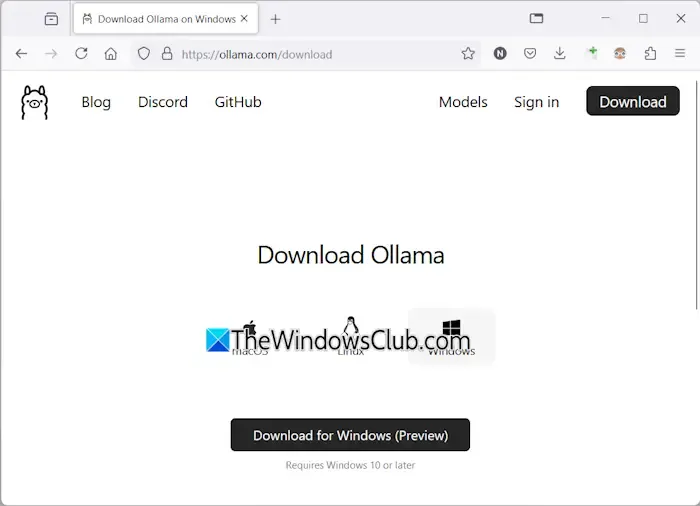

- Navigieren Sie zur offiziellen Ollama-Website .

- Wählen Sie die Option „Download“ und dann „Windows“ .

- Klicken Sie auf „Für Windows herunterladen“, um die ausführbare Datei auf Ihrem Computer zu speichern.

- Führen Sie die heruntergeladene EXE-Datei aus, um Ollama auf Ihrem Gerät zu installieren.

Starten Sie Ihren Computer nach der erfolgreichen Installation von Ollama neu. Es sollte im Hintergrund ausgeführt werden und in der Taskleiste sichtbar sein. Besuchen Sie dann den Abschnitt „Modelle“ auf der Ollama-Website, um verfügbare Modelle anzuzeigen.

Das Modell Llama 3.1 wird in drei Konfigurationen angeboten:

- 8B

- 70B

- 405B

Die Konfiguration 405B ist die anspruchsvollste und funktioniert möglicherweise nicht auf einem Rechner der unteren Preisklasse. Llama 3.2 bietet zwei Optionen:

- 1B

- 3B

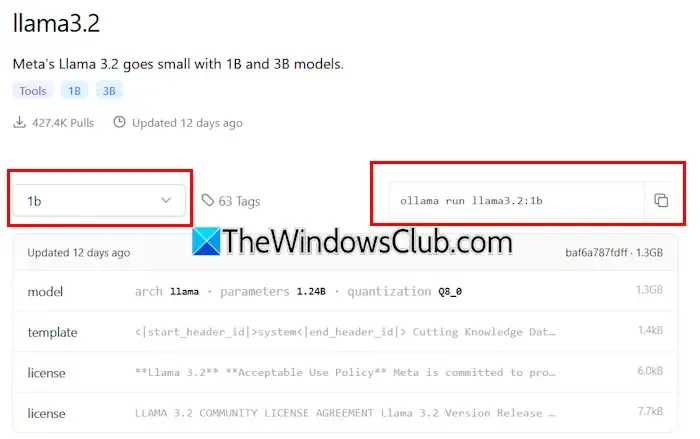

Wählen Sie eine Llama-Version zur Installation aus. Wenn Sie sich für Llama 3.2 entscheiden, klicken Sie darauf. Wählen Sie im folgenden Dropdown-Menü die gewünschte Konfiguration aus. Kopieren Sie anschließend den daneben angezeigten Befehl und fügen Sie ihn in die Eingabeaufforderung ein.

Hier sind die Befehle für das Llama 3.2-Modell:

ollama run llama3.2:3b

Um die Llama 3.2 1B-Konfiguration zu installieren, geben Sie Folgendes ein:

ollama run llama3.2:1b

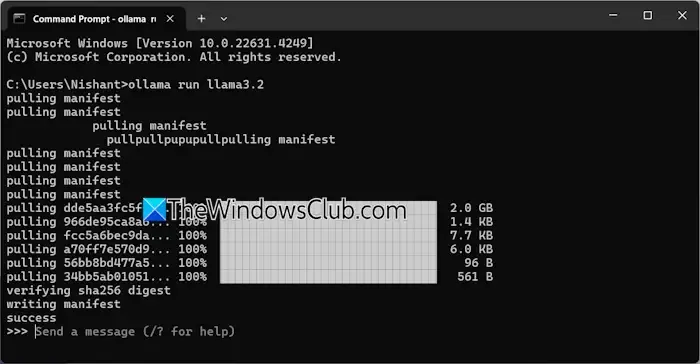

Öffnen Sie die Eingabeaufforderung, geben Sie je nach Bedarf einen der oben genannten Befehle ein und drücken Sie die Eingabetaste . Der Downloadvorgang dauert je nach Internetverbindung eine Weile. Nach Abschluss wird in der Eingabeaufforderung eine Erfolgsmeldung angezeigt.

Anschließend können Sie Ihre Eingaben eingeben, um mit dem Llama 3.2-Modell zu interagieren. Verwenden Sie zum Installieren des Llama 3.1-Modells die auf der Ollama-Website verfügbaren Befehle.

Wenn Sie die Eingabeaufforderung das nächste Mal öffnen, können Sie denselben Befehl verwenden, um Llama 3.1 oder 3.2 auszuführen.

Eine Einschränkung bei der Installation von Llama 3 über CMD ist das Fehlen eines gespeicherten Chatverlaufs. Wenn Sie es jedoch über einen lokalen Host bereitstellen, können Sie Ihren Chatverlauf speichern und erhalten außerdem eine verbesserte Benutzeroberfläche. Im folgenden Abschnitt erfahren Sie, wie Sie dies erreichen.

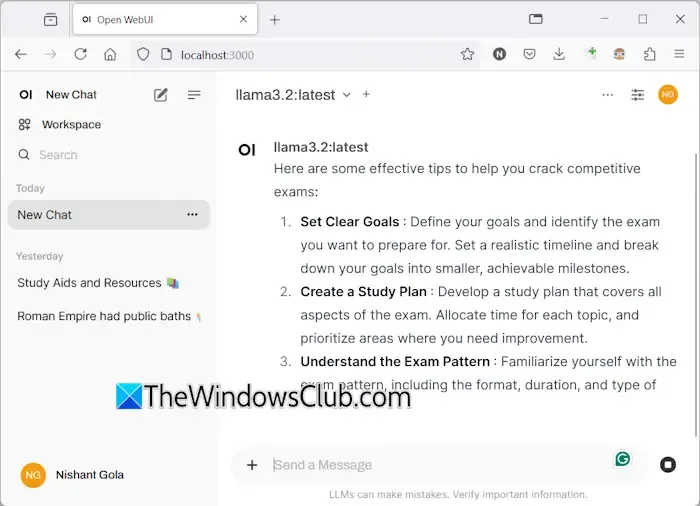

Bereitstellen von Llama 3 mit einer Web-Benutzeroberfläche unter Windows 11

Die Nutzung von Llama 3 über einen Webbrowser verbessert nicht nur das Benutzererlebnis, sondern bewahrt auch den Chatverlauf auf, eine Funktion, die bei der Verwendung von CMD fehlt. So können Sie Llama 3 in Ihrem Webbrowser ausführen.

Um über einen Webbrowser auf Llama 3 zuzugreifen, stellen Sie sicher, dass sowohl Llama 3 über Ollama als auch Docker auf Ihrem System eingerichtet sind. Wenn Sie Llama 3 nicht installiert haben, fahren Sie mit der Ollama-Installation wie zuvor beschrieben fort. Laden Sie als Nächstes Docker von der offiziellen Website herunter und installieren Sie es .

Öffnen Sie Docker nach der Installation und schließen Sie den Anmeldevorgang ab, um ein Konto zu erstellen, da Docker ohne dieses nicht gestartet wird. Minimieren Sie Docker nach der Anmeldung in die Taskleiste. Stellen Sie sicher, dass sowohl Docker als auch Ollama im Hintergrund aktiv sind, um Llama 3 über Ihren Webbrowser zu verwenden.

Öffnen Sie die Eingabeaufforderung, kopieren Sie den folgenden Befehl und fügen Sie ihn ein:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

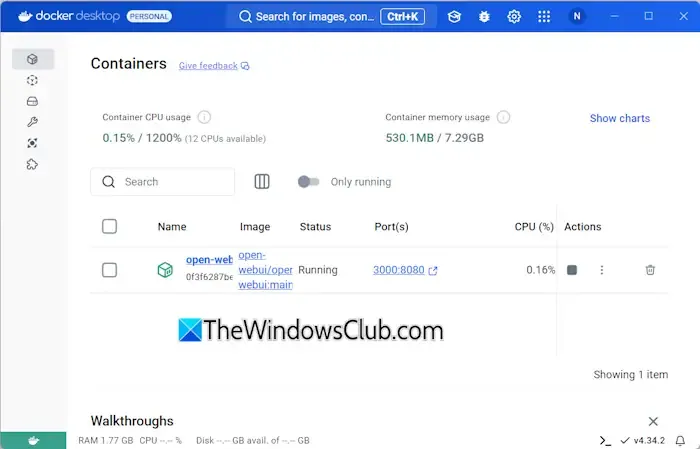

Dieser Befehl benötigt einige Zeit, um die erforderlichen Dateien herunterzuladen. Seien Sie also geduldig. Öffnen Sie nach Abschluss des Vorgangs Docker und navigieren Sie zum Abschnitt „Container“ auf der linken Seite. Sie sollten einen automatisch erstellten Container für Port 3000:8080 sehen.

Klicken Sie auf den Port 3000:8080, wodurch eine neue Registerkarte in Ihrem Standard-Webbrowser geöffnet wird. Möglicherweise müssen Sie sich registrieren und anmelden, um Llama 3 über den Webbrowser zu verwenden. Wenn Sie in der Adressleiste nachsehen, wird localhost:3000 angezeigt, was bedeutet, dass Llama 3 lokal gehostet wird und die Verwendung ohne Internetzugang möglich ist.

Wählen Sie aus dem Drop-down-Menü Ihr bevorzugtes Llama-Chatmodell aus. Um weitere Llama 3-Chatmodelle einzubinden, installieren Sie diese über Ollama mit den entsprechenden Befehlen; sie stehen Ihnen dann in Ihrem Browser zur Verfügung.

Ihr Chatverlauf wird gespeichert und ist auf der linken Seite abrufbar. Wenn Sie fertig sind, melden Sie sich im Webbrowser von Ihrer Sitzung ab, öffnen Sie Docker und klicken Sie auf die Schaltfläche „Stopp“ , um es herunterzufahren, bevor Sie Docker schließen.

Wenn Sie das nächste Mal in Ihrem Webbrowser auf Llama 3 zugreifen möchten, starten Sie sowohl Ollama als auch Docker, warten Sie einige Minuten und klicken Sie dann auf den Port im Docker-Container, um den Localhost-Server zu starten. Nach der Anmeldung können Sie mit der Verwendung von Llama 3 beginnen.

Ich hoffe, diese Informationen sind hilfreich.

Läuft Llama 3 unter Windows?

Ob Sie Llama 3 auf Ihrem Computer ausführen können, hängt von dessen Hardwarespezifikationen ab. Die leichteste Version, das Modell 1B, kann über die Eingabeaufforderung installiert und bedient werden.

Wie viel RAM wird für Llama 3 benötigt?

Um das Modell Llama 3.2 1B auszuführen, sollte Ihr System mit mindestens 16 GB RAM und einer robusten GPU ausgestattet sein. Höhere Varianten von Llama 3 erfordern noch mehr Ressourcen von Ihrem System.

Schreibe einen Kommentar