So schützen Sie Ihre Website vor AI Scraping

Im Moment ist Ihre Website möglicherweise ein All-you-can-eat-Buffet für hungrige KI-Scraper, die mit der Datenerfassung für das Training großer Sprachmodelle wie ChatGPT beauftragt sind. Wenn Sie nicht möchten, dass Ihre wertvollen Inhalte zur nächsten KI-generierten Antwort werden, müssen Sie Ihre Website vor dieser neuen Bedrohung für geistiges Eigentum schützen.

So verhindern Sie Scraping durch KI

Der Schutz Ihrer Website vor KI-Scraping ist nicht so schwierig, wie es scheint. Tatsächlich sind viele der bewährten Methoden zur Bekämpfung des herkömmlichen Web Scrapings ebenso wirksam gegen ihre KI-gestützten Gegenstücke.

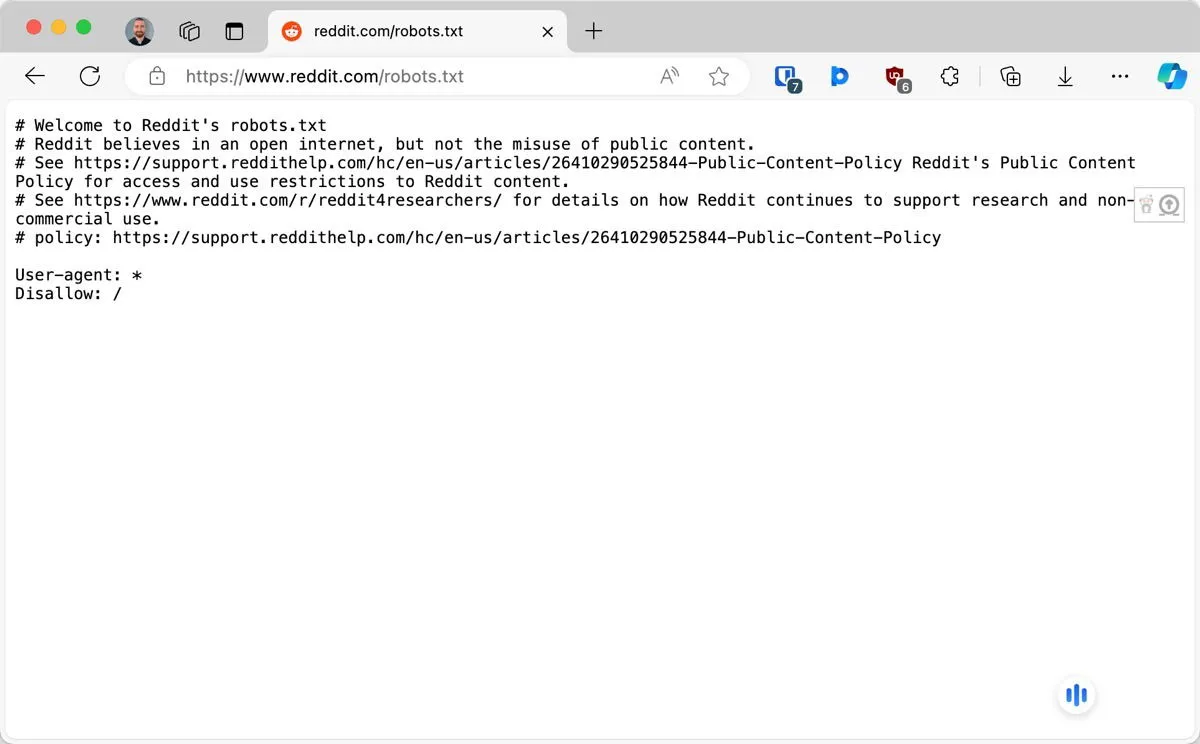

1. Konfigurieren Sie robots.txt, um bestimmte KI-Bots zu blockieren

Die Datei robots.txt ist die erste Verteidigungslinie Ihrer Website gegen unerwünschte Crawler, einschließlich derer von OpenAI und Anthropic. Diese Datei wird verwendet, um das Robots Exclusion Protocol zu implementieren und gut funktionierende Bots darüber zu informieren, auf welche Teile Ihrer Website sie zugreifen dürfen.

Sie sollten die Datei robots.txt im Stammverzeichnis einer Website finden können. Wenn sie dort nicht zu finden ist, können Sie sie mit einem beliebigen Texteditor erstellen. Um einen bestimmten KI-Bot zu blockieren, müssen Sie nur zwei Zeilen schreiben:

Die erste Zeile identifiziert den Bot und die zweite Zeile weist ihn an, keine Seiten aufzurufen. Im obigen Beispiel blockieren wir den Crawler von OpenAI. Hier sind die Namen einiger anderer KI-Bots, die Sie blockieren sollten: Google-Extended, Claude-Web, FacebookBot und anthropic-ai.

2. Implementieren Sie Ratenbegrenzung und IP-Blockierung

Ratenbegrenzung und IP-Blockierung funktionieren durch Überwachung und Kontrolle des Datenverkehrs zu Ihrer Website:

- Die Ratenbegrenzung legt eine Obergrenze für die Anzahl der Anfragen fest, die ein Benutzer (oder Bot) innerhalb eines bestimmten Zeitraums stellen kann. Wenn ein Besucher dieses Limit überschreitet, wird er vorübergehend blockiert oder seine Anfragen werden verlangsamt.

- Mit der IP-Blockierung können Sie hingegen bestimmte IP-Adressen oder Bereiche, die Sie als Quellen von Scraping-Aktivitäten identifiziert haben, vollständig sperren.

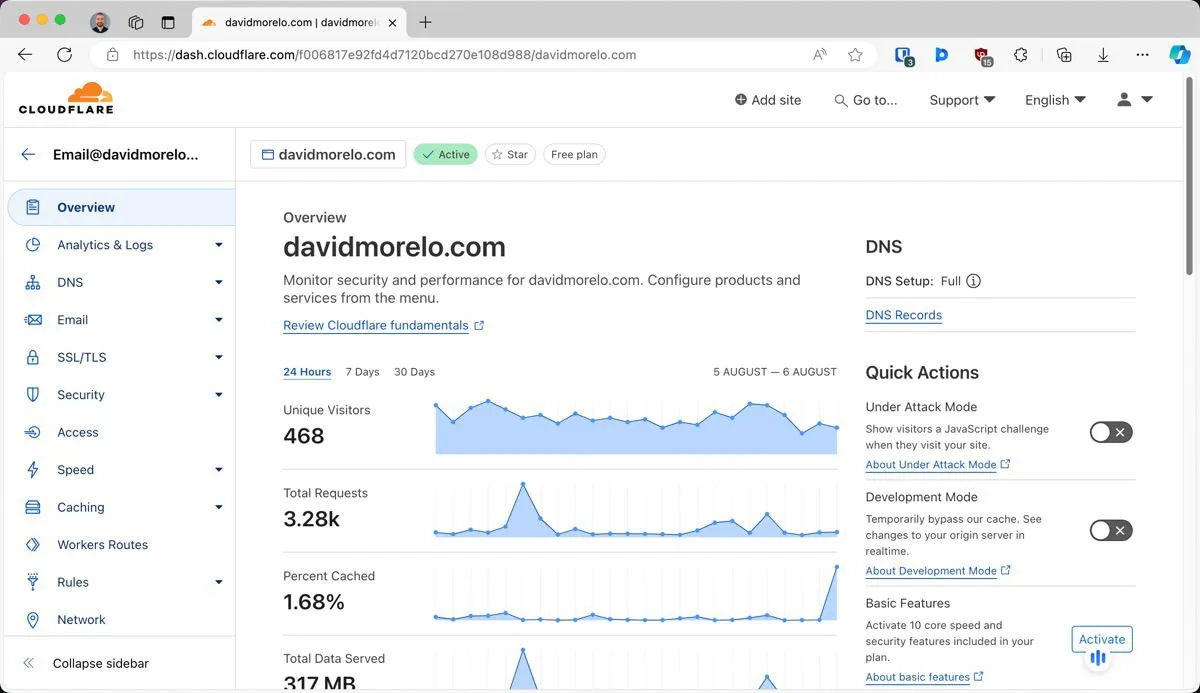

Eine der einfachsten Möglichkeiten, diese Techniken zu implementieren, ist die Verwendung von Cloudflare, einem beliebten Content Delivery Network (CDN) und Sicherheitsdienst.

Cloudflare sitzt zwischen Ihrem Server und dem Internet im Allgemeinen und fungiert dort als Schutzschild für Ihre Website. Sobald Sie Ihre Website hinter Cloudflare platziert haben, können Sie Ratenbegrenzungsregeln konfigurieren und IP-Blöcke über ein benutzerfreundliches Dashboard verwalten.

3. Verwenden Sie CAPTCHAs und andere menschliche Verifizierungsmethoden

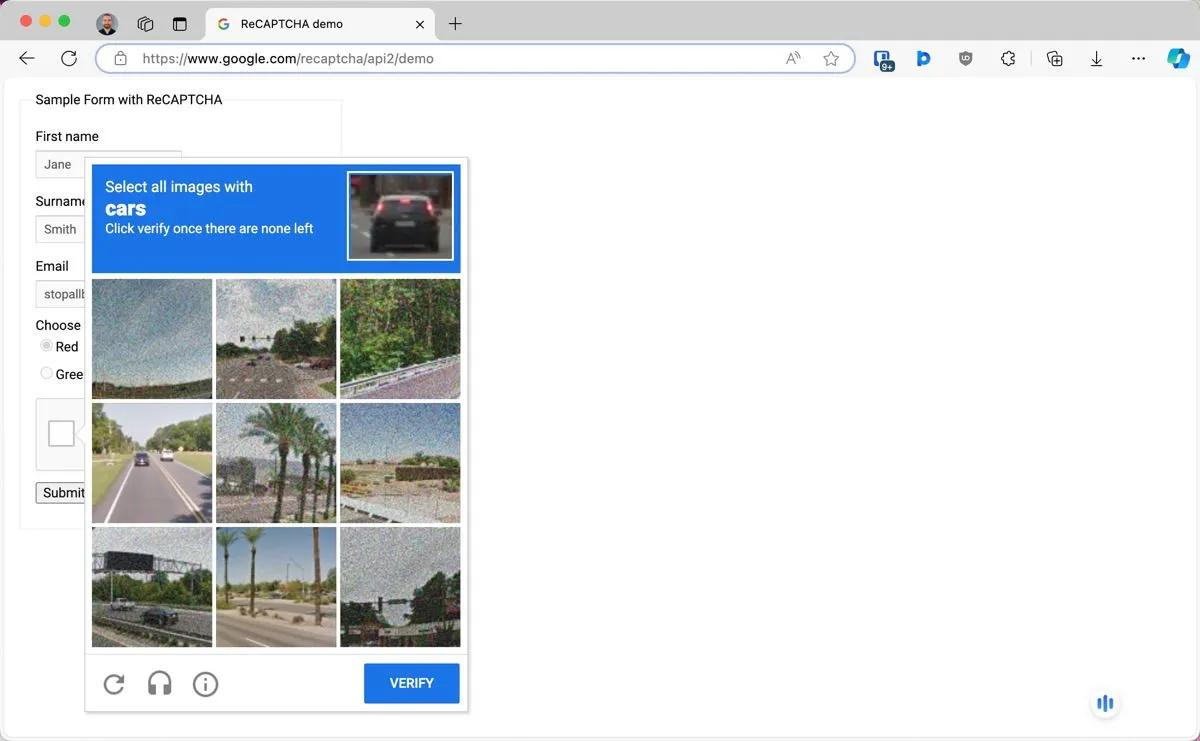

CAPTCHAs (Completely Automated Public Turing test to tell Computers and Humans Apart) sind eine bewährte Methode, um menschliche Benutzer von Bots zu unterscheiden.

Eines der beliebtesten und zugleich effektivsten CAPTCHAs ist Googles reCAPTCHA. Um es zu verwenden, müssen Sie die reCAPTCHA-Administratorkonsole aufrufen und sich für ein API-Schlüsselpaar anmelden. Anschließend können Sie ein WordPress-Plugin wie Advanced Google reCAPTCHA verwenden oder eine benutzerdefinierte Implementierung basierend auf der offiziellen Dokumentation erstellen .

4. Verwenden Sie dynamische Techniken zur Inhaltsdarstellung

Eine weitere clevere Möglichkeit, Ihre Website vor KI-Scraping zu schützen, ist die Verwendung dynamischer Content-Rendering-Techniken. Die Idee ist einfach, aber effektiv: Wenn ein KI-Scraping-Bot Ihre Website besucht, erhält er wertlosen oder gar keinen Inhalt, während normale Besucher den korrekten, vollständigen Inhalt sehen.

So funktioniert es in der Praxis:

- Ihr Server identifiziert den Agenten, der auf die Site zugreift, und unterscheidet zwischen normalen Benutzern und potenziellen KI-Bots.

- Basierend auf dieser Identifizierung entscheidet Ihr Server mithilfe der JavaScript-Logik, welche Inhalte bereitgestellt werden sollen.

- Menschlichen Besuchern stellt der Server die Vollversion Ihrer Site bereit. Bots werden andere Inhalte bereitgestellt.

Da KI-Scraper im Allgemeinen keinen JavaScript-Code verarbeiten (nur einfache HTML-Inhalte), können sie nicht erkennen, dass sie getäuscht wurden.

5. Richten Sie Inhaltsauthentifizierung und eingeschränkten Zugriff ein

Eine der sichersten Möglichkeiten, Ihre Inhalte vor KI-Scrapern zu schützen, besteht darin, sie einfach hinter einem digitalen Tor zu verstecken. Schließlich können diese Bots nur das sammeln, was öffentlich zugänglich ist.

Die einfachste Form dieses Schutzes besteht darin, dass Benutzer sich anmelden müssen, um auf bestimmte Teile Ihrer Website zuzugreifen. Dies allein kann KI-Scraper-Bots abschrecken, da sie normalerweise nicht in der Lage sind, Konten zu erstellen oder sich zu authentifizieren.

Wer noch einen Schritt weiter gehen möchte, kann einen noch besseren Schutz bieten, indem er einige oder alle Inhalte hinter einer Paywall versteckt. WordPress-Nutzer können dies beispielsweise ganz einfach mit Plugins wie MemberPress umsetzen .

Natürlich müssen Sie ein Gleichgewicht zwischen Schutz und Zugänglichkeit finden. Nicht alle Besucher sind möglicherweise bereit, ein Konto zu erstellen, nur um auf Ihre Inhalte zuzugreifen, geschweige denn dafür zu bezahlen. Die Durchführbarkeit dieses Ansatzes hängt ganz von der Art Ihrer Inhalte und den Erwartungen Ihres Publikums ab.

6. Versehen Sie Ihre Bilder mit Wasserzeichen oder vergiften Sie sie

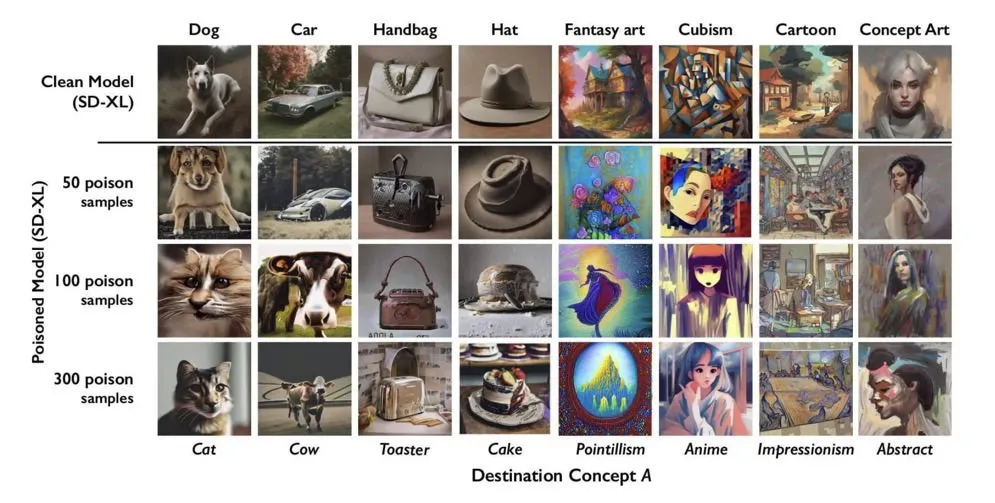

Digitale Wasserzeichen sind eine klassische Technik zum Schutz geistigen Eigentums, die sich jedoch weiterentwickelt, um den Herausforderungen des KI-Zeitalters gerecht zu werden. Eine neue Technik in diesem Bereich ist die Datenvergiftung. Dabei werden subtile Änderungen an Ihren Inhalten vorgenommen, die für Menschen nicht wahrnehmbar sind, aber KI-Systeme, die versuchen, diese abzugreifen oder zu analysieren, verwirren oder stören können.

Tools wie Glaze können Bilder so verändern, dass sie für KI-Modelle schwer zu verarbeiten sind, für menschliche Betrachter aber trotzdem normal aussehen. Und Nightshade treibt die Datenvergiftung noch einen Schritt weiter, indem es aktiv in das KI-Training eingreift.

Durch winzige Änderungen an Bildern kann Nightshare die Annahmen „durchbrechen“, die KI-Modelle während des Trainings treffen. Wenn ein KI-System versucht, aus diesen vergifteten Bildern zu lernen, kann es Schwierigkeiten haben, genaue Darstellungen zu erstellen.

Theoretisch kann Ihr Inhalt, wenn er gut mit Wasserzeichen versehen oder verunreinigt ist, trotzdem gescrapt werden, aber KI-Unternehmen werden ihn mit geringerer Wahrscheinlichkeit in ihre Trainingsdaten aufnehmen. Sie könnten das Scraping Ihrer Website in Zukunft sogar aktiv vermeiden, um eine Verunreinigung ihrer Datensätze zu verhindern.

7. Nutzen Sie die Vorteile von DMCA-Abmahnungen und Urheberrechtsgesetzen

Während sich die vorherigen Methoden darauf konzentrieren, AI Scraping durch technische Maßnahmen zu verhindern, ist es manchmal besser, einen anderen Ansatz zu wählen und sich die Hinweise des Digital Millennium Copyright Act (DMCA) und die Urheberrechtsgesetze zunutze zu machen.

Wenn Sie feststellen, dass Ihre Inhalte kopiert und ohne Erlaubnis verwendet werden, können Sie eine DMCA-Abmahnung ausstellen. Dies ist eine formelle Aufforderung, Ihr urheberrechtlich geschütztes Material von einer Website oder Plattform zu entfernen.

Falls Ihre DMCA-Abmahnungen nicht beachtet werden (und Sie sollten darauf gefasst sein), können Sie die Situation eskalieren, indem Sie Klage einreichen. Und Sie wären nicht der Erste, der das tut.

OpenAI und Microsoft werden derzeit vom Center for Investigative Reporting sowie mehreren anderen Nachrichtenorganisationen wegen Urheberrechtsverletzungen verklagt. In diesen Klagen wird behauptet, dass KI-Unternehmen urheberrechtlich geschützte Inhalte ohne Erlaubnis oder Entschädigung verwenden, um ihre Modelle zu trainieren. Der Ausgang dieser Fälle ist noch ungewiss, aber sie ebnen den Weg für andere, denen sie folgen können.

Titelbild erstellt mit DALL-E. Alle Screenshots von David Morelo.

Schreibe einen Kommentar