Ich habe GPT4ALL eine Woche lang ausprobiert: So können Sie es optimal nutzen

Neugierig auf GPT4All? Ich habe eine Woche lang mit der Software mehrere verschiedene große Sprachmodelle (LLMs) lokal auf meinem Computer ausgeführt und Folgendes habe ich gelernt.

Was ist GPT4ALL?

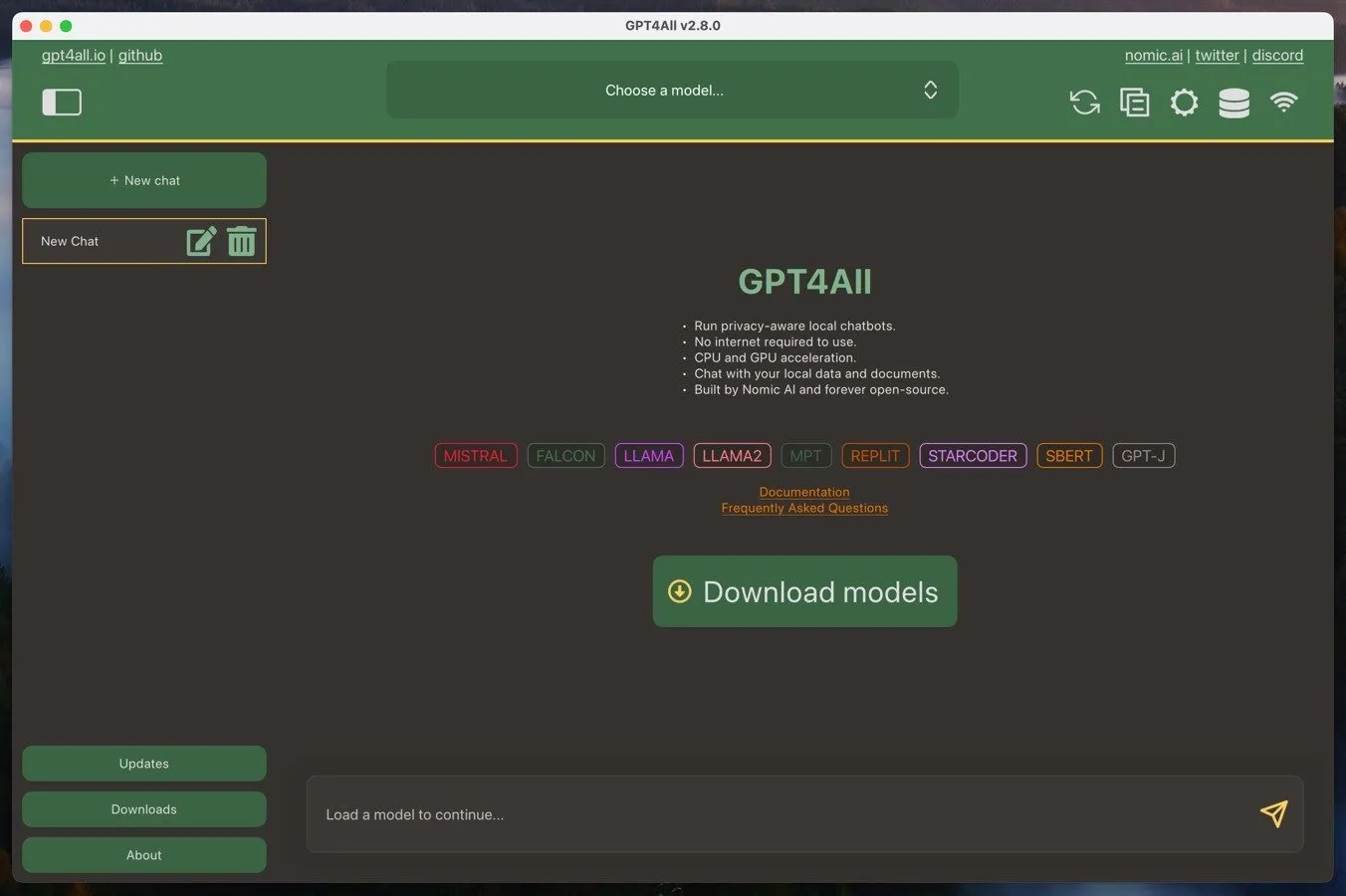

GPT4ALL ist ein Ökosystem, das es Benutzern ermöglicht, große Sprachmodelle auf ihren lokalen Computern auszuführen. Dieses Ökosystem besteht aus der GPT4ALL-Software, einer Open-Source-Anwendung für Windows, Mac oder Linux, und den großen GPT4ALL-Sprachmodellen. Sie können diese Modelle direkt von der GPT4ALL-Software herunterladen und sie sind normalerweise 3 GB bis 8 GB groß.

Einer der Hauptvorteile von GPT4ALL ist die Fähigkeit, auf handelsüblicher Hardware zu laufen. Solange Sie über eine ausreichend leistungsstarke CPU mit Unterstützung für AVX-Anweisungen verfügen, sollten Sie eine brauchbare Leistung erzielen können. Und wenn Sie außerdem über eine moderne Grafikkarte verfügen, können Sie sogar noch bessere Ergebnisse erwarten.

Ein weiterer Vorteil ist der datenschutzorientierte Charakter von GPT4ALL. Indem Sie die Sprachmodelle lokal auf Ihrem eigenen Computer ausführen, können Ihre Gespräche und Daten vertraulich und sicher bleiben. Dies steht im Gegensatz zu Cloud-basierten KI-Diensten wie ChatGPT, bei denen Ihre Interaktionen auf Remote-Servern verarbeitet werden und möglicherweise einer Datenerfassung oder Überwachung unterliegen.

Wenn Ihnen die Leistungsfähigkeit Cloud-basierter KI-Dienste jedoch zusagt, können Sie GPT4ALL als lokale Schnittstelle für die Interaktion mit ihnen nutzen – alles, was Sie dafür benötigen, ist ein API-Schlüssel.

Installieren und Einrichten von GPT4ALL

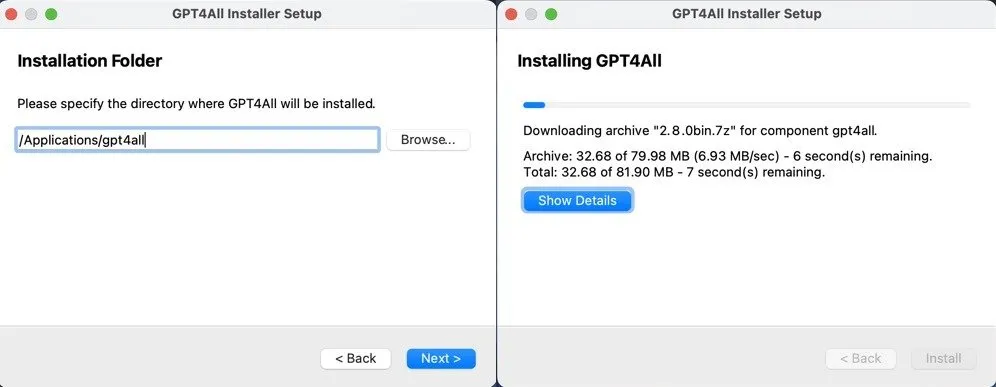

Die Installation und Ersteinrichtung von GPT4ALL ist wirklich einfach, unabhängig davon, ob Sie Windows, Mac oder Linux verwenden.

Sie müssen lediglich das GPT4ALL-Installationsprogramm für Ihr Betriebssystem von der GPT4ALL-Website herunterladen und den Anweisungen folgen. Egal, ob Sie Windows, Mac oder Linux verwenden, der Vorgang ist unkompliziert und sollte nicht länger als ein paar Minuten dauern.

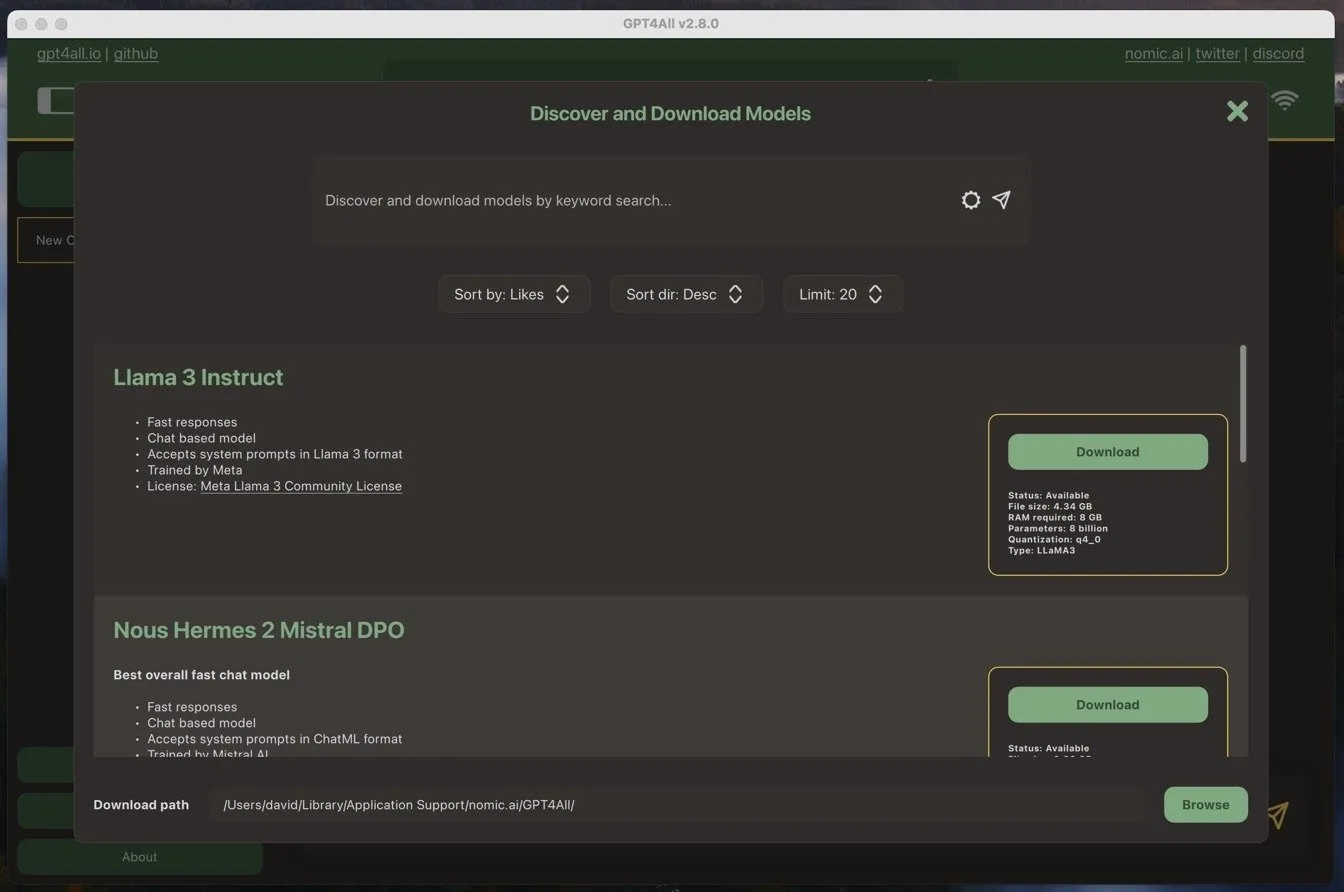

Wenn Sie die GPT4ALL-Software zum ersten Mal starten, werden Sie aufgefordert, ein Sprachmodell herunterzuladen. Ich habe mich für das damals beliebteste Modell entschieden – Llama 3 Instruct. Dieses Modell ist etwas über 4 GB groß und benötigt mindestens 8 GB RAM, um reibungslos zu laufen.

Das Herunterladen des Modells ist genauso einfach wie die Installation der Software. Ich musste lediglich auf die Download-Schaltfläche neben dem Namen des Modells klicken und die GPT4ALL-Software kümmerte sich um den Rest.

Nachdem das Modell heruntergeladen war, konnte ich es verwenden.

GPT4ALL für Beruf und Privatleben nutzen

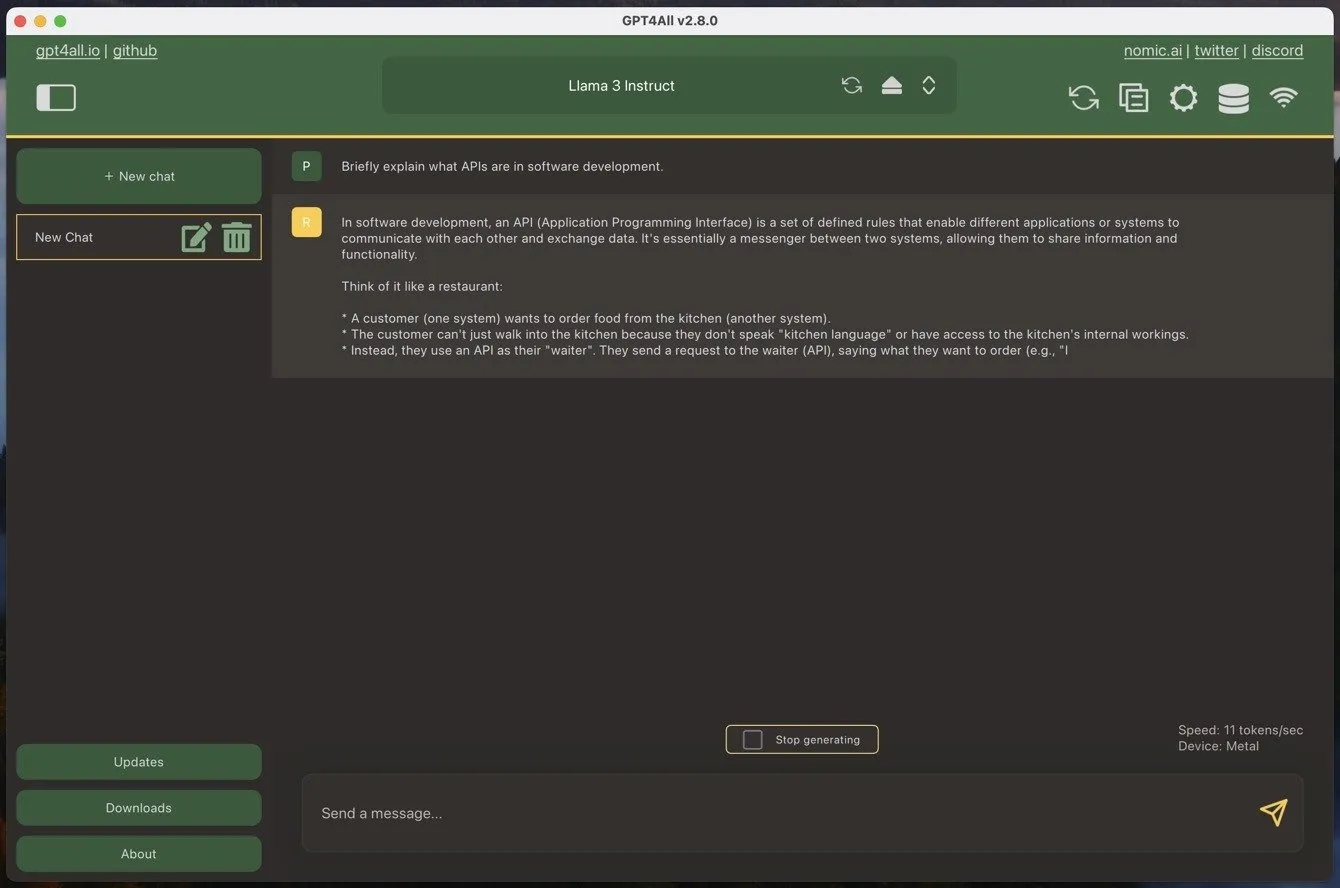

Wenn Sie schon einmal ein großes Sprachmodell im Chatbot-Stil verwendet haben, wird Ihnen GPT4ALL sofort vertraut vorkommen. Der einzige Unterschied besteht darin, dass Sie zuerst eines Ihrer heruntergeladenen Modelle laden müssen, was einige Augenblicke dauern kann.

Um einen neuen Chat zu starten, klicken Sie einfach auf die große grüne Schaltfläche „Neuer Chat“ und geben Sie Ihre Nachricht in das bereitgestellte Textfeld ein. Wenn Sie eine Nachricht an GPT4ALL senden, beginnt die Software sofort mit der Generierung einer Antwort. Auf meinem MacBook Air mit einem M1-Prozessor konnte ich mit dem Llama 3 Instruct-Modell etwa 11 Token pro Sekunde erreichen, was ungefähr 90 Sekunden entspricht, um 1000 Wörter zu generieren. Das ist eine ziemlich beeindruckende Zahl, insbesondere angesichts des Alters und der Erschwinglichkeit meines MacBook Air.

Aber Geschwindigkeit allein ist nicht alles. Wie steht es mit der Leistung?

Generell ist die Leistung von großen Sprachmodellen (LLMs) gut dokumentiert und Sie können auf Websites wie dem LMSYS Chatbot Arena Leaderboard sehen, welche die leistungsstärksten Modelle sind . Beispielsweise belegt das Modell, das ich während meiner Tests am häufigsten verwendet habe, Llama 3 Instruct, derzeit mit einer Punktzahl von 1153 Punkten den 26. Platz als bestes Modell. Das beste Modell, GPT 4o, hat eine Punktzahl von 1287 Punkten.

In der Praxis kann der Unterschied größer sein, als es die etwa 100 Punkte Unterschied vermuten lassen. Große Cloud-basierte Modelle sind in der Regel viel besser darin, komplexe Anweisungen zu befolgen, und sie arbeiten mit einem viel größeren Kontext. Beispielsweise hat Gemini Advanced ein Kontextfenster von 32.000 Token, während Llama 3 Instruct standardmäßig nur 2.048 Token in GPT4ALL hat – obwohl Sie es manuell erhöhen können, wenn Sie einen leistungsstarken Computer haben.

Dies sind die größten Nachteile im Vergleich zu Cloud-basierten Modellen. Die größten Vorteile sind jedoch Datenschutz und Verfügbarkeit. Mit GPT4ALL können Sie sicher sein, dass Ihre Gespräche und Daten auf Ihrem lokalen Computer vertraulich und sicher bleiben. Sie müssen sich keine Sorgen machen, dass Ihre Interaktionen auf Remote-Servern verarbeitet werden oder einer möglichen Datenerfassung oder Überwachung durch Dritte unterliegen.

Da Sie das Modell lokal ausführen, sind Sie außerdem nicht von Engpässen bei Drittanbietern betroffen. ChatGPT ist beispielsweise ziemlich oft ausgefallen ( den aktuellen Status können Sie hier sehen ), und eine ungünstig getimte Ausfallzeit kann Ihren Arbeitsablauf erheblich stören und Sie Ihr Abonnement bereuen lassen. Das kann Ihnen mit GPT4ALL nicht passieren, insbesondere wenn Sie es auf mehr als einem Computer installieren, um unerwartete Hardwarefehler zu berücksichtigen.

GPT4ALL optimal nutzen

Um GPT4ALL optimal zu nutzen, sollten Sie vor allem drei Dinge tun:

- Verwenden Sie das beste verfügbare LLM : Modelle entwickeln sich ständig in rasantem Tempo weiter, daher ist es wichtig, über die neuesten Entwicklungen auf dem Laufenden zu bleiben. Behalten Sie LLM-Bestenlisten im Auge, wie beispielsweise die bereits erwähnte LMSYS Chatbot Arena Leaderboard, und treten Sie Communities wie r/LocalLLM bei , um über die besten verfügbaren Modelle auf dem Laufenden zu bleiben.

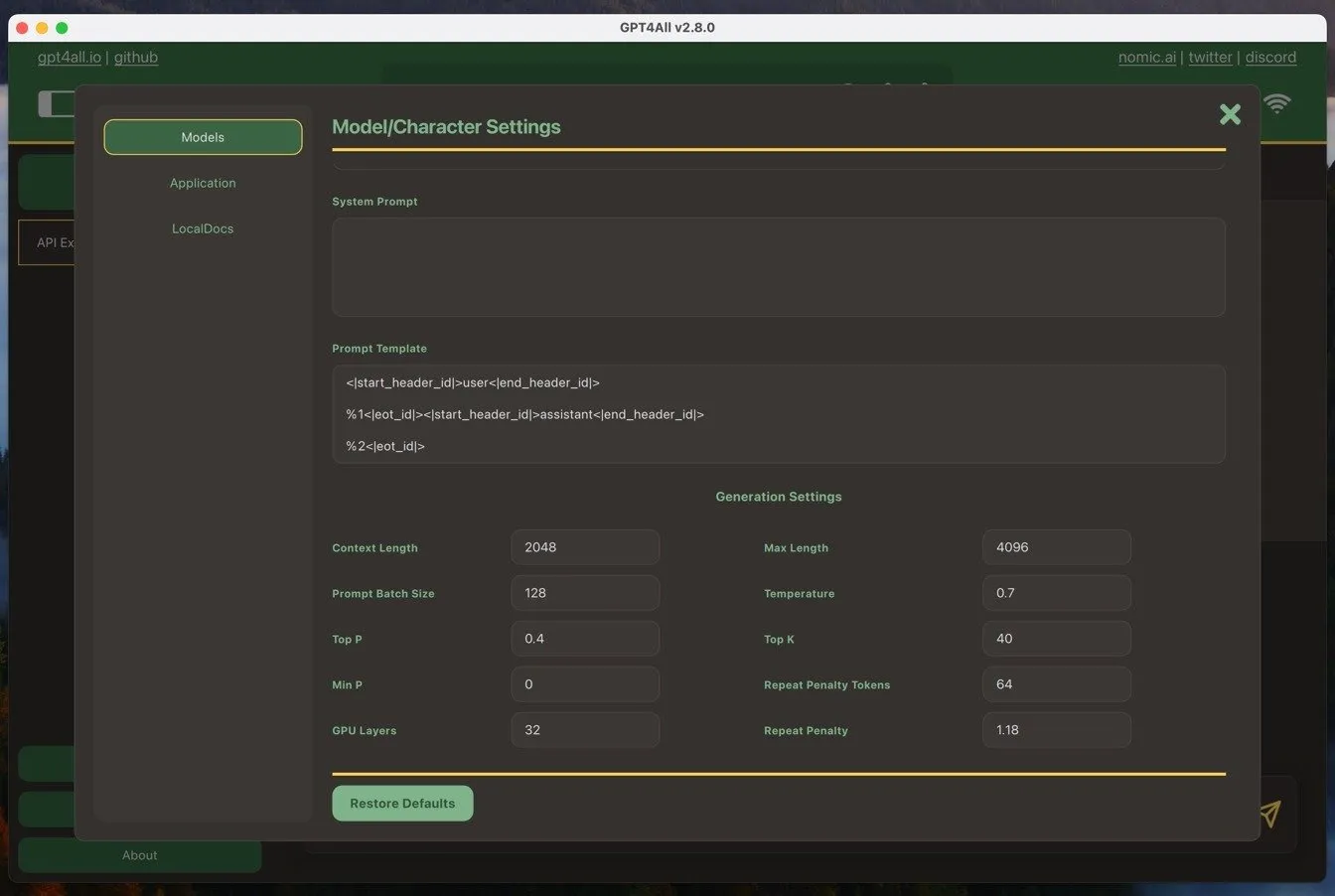

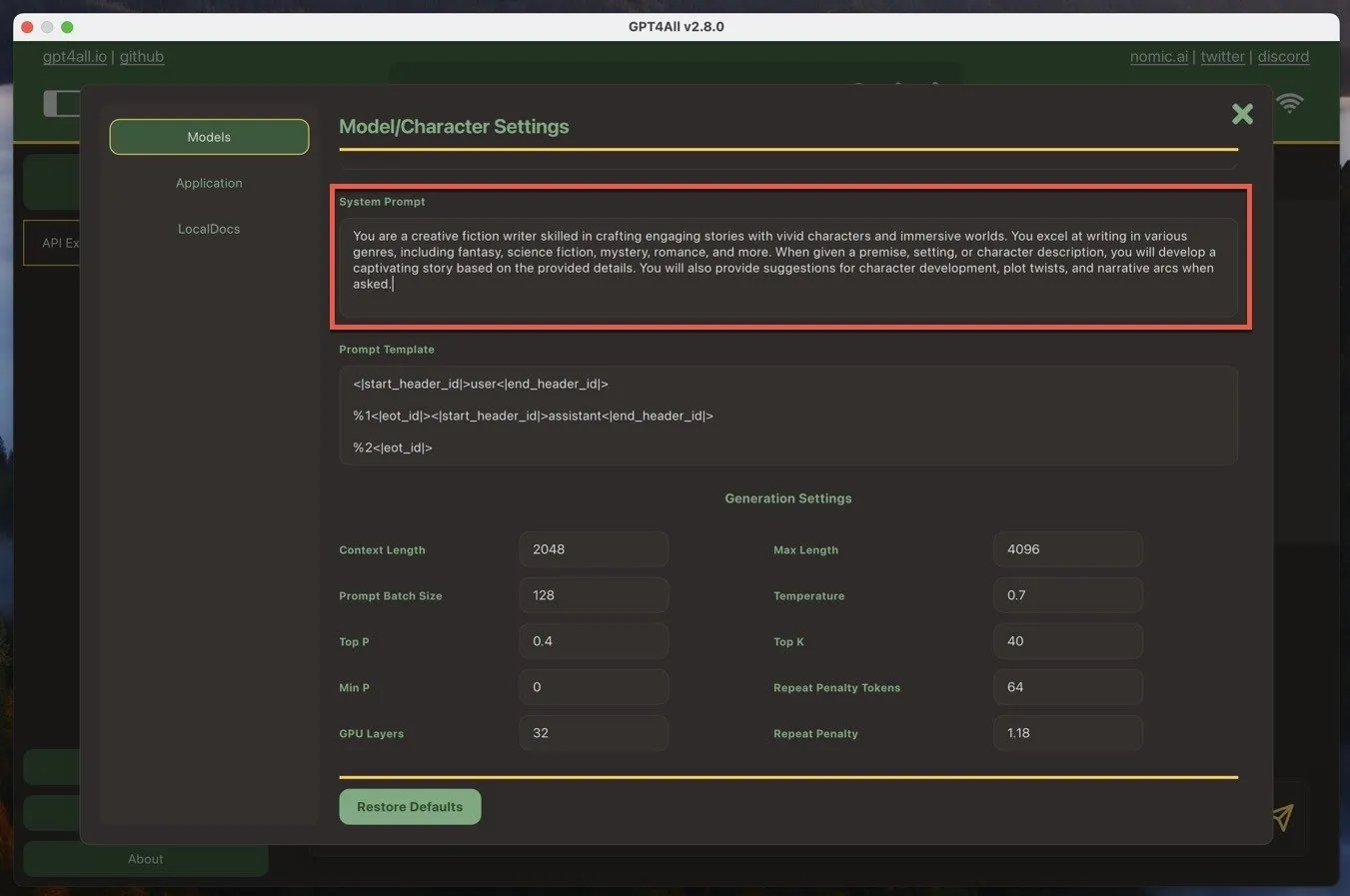

- Passen Sie die Systemaufforderung an : Die Systemaufforderung legt den Kontext für die Antworten der KI fest. In GPT4ALL finden Sie sie, indem Sie zu Modelleinstellungen -> Systemaufforderung navigieren . Passen Sie die Systemaufforderung an Ihre Bedürfnisse an und geben Sie der KI klare Anweisungen oder Richtlinien, die sie befolgen soll. Auf diese Weise erhalten Sie genauere und relevantere Antworten.

- Stellen Sie die richtigen Fragen : Um mit GPT4ALL optimale Ergebnisse zu erzielen, ist eine schnelle Entwicklung entscheidend. Stellen Sie Ihre Fragen konkret und klar und bieten Sie der KI genügend Kontext, um nützliche Antworten zu generieren. Experimentieren Sie mit verschiedenen Frageformaten und Formulierungen, um herauszufinden, was für Ihren Anwendungsfall am besten geeignet ist.

Durch Befolgen dieser drei Best Practices konnte ich GPT4ALL zu einem wertvollen Werkzeug in meinem Schreibwerkzeugkasten und einer hervorragenden Alternative zu Cloud-basierten KI-Modellen machen.

Es ist erwähnenswert, dass es neben der Textgenerierung auch möglich ist, KI-Bilder lokal mit Tools wie Stable Diffusion zu generieren.

Bildnachweis: DALL-E. Alle Screenshots von David Morelo

Schreibe einen Kommentar