So führen Sie Ihr eigenes lokales LLM auf einem Raspberry Pi aus

Seit der atemberaubenden Veröffentlichung von ChatGPT 3 durch OpenAI Ende 2022 haben Large Language Models (LLMs) die Fantasie der Welt beflügelt, indem sie bemerkenswerte Fähigkeiten demonstrierten, vom Verfassen von Aufsätzen bis hin zur Beantwortung komplexer Fragen.

Sie müssen sich jedoch nicht auf Unternehmen wie OpenAI, Google oder Anthropic verlassen und möglicherweise persönliche Daten weitergeben, um die Leistungsfähigkeit von LLMs zu nutzen. Mit nur einem erschwinglichen Raspberry Pi können Sie Ihren eigenen lokalen KI-Chat-basierten Assistenten einrichten. Diese Anleitung zeigt Ihnen, wie das geht.

Was du brauchen wirst

Zum Einrichten Ihres eigenen LLM auf einem Raspberry Pi benötigen Sie einige grundlegende Komponenten:

- Raspberry Pi : Da LLMs ressourcenintensiv sind, ist es am besten, den leistungsstärksten verfügbaren Raspberry Pi zu verwenden, um optimale Leistung zu erzielen. Zum Zeitpunkt des Schreibens dieses Artikels ist der Raspberry Pi 5 mit 8 GB RAM die empfohlene Wahl.

- microSD-Karte mit Raspberry Pi OS: Für maximale Leistung sollten Sie die Lite-Version von Raspberry Pi OS verwenden, da zum Ausführen eines LLM keine grafische Benutzeroberfläche erforderlich ist (Sie können per Fernzugriff über ein Terminal und SSH damit interagieren). Wenn Sie Ihren Raspberry Pi jedoch für andere Aufgaben oder als Hauptcomputer verwenden, können Sie die reguläre Version von Raspberry Pi OS verwenden.

- Zusätzliche Komponenten : Neben dem Raspberry Pi und einer schnellen microSD-Karte benötigen Sie ein zuverlässiges Netzteil (das offizielle wird empfohlen), eine Tastatur, eine Maus und einen Monitor für die Ersteinrichtung (optional, wenn Sie SSH verwenden) sowie eine Internetverbindung zum Herunterladen der erforderlichen Software und Modelle.

Wenn Sie diese Komponenten zur Hand haben, können Sie mit der Einrichtung Ihres eigenen LLM auf Ihrem Raspberry Pi beginnen.

Installieren Sie Ollama

Der erste Schritt beim Einrichten Ihres eigenen LLM auf einem Raspberry Pi besteht darin, die erforderliche Software zu installieren. Derzeit sind llama.cpp und Ollama die beiden beliebtesten Optionen zum lokalen Ausführen von LLMs.

- llama.cpp ist eine leichtgewichtige C++-Implementierung von Metas LLaMA (Large Language Model Adapter), die auf einer Vielzahl von Hardware, einschließlich Raspberry Pi, ausgeführt werden kann. Es wurde von Georgi Gerganov entwickelt und im März 2023 veröffentlicht.

- Ollama hingegen basiert auf llama.cpp und bietet mehrere benutzerfreundliche Funktionen. Es verarbeitet automatisch Vorlagen für Chat-Anfragen in dem Format, das jedes Modell erwartet, und lädt und entlädt Modelle je nach Anforderung des Clients. Ollama verwaltet auch das Herunterladen und Zwischenspeichern von Modellen, einschließlich quantisierter Modelle, sodass Sie sie nach Namen anfordern können.

Für diese Anleitung verwenden wir Ollama aufgrund seiner Benutzerfreundlichkeit und der zusätzlichen Funktionen.

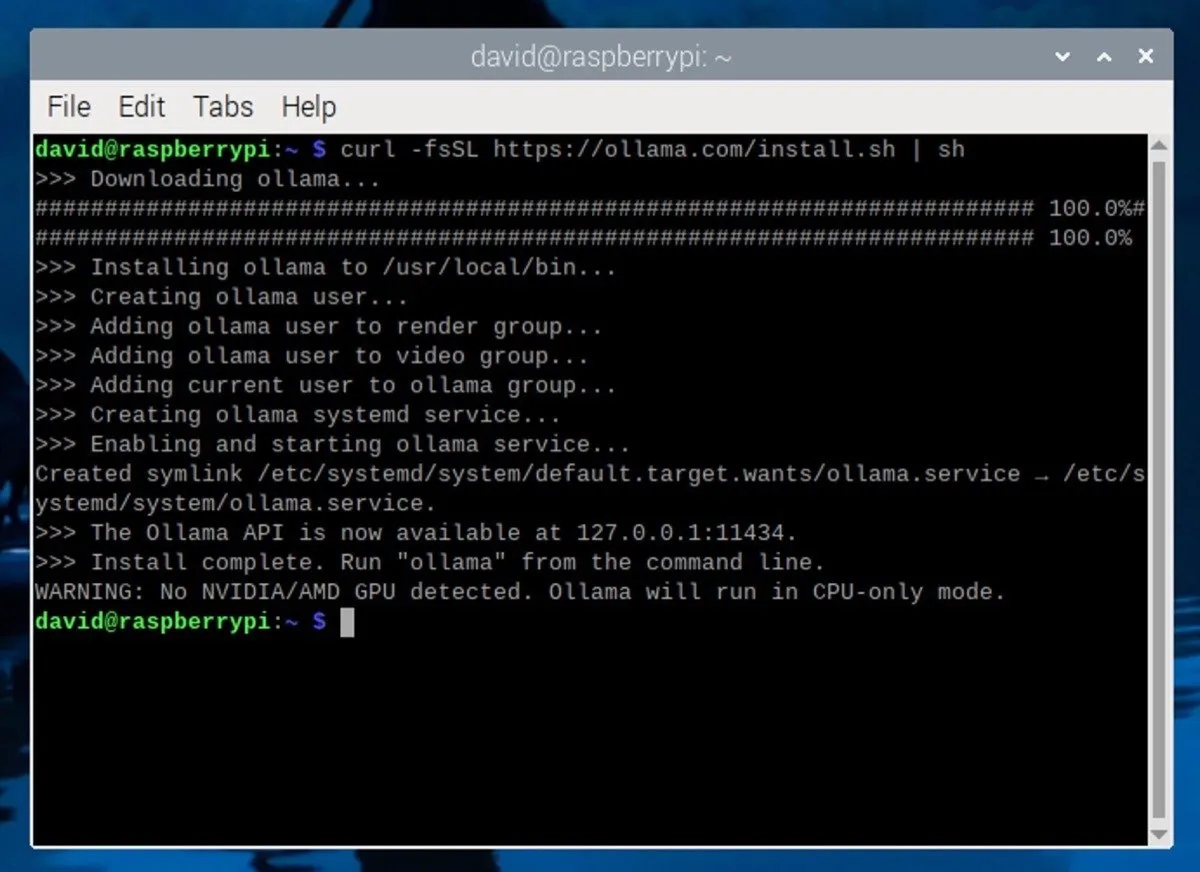

Um Ollama auf Ihrem Raspberry Pi zu installieren, öffnen Sie ein Terminalfenster auf Ihrem Raspberry Pi. Wenn Sie SSH verwenden, stellen Sie über Ihren bevorzugten SSH-Client eine Verbindung zu Ihrem Raspberry Pi her. Geben Sie dann den folgenden Befehl im Terminal ein:

Dieser Befehl lädt das Installationsskript von der offiziellen Ollama-Website herunter und führt es aus. Das Skript installiert automatisch die erforderlichen Abhängigkeiten und richtet Ollama auf Ihrem Raspberry Pi ein.

Herunterladen und Ausführen eines LLM

Nachdem Ollama installiert ist, ist es an der Zeit, ein großes Sprachmodell herunterzuladen. Wenn Sie einen Raspberry Pi mit 8 GB RAM verwenden, können Sie Modelle mit bis zu 7 Milliarden Parametern ausführen (die Einstellungen, die die KI zur Bestimmung ihrer Ausgaben verwendet).

Einige beliebte Optionen sind Mistral (7B), Gemma (7B oder 2B), Llama 2 unzensiert (7B) oder Microsofts Phi-3 (3,8B). Sie können alle unterstützten Modelle auf der Ollama-Bibliotheksseite anzeigen .

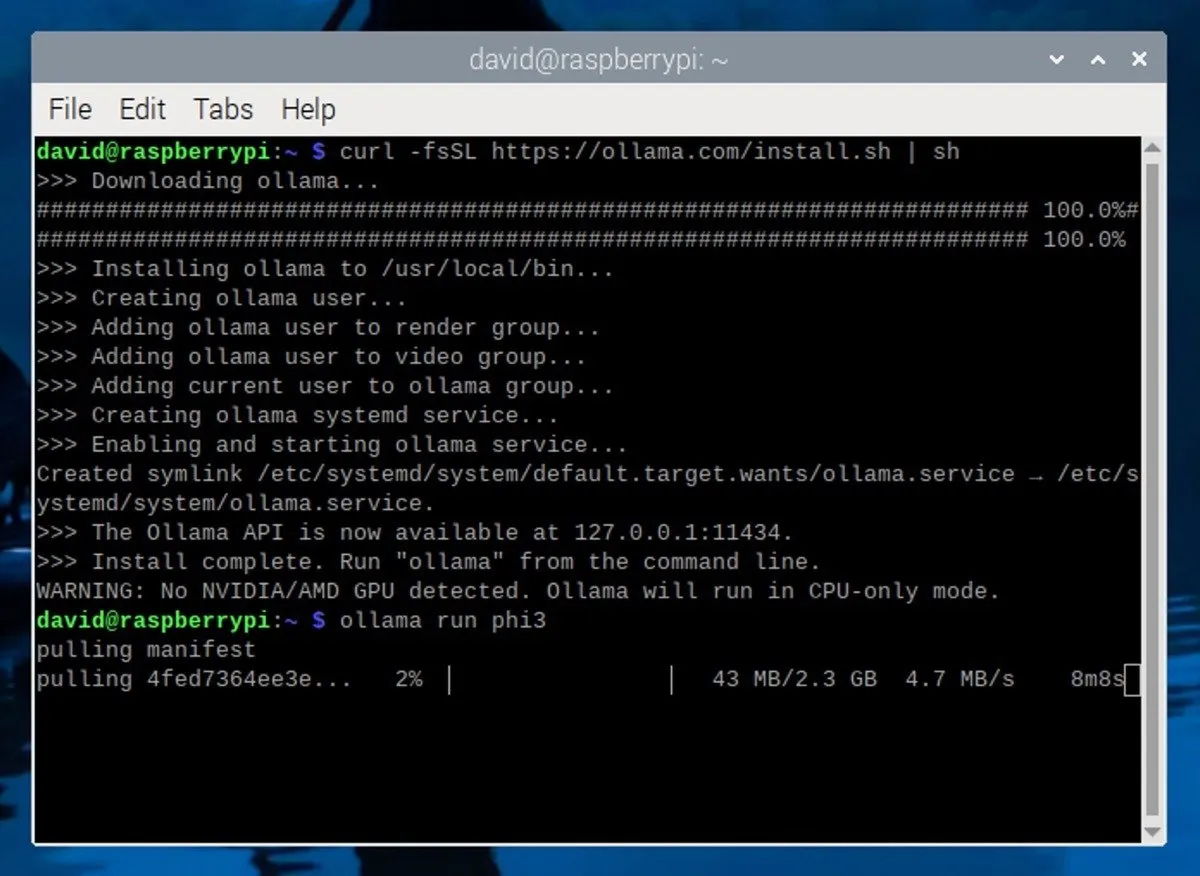

Für diese Anleitung verwenden wir das Phi-3-Modell von Microsoft . Trotz seiner geringen Größe und Effizienz ist Phi-3 ein äußerst leistungsfähiges Modell. Um es zu installieren, führen Sie einfach den folgenden Befehl im Terminal aus:

Dieser Befehl lädt das Phi-3-Modell herunter und installiert es. Außerdem wird automatisch eine interaktive Chat-Sitzung mit dem Modell gestartet.

Verwenden eines lokalen LLM auf Ihrem Raspberry Pi

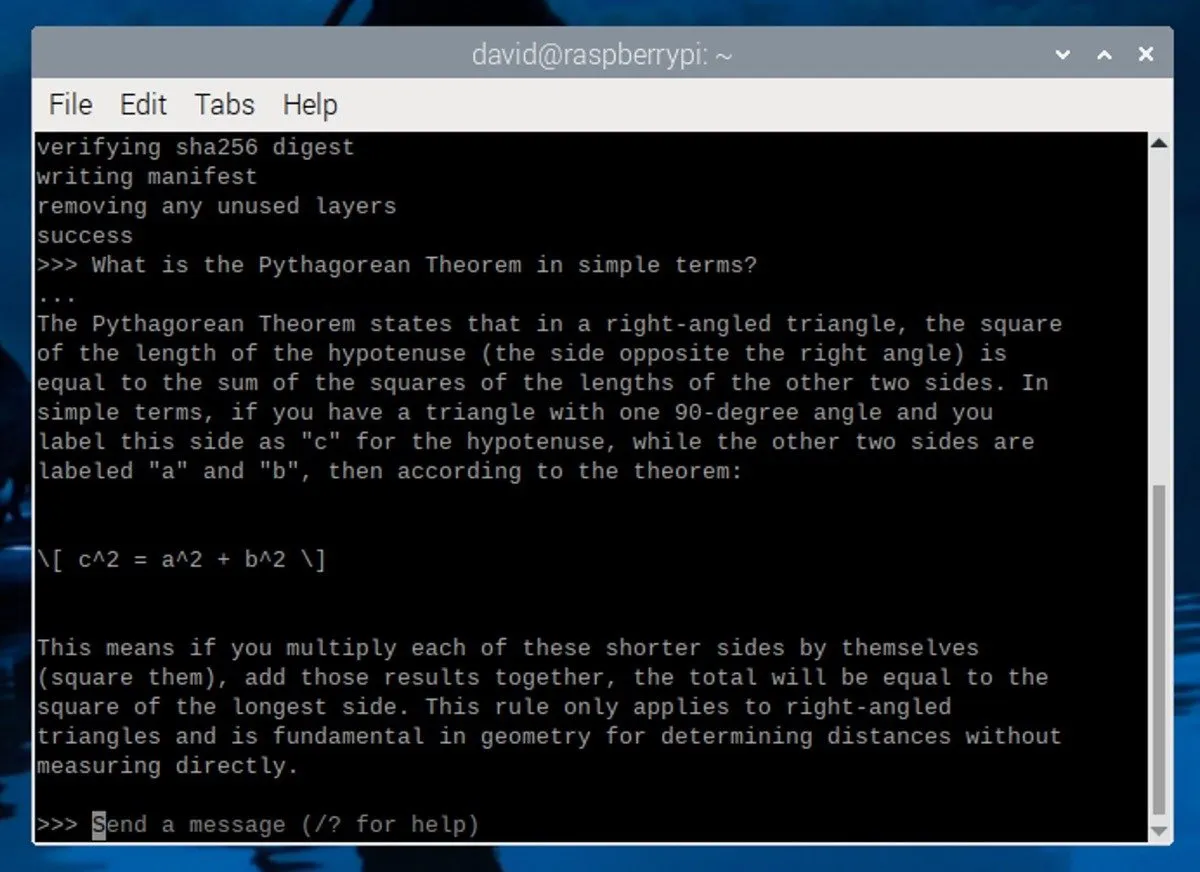

Nachdem Sie das Phi-3-Modell heruntergeladen und installiert haben, wird im Terminal eine Eingabeaufforderung angezeigt, die folgendermaßen aussieht:

Dies bedeutet, dass das LLM ausgeführt wird und auf Ihre Eingabe wartet. Um mit der Interaktion mit dem Modell zu beginnen, geben Sie Ihre Nachricht ein und drücken Sie die Eingabetaste.

Hier sind einige Tipps zum Verfassen wirksamer Eingabeaufforderungen:

- Seien Sie konkret : Geben Sie klare und detaillierte Anweisungen oder Fragen, damit der LLM versteht, wonach Sie suchen.

- Legen Sie den Kontext fest : Geben Sie dem LLM einige Hintergrundinformationen oder ein Szenario, um relevantere Antworten zu generieren.

- Rollen definieren : Geben Sie die Rolle an, die der LLM in seiner Antwort übernehmen soll, z. B. die eines Geschichtenerzählers, eines Lehrers oder eines technischen Experten.

Um die LLM-Sitzung zu beenden, drücken Sie Ctrl+ doder geben Sie den /byeBefehl ein. Wenn Sie später eine weitere Sitzung starten möchten, öffnen Sie einfach ein neues Terminal und führen Sie den ollama run phi3Befehl aus. Da das Modell bereits heruntergeladen ist, wird es schnell gestartet, ohne dass es erneut heruntergeladen werden muss.

Beachten Sie, dass die Leistung des Raspberry Pi 5 ihre Grenzen hat und nur wenige Token pro Sekunde ausgeben kann. Um eine bessere Leistung zu erzielen, sollten Sie Ollama auf einem leistungsstärkeren Computer mit einer dedizierten Grafikkarte ausführen.

Bildnachweis: Unsplash . Screenshots von David Morelo.

Schreibe einen Kommentar