ChatGPT 高度な音声モードの概要: 期待と現実

重要なポイント

- ChatGPT の高度な音声モードには、マルチモーダル機能や保留して話す機能など、いくつかの重要な機能が欠けており、過度の検閲により使用できなくなる場合があります。

- しかし、歌ったり、ハミングしたり、いちゃついたりすることはできませんが(OpenAI の指示による)、複数の言語、アクセント、地方の方言を話すことができ、印象的な表現力を誇ります。

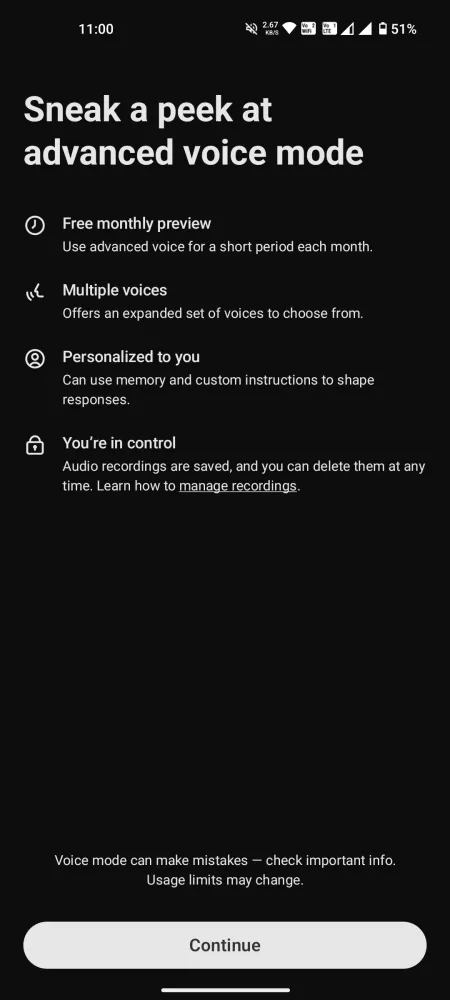

- チャット機能は無料ユーザーの場合、1 か月あたり 15 分間のみアクセス可能ですが、Plus ユーザーの場合は 1 日あたり 1 時間という厳格な制限が適用されます。

最初のデモンストレーションを見た後、ChatGPT の高度な音声モードをめぐる興奮は明白でした。しかし、さまざまな法的課題とその後の遅延により、この機能は依然として大幅に制限されており、重要な機能が欠如しており、期待されるエクスペリエンスを損なう誤解が含まれています。

OpenAI が日常的なやり取りに提供している時間は限られているにもかかわらず、ユーザーはその長所、短所、可能性について十分に理解することができます。ここでは、ChatGPT の高度な音声モードについての率直な感想を述べ、その長所、短所、そしてカリスマ的な音声アシスタントを持つというビジョンがまだ実現に遠い理由を強調します。

高度な音声モードへのユニバーサルアクセスが可能だが、重要な機能が不足している

ChatGPT モバイル アプリケーションで高度な音声モードがリリースされたことで、すべてのユーザーがこの革新的な音声対音声モデルを利用できるようになりました。無料アカウントは月間 15 分の使用に制限されていますが、Plus ユーザーは1 日あたり約 1 時間使用できます。ただし、サーバーの可用性に基づいて 1 日あたりの制限は異なります。この時間に達すると、それほどエキサイティングではない標準音声モードに移行する必要があります。

会話を始める前に、期待を管理することが重要です。プレビュー中に宣伝された多くの機能は、現在、無料アカウントと Plus アカウントの両方で利用できません。現時点では、Advanced Voice Mode はマルチモーダルではなく、音声を解釈したり、画像やビデオを分析したりする機能がありません。物理的な本を読んだり、指を上げているかどうかなどのジェスチャーを認識したり、歌を歌ったり、ギターなどの楽器を識別したりすることはできません。約束された多くの機能がまだ欠けています。

高度な音声モードの利点

ChatGPT の高度な音声モードは、すべての期待に応えるものではないかもしれませんが、特定の分野では成功しています。注目すべき良い点をいくつか挙げます。

多様な音声オプション、しかし空はない

ユーザーは 9 つの異なる音声から選択できます。

- ソル(女性) – リラックスしていて賢い

- エンバー(男性) – 楽観的で自信がある

- アーバー(M) – 多用途で気楽

- ヴェイル(女性) – 好奇心旺盛で明るい

- メープル(女性) – 率直で明るい

- ジュニパー(F) – 明るくオープン

- コーブ(男性) – 率直で落ち着いた

- スプルース(男性) – 肯定的で穏やか

- ブリーズ(男性/女性) – 真面目で活発

このミックスには Sky が欠けていますが、他の声は豊かで魅力的です。Sky はもう選択肢にないようですから、先に進みましょう。

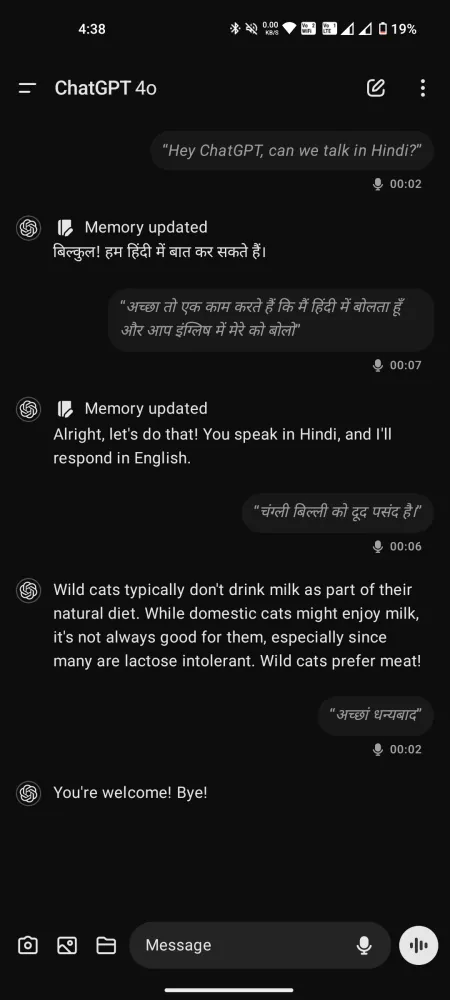

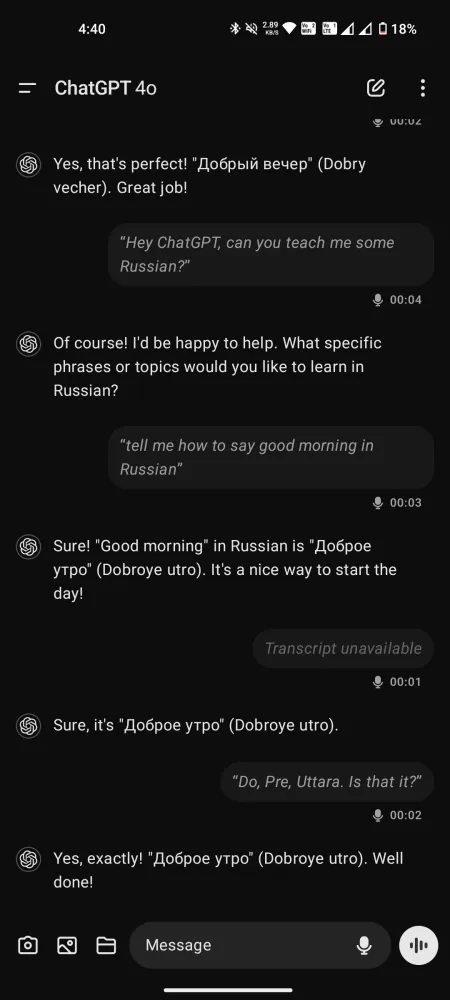

表現力豊かな多言語会話家

高度な音声モードに関する批判はありますが、そのパフォーマンスは誇張しすぎることはありません。特に、遅延が最小限でスムーズな会話ができる標準モードと比較するとそのパフォーマンスは際立っています。50 を超える言語を理解して話すことができるため、スピーチ コーチ、翻訳者、語学講師としても役立ちます。

声を真似ることはできないが、リクエストに応じてさまざまなアクセントを表現でき、アメリカ南部の方言からイギリスのコックニー方言まで、あらゆる方言に対応する。

Gemini Live と比較すると、これらの音声とのやり取りは慌ただしさを感じさせず、より丁寧でサポート的な体験を生み出します。

ChatGPTは感情を理解できますか?

それは議論の余地がある。OpenAIはChatGPTが話者の口調や感情を認識できると主張しているが、ユーザーの間で意見は分かれている。ChatGPTがこれらの側面を本当に理解していると信じる人もいれば、言葉の選択や文脈の手がかりに基づいて口調を推測しているだけだと主張する人もいる。

あるユーザーは、 GPT-4o の音声を直接書き起こすのではなく、音声をテキストに変換してから処理することを提案しました。つまり、声や呼吸のパターンを通じて伝えられるトーンや感情は、テキスト形式にうまく翻訳されない可能性があります。

さらに、Advanced Voice Mode は GPT-4 を利用できるため (テキストから音声への変換は処理できるが、音声から音声への変換は処理できない)、ChatGPT が感情のニュアンスを本当に把握できるかどうか疑問が残ります。しかし、ChatGPT はある程度の理解を示していると主張する人もいます。このトピックは、さらに調査する必要があるようです。

ChatGPT 高度な音声モードの制限

さて、本題に入りましょう。このコンセプトがいかに魅力的に聞こえるかに関わらず、実際に使ってみると大きな欠点が明らかになります。以下に詳細を説明します。

過度な検閲と制限

多くの AI チャットボットと同様に、ChatGPT は慎重すぎる傾向があり、それが過度な検閲につながることもあります。AI が意見を述べたり、扇動的なコメントをしたりしないようにするのは賢明ですが、安全柵が非常に厳しく設定されているため、高度な音声モードでは基本的な質問にも答えられない場合があります。

新規ユーザーはすぐにはこうした問題に遭遇しないかもしれませんが、チャット時間が長い Plus ユーザーは定期的にこうした拒否に直面する可能性があります。自分のリクエストが却下され、希望する回答が得られない可能性があると知ると、イライラします。

驚くほど低い中断閾値

多くのユーザーは、このモデルの中断のしきい値が驚くほど低いことに気づいています。ほんの短い休止でも、ChatGPT は「応答する番」だと判断します。1 秒以上休止すると、すぐに割り込んできます。応答する前に考える時間が必要なので、この設計上の欠陥は、より深い会話を妨げる可能性があります。

何度も質問を中断して言い換えなければならないと、思考プロセスが中断され、表面的な対話になってしまいます。この問題は、保留して話す機能を組み込むことで簡単に解決できます。

残念ながら、標準モードにある保留して話すオプションは、アドバンス バージョンには存在しません。ユーザーはミュート ボタンと通話終了ボタンのみにアクセスできます。そのため、じっくり考えるために一時停止する機能がないため、リクエストが途中で切断される可能性があります。

コンテンツの制限などのより複雑な問題と比較すると、この側面は解決しやすいようです。保留して話すオプションを追加するだけで、ユーザー エクスペリエンスが大幅に向上する可能性があります。

トランスクリプトにアクセスすることには利点がありますが、ChatGPT が質問を理解して回答を提供したとしても、一部の応答が省略される可能性があります。

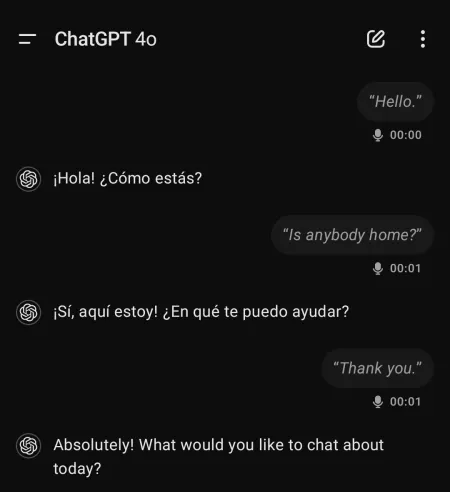

その他の不気味で説明のつかない異常現象

ChatGPT の高度な音声モードを使用しているときに、奇妙で不安な体験をしたというユーザーからの報告があります。たとえば、モデルはスペイン語で事前にやり取りをしていないのに、スペイン語で会話を開始しました。

あるユーザーは、 ChatGPT が「突然叫び声をあげた」り、ロボットのような口調でまったく違う声を出したりした経験があると述べています。

これらの現象は、音声モデル内の幻覚から生じたものである場合もあれば、まったく懸念すべき事態を示している場合もあります。いずれにせよ、この状況には注意が必要です。

最後に

ChatGPT アドバンスド ボイス モードは、登場が遅れたにもかかわらず、現時点では日常的なやり取りの実用的なソリューションとしては機能していません。むしろ、大きな未開発の可能性を秘めた精巧な AI 実験のように感じられます。

トピックの制約やその他の制限により、高度な音声モードはまだ初期開発段階にあり、プロモーション展開時に紹介された機能の多くが欠けています。

ユーザーが AI の音声に感情移入してしまうのではないかという懸念は正当なものだったかもしれないが、OpenAI は現在の機能を過大評価している可能性がある。UI とチャットの制限を改善すれば、間違いなくエクスペリエンスを大幅に向上させることができるだろう。

現時点では、Advanced Voice Mode が競合製品と差別化できる点はほとんどありません。むしろ、問題はあるものの、誰にとっても使いやすい Gemini Live と比べると劣っています。

コメントを残す