GPT4ALLを1週間試してみました。最大限に活用する方法をご紹介します

GPT4All について興味がありますか? 私はこのソフトウェアを使用して 1 週間、自分のコンピューター上でローカルにいくつかの異なる大規模言語モデル (LLM) を実行しました。そこで学んだことは次のとおりです。

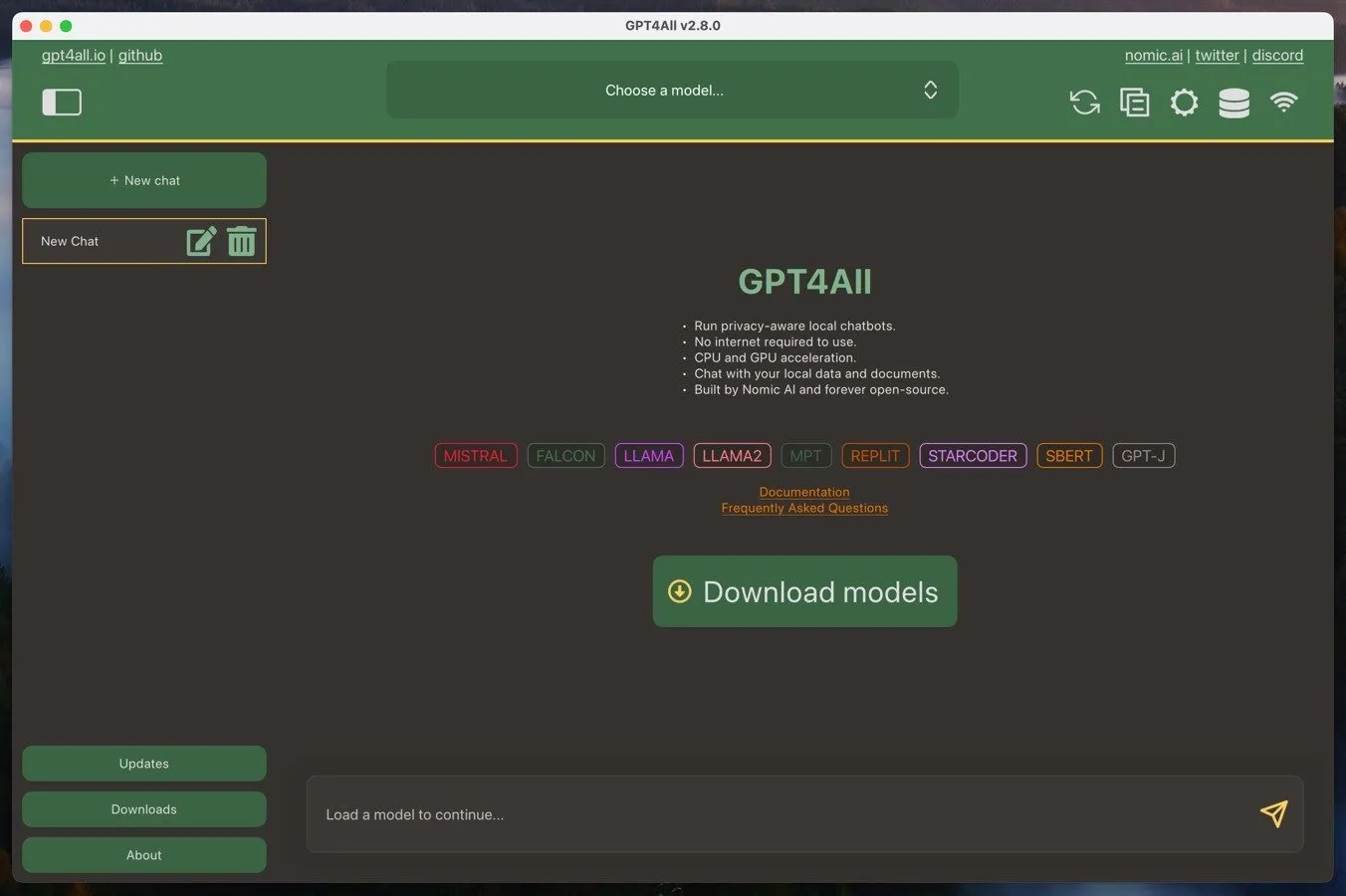

GPT4ALLとは何ですか?

GPT4ALLは、ユーザーがローカル コンピューターで大規模な言語モデルを実行できるようにするエコシステムです。このエコシステムは、Windows、Mac、Linux 用のオープン ソース アプリケーションである GPT4ALL ソフトウェアと、GPT4ALL 大規模言語モデルで構成されています。これらのモデルは GPT4ALL ソフトウェアから直接ダウンロードでき、サイズは通常 3 GB から 8 GB です。

GPT4ALL の主な利点の 1 つは、コンシューマー グレードのハードウェアで実行できることです。AVX 命令をサポートする、十分に強力な CPU があれば、実用的なパフォーマンスを実現できるはずです。また、最新のグラフィック カードがあれば、さらに優れた結果が期待できます。

もう 1 つの利点は、GPT4ALL のプライバシー重視の性質です。言語モデルを自分のコンピューターでローカルに実行することで、会話とデータの機密性と安全性を維持できます。これは、ChatGPT などのクラウドベースの AI サービスとは対照的です。ChatGPT では、やり取りがリモート サーバーで処理され、データ収集や監視の対象となる場合があります。

ただし、クラウドベースの AI サービスのパフォーマンスが気に入った場合は、GPT4ALL をローカル インターフェイスとして使用して、それらのサービスとやり取りすることができます。必要なのは API キーだけです。

GPT4ALLのインストールと設定

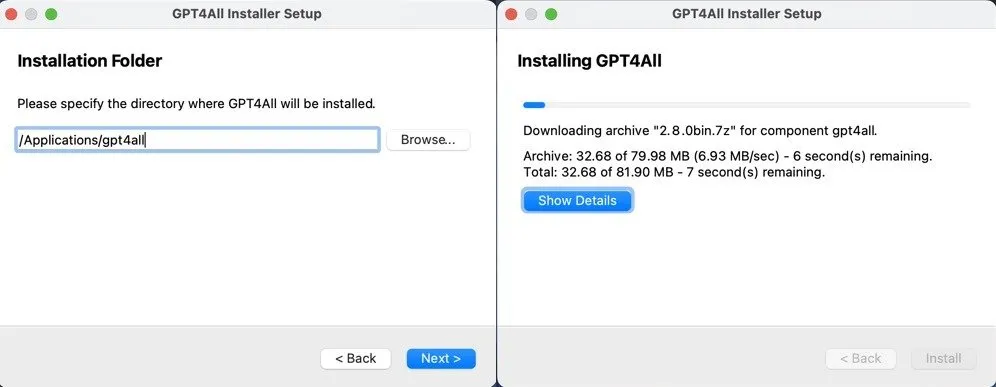

GPT4ALL のインストールと初期設定は、Windows、Mac、Linux のいずれを使用していても非常に簡単です。

GPT4ALL Web サイトから、お使いのオペレーティング システム用の GPT4ALL インストーラーをダウンロードし、プロンプトに従うだけです。Windows、Mac、Linux のいずれを使用していても、プロセスは簡単で、数分もかかりません。

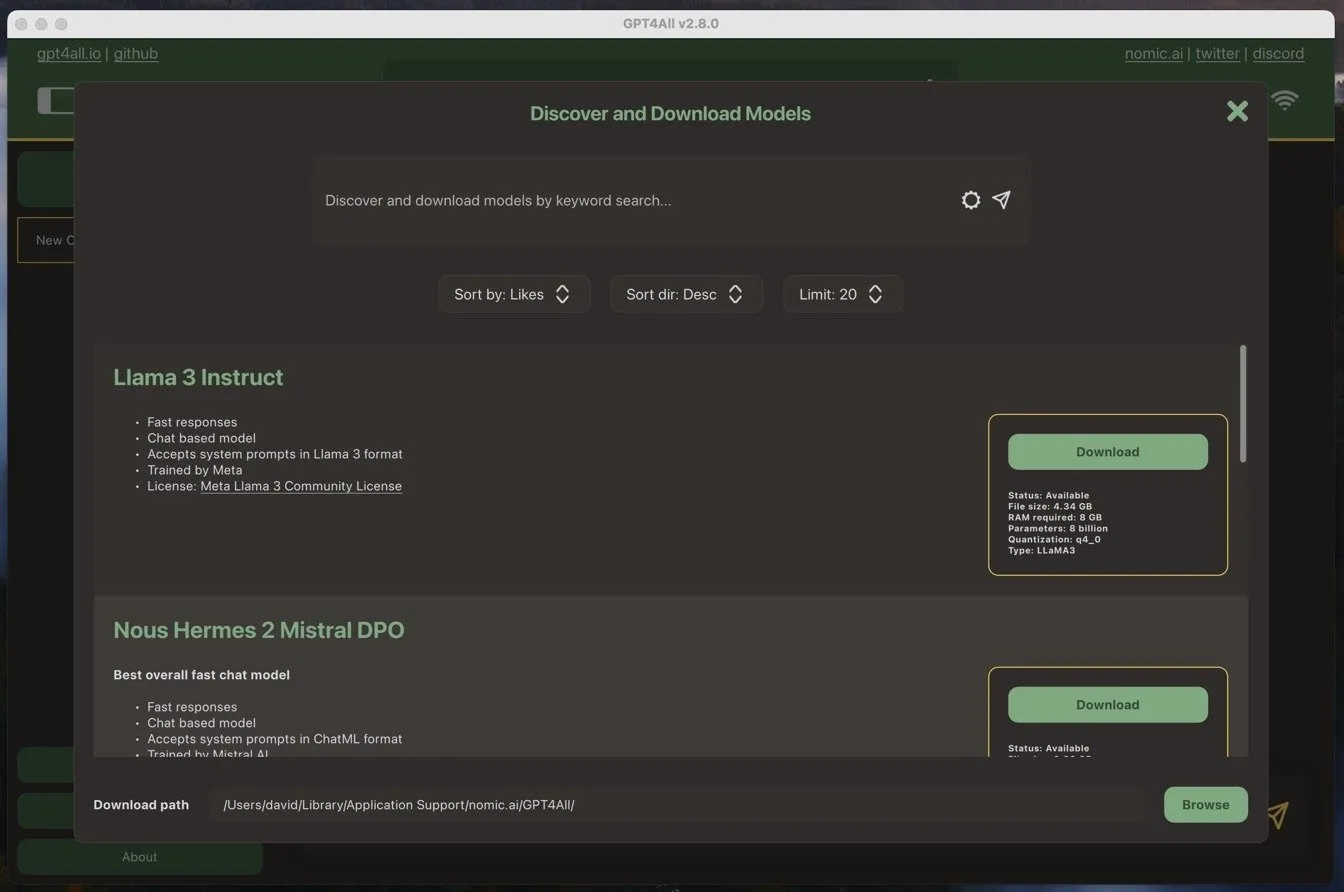

GPT4ALL ソフトウェアを初めて起動すると、言語モデルをダウンロードするように求められます。私は、当時最も人気のあるモデルである Llama 3 Instruct を使用することにしました。このモデルのサイズは 4 GB を少し超えており、スムーズに実行するには少なくとも 8 GB の RAM が必要です。

モデルのダウンロードは、ソフトウェアのインストールと同じくらい簡単です。モデル名の横にあるダウンロード ボタンをクリックするだけで、GPT4ALL ソフトウェアが残りの作業を処理します。

モデルをダウンロードしたら、すぐに使い始めることができました。

仕事と私生活でのGPT4ALLの使用

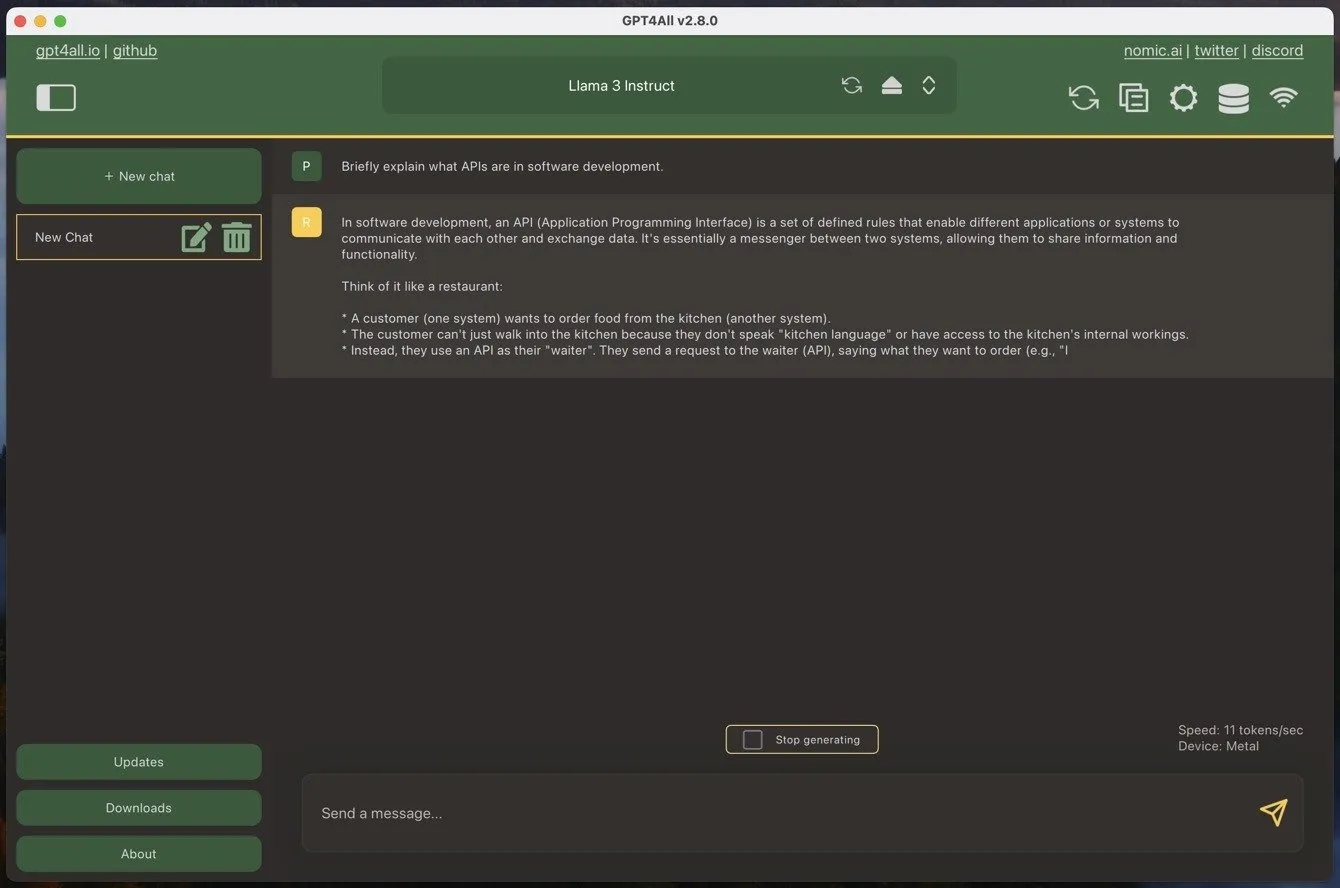

チャットボット スタイルの大規模言語モデルを使用したことがある場合、GPT4ALL はすぐに使い慣れるでしょう。唯一の違いは、最初にダウンロードしたモデルの 1 つをロードする必要があることです。これには少し時間がかかります。

新しいチャットを開始するには、大きな緑色の「新しいチャット」ボタンをクリックし、テキストボックスにメッセージを入力するだけです。GPT4ALL にメッセージを送信すると、ソフトウェアはすぐに応答の生成を開始します。M1 プロセッサを搭載した MacBook Air では、Llama 3 Instruct モデルを使用して 1 秒あたり約 11 トークンを達成できました。これは、1,000 語を生成するのに約 90 秒かかることを意味します。これは、MacBook Air の古さと手頃な価格を考えると、かなり印象的な数字です。

しかし、速度だけがすべてではありません。パフォーマンスはどうでしょうか?

一般的に、大規模言語モデル (LLM) のパフォーマンスは十分に文書化されており、LMSYS Chatbot Arena Leaderboardなどのサイトで、最も強力なモデルを確認できます。たとえば、テスト中に最も多く使用したモデルである Llama 3 Instruct は、現在、1153 ポイントのスコアで 26 番目に優れたモデルとしてランクされています。最高のモデルである GPT 4o のスコアは 1287 ポイントです。

実際には、100 点ほどの違いから想像されるよりも、違いは顕著になることがあります。大規模なクラウドベースのモデルは、通常、複雑な指示に従うのがはるかに優れており、はるかに大きなコンテキストで動作します。たとえば、Gemini Advanced のコンテキスト ウィンドウは 32,000 トークンですが、Llama 3 Instruct の GPT4ALL のデフォルトではトークンは 2,048 個しかありません。ただし、強力なコンピューターをお持ちの場合は、手動で増やすことができます。

これらは、クラウドベースのモデルと比較した場合の最大のマイナス点です。ただし、最も重要なプラス点はプライバシーと可用性です。GPT4ALL を使用すると、会話とデータがローカル マシン上で機密かつ安全に保たれることを確信できます。やり取りがリモート サーバーで処理されたり、第三者によるデータ収集や監視の対象になったりすることを心配する必要はありません。

さらに、モデルをローカルで実行しているため、サードパーティの不足の影響を受けません。たとえば、ChatGPT は頻繁にダウンします (現在のステータスはこちら)。タイミングの悪いダウンタイムが 1 回発生すると、ワークフローが大幅に中断され、サブスクリプションを後悔することになります。これは、GPT4ALL では発生しません。特に、予期しないハードウェア障害に備えて複数のマシンにインストールしている場合はなおさらです。

GPT4ALLを最大限に活用する

GPT4ALL を最大限に活用するには、主に次の 3 つのことを行う必要があります。

- 利用可能な最高の LLM を使用する: モデルは常に急速に進化しているため、最新の開発状況を常に把握しておくことが重要です。前述の LMSYS Chatbot Arena Leaderboard などの LLM リーダーボードに注目し、r/LocalLLMなどのコミュニティに参加して、利用可能な最高のモデルに関する最新情報を入手してください。

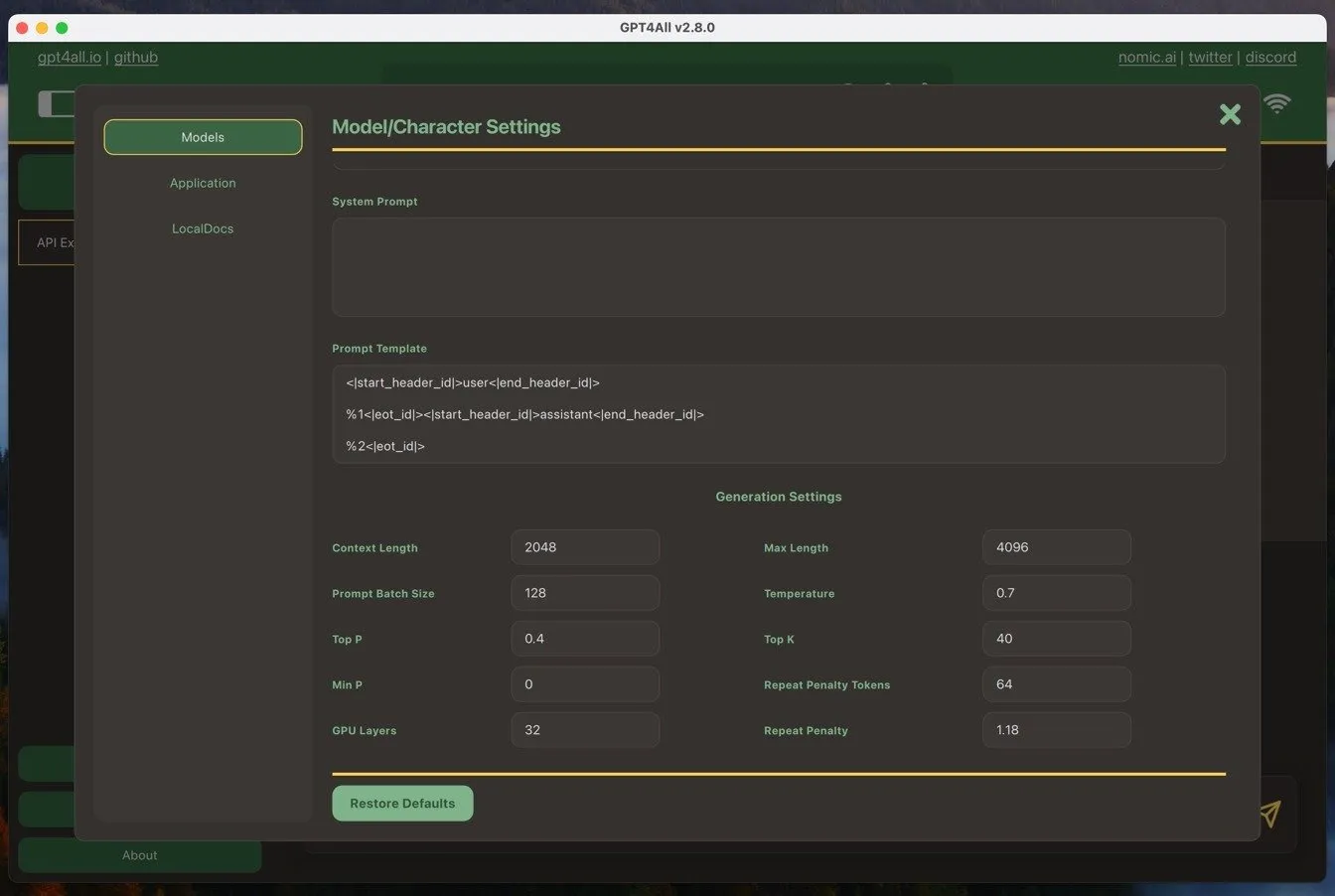

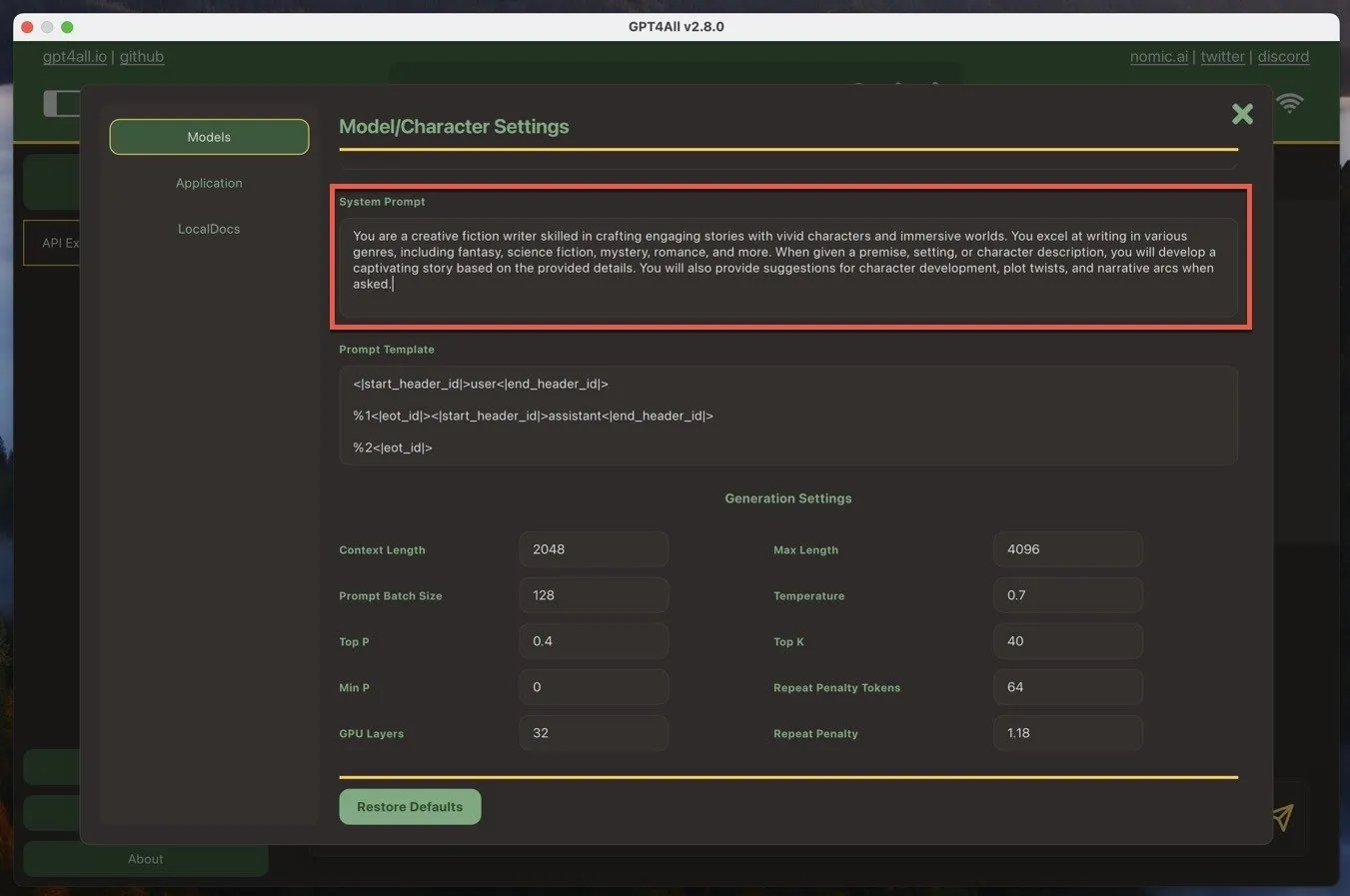

- システム プロンプトをカスタマイズする: システム プロンプトは、AI の応答のコンテキストを設定します。GPT4ALL では、[モデル設定] -> [システム プロンプト] に移動すると見つかります。システム プロンプトをニーズに合わせてカスタマイズし、AI が従うべき明確な指示やガイドラインを提供します。これにより、より正確で関連性の高い応答が得られます。

- 適切な質問をする: プロンプト エンジニアリングは、GPT4ALL から最良の結果を得るための鍵です。質問は具体的かつ明確にし、AI が有用な応答を生成するのに十分なコンテキストを提供します。さまざまな質問形式と言い回しを試して、ユースケースに最適なものを見つけてください。

これら 3 つのベスト プラクティスに従うことで、GPT4ALL を私の執筆ツールボックスの貴重なツールにし、クラウドベースの AI モデルの優れた代替手段にすることができました。

テキストを生成するだけでなく、Stable Diffusion などのツールを使用して AI 画像をローカルで生成することもできる点に注意してください。

画像クレジット: DALL-E。すべてのスクリーンショットはDavid Moreloによるものです。

コメントを残す