Microsoft、Bing 画像検索用の Turing Bletchley v3 ビジョン言語モデルを発表

Microsoft は、Turing Bletchley 多言語ビジョン言語基盤モデルの第 3 バージョンを正式に発表しました。現在、画像検索を改善するためのBingを含む、多くの Microsoft 製品に導入されています。

Microsoft は、2021 年 11 月に Turing Bletchley モデルの最初のバージョンを発売しました。今日のBing 公式ブログへの投稿で、Microsoft は、Bing やその他の製品に追加する前に、2022 年の秋にモデルの 3 番目のバージョンのテストを開始したと述べました。

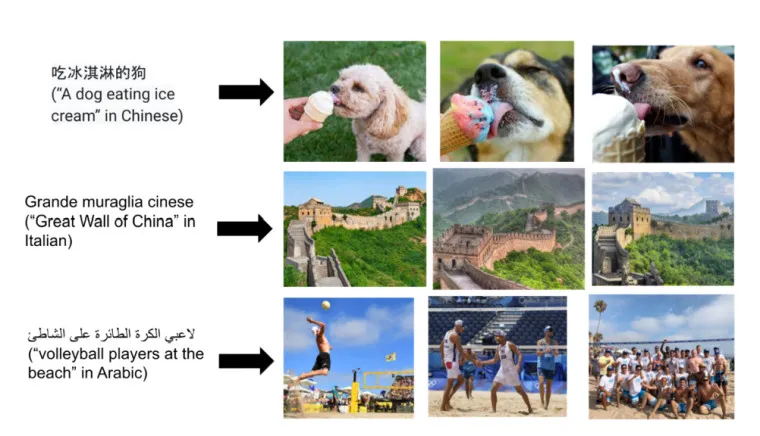

このモデルは、テキストと画像の両方からの入力を使用して、ユーザーが Microsoft の Bing 検索エンジンで探しているものを見つけます。目標は、モデルをできる限り近づけて、たとえば「アイスクリームを食べる犬」というテキストを、検索結果に表示されるアイスクリームを食べる犬の画像にできるだけ近づけることです。

Turing Bletchley v3 がこれらの接続を行う方法の一部は、モデルに関連する広範囲にわたるものです。マイクロソフトは次のように述べています。

画像とその画像を説明するキャプションがある場合、キャプション内の一部の単語がマスクされます。次に、画像とテキストの両方に基づいて隠れた単語を予測するようにニューラル ネットワークがトレーニングされます。タスクを反転して、単語の代わりにピクセルをマスクアウトすることもできます。このタイプのマスクされたトレーニングと大規模なトランスフォーマー ベースのモデルを組み合わせると、さまざまな下流タスクで微調整できる強力な事前トレーニング済みモデルが得られます。

Bing での画像検索にも使用されます。新しい Turing Bletchley v3 モデルは、Xbox ゲーム サービスのコンテンツ モデレーションに使用されています。これは、チームが、たとえば、Xbox プレーヤーによってプロフィールにアップロードされた、Xbox プラットフォーム上で不適切であり、同社のコミュニティ標準に違反していると考えられる画像やビデオを特定するのに役立ちます。

コメントを残す